泛化特征与非泛化特征

- 泛化特征(Generalized Features):

- 泛化特征是指那些能够捕捉数据内在模式或规律性的特征,这些特征具有一定的普遍性,可以适用于不同但相关的场景

- 一个模型如果具备良好的泛化能力,意味着它能在未见过的数据上表现良好,即不仅能准确预测训练集中的数据,还能对新数据做出合理的预测

- 在创建泛化特征时,通常会考虑去除噪声、避免过拟合,并确保特征的选择基于数据的统计显著性和稳定性

- 非泛化特征(Non-Generalized Features 或 Specific Features):

- 非泛化特征是指那些与特定数据样本紧密相关,但在其他类似的数据样本中可能不具备相同意义或重要性的特征

- 这些特征可能会导致模型过拟合,即模型在训练数据上的表现非常好,但对于未曾见过的新数据则可能无法给出准确的预测

- 非泛化特征的例子包括某些特定于训练集样本的异常值或者非常具体且不常见的属性

一些说明

- 统计型特征一般可以看做是泛化特征

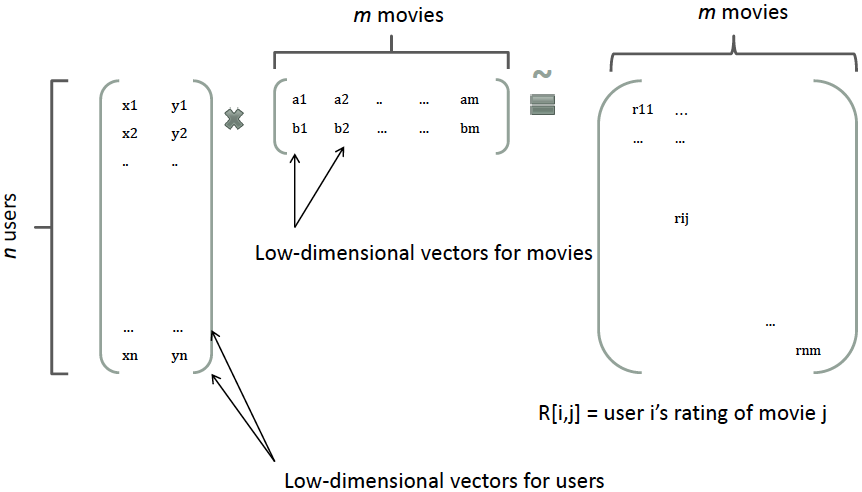

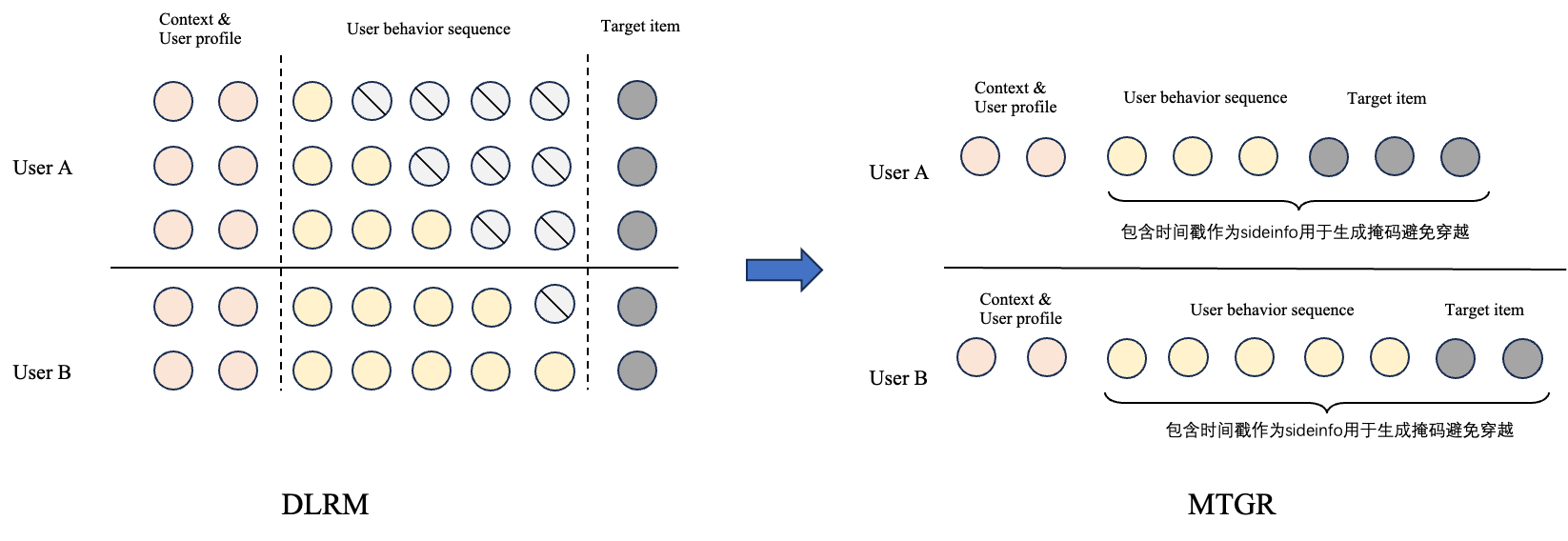

- User-ID或者Item-ID这种特征一般可以看做是非泛化特征

- 在数据量特别大的时候,其实User-ID和Item-ID类特征是可以放进模型的,只要有充足的数据来训练他们的Embedding就可以;但是一般的小任务,小数据就不适合加这类特征了