本文主要广告计算领域用于CTR,CVR预估的模型

计算广告领域的术语

一些术语

- CPA(Cost Per Action):

- 一种广告计费模式

- 按照行为(Action)来计费

- 这里的行为可以是注册,咨询,放入购入车等

- CPC(Cost Per Click)

- 一种广告计费模式

- 按照点击(Click)次数

衡量指标

- 点击率CTR(click-through rate), 又名点击通过率:

$$CTR = \frac{Count_{click}}{Count_{show}} $$- 分母是广告的实际展示次数

- 分子是广告的实际点击次数

- 转化率CVR(conversion rate), 一种CPA衡量指标

$$CVR= \frac{Count_{conversion}}{Count_{click}}$$- 分母是广告的实际点击次数

- 分子是广告的转化次数,不同场景对转化成功的定义不同,比如手机号码注册用户为一次有效转化,那么这里CVR统计的就是所有点击了广告的人中有多少进行了实际的手机号注册

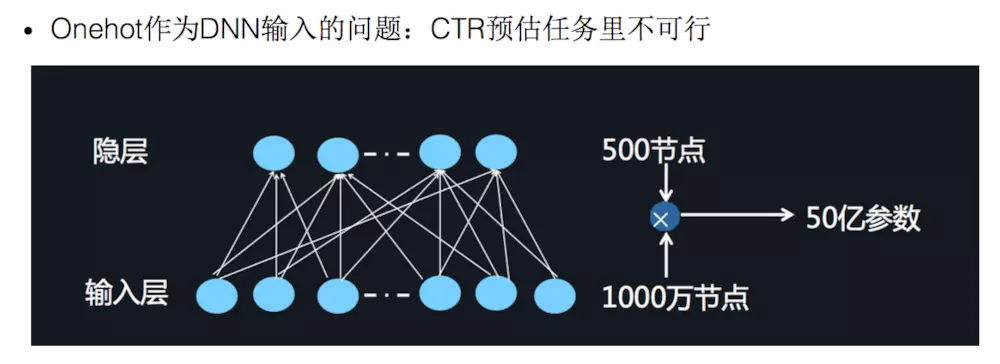

预估CTR,CVR的模型

人工特征工程+LR

- 人工提取当前广告的特征

- LR模型预估用户是否会点击该广告或者注册该网站(二分类)

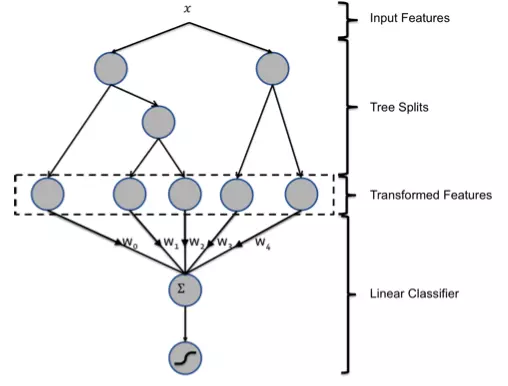

GBDT+LR

- 参考博客: https://www.jianshu.com/p/96173f2c2fb4

- Facebook paper中的一个例子

- 图中的GBDT只包含两棵树,实际上使用时可包含更多

- LR的特征数量(样本维度)就是所有树的叶节点树,样本落到当前叶节点则,当前叶节点对应的特征值为1,否则为0

- 用于LR训练的特征维度共num_trees * num_leaves(也就是所有树叶节点的总数)

- 由于有多棵树,每个原始样本在每棵树都会落到一个叶节点上,所以得到的新样本中可能有很多个特征值为1

- 实践中原始输出时可能维度是树的棵数,每个数表示当前树中样本落到第几个叶节点上,对每棵树分别使用OneHot编码即可的到上面的 (num_trees * num_leaves) 维数据

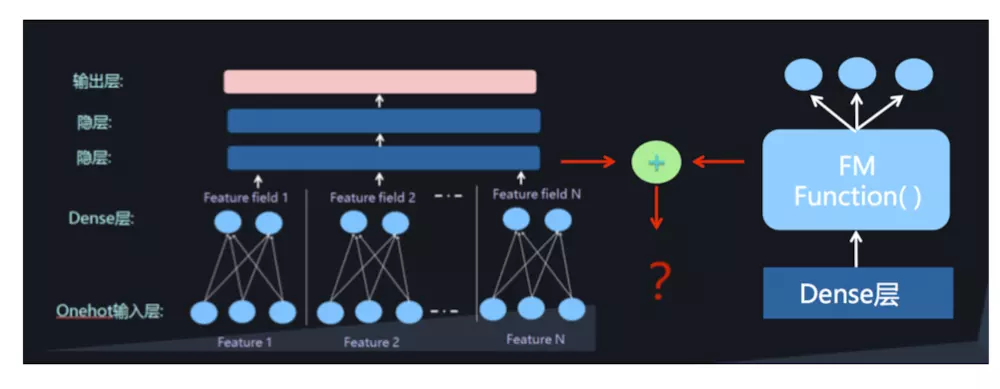

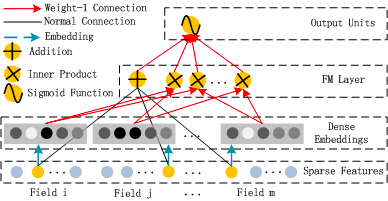

FM

- 参考博客RS——FM-因子分解机

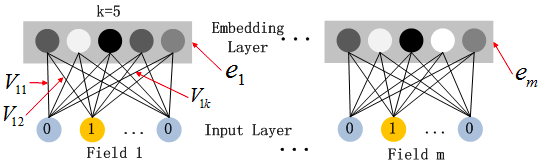

FFM

- 参考博客RS——FMM模型