- 参考链接:

自信息(Self-Information):\(I(x)\)

自信息的来源讨论

- 一条信息的信息量大小和它的不确定性有直接的关系,信息量的度量就等于不确定性的多少

- 考虑一个离散随机变量 \(x\),随机变量的信息量由概率分布 \(p(x)\) 确定

- 我们的目标是找到一个函数 \(I(x) = f(p(x))\) (自变量是 \(p(x)\),因为随机变量的信息量由概率分布确定),能够衡量 \(x\) 信息内容的多少

- 且必须是概率分布 \(p(x)\) 的单调函数?

- 现在考虑同时出现两个相互独立的随机变量 \(x\) 和 \(y\),那么他们的信息量和应该是

$$I(x,y) = I(x)+I(y) = f(p(x)) + f(p(y))$$- 同时他们的联合概率分布为

$$p(x,y) = p(x)p(y)$$

- 同时他们的联合概率分布为

- 由上面的两个表达式可以知道 \(f(\cdot)\) 应该是一个对数相关的函数,因为

$$log_{a}(MN) = log_{a}M + log_{a}N$$ - 所以我们可以考虑把原始信息量定义为

$$I(x) = f(p(x)) = -log p(x)$$- 其中负号是用来保证信息量是正数或者零

- log 函数基的选择是任意的(信息论中基常常选择为 2,因此信息的单位为比特 bits;而机器学习中基常常选择为自然常数,因此单位常常被称为奈特 nats)

- \(I(x)\) 也被称为随机变量 \(x\) 的自信息(self-information),描述的是随机变量的某个事件发生所带来的信息量

自信息精确定义

- 在信息论中,自信息(Self-Information) 是衡量单个随机事件发生时所携带的信息量的指标

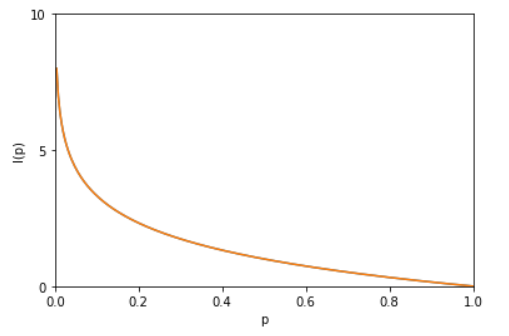

- 自信息的核心思想是:事件发生的概率越低,它携带的自信息就越大;反之,概率越高,自信息越小

- 定义:对于离散随机变量 \(X\),若某个事件 \(x\) 发生的概率为 \(P(x)\),则该事件的自信息定义为:

$$

I(x) = -\log_b P(x)

$$- 底数 \(b\) 决定自信息的单位:

- 当 \(b=2\) 时,单位为 比特(bit) (这是最常用的设定)

- 当 \(b=e\) 时,单位为 奈特(nat)

- 当 \(b=10\) 时,单位为 哈特(hart)

- 底数 \(b\) 决定自信息的单位:

- 自信息的核心性质

1)非负性:由于 \(0 \leq P(x) \leq 1\),\(\log P(x) \leq 0\),因此 \(I(x) \geq 0\)

2)单调性:自信息与事件概率成反比

3)独立性:若两个事件 \(x\) 和 \(y\) 相互独立,则联合事件 \(xy\) 的自信息等于两个事件自信息之和,即* 若事件必然发生(\\(P(x)=1\\)),则 \\(I(x)=0\\),该事件不携带任何新信息; * 若事件概率极低(\\(P(x)\rightarrow0\\)),则 \\(I(x)\rightarrow\infty\\),该事件发生时会携带极大的信息量$$ I(xy) = I(x) + I(y) $$

熵(也称为信息熵):\(H(x)\)

熵的起源讨论

- 现在假设一个发送者想传送一个随机变量的值给接收者

- 那么在这个过程中,他们传输的平均信息量可以通过求 \(I(x)=−logp(x)\) 关于概率分布 \(p(x)\) 的期望得到:

$$

\begin{align}

H(x) &= \sum_{x}p(x)(-logp(x)) \\

&= -\sum_{x}p(x)logp(x) \\

&= -\sum_{i=1}^{n}p(x_{i})logp(x_{i})

\end{align}

$$ - \(H(X)\) 就被称为随机变量 \(x\) 的熵,它是表示随机变量不确定的度量,是对所有可能发生的事件产生的信息量的期望

- 从公式可得,随机变量的取值个数越多,状态数也就越多,信息熵就越大,混乱程度就越大,当随机分布为均匀分布时,熵最大,且

$$0 ≤ H(X) ≤ logn$$ - 上式的证明如下:

$$p(1)+p(2)+\dots+p(n)=1$$- 目标函数

$$f(p(1),p(2),\dots,p(n))=-(p(1)logp(1)+p(2)logp(2)+\dots+p(n)logp(n))$$ - 约束条件

$$g(p(1),p(2),\dots,p(n),\lambda)=p(1)+p(2)+\dots+p(n)-1=0$$ - 定义拉格朗日函数

$$

L(p(1),p(2),\dots,p(n),\lambda)=-(p(1)logp(1)+p(2)logp(2)+\dots+p(n)logp(n))+\lambda(p(1)+p(2)+\dots+p(n)-1)

$$ - 对 \(p(i)\) 和 \(\lambda\) 求偏导,并令其等于0得

$$p(1)=p(2)=\dots=p(n)=\displaystyle\frac{1}{n}$$ - 带入目标函数得

$$

\begin{align}

f(\displaystyle\frac{1}{n},\frac{1}{n},\dots,\frac{1}{n}) &= -(\frac{1}{n}log\frac{1}{n} + \frac{1}{n}log\frac{1}{n} + \dots + \frac{1}{n}log\frac{1}{n}) \\

& = -log(\frac{1}{n}) \\

& =\log(n)

\end{align}

$$

- 目标函数

熵的精确定义

- 在信息论与概率论中,熵(Entropy) 是衡量随机变量不确定性大小的核心量化指标,其本质是随机变量所有可能事件的自信息的数学期望

- 根据随机变量的类型,熵的定义分为离散型和连续型两类

离散随机变量的熵(信息熵)

- 设离散随机变量 \(X\) 的取值集合为 \(\{x_1,x_2,\dots,x_n\}\),对应的概率分布为 \(P(X=x_i)=p_i\)(满足归一化条件 \(\sum_{i=1}^n p_i = 1\)),则 \(X\) 的熵定义为:

$$

H(X) = -\sum_{i=1}^n p_i \log_b p_i

$$- 其中底数 \(b\) 决定熵的单位:

- \(b=2\):单位为 比特(bit) ,是信息论中最常用的单位

- \(b=e\):单位为 奈特(nat) ,适用于理论推导(自然对数)

- \(b=10\):单位为 哈特(hart) ,较少使用

- 其中底数 \(b\) 决定熵的单位:

离散随机变量的熵的核心性质

- 非负性:\(H(X) \geq 0\),当且仅当 \(X\) 为确定事件(某一 \(p_i=1\),其余 \(p_i=0\))时,\(H(X)=0\);

- 极值性:当 \(X\) 的所有取值等概率分布时,熵达到最大值 \(H_{\text{max} }(X)=\log_b n\),此时不确定性最高;

- 可加性:若离散随机变量 \(X\) 与 \(Y\) 相互独立,则联合熵 \(H(X,Y)=H(X)+H(Y)\)

连续随机变量的熵(微分熵)

- 对于连续随机变量 \(X\),其概率密度函数为 \(p(x)\),则微分熵定义为:

$$

h(X) = -\int_{-\infty}^{\infty} p(x)\log_b p(x) dx

$$

连续随机变量的熵 vs 离散随机变量的熵

- 微分熵不满足非负性 ,其值可以为负数(例如均匀分布 \(U(a,b)\) 的微分熵为 \(\log(b-a)\),当 \(b-a<1\) 时熵为负)

- 微分熵的物理意义与离散信息熵略有不同,它衡量的是连续变量分布的“相对不确定性”,而非绝对信息量

自信息与熵的关系

- 两者的关系公式为:

$$

H(X) = \mathbb{E}[I(x)] = \sum_{x\in X} P(x) \cdot I(x) = -\sum_{x\in X} P(x)\log P(x)

$$ - 简单来说:

- 自信息描述单个事件的信息量

- 熵描述整个随机变量的平均信息量

互信息(Mutual Information, MI):\(I(X;Y)\)

- 在概率论与信息论中,两个随机变量 \(X\) 和 \(Y\) 的互信息(Mutual Information, MI) 用于衡量它们之间的相互依赖程度

- 互信息的核心是量化“已知一个随机变量的信息后,另一个随机变量的不确定性减少的量”

离散随机变量的互信息定义

- 若 \(X\) 和 \(Y\) 为离散随机变量,联合概率分布为 \(P(X,Y)\),边缘概率分布分别为 \(P(X)\) 和 \(P(Y)\),则互信息的定义为:

$$

I(X;Y)=\sum_{x\in X}\sum_{y\in Y}P(x,y)\log\frac{P(x,y)}{P(x)P(y)}

$$- 当 \(X\) 和 \(Y\) 相互独立时,\(P(x,y)=P(x)P(y)\),此时 \(I(X;Y)=0\);

- 当 \(X\) 和 \(Y\) 完全依赖时,\(I(X;Y)\) 达到最大值,等于 \(X\) 或 \(Y\) 的熵(\(H(X)\) 或 \(H(Y)\))

连续随机变量的互信息定义

- 若 \(X\) 和 \(Y\) 为连续随机变量,联合概率密度函数为 \(p(x,y)\),边缘概率密度函数分别为 \(p(x)\) 和 \(p(y)\),则互信息的定义为:

$$

I(X;Y)=\int_{-\infty}^{\infty}\int_{-\infty}^{\infty}p(x,y)\log\frac{p(x,y)}{p(x)p(y)}dxdy

$$

互信息的等价公式

- 互信息可以通过熵(Entropy) 和条件熵(Conditional Entropy) 推导,核心等价关系为:

$$

I(X;Y)=H(X)-H(X|Y)=H(Y)-H(Y|X)=H(X)+H(Y)-H(X,Y)

$$- \(H(X)\) 是 \(X\) 的熵,衡量 \(X\) 的不确定性

- \(H(X|Y)\) 是给定 \(Y\) 时 \(X\) 的条件熵,衡量已知 \(Y\) 后 \(X\) 剩余的不确定性

- \(H(X,Y)\) 是 \(X\) 和 \(Y\) 的联合熵

互信息 与 InfoNCE 的关联

- InfoNCE 损失的设计目标是最大化互信息的下界 ,而非直接计算互信息

- 当负样本数量 \(K\rightarrow\infty\) 时,InfoNCE 损失对应的下界会收敛到真实的互信息 \(I(X;Y)\),这也是该 InfoNCE 损失函数命名的核心原因