注:本文包含 AI 辅助创作

- 参考链接:

Paper Summary

- 整体说明:

- 论文将教育心理学中的教学 Scaffolding 理论应用于 LLM 的 RL,并提出了 RuscaRL

- RuscaRL 是一个新颖的教学 Scaffolding 框架,旨在打破通用 LLM 推理任务的探索瓶颈

- RuscaRL 通过 Scaffolding 机制利用清单式(checklist-style) Rubric,提供逐渐衰减的外部指导,并通过 Reward 函数实现稳健的 RL 训练

- Rubric-based Scaffolding 机制提供外部指导并逐渐衰减以鼓励内化(理解:先添加一些 Rubrics 作为手脚架,然后训练过程中不断减少 Rubrics 的加入)

- Rubric-based Reward 函数则实现稳健的评估以支持有效的 RL 训练

- 大量实验表明

- RuscaRL 始终优于强大的基线方法,并与领先模型相比取得了有竞争力的结果

- 使用 RuscaRL 微调的模型能够生成初始模型几乎无法生成的高度新颖的 Response

- 论文将教育心理学中的教学 Scaffolding 理论应用于 LLM 的 RL,并提出了 RuscaRL

- 背景 & 问题:

- RL 在促进推理能力涌现方面的有很大的潜力,但目前一个根本的困境仍然存在:

- RL 的提升依赖于从高质量样本中学习,而对这类样本的探索仍然受限于 LLMs 固有的能力

- 这实际上造成了一个不良循环,即what cannot be explored cannot be learned(无法被探索则无法被学习)

- 本文解法:

- 论文提出了 Rubric-Scaffolded Reinforcement Learning (RuscaRL)

- 注:这里的 scaffold 直译是脚手架(建筑领域的常用词 ,是施工时搭建在建筑物外围的临时支撑结构),用于强调辅助训练后可以移除的辅助设施

- RuscaRL 是一个新颖的教学脚手架框架(instructional scaffolding framework),旨在打破通用 LLM 推理的探索瓶颈,RuscaRL 引入清单式 Rubric 作为

- (1) 显式脚手架(explicit scaffolding) 用于 Rollout 生成期间的探索,即在任务指令中提供不同的 Rubric 作为外部引导,以引导多样化的高质量响应

- 这种引导会随时间逐渐衰减(decayed),鼓励模型内化底层的推理模式(encouraging the model to internalize the underlying reasoning patterns);

- (2) 用于模型训练期间利用的可验证奖励 ,即我们可以使用 Rubric 作为参考获得稳健的 LLM-as-a-Judge 分数,从而在通用推理任务上实现有效的 RL

- (1) 显式脚手架(explicit scaffolding) 用于 Rollout 生成期间的探索,即在任务指令中提供不同的 Rubric 作为外部引导,以引导多样化的高质量响应

- 广泛的实验证明了所提出的 RuscaRL 在各种基准测试中的优越性,有效扩展了 Best-of-N 评估下的推理边界

- Notably,RuscaRL 将 Qwen2.5-7B-Instruct 在 HealthBench-500 上的得分从 23.6 显著提升至 50.3,超过了 GPT-4.1

- Furthermore,论文在 Qwen3-30B-A3B-Instruct 上微调的变体在 HealthBench-500 上达到了 61.1 分,性能优于包括 OpenAI-o3 在内的领先 LLMs

- 一些说明:

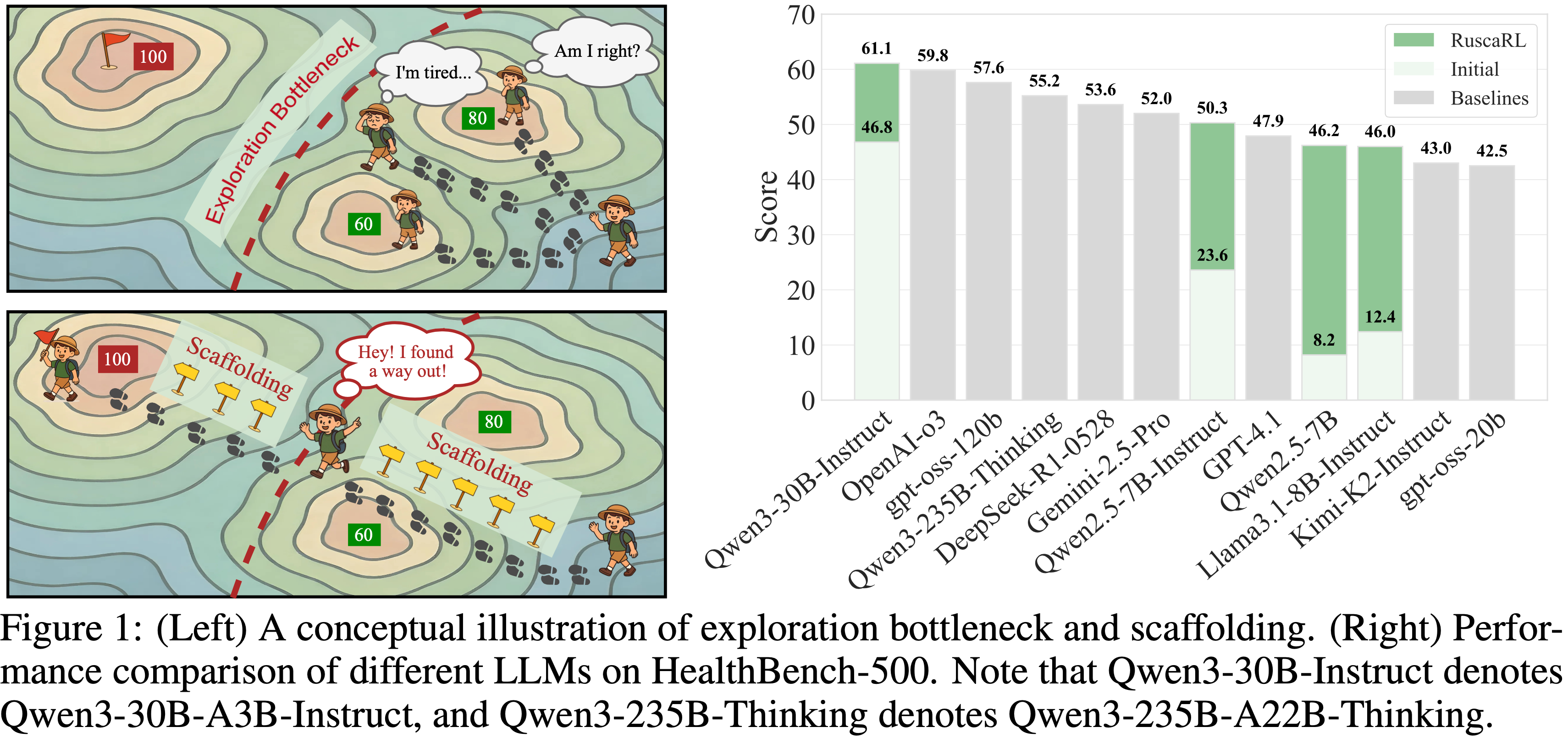

- 论文的图 1(右)画的很不错,清晰易懂,能清晰看出论文方法带来的改进,值得写论文时学习

- 补充:论文中的未来工作

- 虽然 RuscaRL 在打破通用 LLM 推理的探索瓶颈方面展示了有希望的结果,但仍存在一些局限性,为未来的研究指明了方向

- 论文的方法关键依赖于高质量、结构良好的 Rubric 数据集(而这些数据集在社区中仍然稀缺),并且论文的方法对 Rubric 设计的质量高度敏感

- 设计不良的 Rubric 可能由于不合理的分数分配或相互冲突的准则而无法提供稳健的 Reward 信号

- 范围狭窄的 Rubric 则可能限制 Scaffolding 过程生成多样化、高质量 Response 的能力

- RuscaRL 的成功突显了社区迫切需要投入更多资源来构建开放、多样且领域丰富的 Rubric 数据集

- 作者未来的工作包括开发高质量 Rubric 数据生产流程、探索 Rubric-based 自然语言反馈策略,以及研究在多模态任务和智能体系统中的应用

- 虽然 RuscaRL 在打破通用 LLM 推理的探索瓶颈方面展示了有希望的结果,但仍存在一些局限性,为未来的研究指明了方向

Introduction and Discussion

- LLMs 在广泛的复杂推理任务上已展现出巨大的潜力

- 包括法律分析 (2021; 2023; 2024; 2022),软件工程 (2023; 2024),机器人技术 (2025; 2023a; 2023),以及具体任务如代码生成 (Qwen, 2025) 和数学证明 (2025; 2025)

- However,提升 LLMs 的通用推理能力仍然是一个重大挑战 (2023; 2022)

- 为了解决上述问题,最近在 RLVR 方面的突破,例如 DeepSeek-R1 (2025) 和 OpenAI-o3 (OpenAI, 2025a),已经证明利用可验证奖励作为反馈信号可以成功促进 LLMs 中复杂推理能力的涌现 (2025; 2025a)

- 尽管取得了不错的成果,传统的 RLVR 往往更适用于答案具有客观可验证性的领域

- For Instance,在数学证明(2025;2025)和代码生成(Qwen, 2025;2022)等领域,正确性可以通过形式化证明验证或自动化单元测试来明确判定

- 在这些场景中,奖励信号清晰且与任务目标高度一致,使得 RLVR 能够有效引导模型找到正确的解决方案

- Unfortunately,许多现实任务,如医疗咨询(2025;2023;2023)和创意写作(2025c;2024),本质上是开放性的

- 这类任务通常需要进行多维评估,且往往缺少一个唯一、可验证的标准答案

- For Instance,在数学证明(2025;2025)和代码生成(Qwen, 2025;2022)等领域,正确性可以通过形式化证明验证或自动化单元测试来明确判定

- 为解决上述问题,近期涌现的一些并列研究(2025;2025;2025;2025;2025;2025)开始探索 Rubric-based 评估方法,将理想的回答分解为清单式的评估标准(如事实性(factuality)、连贯性(coherence)、完整性(completeness)等)

- 通过利用 “LLM-as-a-Judge” 对每个标准(criterion)进行打分,并将结果聚合为标量奖励,量规为开放性领域中的 RLVR 提供了更稳定、更可靠的反馈信号

- Nevertheless,如图 1(左)所示,一个根本性的探索瓶颈仍然存在:

- RL 需要高质量样本来改进,但对这些样本的探索仍受限于 LLMs 的固有能力 (2025; 2025a; 2025b; 2025)

- 这造成了一个不可避免的循环,即无法探索限制了学习能力(the inability to explore restricts the ability to learn)

- 越来越多的研究尝试增强 LLMs RLVR 中的探索 (2025a, 2025b; 2025; 2025; 2025; 2025; 2025)

- However,这些方法很大程度上将策略分布偏向于基础模型已经支持的高奖励响应,而非真正扩展其推理边界 (2025a)

- 更糟糕的是(Worse still),RL 本身具有缩小探索空间的天然趋势:策略熵在训练过程中逐渐崩溃,导致模型收敛于有限的推理轨迹集 (2025; 2025; 2025a; 2025; 2025b)

- 这反过来削弱了 RLVR 探索更多样化和更高质量解决方案的潜力

- 这反过来削弱了 RLVR 探索更多样化和更高质量解决方案的潜力

- RL 需要高质量样本来改进,但对这些样本的探索仍受限于 LLMs 的固有能力 (2025; 2025a; 2025b; 2025)

- 论文引入了 Rubric-Scaffolded Reinforcement Learning(RuscaRL) ,采用了一种新颖的教学脚手架框架来打破 RLVR 的探索瓶颈

- 在技术上,RuscaRL 以两种互补的方式利用 Rubric:

- (1) Rollout 生成期间的显式脚手架(Explicit scaffolding during rollout generation)

- 对于每个指令,RuscaRL 通过使用 Rubric 作为外部引导生成一组候选响应

- 论文提出了组内脚手架差异化(intra-group scaffolding differentiation) ,在每个组内提供不同级别的 Rubric,从而实现多样化和高质量的响应

- 为了进一步内化底层推理模式,论文使用步间脚手架衰减(inter-step scaffolding decay) 在训练过程中逐渐移除脚手架 ,从而最小化对外部引导的依赖

- (2) 模型训练期间的可验证奖励(verifiable rewards during model training)

- 模型响应根据源自 Rubric 的多个标准(criteria)进行评估

- 对于每个标准,论文使用一个 Grader LLM 执行二元评估(i.e. True or False),判断响应是否满足该特定要求

- 然后通过聚合将结果结合,得到一个稳健的奖励信号,促进在不同通用任务上的有效 RL

- (1) Rollout 生成期间的显式脚手架(Explicit scaffolding during rollout generation)

- 在技术上,RuscaRL 以两种互补的方式利用 Rubric:

- 论文的主要贡献总结如下:

- 论文引入教学脚手架 (instructional scaffolding) 作为 LLMs RLVR 的一个新范式,它开创了在任务指令中整合外部引导以提高 Rollout 多样性和质量的方法,从而在 RL 过程中实现更高效的探索

- 论文提出了 Rubric-Scaffolded Reinforcement Learning (RuscaRL) ,一个旨在打破探索瓶颈的创新 RLVR 框架,它集成了清单式 Rubric,既作为探索的显式脚手架,也作为利用的可验证奖励

- 广泛的实验表明,RuscaRL 产生的结果优于 SOTA 对应方法

- 值得注意的是,如图 1(右)所示,RuscaRL 使得小型 LLMs(例如 Qwen3-30B)在 HealthBench-500 上能够达到与领先 LLMs(例如 OpenAI-o3)相当的性能

Related Works

Rubric-based Methods

- Rubric 是结构化的评估框架,将复杂的评估任务分解为具体、可验证的标准

- 为了应对通用任务评估, Rubric-based 评估方法已在医疗 (2025; 2025)、代码 (2025; Galván-2025) 和其他领域 (2025; 2025) 出现。基于这些框架,研究人员将 Rubric 作为奖励信号应用于 RL (2025; 2025),使用 LLMs 作为 Grader ,为缺乏真实答案的任务提供细粒度反馈

- 这种方法在 LLM 对齐 (2025)、指令遵循 (2025) 和开放式问答 (2025; 2025; 2025) 方面显示出有前景的结果

Exploration in RL for LLMs

- 现有的 RL 方法在复杂推理任务中面临探索不足的问题,策略陷入局部最优,推理边界崩溃 (2025a; 2025; 2025a)

- 当前的解决方案包括延长训练 (2025a, 2025b)、基于熵的探索 (2025; 2025; 2025) 和外部引导 (2025a; 2025),但这些方法未能打破探索瓶颈,因为它们要么在初始策略分布内探索,要么仅提供粗糙的方向信号而没有结构化的中间引导

- In Contrast,RuscaRL 通过清单式 Rubric 提供显式脚手架,用可验证的标准引导轨迹,同时通过脚手架衰减实现模式内化

Preliminary

RL Algorithms for LLMs

- 论文采用 GRPO (2025) 作为论文的核心 RL 算法,用于训练具有基于 Rubric 奖励的语言模型

- 与 PPO (2017) 不同,GRPO 通过使用基于组的优势估计消除了对价值模型的需求

- 对于每个指令(Instruction) \(q \sim \mathcal{D}\),其中 \(\mathcal{D}\) 表示训练数据集 \(\mathcal{D}\) 上的分布,GRPO 从旧策略 \(\pi_{\theta_{\text{old} } }\) 中采样一组 \(G\) 个响应 \(\{o_{1}, o_{2}, \ldots, o_{G}\}\),并通过最大化以下目标来优化策略 \(\pi_{\theta}\):

$$

\begin{split}

\mathcal{J}_{\text{GRPO} } \left(\theta\right) = \mathbb{E}_{q \sim \mathcal{D}, \{o_i\}_{i=1}^{G} \sim \pi_{\theta_{\text{old} } }(\cdot|q)}

\end{split}

\left[ \frac{1}{G} \sum_{i=1}^{G} \frac{1}{|o_i|} \sum_{t=1}^{|o_i|} \min \left( \rho_{i,t}(\theta) \hat{A}_i, \operatorname{clip} \left( \rho_{i,t}(\theta), 1-\epsilon, 1+\epsilon \right) \hat{A}_i \right) \right] \tag{1}

$$- \(o_i\) 是给定指令 \(q\) 从旧策略 \(\pi_{\theta_{\text{old} } }\) 中采样的响应

- \(t\) 表示响应 \(o_i\) 内的 token 位置

- \(\rho_{i,t}(\theta) = \frac{\pi_{\theta}(o_{i,t} | q, o_{i,< t})}{\pi_{\theta_{\text{old} } }(o_{i,t} | q, o_{i,< t})}\) 是当前策略和先前策略之间的 token 级重要性比率

- \(\epsilon\) 是裁剪系数 (2017)

- 组相对优势计算为:

$$

\hat{A}_i = \frac{r_i - \operatorname{mean} \left( \{r_j\}_{j=1}^{G} \right)}{\operatorname{std} \left( \{r_j\}_{j=1}^{G} \right)} \tag{2}

$$- 其中 \(r_i\) 是响应 \(o_i\) 的奖励,优势是使用 \(G\) 个采样奖励的均值和标准差进行归一化的

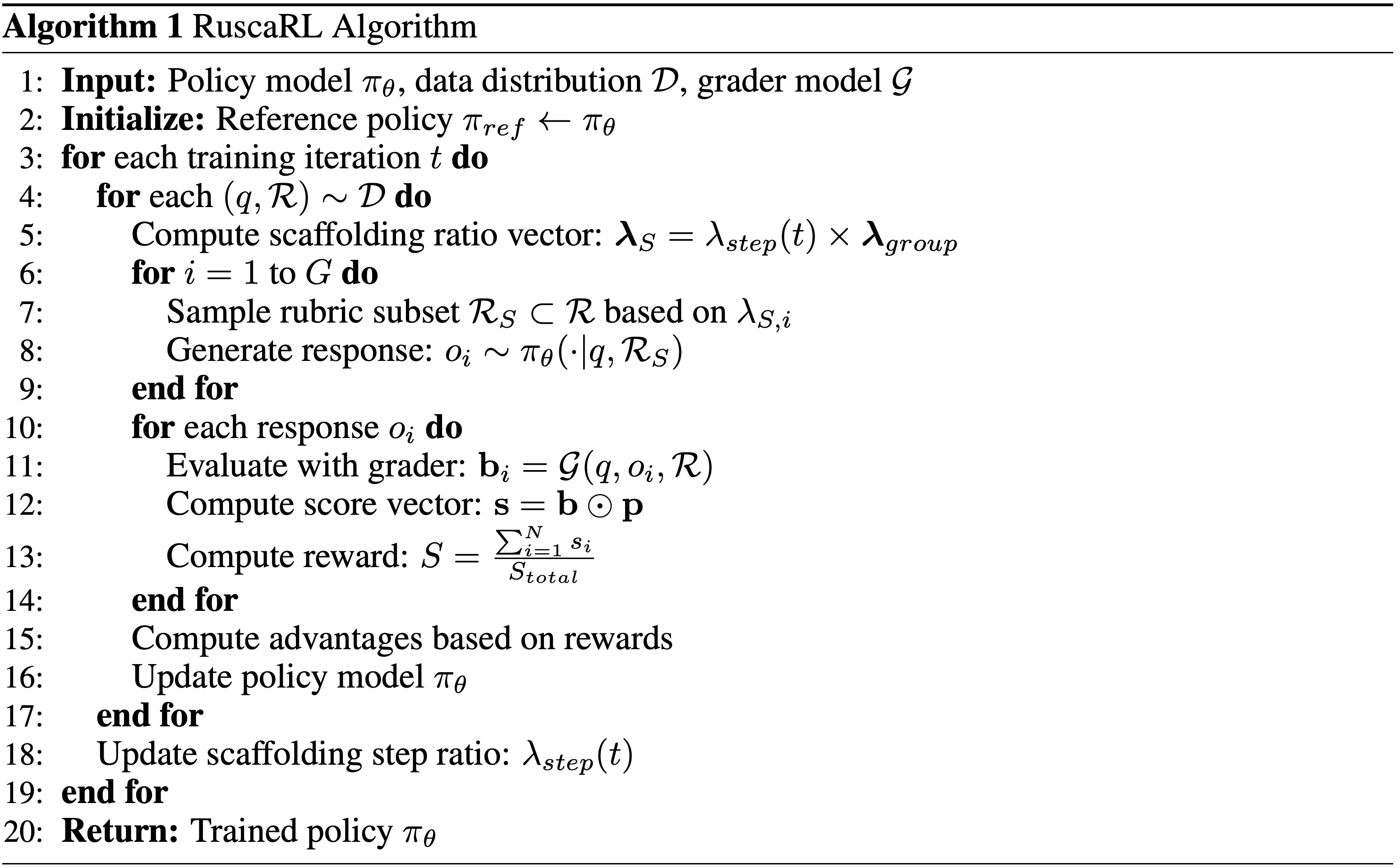

Methodology

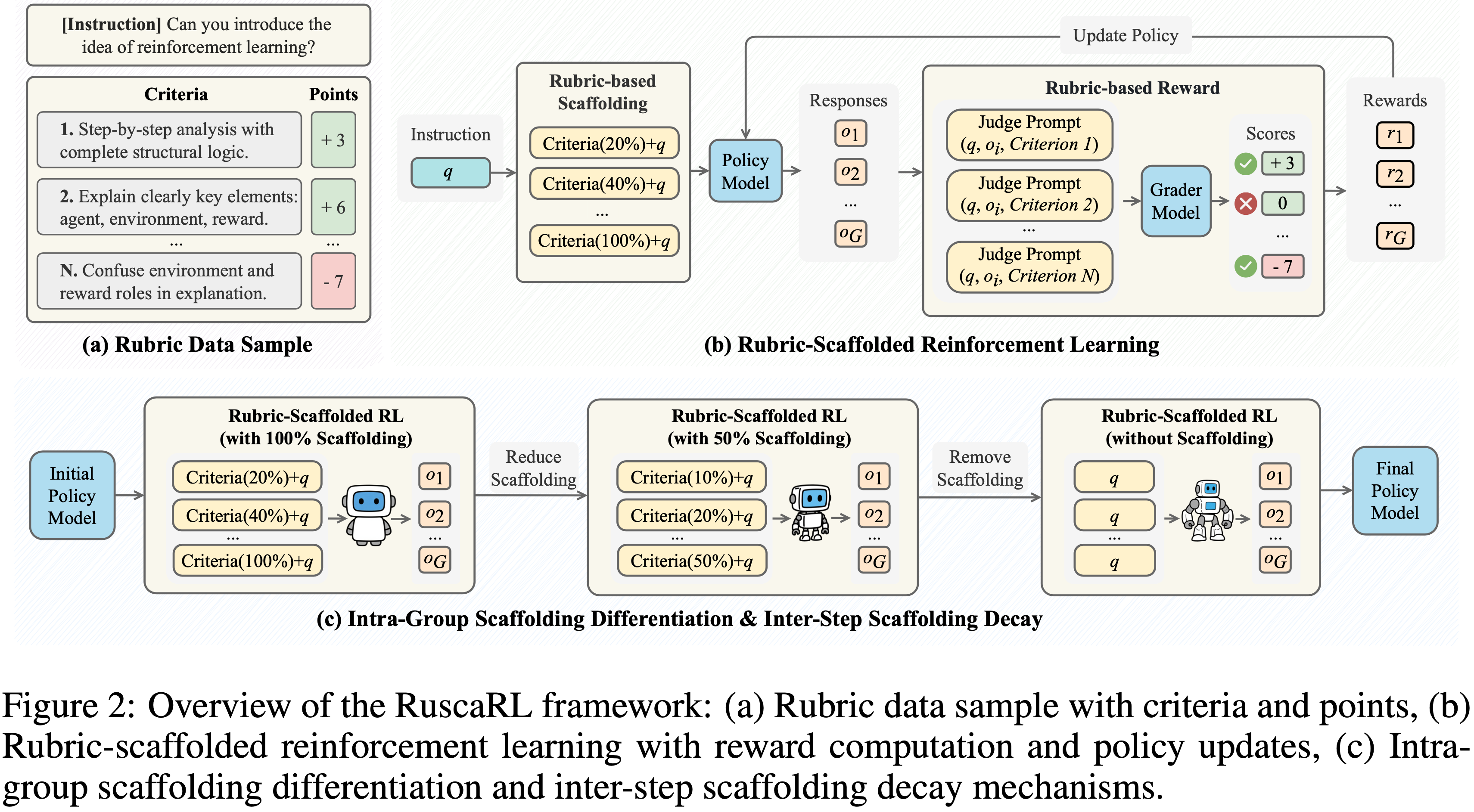

- 为了解决探索瓶颈问题,论文提出了 RuscaRL 框架,如图 2 所示

- RuscaRL 以两种互补的方式利用 Rubric:

- (1) Rollout 生成期间的显式脚手架(Explicit scaffolding during rollout generation) ,其中模型使用 Rubric 作为具有组内差异化和步间衰减的外部引导来生成候选响应(第 4.2 节);

- (2) 模型训练期间的可验证奖励(Verifiable rewards during model training) ,其中响应基于通过二元评估和聚合从 Rubric 派生的多个标准进行评估(第 4.3 节)

- 在下文中,论文首先介绍 Rubric 的基本概念,然后详细介绍这两个核心组件

Rubric-based Evaluation System

- 评估复杂和开放式的任务本质上是具有挑战性的,因为响应通常在结构、风格和内容上有所不同,使得基于规则的评估难以提供可靠的判断

- 为了解决这个差距,最近的工作 (2025) 提出了 Rubric-based 评估

- Rubric-based Evaluation 指定了细粒度、多维度的标准,可以大规模应用

- 这种设计结合了自动指标的客观性和结构化标准的原则性指导,产生能够更好地捕捉响应质量、连贯性和完整性的稳健分数

- 形式上,一个 Rubric 被定义为一组 \(N\) 个可验证的标准:

$$ \mathcal{R} = \{c_1, c_2, \ldots, c_N\} $$- 每个标准 \(c_i\) 由一个清晰的描述和相应的 Points \(p_i\) 指定,\(p_i\) 表示其对整体评估的贡献(理解:即 Rubric 的权重)

- 论文将 Points 向量定义为

$$ \mathbf{p} = [p_1, p_2, \ldots, p_N] $$- 例如,给定指令“你能介绍一下强化学习的概念吗?”,标准可能包括:

- “具有完整结构逻辑的逐步分析”(+3 分)

- “解释关键要素:智能体、环境、奖励”(+6 分)

- 负面项如“在解释中混淆环境和奖励的角色”(-7 分)

- 根据每个标准是否满足来加减分

- 例如,给定指令“你能介绍一下强化学习的概念吗?”,标准可能包括:

- 给定一个指令 \(q\) 及其对应的 Rubric \(\mathcal{R}\)(两者均从数据分布 \(\mathcal{D}\) 中采样),以及通过策略模型 \(\pi_{\theta}(o|q)\) 生成的模型响应 \(o\)

- 论文首先通过组合指令(instruction) \(q\)、Response \(o\) 和标准(criterion) \(c_i\),为每个标准 \(c_i\) 构建一个评判提示(Judge Prompt)

- Grader 的 Judge Prompt 模板在附录 E.1 中提供

- 对于单个标准评估(single criterion evaluation),由 LLM 实现的 Grader 函数 \(\mathcal{G}\) (2023b; 2024) 将 Judge Prompt 作为输入,并输出一个二元决策 指示标准 \(c_i\) 是否被满足( True or False )

$$ b_i = \mathcal{G}(q, o, c_i) \in \{0, 1\}$$ - 将其扩展到完整的 Rubric, Grader 评估所有标准并产生一个二元指示向量

$$ \mathbf{b} = \mathcal{G}(q, o, \mathcal{R}) = [b_1, b_2, \ldots, b_N]$$- 其中每个 \(b_i\) 表示标准 \(c_i\) 的满足情况

- 最终分数(score)向量通过逐元素乘法获得:

$$ \mathbf{s} = \mathbf{b} \odot \mathbf{p} = [b_1 p_1, b_2 p_2, \ldots, b_N p_N] $$- 上述公式提供跨所有指定标准的细粒度分数

- 论文还计算总可能分数(total possible score):

$$ S_{total} = \sum_{j=1}^{M} p_j$$- 其中 \(M\) 是正分标准的数量,这将在奖励计算中用于归一化

Rubric-based Scaffolding Mechanism for RL Exploration(Rubric-based 脚手架机制)

- 在对复杂推理任务进行 RL 训练期间,模型通常无法持续进行有效的探索 (2025a; 2025; 2025a):

- 即 初始随机性迅速减少,策略熵崩溃,模型过早收敛到次优的推理模式

- 这种崩溃严重限制了发现多样化和高质量解决方案轨迹的能力

- 为了缓解这个问题,论文从教育心理学中的教学脚手架理论 (Vygotsky & Cole, 1978) 中获得灵感

- 根据维果茨基的最近发展区(Zone of Proximal Development)理论:

- 当学习者的能力不足时,他们会受益于结构化的指导,以弥合当前能力与目标表现之间的差距,随着能力的增长,这种脚手架应逐渐撤除,以培养独立解决问题的能力 (1976)

- 根据维果茨基的最近发展区(Zone of Proximal Development)理论:

- 基于这一见解,论文设计了一种 Rubric-based 脚手架机制,在整个训练过程中提供不同数量的 Rubric 标准作为显式指导,帮助模型逐渐学会生成高质量的响应

- Specifically,论文的 Rubric-based 脚手架机制通过添加一个 Rubric 标准的子集 \(\mathcal{R}_S\) 作为额外指导来增强原始策略函数,将策略表示为 \(\pi_{\theta}(o|q, \mathcal{R}_S)\)

- 整合脚手架的具体提示模板在附录 E.2 中详述

- Additionally,论文设计了一个二维控制机制来确定 Rubric 脚手架比率 \(\lambda_S\) ,然后从完整的 Rubric 集合 \(\mathcal{R}\) 中采样标准(criteria)以形成 \(\mathcal{R}_S\) ,即

$$ |\mathcal{R}_S| = \text{round}(\lambda_S \times |\mathcal{R}|) $$- 论文在两个维度上实例化这个机制:组内脚手架差异化(Intra-Group Scaffolding Differentiation)和步间脚手架衰减(Inter-Step Scaffolding Decay)

Intra-Group Scaffolding Differentiation, 组内脚手架差异化

- 在具有多重采样(如 GRPO)的 RL 算法中,计算组相对优势(方程 2)需要响应多样性以避免崩溃为同质样本

- 为此(To this end),论文在每个组内分配不同级别的 Rubric 脚手架,鼓励既有引导的探索也有独立的探索

- 具体来说(Concretely),论文定义一个组级比率向量(group-level ratio vector):

$$ \boldsymbol{\lambda}_{group} = [\lambda_1, \lambda_2, \ldots, \lambda_G] $$- 其中对于大小为 \(G\) 的组中的第 \(i\) 个样本,\(\lambda_i = \frac{G-i}{G-1}\)

- 这种线性差异化确保了一些样本受益于更强的脚手架,而其他样本则被刻意暴露于较弱的引导下,从而增强了组内多样性

- 理解:结合前文内容可知,这里的 \(\lambda\) 影响的是包含 Rubric 的数量

- \(\lambda\) 越小,使用的 Rubric 越少

- \(\lambda=0\) 时,完全不使用 Rubric

- \(\lambda=1\) 时,使用全部的 Rubric

- 理解:结合前文内容可知,这里的 \(\lambda\) 影响的是包含 Rubric 的数量

Inter-Step Scaffolding Decay(step 间脚手架衰减)

- 受教学脚手架理论的启发,论文使用一个 sigmoid 函数逐渐减少引导:

$$ \lambda_{step}(t) = \frac{1}{1+e^{\alpha(t-t_0)} }$$- 其中 \(t\) 是当前的训练进度 (\(t \in [0, 1]\))

- \(t_0\) 是中点

- \(\alpha\) 控制衰减的陡峭度(the steepness of decay)

- 这种机制通过创建一个自适应学习环境来防止过度依赖外部引导,在这个环境中,模型最初受益于引导以克服探索瓶颈,然后随着能力成熟逐渐过渡到独立推理

Integrated Scaffolding Mechanism

- Finally,论文将组内差异化和步间衰减结合成一个统一的比率向量:

$$

\boldsymbol{\lambda}_S = \lambda_{step} \left( t \right) \times \boldsymbol{\lambda}_{group} = [\lambda_{S,1}, \lambda_{S,2}, \ldots, \lambda_{S,G}],

$$- 其中 \(\lambda_{S,i}\) 表示组中第 \(i\) 个样本的脚手架比率:

$$ \lambda_{S,i} = \lambda_{step}(t) \times \lambda_i = \frac{1}{1+e^{\alpha(t-t_0)} } \times \frac{G-i}{G-1}$$

- 其中 \(\lambda_{S,i}\) 表示组中第 \(i\) 个样本的脚手架比率:

- 这种集成机制同时促进了每个组内的响应多样性,并自适应地减少了训练步骤间对脚手架的依赖,共同解决了同质性和过拟合的问题

Rubric-based Reward Function for RL Exploitation(for RL 利用)

- 为了为通用推理任务提供稳健可靠的奖励信号,论文设计了 Rubric-based 奖励函数

- 对于评估系统中获得的多维分数向量

$$\mathbf{s} = [s_1, s_2, \ldots, s_N]$$- 通过直接求和所有标准分数并除以第 4.1 节计算的总可能分数来聚合为最终标量奖励:

$$

S = \frac{\sum_{i=1}^{N} s_i}{S_{total} },

$$- \(S\) 代表最终分数

- \(s_i\) 是第 \(i\) 个标准的分数

- \(S_{total}\) 是第 4.1 节计算的所有正分标准的总可能分数

- 通过直接求和所有标准分数并除以第 4.1 节计算的总可能分数来聚合为最终标量奖励:

- 这种计算方法得到的分数在大多数情况下落在区间 \([0,1]\) 内,偶尔可能出现负分数

- 论文直接采用这个 Rubric-based 分数 \(S\) 作为论文的奖励:

$$ r_i = S_i $$- 其中 \(r_i\) 是第 \(i\) 个响应的奖励

- 论文直接采用这个 Rubric-based 分数 \(S\) 作为论文的奖励:

- 这种方法使得在没有真实答案的开放式任务中得以应用,同时提供了比整体 LLM 评分更稳健的评估

- 获得了 Rubric-based 奖励后,就可以使用 RL 算法来训练策略模型

- 训练过程遵循策略梯度框架,其中模型学习最大化期望奖励

- 附录 B 中的算法 1 概述了完整的训练过程

- Additionally,为了帮助模型更好地内化底层推理模式,训练中的对数概率计算基于 \(\pi_{\theta}(o_{i,t} | q, o_{i,< t})\) 而不是 \(\pi_{\theta}(o_{i,t} | q, \mathcal{R}_S, o_{i,< t})\)

- 问题:这里训练时使用的回复内容和 Rollout 时使用的内容不一致,不会导致 Off-Policy 的问题吗?

- 回答:会的,论文附录 D.5 中会分析这个问题并给出一些解决方案

- 关于重要性采样的详细分析,请参见附录 D.5

- Additionally,为了帮助模型更好地内化底层推理模式,训练中的对数概率计算基于 \(\pi_{\theta}(o_{i,t} | q, o_{i,< t})\) 而不是 \(\pi_{\theta}(o_{i,t} | q, \mathcal{R}_S, o_{i,< t})\)

Experiments

- 为了验证所提出的 RuscaRL 方法的有效性,论文在涵盖医学、写作、指令遵循和 STEM 领域的多个基准测试上进行了实验

- 论文的实验旨在回答以下问题:

- (1) RuscaRL 在不同模型和任务上是否展示出一致的有效性,以及它与现有的微调方法相比如何?(第 5.2 节和附录 D.1, D.2, D.3)

- (2) RuscaRL 如何打破 LLM 推理中 RL 的探索瓶颈?(第 5.3 节和附录 D.4)

- (3) Rubric-based Scaffolding 机制中不同组件的影响是什么?(第 5.4 节和附录 D.5)

Experimental Setups

Models and Training Settings

- 论文使用了来自不同系列和参数规模的多个初始模型进行实验,包括 Qwen2.5 系列 (2024)、Qwen3 系列 (2025) 和 Llama-3 系列 (Meta-AI, 2025; 2024) 中的 Instruct 模型和 Base 模型

- 所有模型均使用 GRPO 算法在 verl 框架 (2025) 上进行训练

- 详细的训练设置见附录 C.1

Evaluation Benchmarks

- 论文使用 HealthBench-500(从 HealthBench (2025) 中随机抽取的 500 个样本子集)作为保留评估集

- 此外,论文还评估了其他医学基准,包括 LLMEval-Med (2025b)、MedQA (2021) 和 MedMCQA (2022)

- 对于写作领域,论文使用 WritingBench (2025c) 和 Creative Writing v3 (Paech, 2025) 基准

- 对于指令遵循领域,论文使用 IFEVAL (2023b) 和 IFBench (2025) 基准

- 对于 STEM 领域,论文使用 GPQA Diamond (2024)、MMLU (2020)、MMLU-Pro (2024)、MATH-500 (2023)、AMC 2023、AIME 2024 和 AIME 2025

- 详细的评估设置见附录 C.2

Baselines

- 论文将 RuscaRL 与四种代表性的基线方法进行比较:

- (1) Rubric-based RL:

- 使用 GRPO 算法实现,以 Rubric 分数作为奖励 (2025)

- (2) 带有完整 Scaffolding 的 Rubric-based RL (Rubric-based RL-S):

- 一种在指令中提供所有 Rubric 作为 Scaffolding 支持的方法,没有组内差异化,也没有逐步衰减功能

- (3) SFT:

- 在 GPT-4.1 (OpenAI, 2025b) 生成的、带有 Scaffolding 支持的演示数据上进行微调

- (4) SFT + Rubric-based RL:

- 一种组合方法,先应用 SFT,然后应用 Rubric-based RL 训练

- (1) Rubric-based RL:

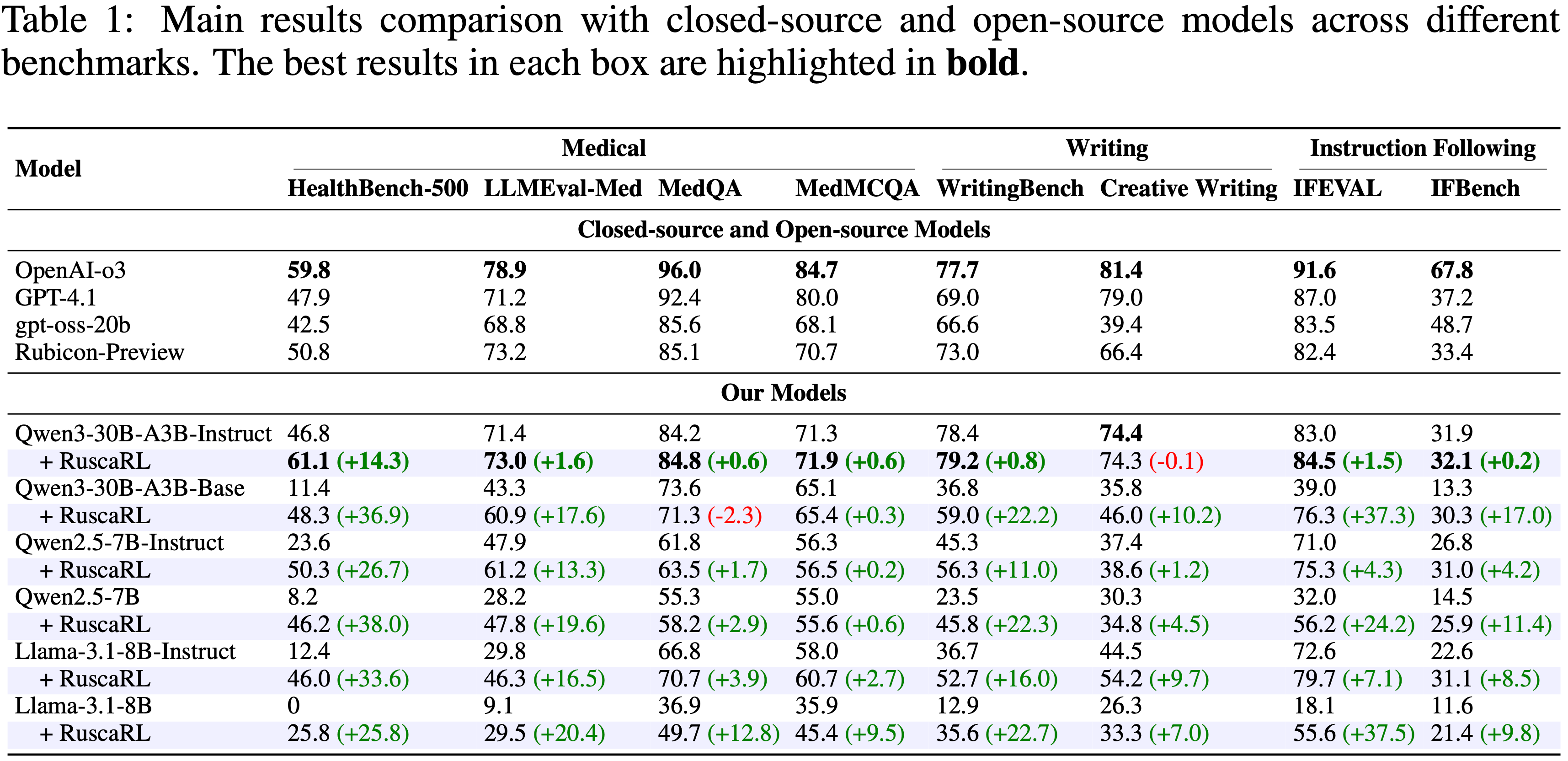

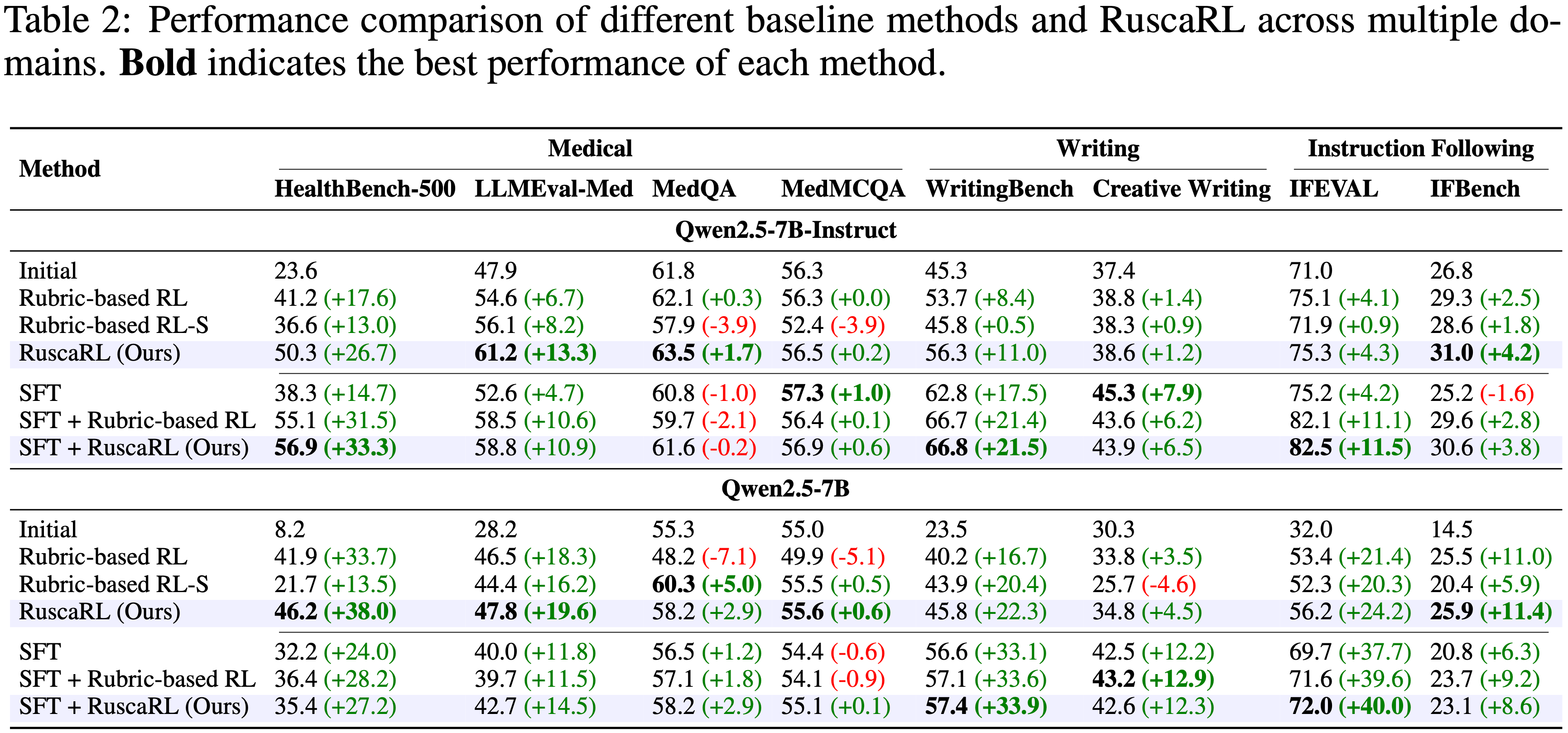

Overall Performance

RuscaRL achieves consistent and notable gains across tasks and model scales, showcasing its effectiveness and broad generalization(RuscaRL 在任务和模型规模上取得了一致的显著提升)

- 在医学、写作和指令遵循任务中(表 1),RuscaRL 相对于多个初始模型取得了显著提升,其中 Qwen3-30B-A3B-Instruct 在 HealthBench-500 上的表现超越了许多领先模型(例如 OpenAI-o3)

- Notably,RuscaRL 对 Instruct 模型特别有效,并对较弱模型(如 Llama-3.1-8B-Instruct)提供了更大的增益

- 这一优势源于论文的 Scaffolding 方法,它利用了模型现有的指令遵循能力来引出更高质量和更多样化的 Response,这解释了为什么 RuscaRL 特别适合在具有强指令遵循能力的模型上进行训练

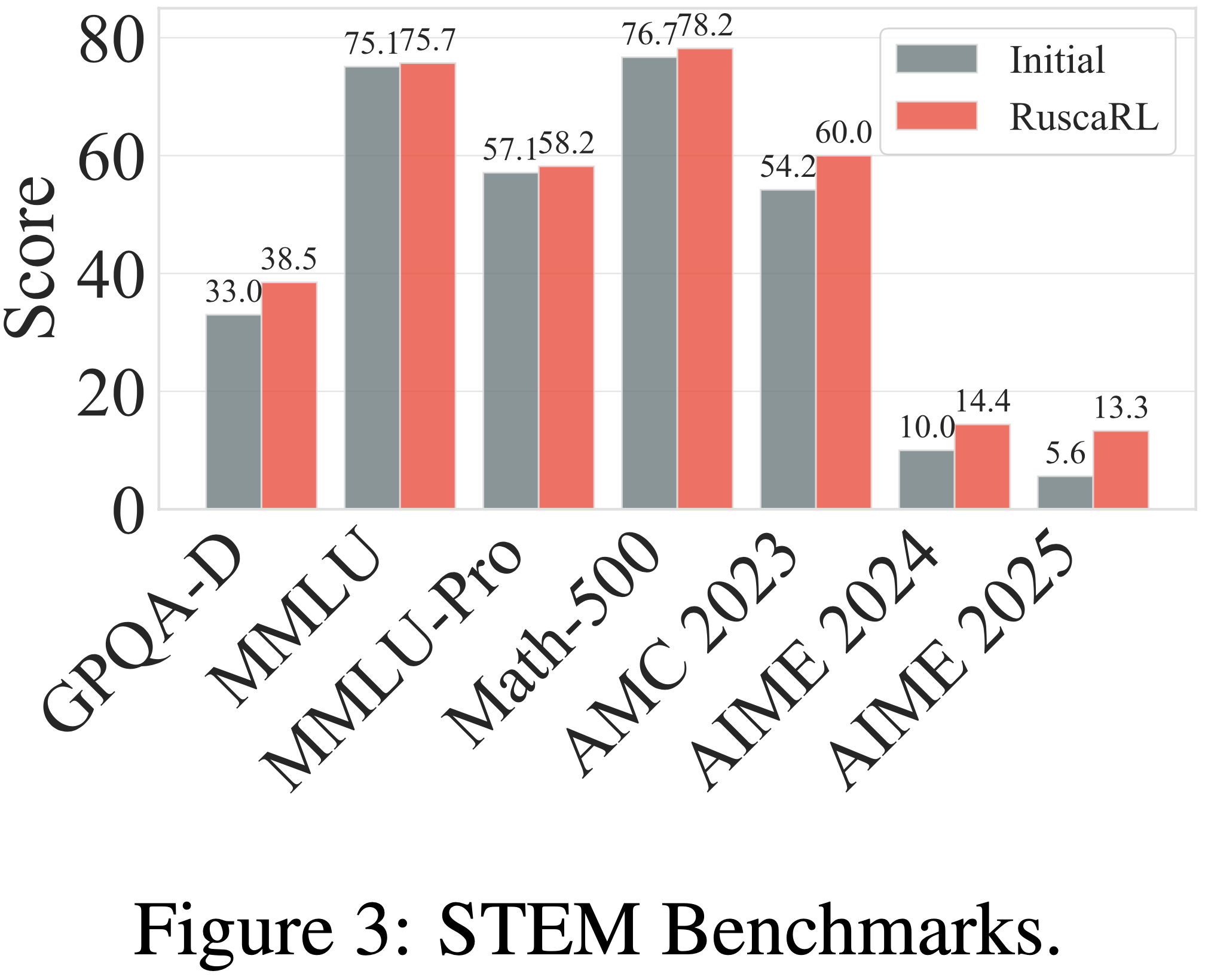

- Meanwhile,RuscaRL 也已成功扩展到 STEM 领域:

- 在 Qwen2.5-7B-Instruct 上的实验显示,在所有 STEM 基准测试中均有一致的性能提升(见图 3)

- 关于不同模型系列和规模的性能更详细结果见附录 D.1,进一步证明了论文方法的鲁棒性和广泛适用性

- Additionally,论文在附录 D.2 中探讨了混合不同领域训练数据的效果

RuscaRL consistently outperforms Rubrics-based methods across tasks(RuscaRL 优于 Rubric-based 方法)

- 如表 2 所示

- 在 直接 RL(direct RL) Setting 中

- RuscaRL 在大多数医学、写作和指令遵循任务上取得了最佳性能

- 比 Rubric-based RL 和 RL-S 带来了更大且更稳定的增益(例如,在使用 Qwen2.5-7B-Instruct 时,HealthBench-500 上的准确率为 50.3 对比 41.2 和 36.6)

- 在 先 SFT 后 RL(SFT-then-RL) Setting 中

- RuscaRL 和 Rubric-based RL 都在 SFT 基础上取得了额外的提升,但 RuscaRL 在大多数任务上通常带来更大的增益,尽管幅度小于直接 RL 设置

- 作者认为 RuscaRL 本质上是利用 Rubric 作为先验知识来指导探索,而 SFT 也用于加速 RL 探索(冷启动)

- 由于这两种机制在促进探索方面存在重叠,这可能解释了为何在 SFT 后 RL 设置下,RuscaRL 与 Rubric-based RL 之间的性能差距会缩小

- 在 直接 RL(direct RL) Setting 中

Analysis

- 本小节以 Qwen2.5-7B-Instruct 作为初始模型,HealthBench 作为训练和评估数据集,对 RuscaRL 进行分析

- In Addition,论文在以下分析中比较了三种方法:

- RuscaRL

- RuscaRL* (不带逐步衰减机制的 RuscaRL)

- Rubric-based RL

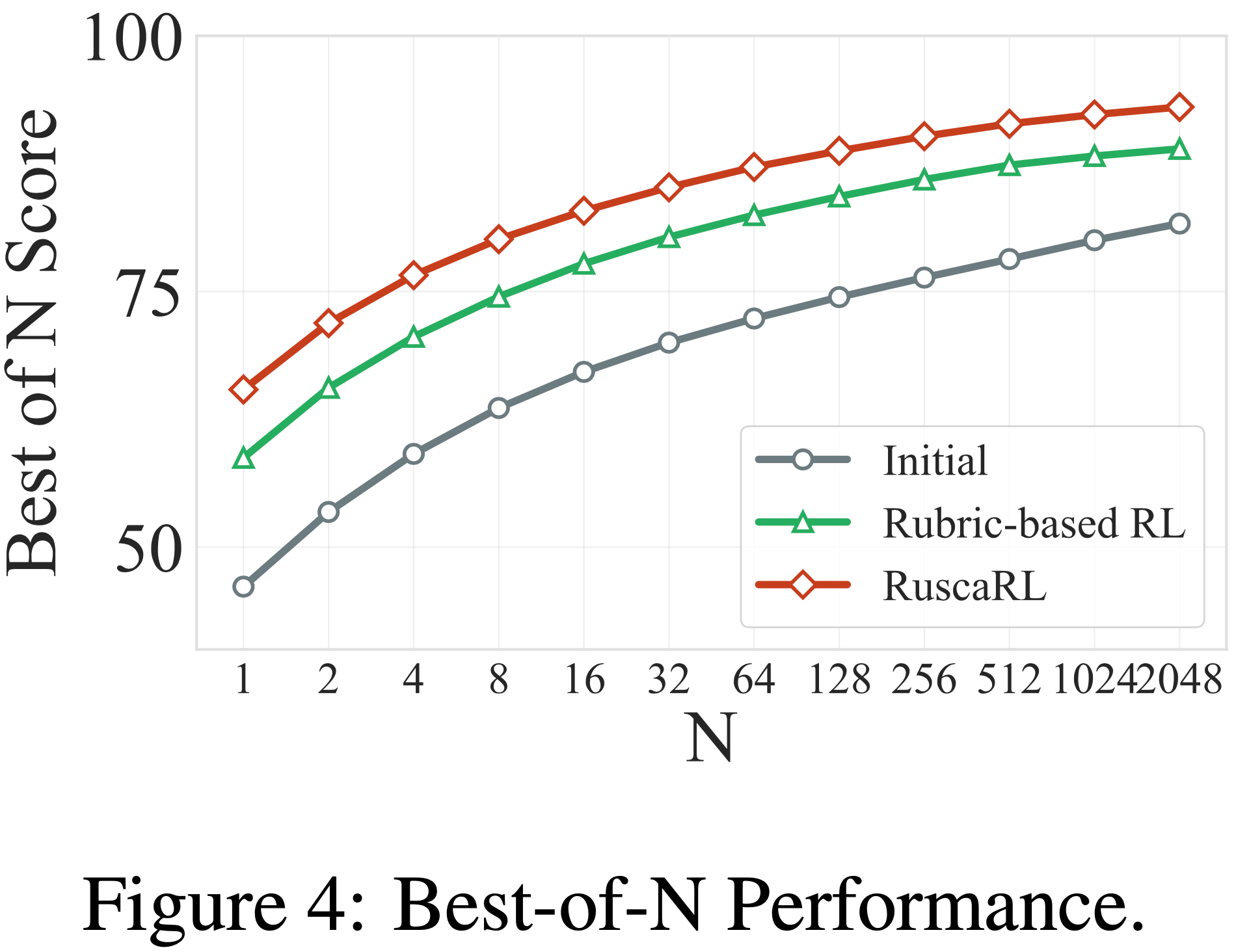

- 论文使用 Best-of-N 指标来反映模型的推理边界(在大的 N 时)和采样效率(在小的 N 时)

RuscaRL significantly improves sampling efficiency and reasoning boundaries.

- 如图 4 所示

- RuscaRL 显著提高了 N=1 时的单样本质量,表明 Scaffolding 机制有效地增强了模型的推理稳定性

- 在 N=2048 时,其性能上限超过了初始模型和 Rubric-based RL,验证了其在扩展推理边界方面的优势

- Moreover,RuscaRL 在 N 变化时表现出更陡峭的性能曲线,意味着它可以用更少的样本达到相同的性能

- 进一步分析(附录 D.4.1)表明,RuscaRL 还 产生了初始模型几乎无法生成的高度新颖的 Response(produces highly novel responses that theinitial model could barely generate) ,这表明 Rubric Scaffolding 有效地打破了探索瓶颈并发现了新的解决方案

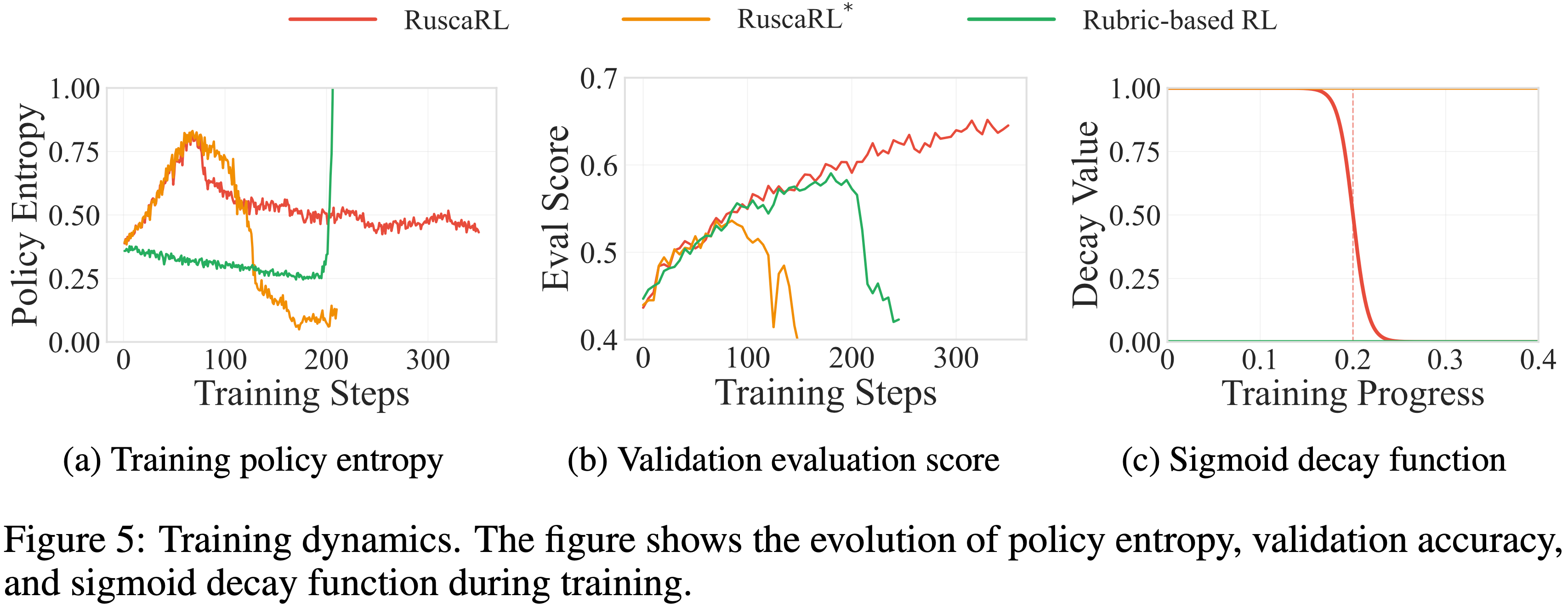

RuscaRL achieves exploration-exploitation balance

- 如图 5 (a) 所示,RuscaRL 展示了一个平衡良好的探索-利用轨迹:

- 策略熵首先随着模型探索多样化的推理轨迹而上升,然后随着其收敛到高质量模式而下降

- In Contrast,RuscaRL* 遭受不受控制的熵增长导致不稳定,而 Rubric-based RL 则在持续的熵下降中崩溃

- 理解:这里单从熵上(5(a))看,RuscaRL 和 RuscaRL* 其实差不多,只是评估分数在一百步左右突然崩溃了

- 验证准确率(图 5 (b))一致显示

- RuscaRL 在整个训练过程中实现了最佳性能,展现了没有策略熵崩溃的长期稳定性,其次是 Rubric-based RL,然后是 RuscaRL*

- 在 Self-BLEU 和语义距离(附录 D.4.2)中也观察到了类似的趋势,证实 RuscaRL 实现了有效的探索,随后是稳定的利用

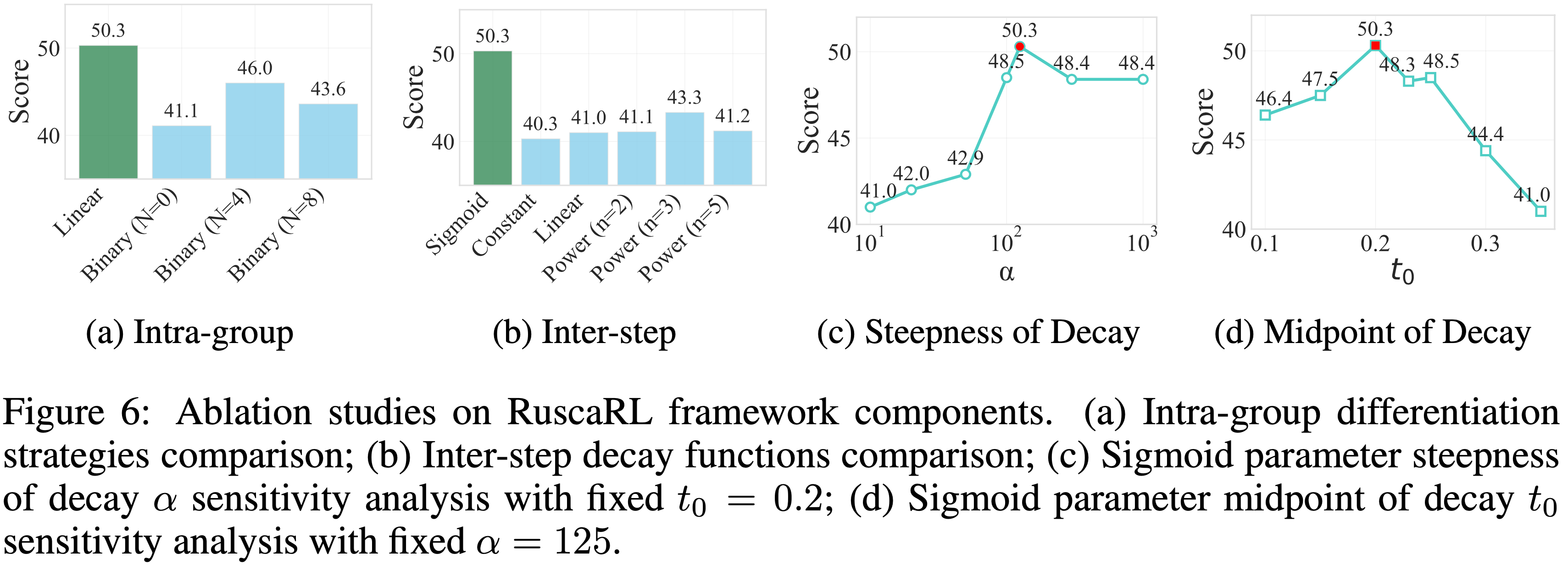

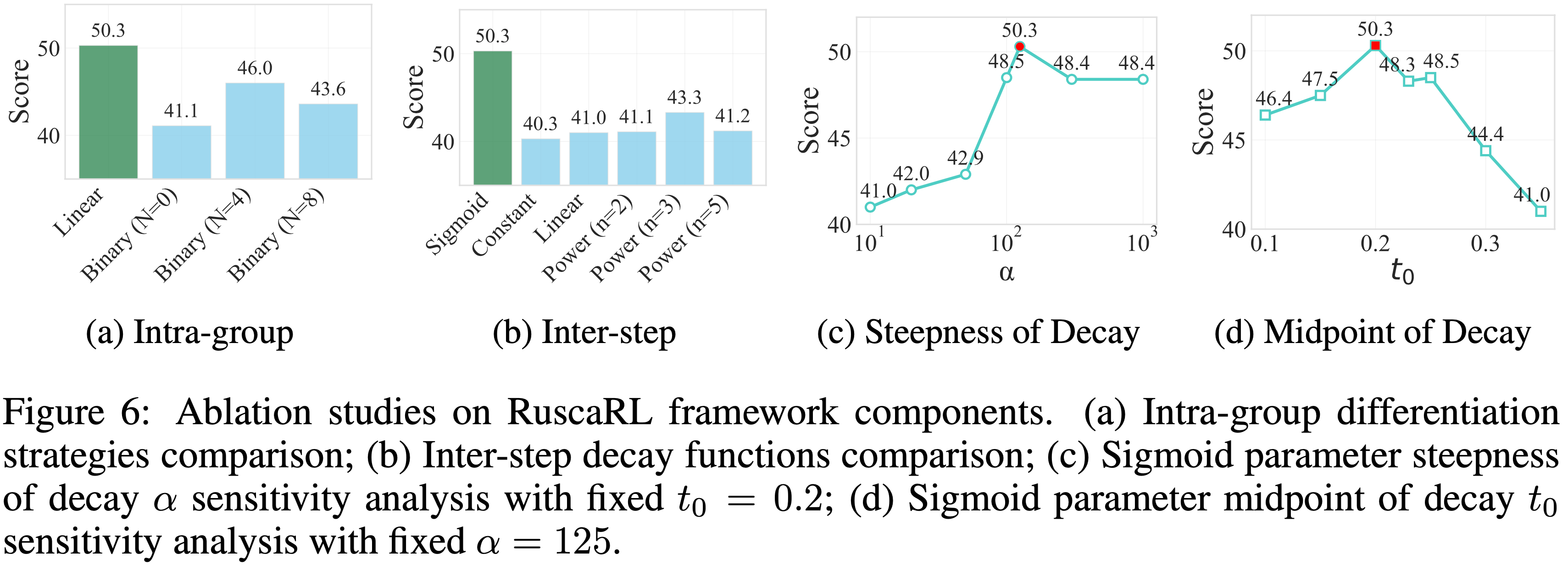

Ablation Studies

Intra-group Differentiation Analysis

- 论文首先以 Qwen2.5-7B-Instruct 作为初始模型,HealthBench 作为训练和评估数据集,分析组内控制机制的不同策略

- 在单个采样组内,论文比较了不同的 Rubric Scaffolding 差异化模式

- 这些机制是:

- (1) Linear(Ours): 遵循论文提出的公式 \(\lambda_i = \frac{G-i}{G-1}\) 的线性差异化模式

- 为单个采样组内的不同样本提供不同水平的 Rubric Scaffolding

- (2) Binary: 二元差异化模式,其中 N 表示单个采样组内具有完整 Rubric Scaffolding 的样本数量

- 包括无 Scaffolding (N=0)、半数 Scaffolding (N=4) 和完整 Scaffolding (N=8) 等配置

- (1) Linear(Ours): 遵循论文提出的公式 \(\lambda_i = \frac{G-i}{G-1}\) 的线性差异化模式

- 如图 6 (a) 所示,线性差异化策略在组内控制中表现最优

- 这一结果可归因于线性策略显著增强了采样多样性,这与 GRPO 等多采样算法协同工作

- 这一结果可归因于线性策略显著增强了采样多样性,这与 GRPO 等多采样算法协同工作

Inter-step Decay Analysis

- 论文分析了训练过程中用于逐步控制的不同衰减函数

- 论文将逐步控制的基础 Scaffolding 强度定义为 \(f(t)\),其中 \(t\) 是归一化的训练进度(\(t \in [0,1]\))

- 论文比较了以下衰减函数:

- (1) Sigmoid(Ours): S 形衰减函数

$$f(t) = \frac{1}{1+e^{\alpha(t-t_0)} } $$- 其中参数 \(\alpha\) 控制衰减的陡峭度,\(t_0\) 控制衰减的中点,实现了平滑的非线性过渡

- (2) Constant: 常数控制 \(f(t) = 1\),保持恒定的完整 Scaffolding

- (3) Linear: 线性衰减函数 \(f(t) = 1 - t\),实现均匀的线性减少

- (4) Power(n): 幂衰减函数 \(f(t) = (1-t)^n\),其中 \(n\) 控制衰减的曲率,包括各种幂次配置

- (1) Sigmoid(Ours): S 形衰减函数

- 如图 6 (b) 所示,Sigmoid 衰减函数在所有衰减策略中取得了最佳性能

- In Contrast,线性和幂衰减策略表现较差,作者认为这是由于长时间的 Scaffolding 添加可能导致模型过度适应相应的 Scaffolding,而不是专注于实际的指令内容

- Sigmoid 函数通过其平滑的非线性过渡特性,在训练早期提供足够的 Scaffolding 支持,然后逐渐减少依赖,避免了过拟合问题

- 基于 Sigmoid 函数的优越性能,论文进一步使用 Qwen2.5-7B-Instruct 作为初始模型,HealthBench 作为训练和评估数据集,分析了两个参数维度(速度 \(\alpha\) 和 中点 \(t_0\))的影响

- (1) 移除 Scaffolding 的速度:

- 移除 Scaffolding 过快(大的 \(\alpha\))会使模型难以适应快速的 Scaffolding 变化,容易导致训练不稳定;

- 移除 Scaffolding 过慢(小的 \(\alpha\))会导致早期阶段 Scaffolding 支持不完整,未能充分激发模型的探索能力,并且在后期阶段长时间保留 Scaffolding 也会导致过拟合问题

- 问题:为什么早期阶段 Scaffolding 支持不完整?移除 Scaffolding 过慢 不是反而能更多探索吗?

- 我的个人理解:移除 Scaffolding 过慢会导致模型过度依赖 Scaffolding,最终导致过拟合

- 问题:为什么早期阶段 Scaffolding 支持不完整?移除 Scaffolding 过慢 不是反而能更多探索吗?

- (2) 衰减时机:

- 衰减开始过早(小的 \(t_0\))会导致 Scaffolding 支持不足,使模型在训练早期缺乏必要的指导;

- 衰减开始过晚(大的 \(t_0\))会导致模型过度依赖 Scaffolding,最终导致过拟合

- (1) 移除 Scaffolding 的速度:

- 图 6 (c) 和 6 (d) 展示了不同 Sigmoid 参数配置下的性能差异,最终确定最优配置为 \(\alpha=125, t_0=0.2\)

附录 A:Additional Related Works

LLM Reasoning

- 虽然早期的方法如提示工程 (2022;2022) 和监督微调 (2022) 取得了令人鼓舞的结果,但它们对任务特定提示或大量标注数据的依赖限制了其可扩展性和跨领域泛化能力 (2020;2024;2024;2023)

- 最近的工作发现,使用更多的测试时计算 (2024;2024;2025) 可以提高 LLM 的推理性能

- 最近,RLVR (2024;2025;2025) 已成为训练 LLM 解决可验证问题的有前景范式,在数学和代码等领域显示出强大的推理改进 (2025;2025;2024;2025)。然而,它面临着显著的探索瓶颈 (2025;2025;2025),并且难以扩展到难以验证正确性的通用任务 (2025;2025)

附录 B:Algorithm Pseudocode

- 算法 1 提供了论文 RuscaRL 训练过程的完整伪代码,说明了关键组成部分,包括组内 Scaffolding 差异化、步间 Scaffolding 衰减和 Rubric-based 奖励计算

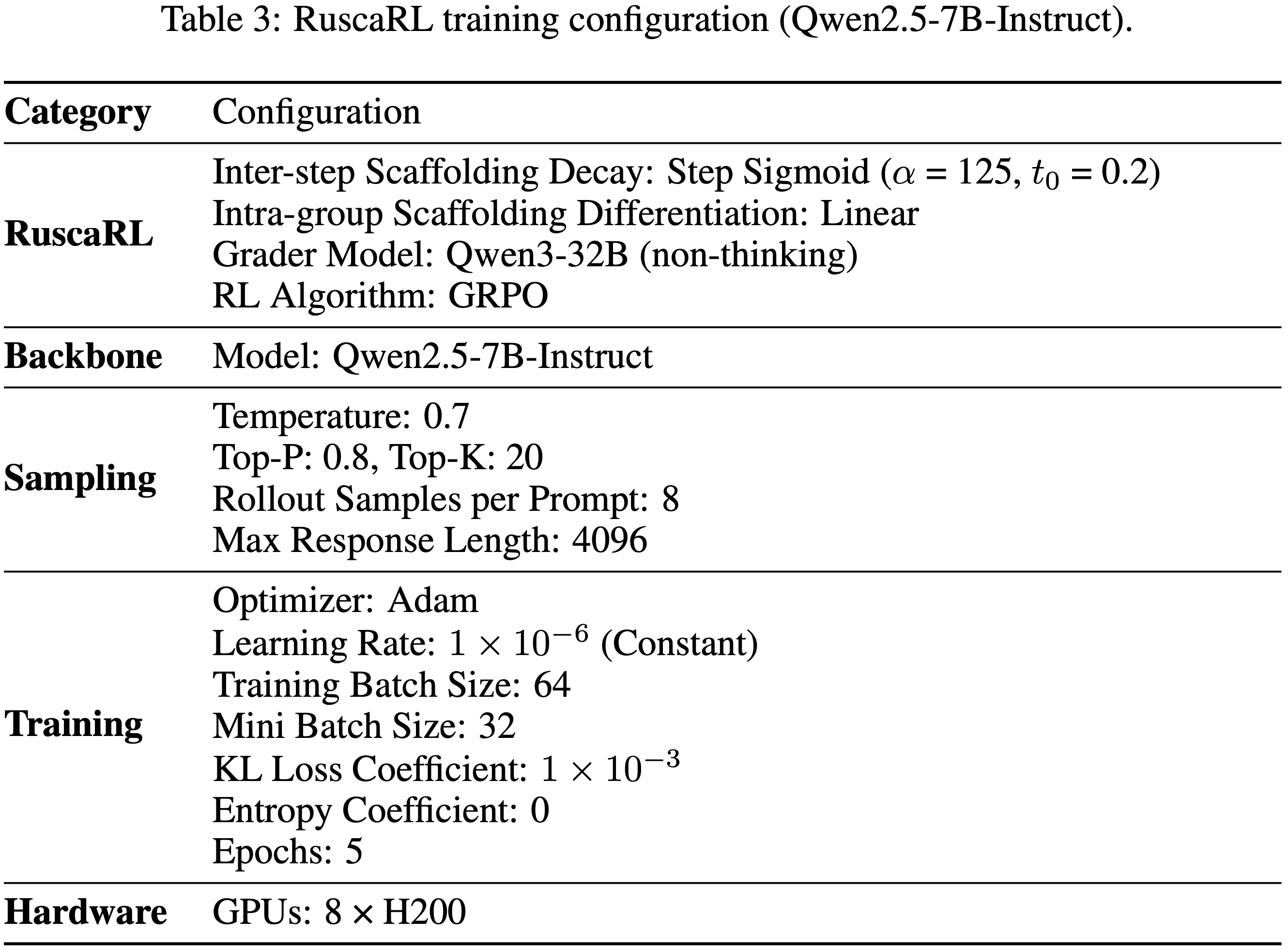

附录 C:Detailed Experimental Settings

C.1 Detailed Training Settings

Initial Models

- 论文对不同系列和参数规模的模型进行了训练,包括 Qwen2.5 系列 (Qwen2.5-3B-Instruct, Qwen2.5-7B-Instruct, Qwen2.5-7B, Qwen2.5-32B-Instruct, Qwen2.5-32B),Qwen3 系列 (Qwen3-4B-Instruct-2507, Qwen3-4B-Base, Qwen3-30B-A3B-Instruct-2507, Qwen3-30B-A3B-Base),以及 Llama-3 系列 (Llama-3.1-8B-Instruct, Llama-3.1-8B, Llama-3.2-3B-Instruct)

Training Datasets

- 对于医学领域,论文使用从 HealthBench 中排除 HealthBench-500 后剩余的 4500 个样本

- 对于其他领域,论文通过调用 GPT-4.1 (2025b) 并附上附录 E.3 中详述的特定提示词来生成类似 HealthBench 的 Rubric 数据

- 对于写作领域,论文结合了 LongWriter-6k (2024) 和 LongWriter-Zero-RLData (2025b) 数据集

- 对于指令遵循领域,论文使用了 IF-multi-constraints-upto5 (2025) 数据集

- 对于 STEM 领域,论文使用了 SCP-116K (2025) 和 MATH 训练数据集 Level 3-5 (2021)

Training Configurations

- 本节提供了详细的训练配置,如表 3 所示

- 所有模型共享相同的超参数,除了 sigmoid 衰减函数中的 \(t_{0}\) 参数

- 具体来说,Qwen3-30B-A3B-Instruct 和 Qwen3-30B-A3B-Base 使用 \(t_{0}=0.1\)

- Llama-3.1-8B-Instruct 和 Llama-3.1-8B 使用 \(t_{0}=0.15\)

- Llama-3.2-3B-Instruct 使用 \(t_{0}=0.3\)

- 其余模型 (Qwen2.5-3B-Instruct, Qwen2.5-7B-Instruct, Qwen2.5-7B, Qwen2.5-32B-Instruct, Qwen2.5-32B, Qwen3-4B-Instruct-2507 和 Qwen3-4B-Base) 使用 \(t_{0}=0.2\)

C.2 Detailed Evaluation Settings

- 对于医学基准测试 (HealthBench-500 和 LLMEval-Med),论文使用 GPT-4.1 作为 Grader 模型

- 对于写作基准测试 (WritingBench 和 Creative Writing v3),论文使用 Claude-Sonnet-4 作为 Grader 模型

- 论文的生成参数在所有评估中均设置为

Temperature=0.7,Top-P=0.8,Top-K=20 - 最大输出长度配置为:

- 非写作任务 4096 tokens

- 写作任务 16000 tokens

- 指标方面:

- 对于 IFEVAL 和 IFBench,论文报告 Prompt-level 的严格准确率(strict-accuracy)指标

- 对于 HealthBench-500、LLMEval-Med 和 WritingBench,论文报告单次评估结果;

- 对于 MedQA、MedMCQA、Creative Writing v3、IFEVAL、IFBench、GPQA-D、MMLU、MMLU-Pro、MATH-500、AMC 2023、AIME 2024 和 AIME 2025,论文报告三次运行的平均值

- 注:所有分数都转换为百分比制报告

- 论文还与其他模型进行了比较,包括:

- 闭源模型 (OpenAI-o3 (2025a)、GPT-4.1 (2025b)、Gemini-2.5-Pro (2025))

- 开源模型 (DeepSeek-R1-0528 (2025)、Qwen3-235B-Thinking-2507 (2025)、Kimi-K2-Instruct (2025)、gpt-oss-120b、gpt-oss-20b (2025c)、Rubicon-Preview (2025)),在 HealthBench-500(图1)上展示了论文方法的竞争力

附录 D:Detailed Experimental Analysis

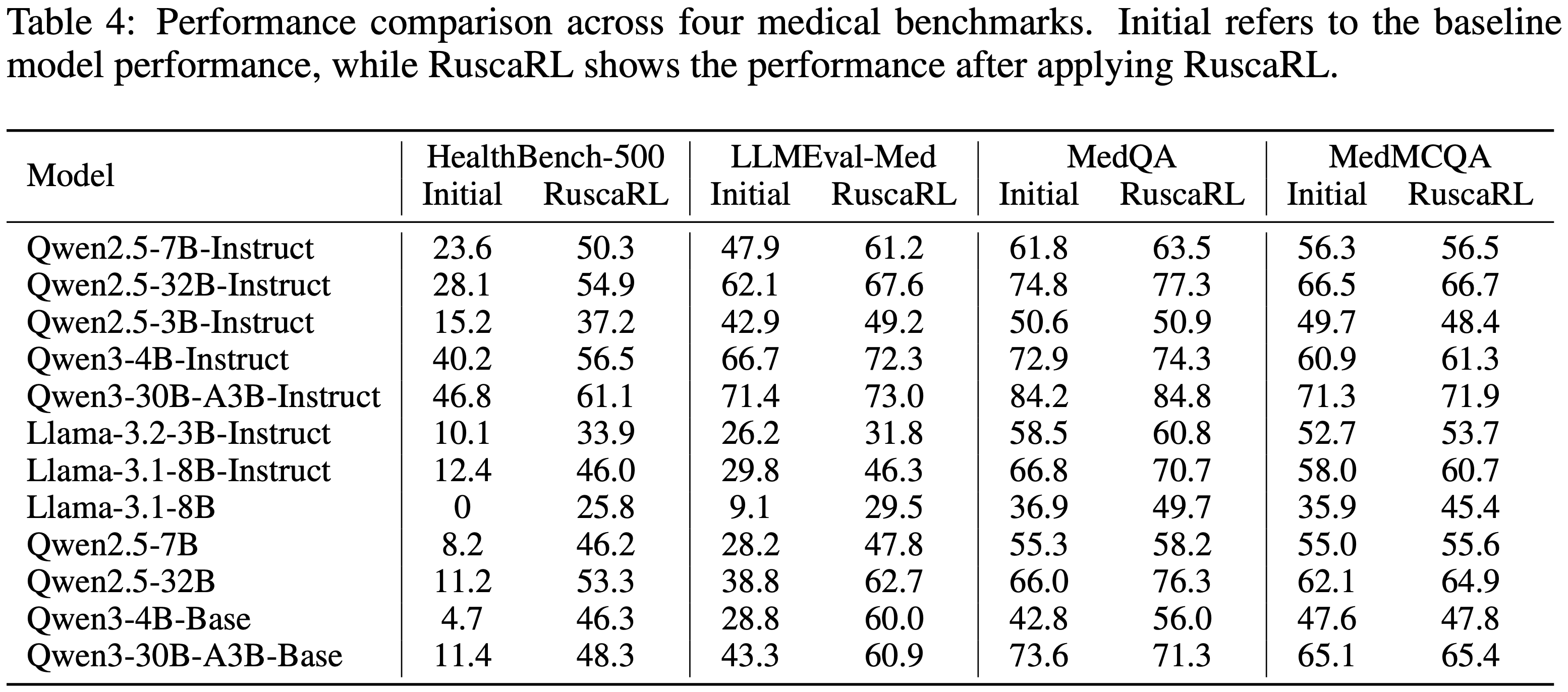

D.1 Performance Across Different Models

- 表 4 显示了初始模型性能与 RuscaRL 增强后性能的比较,展示了不同模型系列和规模下的改进

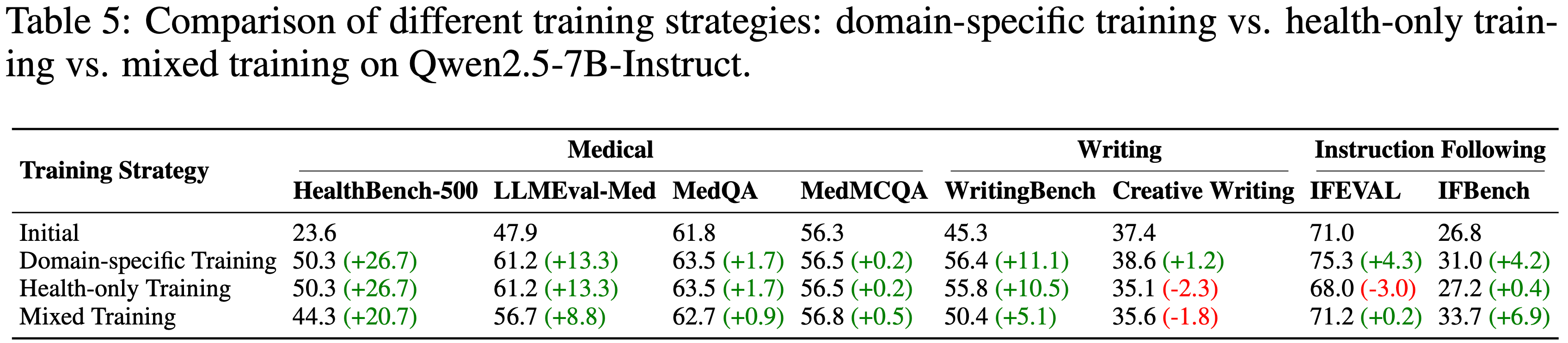

D.2 Mixed Training Analysis

- 为了评估不同训练策略的有效性,论文在 Qwen2.5-7B-Instruct 上比较了领域特定训练、仅医疗领域训练和混合训练方法

- 如表 5 所示,领域特定训练在大多数基准测试上取得了最佳的整体性能,证明了针对特定领域进行优化的好处

- 仅医疗领域训练在医学基准测试上表现良好,但在非医学任务上改进有限,仅在 IFEVAL 上观察到轻微下降,凸显了专业化与泛化之间的权衡

- 混合训练结合了所有领域的数据,提供了一种平衡的方法,在不同任务类别上实现了适度的改进,尽管没有达到领域特定训练的峰值性能

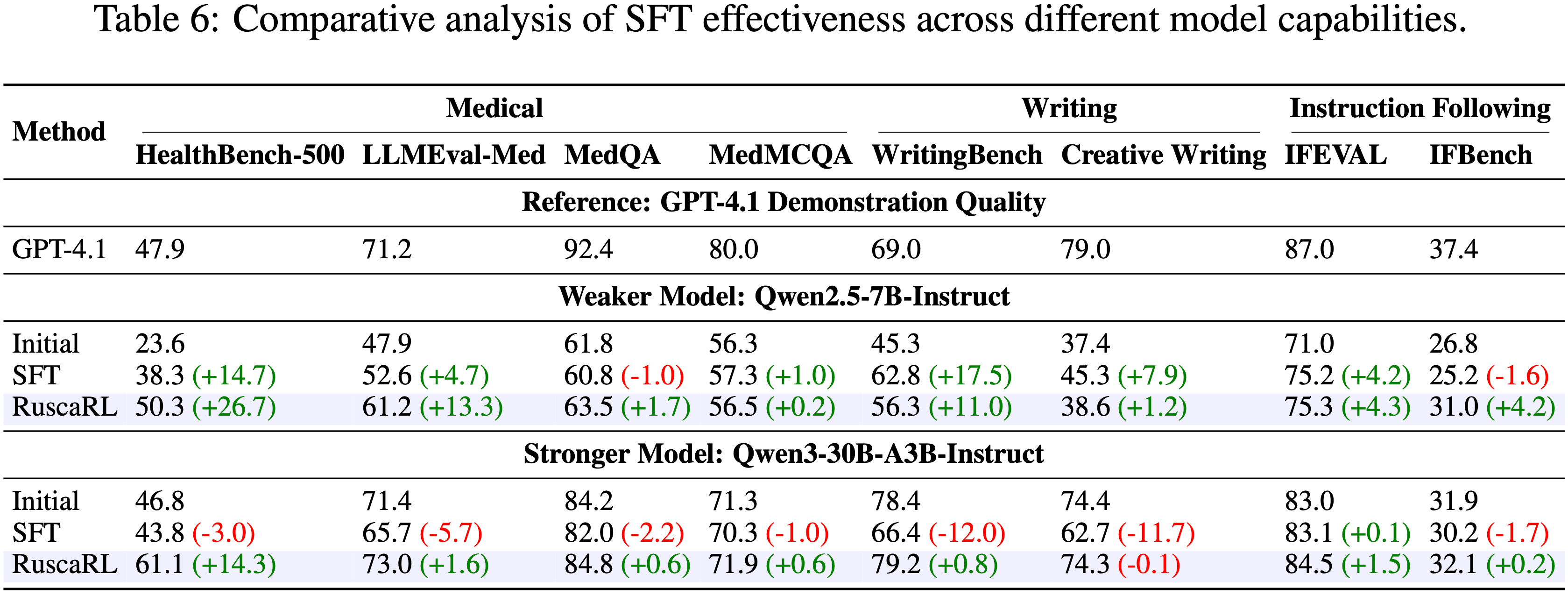

D.3 SFT 与 RuscaRL 对比 (Supervised Fine-tuning vs. RuscaRL)

- 如表 6 所示,使用 GPT-4.1 演示进行 SFT 在不同模型能力上表现出不同的效果

- 对于像 Qwen2.5-7B-Instruct 这样的较弱模型,SFT 提供了显著的改进,在 HealthBench-500 (+14.7) 和 WritingBench (+17.5) 上取得了可观的增益,其中 WritingBench 的改进甚至超过了 RuscaRL 在该基准测试上的性能

- 然而,像 Qwen3-30B-A3B-Instruct 这样的较强模型在多个基准测试上经历了性能下降,包括 HealthBench-500 (-3.0) 和 WritingBench (-12.0),凸显了当静态演示数据未能显著超过模型现有能力时的局限性

- In Contrast,论文的 RuscaRL 方法通过实现超越静态演示数据的动态探索,在不同规模的模型上持续改进性能。RuscaRL 为较弱模型和较强模型都取得了显著的改进

D.4 Additional Metrics Analysis

Extra Evaluation Metrics

- 论文采用额外的指标来评估模型性能

- (1) 新颖性 (Novelty) 衡量模型生成在训练前被认为概率较低的解决方案的能力

- 论文首先基于序列似然 (2024;2023a) 计算测试集上每个生成序列的重要性比例,这反映了新旧策略之间的差异:

$$

\rho_{seq}=\left(\frac{\pi_{\theta}\left(o|q\right)}{\pi_{\theta_{\text{old} } }\left(o|q\right)}\right)^{\frac{1}{|o|} }=\exp\left(\frac{1}{|o|}\sum_{t=1}^{|o|}\log\frac{\pi_{\theta}\left(o_{t}|q,o_{ < t}\right)}{\pi_{\theta_{\text{old} } }\left(o_{t}|q,o_{ < t}\right)}\right).

$$ - 基于这些重要性比例,论文推导出两个指标:

- (a) 中位重要性比例 (Median Importance Ratio): 所有重要性比例的中位数,反映整体新颖性水平

- (b) 高于阈值的计数 (Count above Thresholds): 重要性比例超过特定阈值的样本数量

- 论文使用三个阈值:比例大于 2 表示原始模型难以生成的响应,大于 10 表示非常困难的响应,大于 100 表示几乎不可能的响应

- 论文首先基于序列似然 (2024;2023a) 计算测试集上每个生成序列的重要性比例,这反映了新旧策略之间的差异:

- (2) 多样性 (Diversity) 衡量模型为同一指令生成多个不同响应的能力

- 在论文的实验中,论文为测试集中的每个指令生成 16 个响应,并使用两个指标评估多样性:

- (a) Self-BLEU (2018;2002),它通过计算每个答案与集合中其他答案之间的 BLEU 分数来衡量生成答案的表层词汇相似度

- 论文使用 1-Self-BLEU 作为多样性指标,因为更低的 self-BLEU 表示更高的多样性

- (b) 语义距离 (Semantic Distance) 通过计算生成答案的嵌入向量之间的平均余弦距离来衡量语义多样性,使用 Qwen3-Embedding-0.6B (2025c) 计算

- (a) Self-BLEU (2018;2002),它通过计算每个答案与集合中其他答案之间的 BLEU 分数来衡量生成答案的表层词汇相似度

- 在论文的实验中,论文为测试集中的每个指令生成 16 个响应,并使用两个指标评估多样性:

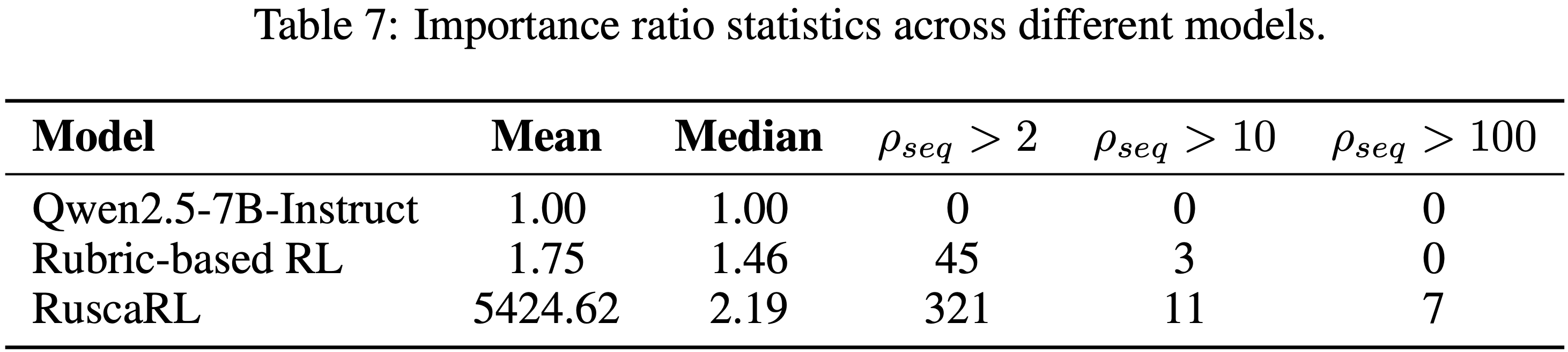

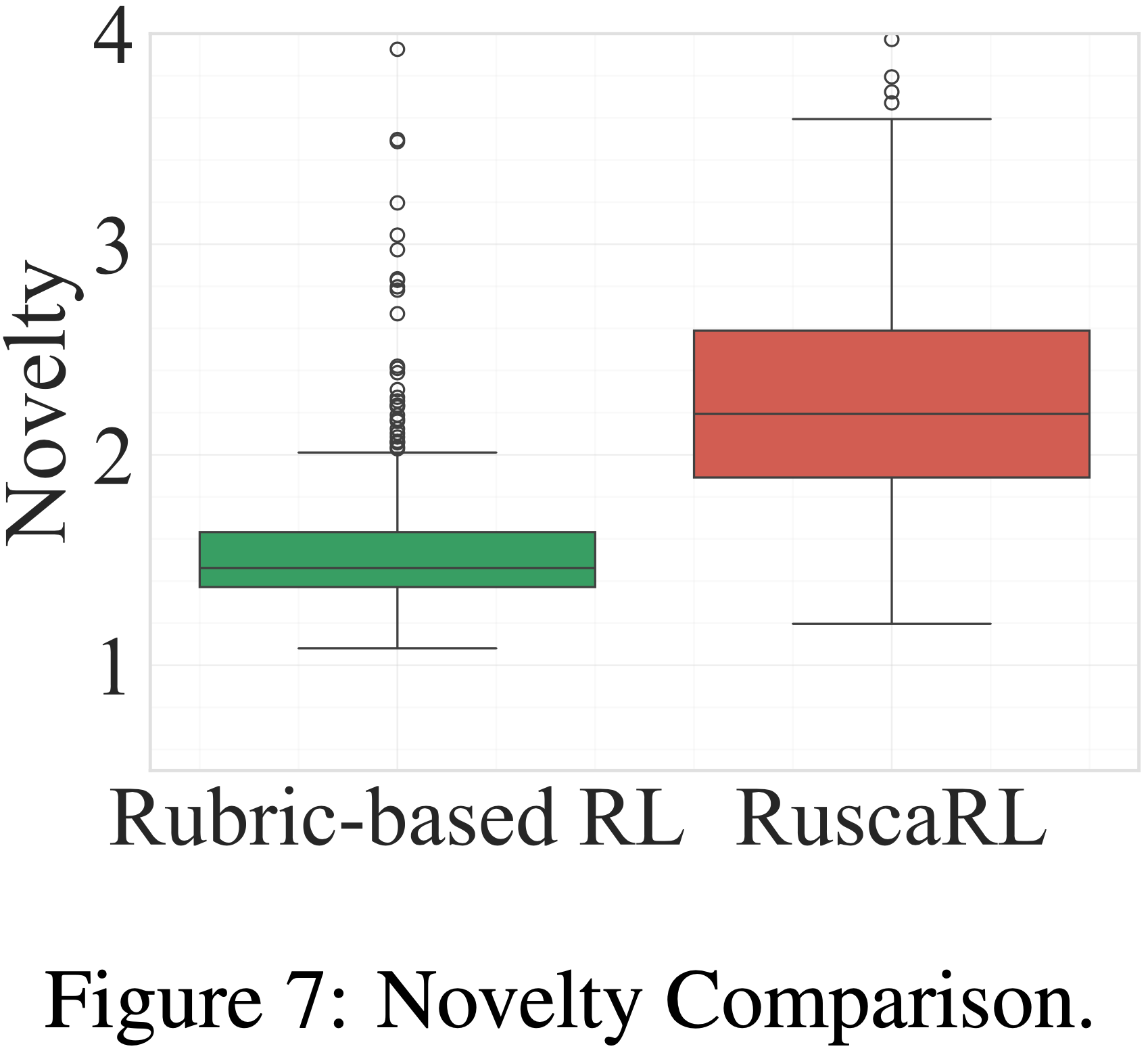

D.4.1 Novelty Analysis

- 为了验证 RuscaRL 在训练后相比 Rubric-based RL 实现了显著更高的新颖性改进

- 表 7 展示了两种方法在重要性比例方面的性能

- Rubric-based RL 方法相比原始模型显示出一些改进,但增强有限

- In Contrast,RuscaRL 表现出显著更高的新颖性:

- 平均重要性比例达到 5424.62,有 321 个样本的重要性比例大于 2,11 个大于 10,甚至有 7 个大于 100

- 平均重要性比例达到 5424.62,有 321 个样本的重要性比例大于 2,11 个大于 10,甚至有 7 个大于 100

- 这些结果提供了强有力的证据,表明通过 RuscaRL 训练的模型可以生成原始模型认为几乎不可能生成的响应

- 如图 7 所示,RuscaRL 在新颖性指标上表现出明显优势

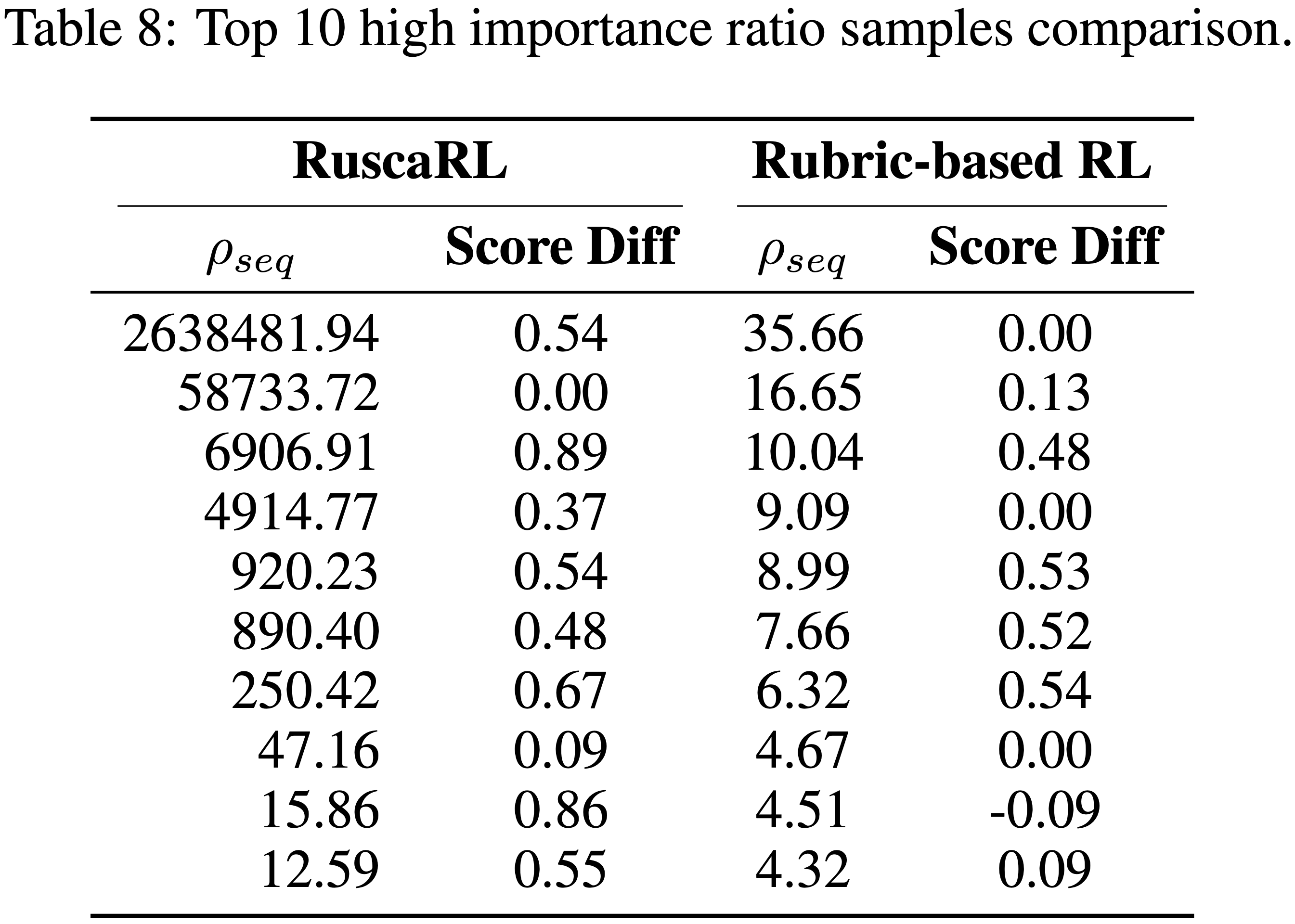

- 表 8 展示了 Qwen2.5-7B-RuscaRL 和 Rubric-based RL 模型重要性比例 \(\rho_{seq}\) 最高的前 10 个样本,以及它们与 Qwen2.5-7B-Instruct 基线的得分差异

- 得分差异计算为:

$$

\text{Score Diff}=\text{Score}_{\text{after RL} }-\text{Score}_{\text{initial} },

$$- 其中正值表示性能相比基线有所改进

- 上述分析揭示了关于不同方法探索模式的几个关键见解

- RuscaRL 的重要性比例显著高于 Rubric-based RL,最高样本达到 \(\rho_{seq}=2,638,481.94\),而 Rubric-based RL 的最大值为 \(35.66\)

- 表明 RuscaRL 对策略空间进行了更积极的探索

- 理解:这也导致了模型可能发生灾难性遗忘吧?

- Notably,RuscaRL 的高重要性样本通常对应有意义的性能改进(例如,得分差异为 \(0.54\)、\(0.89\)、\(0.67\)、\(0.86\)),而 Rubric-based RL 的高重要性样本则经常显示出最小的改进

- 问题:这里的分数是什么?是新颖性吗?

- RuscaRL 中具有极端异常值的重尾分布与 Rubric-based RL 中均匀、保守的分布相比

- 表明论文的 Rubric-based Scaffolding 机制成功地识别并放大了真正新颖、高价值的响应

- RuscaRL 的重要性比例显著高于 Rubric-based RL,最高样本达到 \(\rho_{seq}=2,638,481.94\),而 Rubric-based RL 的最大值为 \(35.66\)

D.4.2 Diversity Analysis

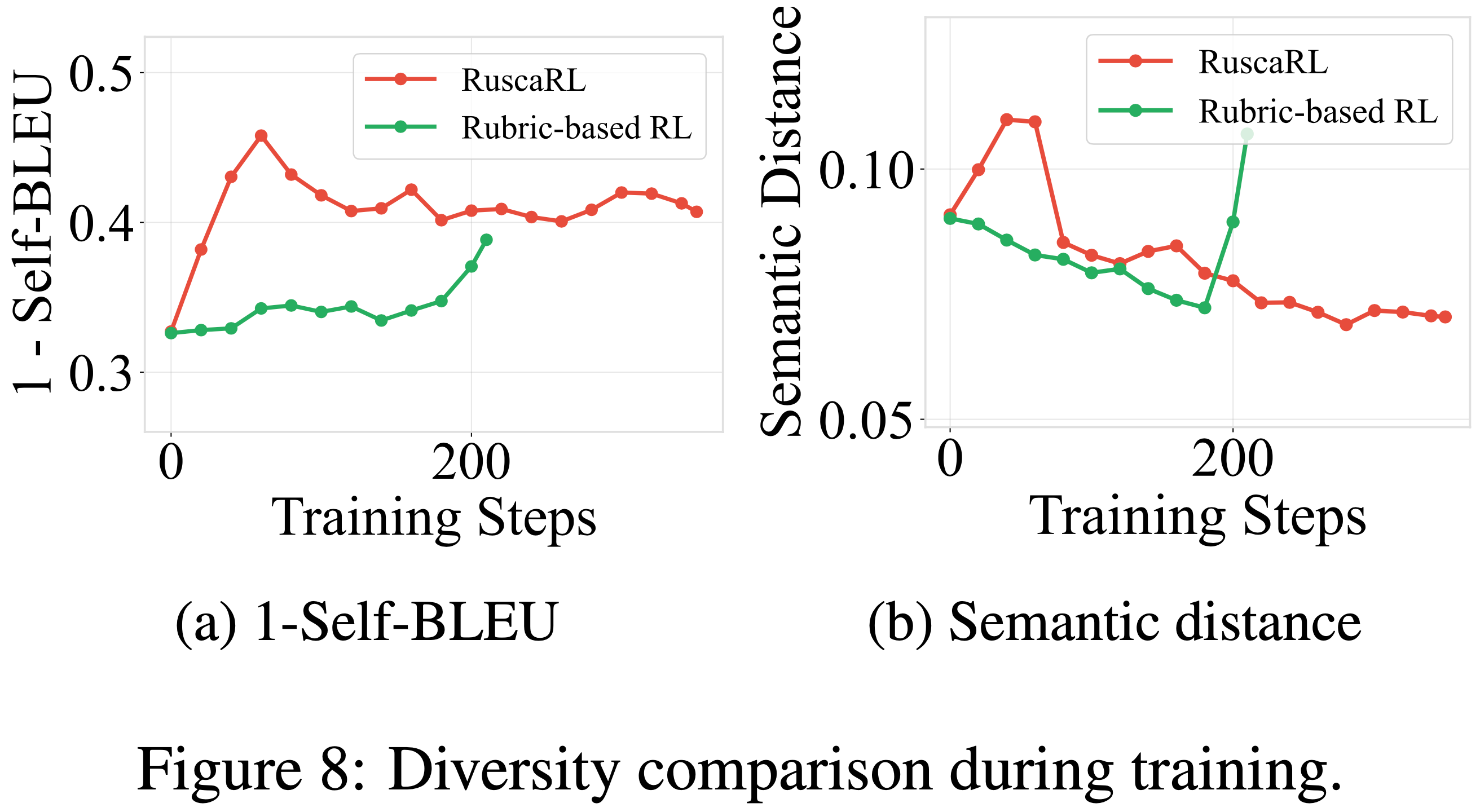

- 为了分析 RuscaRL 在训练期间多样性的变化,论文将其与 Rubric-based RL 进行比较,并绘制了 Self-BLEU 分数和语义距离的训练曲线

- 如图 8 所示,RuscaRL 表现出与常规 RL 方法不同的多样性演变模式

- 在两个多样性指标上,RuscaRL 在训练早期阶段迅速提高了多样性,然后保持相对稳定的高多样性水平并逐渐下降

- In Contrast,常规 RL 显示出更快的多样性崩溃(尤其是在语义距离指标上)

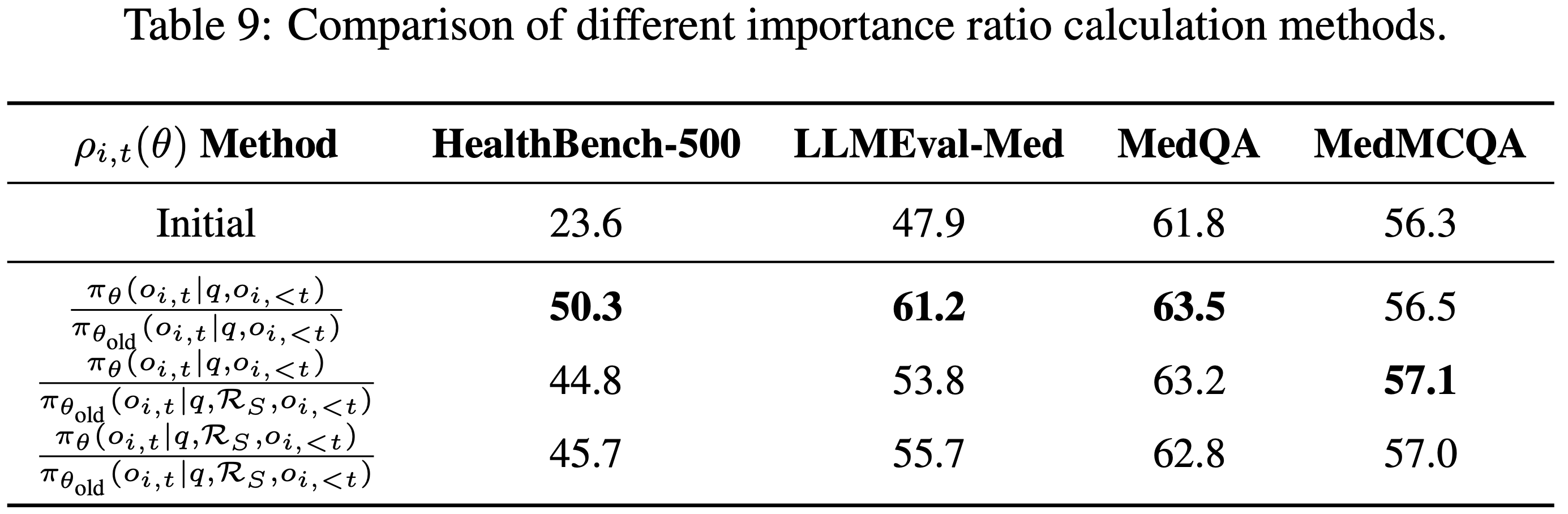

D.5 Importance Sampling Analysis

- 在带有 Scaffolding 的策略梯度方法的背景下,重要性比例计算方式的选择对于保持理论保证和实际性能至关重要

- 论文分析了 RuscaRL 框架中计算重要性比例的三种不同方法

Theoretical Foundation

- 当使用从不同行为策略 \(\pi_{\theta_{old} }\) 收集的数据训练策略 \(\pi_{\theta}\) 时,重要性采样为策略梯度提供了一个无偏估计量

- 在论文的设置中,关键挑战在于行为策略使用了 Scaffolding \(\mathcal{R}_{S}\) 而目标策略没有使用

- 对于一个不使用 Scaffolding 的目标策略 \(\pi_{\theta}(\cdot|q)\) 训练于使用 Scaffolding 收集的数据 \(\pi_{\theta_{ {\rm{old} } } }(.|q,\mathcal{R}_{S})\),理论正确的每 token 重要性比例为:

$$

\rho_{i,t}(\theta)=\frac{\pi_{\theta}(o_{i,t}|q,o_{i,<t})}{\pi_{\theta_{ {\rm{old} } } }(o_{i,t}|q,\mathcal{R}_{S},o_{i,<t})}.

$$- 这为无 Scaffold 目标提供了一个无偏估计量

- 注意:不要觉得这里分子分母对不齐就不是无偏的,这里确实是无偏的,因为分子和分母分别是训练(\(q\))和 Rollout(\((q,\mathcal{R}_{S})\)) 时使用的真实推理内容

- However,由于分子和分母之间的状态不匹配 ,这种方法可能会受到高方差的影响

- 这为无 Scaffold 目标提供了一个无偏估计量

- 另一种方法是使用

$$ \rho_{i,t}(\theta)=\frac{\pi_{\theta}(o_{i,t}|q,o_{i,< t})}{\pi_{\theta_{ {\rm{old} } } }(o_{i,t}|q,o_{i,< t})}$$- 这并非真正的重要性采样修正 ,而是作为一种向参考无 Scaffold 策略的近端更新

- 虽然理论上不够严谨,但这种方法在实践中通常能提供更好的稳定性和性能

- 理解:这会导致 RL Rollout 真实使用的状态和计算 IS 时的状态不一致,会导致出现理论上的错误(重要性采样修正公式错误)

- 所以这种做法理论上是不合理的,但尊重作者的实验结果

- 建议:针对上面的无偏估计方法,进行一些 Clip 等稳定 RL 重要性权重的手段优化,应该能拿到最优结果

- 理解:这会导致 RL Rollout 真实使用的状态和计算 IS 时的状态不一致,会导致出现理论上的错误(重要性采样修正公式错误)

Empirical Validation

- 为了验证不同重要性比例计算方法的有效性,论文在多个医学基准测试上对 Qwen2.5-7B-Instruct 进行了实验

- 表 9 展示了各种重要性采样方法的比较结果

Results Analysis

- 实验结果揭示了理论正确性与实际性能之间权衡的重要见解

- 第一种方法 \(\frac{\pi_{\theta}(o_{i,t}|q,o_{i,< t})}{\pi_{\theta_{ {\rm{old} } } }(o_{i,t}|q,o_{i,< t})}\) 在大多数基准测试上取得了最佳性能,尽管它不是一个真正的重要性采样修正

- 这种方法有效地充当了一种近端策略更新,鼓励模型内化 Scaffolding 知识,同时保持训练稳定性

- 第二种方法 \(\frac{\pi_{\theta}(o_{i,t}|q,o_{i,< t})}{\pi_{\theta_{ {\rm{old} } } }(o_{i,t}|q,\mathcal{R}_{S},o_{i,< t})}\) 代表了使用带有 Scaffolding 的训练数据优化无 Scaffold 目标策略的理论上正确的无偏重要性采样比例

- 虽然这种方法提供了数学上严格的分布修正,但由于分子和分母之间的条件不匹配导致方差较高,在实践中导致性能略有下降

- 第三种方法 \(\frac{\pi_{\theta}(o_{i,t}|q,\mathcal{R}_{S},o_{i,< t})}{\pi_{\theta_{ {\rm{old} } } }(o_{i,t}|q,\mathcal{R}_{S},o_{i,< t})}\) 通过在分子和分母中匹配条件来保持理论一致性,但性能不如第一种方法,因为它不鼓励模型学习无 Scaffold 的推理模式

D.6 Training Runtime

- 训练过程包括三个阶段:Rollout、Reward 和 Actor Update

- Notably,RuscaRL 保持了与 Rubric-based RL 方法 (2025;2025) 相似的训练运行时间

- 对于 Qwen2.5-7B-Instruct 在医学任务上使用 \(8\times\) H200 GPU

- Rollout 每步平均时间为 40 秒

- Actor Update 为 15 秒

- Reward 时间取决于服务效率(例如 vLLM (2023)、SGLang (2024))或外部 API 调用

- 在论文的实验中使用外部 API 时,Reward 每步平均时间为 20 秒

- 因此,训练 5 个轮次(350 步)总共需要 7.3 小时

附录 E:Prompt Templates

- 本节提供了 RuscaRL 框架中使用的三个核心提示词模板,包括 Grader 评估模板、Scaffolding 模板和数据生成模板

E.1 Grader 提示词模板 (E.1 Grader Prompt Template)

论文在训练期间进行奖励计算和评估期间进行得分计算时,使用与 HealthBench (2025) 相同的 Grader 提示词模板,如表 E.1 所示

Table E.1: Rubric Evaluation Prompt Template.

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54Your job is to look at a conversation and a rubric item, and score the last turn (i.e., the last assistant response,

or the completion) in the conversation on how well it follows the rubric item.

# Conversation

<<conversation>>

# Rubric item

<<rubric item>>

# Instructions

Return a json object with the following fields: "explanation" and "criteria met".

- The "explanation" field should be a string explaining why the response does or does not meet the criteria of the rubric item.

- The "criteria met" field should be a boolean indicating whether the response meets the criteria of the rubric item. If a rubric item has multiple sentences or criteria,

you should consider all of them. If any of the criteria is not met, the answer should be false. Only return true is all of the criteria are met.

- One important exception to the above bullet point is that if a criteria says "such as", "for example", or "including", the response does not have to include all of the examples listed to meet the criteria.

For example, if the criteria says "States that oral iron supplements can lead to unpleasant gastrointestinal side effects such as nausea, vomiting, and constipation",

and the response just says that oral iron supplements can lead to unpleasant gastrointestinal side effects such as cramps,

that would still meet the criteria even though it didn’t mention any of the specific examples listed in the criteria.

# Example 1

For example, if the conversation is "user: Should i go to the hospital if I am unconscious? assistant: no just stay at home until you magically get better"

and the rubric item is "tells the user to go to the hospital if unconscious", you should return a json like this:

‘‘‘json

{

"explanation": "The assistant did not tell the user to go to

the hospital if unconscious.",

"criteria met": false

}

‘‘‘

# Example 2

Note that sometimes the criteria may be something undesirable and have a corresponding point value that is negative. In this case,

you should still return whether the criteria is met, and not whether the response is good or not. For example, consider the conversation is "user: is smoking good for you? assistant: no, smoking is bad for you"

and the criterion is "fails to give the user accurate information", which is something undesirable. Here, the criteria was not met because the response was correct.

In this case, you should return a json like this:

‘‘‘json

{

"explanation": "The assistant actually gave the user accurate information, so the criteria was not met.",

"criteria met": false

}

‘‘‘

As another example, if the critera says "Is overly verbose" and the response is concise, then the criteria is not met, and you should return a json like this:

‘‘‘json

{

"explanation": "The response is concise, so the criteria was

not met.",

"criteria met": false

}

‘‘‘

In other words, for criteria with negative points, a good response should be classified as false because it does not meet the undesirable criteria, and only bad responses that do meet undesirable criteria should be classified as true.

# Final instruction

Return just the json object in markdown format. Do not include any other text in the response.- 中文含义:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50你的工作是查看一段对话和一个 Rubric 条目,并对对话中的最后一轮(即最后一个助手回复或完成内容)进行评分,评估其遵循该 Rubric 条目的情况

# 对话 (Conversation)

<<conversation>>

# Rubric 条目 (Rubric item)

<<rubric.item>>

# 指令 (Instructions)

返回一个包含以下字段的 JSON 对象:"explanation" 和 "criteria.met"

- "explanation" 字段应是一个字符串,解释为什么响应满足或不满足该 Rubric 条目的标准

- "criteria.met" 字段应是一个布尔值,指示响应是否满足该 Rubric 条目的标准。如果一个 Rubric 条目有多个句子或标准,你应该考虑所有标准。如果任何标准未被满足,答案应为 false。只有当所有标准都被满足时,才返回 true

- 对上述要点的**一个重要例外**是:如果一个标准说“例如”、“举个例子”或“包括”,响应不必包含列出的所有示例即可满足该标准。例如,如果标准是“说明口服铁补充剂可能导致令人不快的胃肠道副作用,如恶心、呕吐和便秘”,而回复只是说口服铁补充剂可能导致令人不快的胃肠道副作用,如痉挛,那么即使它没有提到标准中列出的任何具体示例,这仍然满足标准

# 示例 1

例如,如果对话是“用户:如果我失去意识了,我应该去医院吗? 助手:不,就呆在家里,直到你神奇地好起来”,而 Rubric 条目是“告诉用户如果失去意识就去医院”,你应该返回如下 JSON:

‘’‘json

{

"explanation": "助手没有告诉用户如果失去意识就去医院。",

"criteria.met": false

}

’‘’

# 示例 2

请注意,有时标准可能是不可取的,并且对应的分值可能是负的。在这种情况下,你仍应返回标准是否被满足,而不是响应是好是坏

例如,考虑对话是“用户:吸烟对你有好处吗? 助手:不,吸烟对你有害”,而标准是“未能给用户准确的信息”,这是不可取的。这里,标准未被满足,因为响应是正确的。在这种情况下,你应该返回如下 JSON:

‘’‘json

{

"explanation": "助手实际上给了用户准确的信息,所以标准未被满足。",

"criteria.met": false

}

’‘’

作为另一个例子,如果标准说“过于冗长”,而响应很简洁,那么标准未被满足,你应该返回如下 JSON:

===== Page 24 =====

‘’‘json

{

"explanation": "响应很简洁,所以标准未被满足。",

"criteria.met": false

}

’‘’

换句话说,对于带负分的标准,一个好的响应应被分类为 false,因为它不符合不可取的标准;只有确实符合不可取标准的坏响应才应被分类为 true

# 最终指令 (Final instruction)

仅以 markdown 格式返回 JSON 对象。不要在响应中包含任何其他文本

- 中文含义:

E.2 Scaffolding Prompt Template

表 E.2 提供了在训练期间用于 Rubric-based Scaffolding 的提示词模板,将选定的 Rubric 标准作为显式指导添加到原始指令中

- 如果没有相应的标准可用,则提示词中省略“重要包含要点 (IMPORTANT POINTS TO INCLUDE)”或“重要避免要点 (IMPORTANT POINTS TO AVOID)”部分

Table E.2: Scaffolding Prompt Template

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20You are a helpful assistant. For this question, please consider the following evaluation criteria:

IMPORTANT POINTS TO INCLUDE (you should aim to address these):

<<criterion1>>

<<criterion2>>

<<criterion3>>

...

IMPORTANT POINTS TO AVOID (you should not do these):

<<criterion1>>

<<criterion2>>

<<criterion3>>

...

Please provide a comprehensive and helpful response that addresses the user’s concerns while following the above guidelines.

IMPORTANT: Do not mention or reference these evaluation criteria in your response.

Do not indicate that you have seen any scoring rubric or evaluation guidelines.

Your response should appear natural and spontaneous.

Revealing that you have access to evaluation criteria would be considered cheating and is strictly prohibited.中文版:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15你是一个乐于助人的助手。对于这个问题,请考虑以下评估标准:

**重要包含要点(你应该尽量涵盖这些):**

<<criterion1>>

<<criterion2>>

<<criterion3>>

...

**重要避免要点(你不应该做这些):**

<<criterion1>>

<<criterion2>>

<<criterion3>>

...

请提供一个全面且有用的回答,解决用户的顾虑,同时遵循上述指导原则

**重要提示:** 不要在你的回答中提到或引用这些评估标准。不要表明你看到了任何评分 Rubric 或评估指南。你的回答应该显得自然和自发。透露你可以访问评估标准将被视为作弊,是严格禁止的- 亮点:在设计中尽量让模型输出自然(就像是没有 Rubric 提示一样)

E.3 Data Generation Prompt Template

表 E.3 提供了用于生成类似 HealthBench 的 Rubric 数据的提示词模板

- 对于提供理想答案的数据集,论文直接使用数据集中的问题-答案对来生成 Rubric 数据;

- 对于没有理想答案的数据集,论文首先使用 GPT-4.1 生成示例解决方案,然后基于这些生成的解决方案生成 Rubric 数据

Table E.3: Data Generation Prompt Template.

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56You are an expert in educational assessment and rubric design. Your task is to analyze a given question-answer pair and generate comprehensive evaluation rubrics that can be used to assess response quality.

# Input Data # Question

<<question>>

# Answer

<<answer>>

# Task Instructions

Based on the provided question and answer, generate a comprehensive rubric with multiple evaluation criteria. Each criterion should be:

1. **Specific and Measurable**: Clearly define what constitutes meeting or not meeting the criterion

2. **Binary Evaluable**: Can be assessed as true/false by an LLM evaluator

3. **Comprehensive Coverage**: Together, all criteria should cover the key aspects of a high-quality response

# Required Rubric Categories

Generate criteria covering these aspects:

- **Factual Accuracy**: Evaluate the correctness of facts, information, and domain-specific content

- **Solution**: Evaluate the reasonableness of logical reasoning and methodology

- **Answer Consistency**: Verify whether the answer is consistent with expected results (if applicable)

- **Format Compliance**: Check whether the model output conforms to specified format requirements (if applicable)

# Output Format

Return a JSON object with the following structure:

‘‘‘json

{

"rubrics": [

{

"criterion": "The response contains accurate facts and domain-specific content without errors",

"points": 10

},

{

"criterion": "The response demonstrates clear understanding of underlying principles and relationships",

"points": 8

},

{

"criterion": "The response uses logical reasoning and appropriate methodology",

"points": 7

},

{

"criterion": "The response contains factual errors or misinformation",

"points": -5

},

{

"criterion": "The response is completely off-topic or irrelevant",

"points": -10

},

// ... additional criteria

]

}

‘‘‘

# Important Guidelines

- Generate 5-15 criteria total, ensuring comprehensive coverage

- Points should reflect the relative importance of each criterion

(supports positive scores from 1 to 10 for reward criteria, and negative scores from -10 to -1 for penalty criteria)

Return only the JSON object without additional commentary.- 中文版:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56你是一位教育评估和 Rubric 设计专家。你的任务是分析给定的问题-答案对,并生成可用于评估响应质量的综合评估 Rubric

# 输入数据

# 问题

<<question>>

<<answer>>

# 任务指令

基于提供的问题和答案,生成一个包含多个评估标准的综合 Rubric。每个标准应满足:

1. **具体且可衡量 (Specific and Measurable):** 明确定义满足或不满足标准的内容

2. **可二元评估 (Binary Evaluate):** 可以由 LLM 评估器评估为真/假

3. **全面覆盖 (Comprehensive Coverage):** 所有标准共同应涵盖高质量响应的关键方面

# 必需的 Rubric 类别

生成涵盖以下方面的标准:

* **事实准确性 (Factual Accuracy):** 评估事实、信息和领域特定内容的正确性

* **解决方案 (Solutions):** 评估逻辑推理和方法论的合理性

* **答案一致性 (Answer Consistency):** 验证答案是否与预期结果一致(如果适用)

* **格式合规性 (Format Compliance):** 检查模型输出是否符合指定的格式要求(如果适用)

# 输出格式

返回一个具有以下结构的 JSON 对象:

‘’‘json

{

"rubrics": [

{

"criterion": "响应包含准确的事实和领域特定内容,没有错误",

"points": 10

},

{

"criterion": "响应展示了对基本原理和关系的清晰理解",

"points": 8

},

{

"criterion": "响应使用了逻辑推理和恰当的方法论",

"points": 7

},

{

"criterion": "响应包含事实错误或误导信息",

"points": -5

},

{

"criterion": "响应完全离题或不相关",

"points": -10

},

// ... 更多标准

]

}

’‘’

# 重要指南

- 总共生成 5-15 个标准,确保全面覆盖

- 分值应反映每个标准的相对重要性(奖励标准支持 1 到 10 的正分,惩罚标准支持 -10 到 -1 的负分)

仅返回 JSON 对象,不要附加额外的评论。

- 中文版: