注:本文包含 AI 辅助创作

- 参考链接:

Paper Summary

- 重点说明:

- 论文首次全面综述了后训练语言模型(Post-training Language Model, PoLM) ,系统追溯了从 2018 年 ChatGPT 的对齐起源到 2025 年 DeepSeek-R1 的推理里程碑的发展轨迹

- 论文评估了广泛的技术(即微调、对齐、推理、效率以及集成与适配)

- 论文的分析强调,后训练语言模型显著提升了大语言模型的能力,从最初的对齐创新发展到复杂的推理框架;

- 揭示了一些持续存在的挑战,包括偏差持久性、计算可扩展性以及依赖上下文的伦理对齐

- LLM 的出现从根本上改变了自然语言处理领域,使其在从对话系统到科学探索等多个领域都变得不可或缺,但 LLMs 的预训练架构在特定场景中往往存在局限性,包括

- 推理能力有限(restricted reasoning capacities)

- 伦理不确定性(ethical uncertainties)

- 特定领域性能欠佳(suboptimal domain-specific performance)

- 这些挑战需要先进的 后训练语言模型(PoLM) 来解决,例如 OpenAI-o1/o3 和 DeepSeek-R1(统称为大型推理模型,Large Reasoning Model, LRM)

- 论文首次对 PoLM 进行了全面综述,系统追溯了其在五个核心范式中的演变:

- 微调(Fine-tuning) ,用于提高特定任务的准确性;

- 对齐(Alignment) ,确保伦理一致性并与人类偏好对齐;

- Reasoning ,在奖励设计面临挑战的情况下推进多步推理;

- 效率(Efficiency) ,在复杂性不断增加的情况下优化资源利用;

- 集成与适配(Integration and Adaptation) ,在解决一致性问题的同时跨多种模态扩展能力

- 从 2018 年 ChatGPT 的基础对齐策略到 2025 年 DeepSeek-R1 在推理方面的创新进展,论文阐述了 PoLM 如何利用数据集来减轻偏见、深化推理能力并增强领域适应性

- 论文的贡献包括:

- 对 PoLM 演变的开创性综合分析

- 对技术和数据集进行分类的结构化分类法

- 强调 LRM 在提高推理能力和领域灵活性方面作用的战略议程

- 作为首个此类范围的综述,论文整合了近期 PoLM 的进展,并为未来研究建立了严谨的理论框架,促进在精度、伦理稳健性和跨科学与社会应用的多功能性方面表现卓越的 LLM 的发展

Introduction and Discussion

- 人们普遍认为,真正的智能赋予论文推理能力、检验假设的能力以及为未来可能发生的事情做准备的能力

It is generally agreed upon that authentic intelligence equips us with reasoning capabilities, enables us to test hypotheses, and prepares for future eventualities. —— Jean Khalfa 《WHAT IS INTELLIGENCE(1994)》

- 语言模型(Language Models, LMs)(2018, 2018)代表了旨在建模和生成人类语言的复杂计算框架

- 这些模型通过使机器能够以接近人类认知的方式理解、生成和与人类语言交互,彻底改变了自然语言处理领域(2011)

- 与通过与环境互动和接触语境自然习得语言技能的人类不同,机器必须经过广泛的、数据驱动的训练才能发展出类似的能力(2025)

- 这带来了重大的研究挑战,因为要使机器理解和生成人类语言,同时进行自然的、符合语境的对话,不仅需要大量的计算资源,还需要完善的模型开发方法(2024, 2023)

- 以 GPT-3(2020)、InstructGPT(2023)和 GPT-4(2023)为代表的 LLMs 的出现,标志着语言模型进化的一个变革性阶段

- 这些模型以其庞大的参数规模和先进的学习能力为特点,旨在捕捉海量数据集中的复杂语言结构、语境关系和细微模式

- 这使大语言模型不仅能够预测后续词语,还能在包括翻译、问答和摘要在内的广泛任务中生成连贯的、与语境相关的文本

- 大语言模型的发展引发了极大的学术兴趣(2024, 2023),其发展可分为两个主要阶段:预训练和后训练

- 预训练 :预训练的概念源于计算机视觉(Computer Vision, CV)任务中的迁移学习(2023)

- 其主要目标是利用大量数据集开发一个通用模型,以便轻松微调用于各种下游应用

- 预训练的一个显著优势是它能够利用任何未标记的文本语料库,从而提供丰富的训练数据源

- 然而,早期的静态预训练方法,如神经网络语言模型(Neural Network Language Models, NNLM)(2000)和Word2vec(2013),难以适应不同的文本语义环境,这促使了像 BERT(2018)和 XLNet(2019)这样的动态预训练技术的发展

- BERT 通过利用 Transformer 架构和在大规模未标记数据集上采用自注意力机制,有效解决了静态方法的局限性

- BERT 确立了“预训练和微调”的学习范式,启发了众多后续研究,这些研究引入了多种架构,包括 GPT-2(2019)和 BART(2019)

- 后训练 :后训练指的是在模型经过预训练后采用的技术和方法,旨在完善模型,使其适应特定任务或用户需求

- 随着拥有 175B 参数的 GPT-3(2020)的发布,后训练领域的兴趣和创新显著激增

- 各种旨在提高模型性能的方法应运而生,包括:

- 微调(2020, 2021):利用标记数据集或特定任务数据调整模型参数;

- 对齐策略(2022, 2022, 2023):优化模型以更好地符合用户偏好;

- 知识适应技术(2022, 2021):使模型能够整合特定领域的知识;

- 推理改进(2024, 2024):增强模型进行逻辑推理和决策的能力

- 以上这些技术统称为后训练语言模型(Post-training Language Models, PoLMs),促成了GPT-4(2023)、LLaMA-3(2024)、Gemini-2.0(2025)和 Claude-3.5(2024)等模型的开发,标志着大语言模型能力的显著进步

- 然而,后训练模型通常难以在不重新训练或大幅调整参数的情况下适应新任务 ,这使得后训练模型的开发成为一个活跃的研究领域

- 如前所述,预训练语言模型(Pre-trained Language Models, PLMs)主要旨在提供通用知识和能力,而后训练语言模型则专注于使这些模型适应特定任务和需求

- 最新的大语言模型 DeepSeek-R1(2025)就是这种适应的一个显著例子,它展示了后训练语言模型在增强推理能力、符合用户偏好以及提高跨领域适应性方面的进化(2024)

- 此外,开源大语言模型(如 LLaMA(2023)、Gemma(2024)和 Nemotron(2024))和特定领域的大型数据集(如 PromptSource(2022)和 Flan(2023))的日益普及,正促使学术研究人员和行业从业者开发后训练语言模型

- 这一趋势凸显了人们越来越认同后训练语言模型领域中定制化适应的重要性

- 在现有文献中,预训练语言模型已被广泛讨论和综述(2023, 2023, 2023, 2020),而后训练语言模型却很少被系统地综述

- 为了推进这些技术,有必要彻底审视现有研究,以确定关键挑战、差距和进一步完善的机会

- 本综述旨在通过为不断发展的后训练研究提供一个结构化框架来填补这一空白

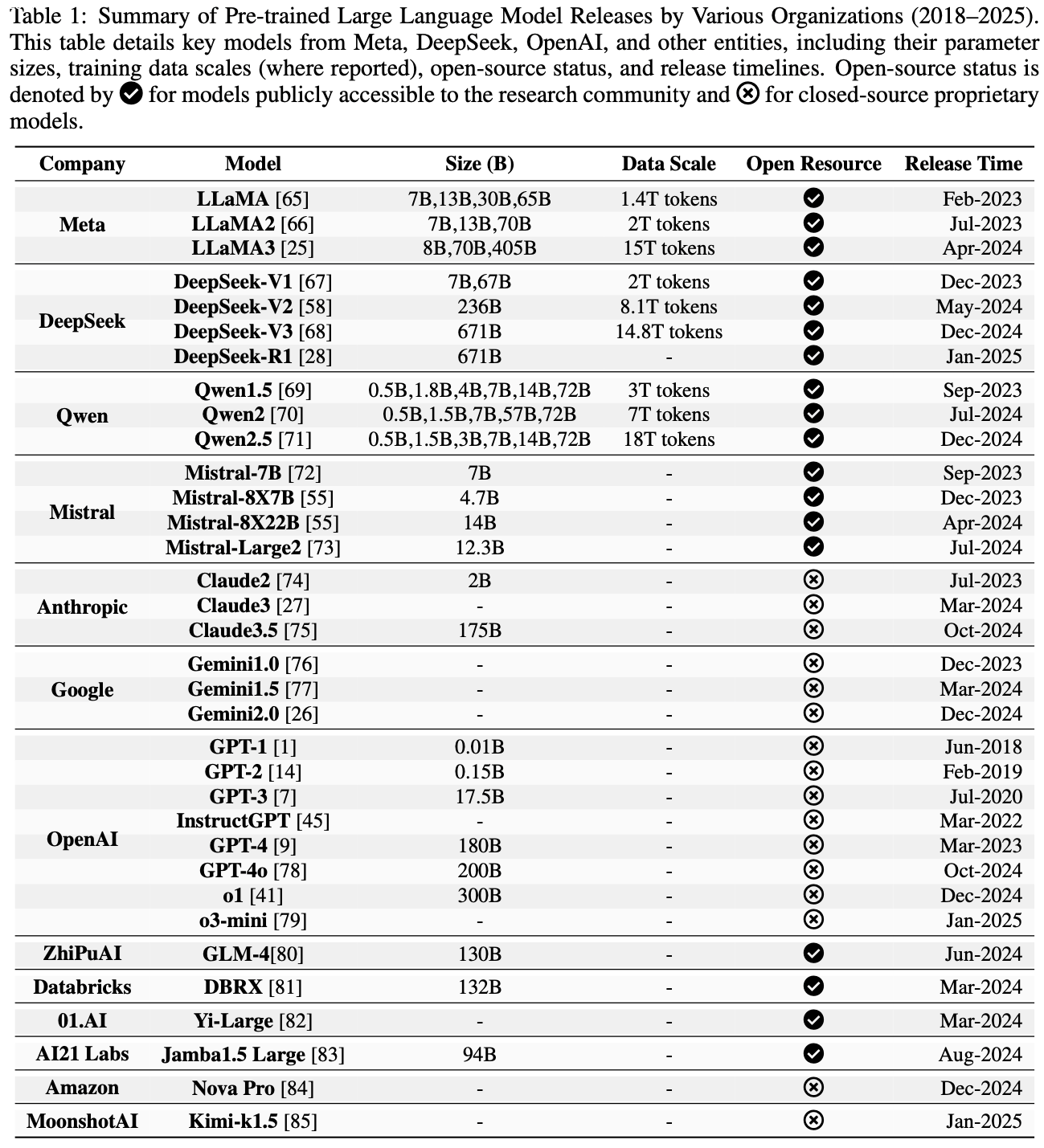

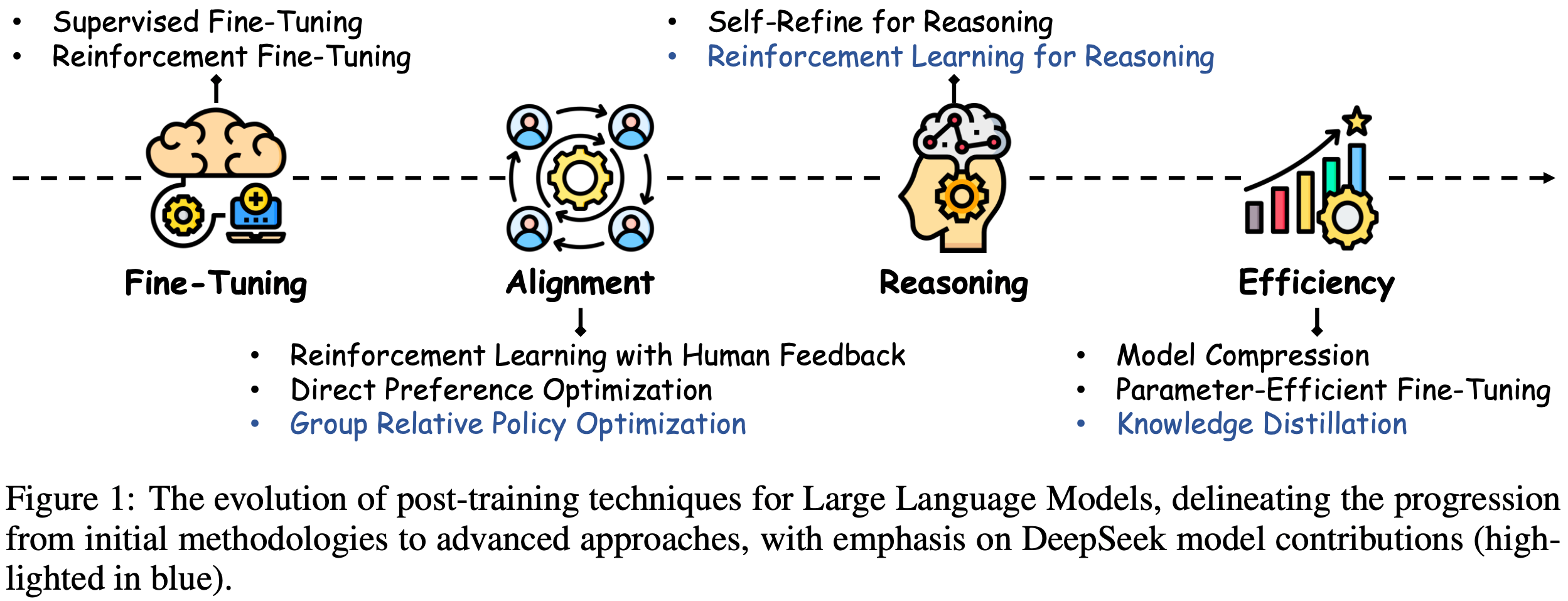

- 如图1所示,它探讨了后训练的多个阶段,特别关注从 ChatGPT 到 DeepSeek 所采用的阶段

- 这些技术涵盖了广泛的方法,包括微调、大语言模型对齐、推理增强和效率改进

- 图中的蓝色部分专门突出了 DeepSeek 所应用的后训练方法集,强调了有助于其在适应用户偏好和特定领域需求方面取得成功的创新策略

Major Contributions

- 论文是第一篇关于后训练语言模型的全面综述,对该领域的最新进展进行了彻底、结构化的探索

- 以前的综述通常集中在大语言模型开发的特定方面,如偏好对齐(2024)、参数高效微调(2024)和大语言模型的基础技术(2025),但它们主要集中在狭窄的子主题上

- 相比之下,本综述采用整体方法,全面回顾了后训练中常用的核心技术,并对其进行了系统分类

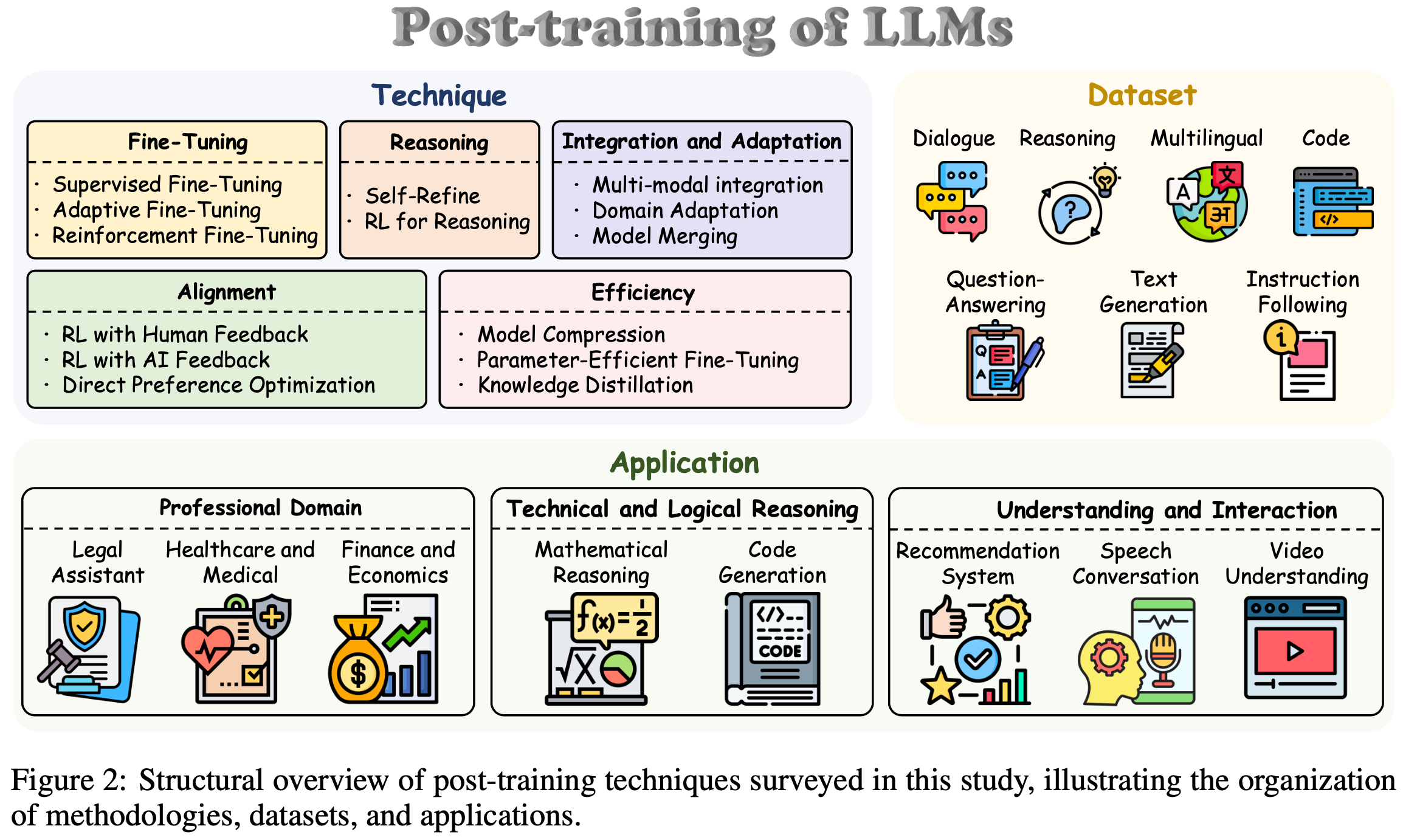

- 此外,论文研究了对这些方法至关重要的数据集和实际应用,如图2所示,并确定了开放挑战和未来研究的有前景的方向

- 本综述的主要贡献如下:

- 全面的历史综合(Comprehensive Historical Synthesis) :论文首次深入综合了后训练语言模型,追溯了它们从 ChatGPT 最初的 RLHF 到 DeepSeek-R1 创新的冷启动强化学习方法的演变

- 这种综合涵盖了关键技术(即微调、对齐、推理、效率以及整合与适应),分析了它们的发展和相关挑战,如计算复杂性和伦理考虑

- 通过将这一进展作为一个连贯的叙述呈现,并辅以必要的参考文献,论文为研究人员提供了近年来后训练演变的全面概述,作为该领域的基础资源

- 结构化分类法和框架(Structured Taxonomy and Framework) :论文引入了一个结构化分类法(如图2所示),将后训练方法分为五个不同类别,并将数据集组织为七种类型,同时将应用划分为专业、技术和交互领域

- 该框架阐明了这些方法的相互关系和实际意义,提供了对其发展的系统视角

- 通过提供明确定义的类别和分析见解,论文提高了新手和专家的可访问性和理解度,建立了一个全面的指南,用于驾驭后训练研究的复杂性

- 未来方向(Future Directions) :论文强调了新兴趋势,特别是大型推理模型(Large Reasoning Models, LRMs)的兴起,如 o1(2024)和 DeepSeek-R1(2025),它们利用大规模强化学习突破推理的界限

- 论文强调,持续进步对于进一步提高推理能力和领域适应性至关重要

- 论文的分析确定了关键挑战,包括可扩展性限制、伦理对齐风险和多模态整合障碍

- 论文提出了研究途径,如自适应强化学习框架和公平感知优化

- 这些方向旨在推动后训练向前发展,确保大语言模型在精度、可信度方面达到更高水平,以满足未来的需求

- 全面的历史综合(Comprehensive Historical Synthesis) :论文首次深入综合了后训练语言模型,追溯了它们从 ChatGPT 最初的 RLHF 到 DeepSeek-R1 创新的冷启动强化学习方法的演变

Organization

- 本综述被系统地组织起来,以全面探讨后训练语言模型,涵盖其历史演变、方法、数据集、应用和未来轨迹

- 第2节提供了后训练语言模型的历史概述

- 第3节研究微调,包括

- 3.1节中的 SFT

- 3.3节中的强化微调(Reinforcement Fine-Tuning, RFT)

- 第4节讨论对齐,包括

- 4.1节中的 RLHF

- 4.2节中的 RLAIF(Reinforcement Learning from AI Feedback, RLAIF)

- 4.3节中的直接偏好优化

- 第5节关注推理,包括

- 5.1节中的 Self-Refine 方法

- 5.2节中的用于推理的强化学习

- 第6节综述提高效率的方法,包括

- 6.1节中的模型压缩

- 6.2节中的参数高效微调(Parameter-Efficient Fine-Tuning, PEFT)

- 6.3节中的知识蒸馏

- 第7节研究整合与适应,探讨多模态方法、领域适应和模型合并

- 第8节回顾后训练中使用的数据集

- 第9节探讨大语言模型的应用

- 第10节评估开放问题和未来方向

- 第11节以总结和研究展望结束

Overview

History of PoLMs

- LLM 的发展是 NLP 领域的关键篇章,而后训练方法则是推动其从通用预训练架构向专门化、任务自适应系统演进的重要催化剂

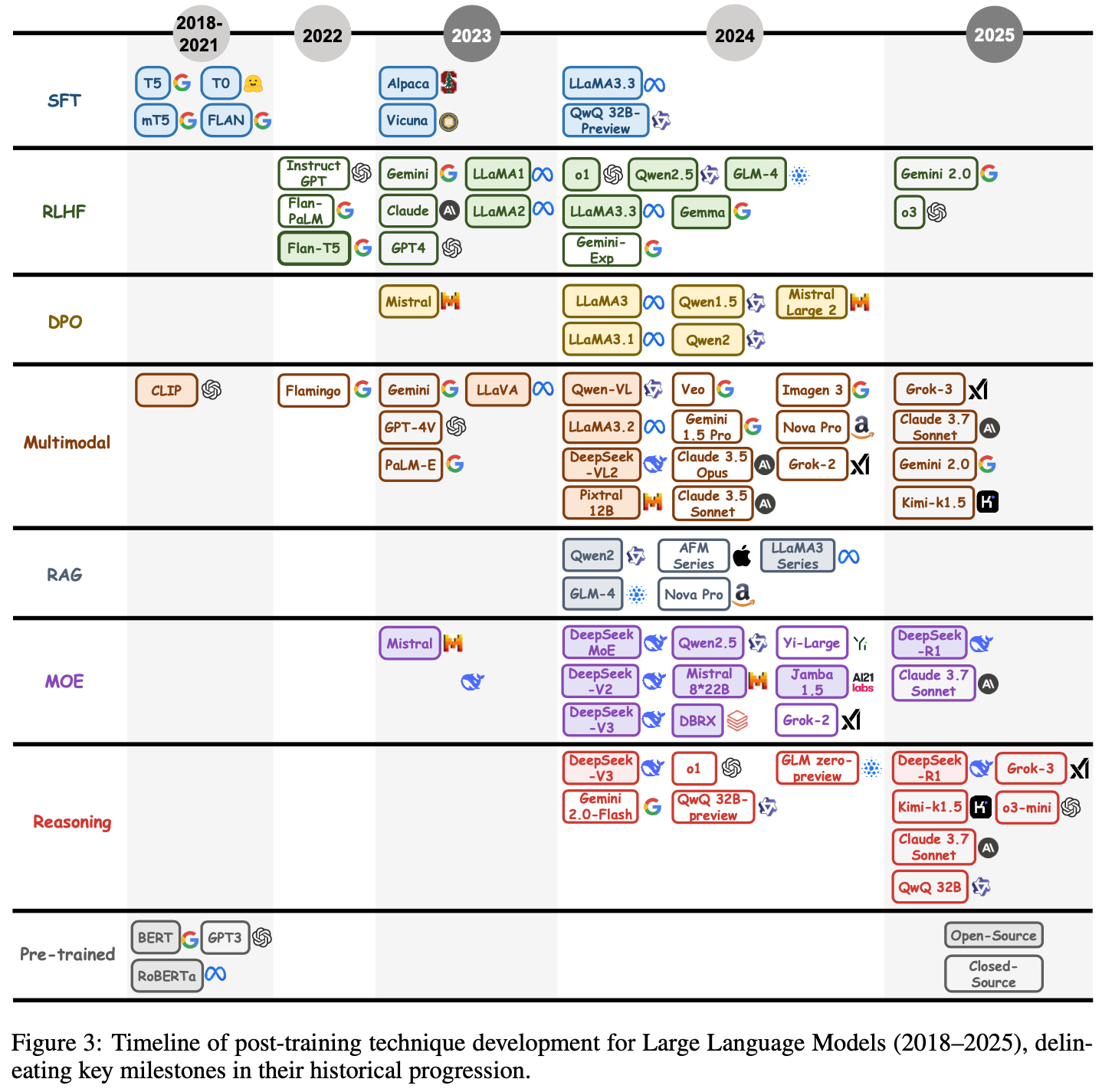

- 本节将阐述后训练语言模型(Post-training Language Models, PoLMs)的历史轨迹,追溯其从以 BERT(2018)和 GPT(2018)为代表的预训练里程碑,到以当代模型(如 o1(2024)和 DeepSeek-R1(2025))为体现的复杂后训练范式的发展过程

- 如图3所示,这一进程反映了从建立广泛语言能力到增强任务特定适应性、伦理对齐、推理复杂性和多模态整合的转变,标志着大语言模型能力的变革之旅

- 现代后训练语言模型历史的开端与 2018年 的预训练革命相契合,以 BERT(2018)和 GPT(2018)的发布为标志,它们重新定义了自然语言处理的基准

- BERT 的双向自编码框架利用 Transformer 架构和自注意力机制,在问答等任务中出色地捕捉了上下文相互依赖关系

- GPT 的自回归设计则优先考虑生成连贯性,为文本生成树立了先例

- BERT 和 GPT 模型确立了“预训练和微调”范式,随后在 2019年 通过 T5(2019)得到改进,T5 将各种任务统一在文本到文本框架下,促进了多任务学习,并为后训练进展奠定了坚实基础

- 2020年起,后训练语言模型的格局开始发生重大演变,这是因为人们越来越需要使预训练模型能够凭借有限的数据高效适应各种任务

- 早期创新(如 Prefix-Tuning(2021)和 Prompt-Tuning(2021))引入了轻量级适应策略,通过修改模型输入而非重新训练整个架构,实现了多任务灵活性,从而节省了计算资源并扩大了适用性

- 这一时期还出现了向以用户为中心的优化的关键转变 ,2021年 RLHF(Reinforcement Learning from Human Feedback, RLHF)(2022)问世,该技术利用人类评估使模型输出与主观偏好保持一致,提高了对话场景中的实际效用

- 到 2022年 ,RLHF 随着 PPO(2017)的采用而成熟,改进了对齐稳定性并减轻了对噪声反馈的过拟合

- 2022年末 ,ChatGPT(2023)的发布集中体现了这些进步,展示了 RLHF 在创建响应迅速、与用户对齐的大语言模型方面的变革潜力,并推动了后训练语言模型研究的激增

- 同时, CoT 提示(2022)作为一种推理增强策略出现,鼓励模型在复杂任务中阐明中间步骤,从而提高了逻辑推理和问题解决领域的透明度和准确性

- 2022年 至 2024年 间,后训练语言模型(PoLMs)向解决领域特异性(domain specificity)、伦理稳健性(ethical robustness)和多模态整合(multi-modal integration)等方向多元化发展,反映出对大语言模型优化的日益细致的方法

- 领域适应技术(如检索增强生成(Retrieval-Augmented Generation, RAG)(2020))应运而生,用于整合外部知识库,无需完全重新训练就能为专业领域提供富含上下文的输出,这对于需要最新信息的专业应用而言是一项关键进步

- 伦理对齐方面的努力也在加强,2023年 直接偏好优化(Direct Preference Optimization, DPO)(2024)通过直接根据人类偏好优化模型输出来简化 RLHF,绕过了中间奖励建模,以提高效率和稳健性

- 同时,对多模态能力的追求也获得了关注,像 PaLM-E(2023)和 Flamingo(2022)等模型开创了视觉-语言整合,随后 BLIP-2(2023)和 LLaVA(2023)将这些努力扩展到医学成像等更广泛的领域

- 效率创新与这些发展并行,特别是通过 MoE 架构实现;

- 谷歌 2022年 的 Switch-C Transformer(2022)引入了 1.6T 参数的稀疏激活,分布在 2048 个专家中,而 Mixtral(2024)完善了这一范式,平衡了可扩展性和性能

- 这一时期的推理增强(如自我对弈(Self-play)(2024)和结合思维链的蒙特卡洛树搜索(Monte Carlo Tree Search, MCTS)(2021))通过模拟迭代推理路径进一步增强了大语言模型的决策能力,为以推理为重点的高级模型奠定了基础

- 随着混合专家模型的兴起,一项重大的架构进步出现了,与传统的密集架构不同,混合专家模型通过动态激活选择性参数子集,在优化计算效率的同时适应了庞大的参数规模

- 这一范式由谷歌 2022年 的 Switch-C Transformer(2022)开创,其特点是 1.6T 参数分布在 2048 个专家中,这种开创性方法平衡了资源需求和性能提升

- 后续版本(如 Mixtral(2024)和 DeepSeek V2.5(2024),其中 DeepSeek V2.5 利用 236B 总参数(160 个专家,激活参数 21B))进一步完善了这一框架,在 LMSYS 基准测试中取得了 SOTA 结果,并证明了稀疏混合专家架构在可扩展性和功效方面都能与密集模型相媲美

- 注:LMSYS,即 LmArena,是一个 LLM 排行榜基准

- 这些发展强调了向注重效率的后训练语言模型的转变,使大语言模型能够以更低的计算开销处理复杂任务,这是扩大其实用性的关键一步

- 到 2025年 ,DeepSeek-R1(2025)成为后训练语言模型创新的里程碑,它摆脱了对传统 SFT 的依赖,采用思维链推理和探索性强化学习策略

- 以 DeepSeek-R1-Zero 为代表,该模型整合了自我验证、反思和扩展的思维链生成,在开放研究范式中验证了强化学习驱动的推理激励,并引入了蒸馏技术(distillation techniques,2025),将复杂的推理模式从更大的架构转移到更小的架构

- 这些技术不仅相对单独的强化学习训练产生了更优异的性能,还预示了一种可扩展的、以推理为中心的大语言模型范式,有望解决后训练方法中计算效率和任务适应性的长期挑战

Formula Foundations of PoLMs

Principle of Policy Optimization

- PPO 算法(2017)是一种关键的强化学习技术,在 RLHF(2022)等场景中特别有用,在这些场景中,保持稳定性和效率至关重要

- PPO 通过限制策略更新的大小来实现这些目标,确保模型行为的变化是渐进和可控的,从而防止性能出现灾难性的变化

- 这在微调大规模语言模型时尤为重要,因为剧烈的策略更新可能导致不良或不可预测的行为

- 定义(Definition) :在 PPO 的背景下,状态 \(s_{t} \in S\) 表示时间 \(t\) 的环境,包括模型做出决策所需的所有相关信息

- 动作 \(a_{t} \in A(s_{t})\) 表示模型在状态 \(s_{t}\) 下做出的选择

- 这个动作是模型所做的一系列决策的一部分

- 执行动作后,智能体会收到奖励 \(r_{t} \in \mathbb{R}\),作为来自环境的反馈,表明所采取动作的成功或失败

- 优势函数 \(A^{\pi}(s, a)\) 衡量在当前策略 \(\pi\) 下,在状态 \(s\) 中采取动作 \(a\) 相对于该状态下动作的预期值的优势

- 它正式定义为动作值函数 \(Q^{\pi}(s, a)\) 和状态值函数 \(V^{\pi}(s)\) 之间的差异,定义如下:

$$A^{\pi}(s, a)=Q^{\pi}(s, a)-V^{\pi}(s) \tag{1}$$- 其中 \(Q^{\pi}(s, a)\) 表示在状态 \(s\) 中采取动作 \(a\) 并遵循策略 \(\pi\) 所获得的预期累积奖励,\(V^{\pi}(s)\) 是从状态 \(s\) 开始并遵循策略 \(\pi\) 的预期累积奖励

- 这两个函数都考虑了未来的奖励,并通过因子 \(\gamma\) 进行贴现(discounted by \(\gamma\))

- 动作 \(a_{t} \in A(s_{t})\) 表示模型在状态 \(s_{t}\) 下做出的选择

- 策略更新(Policy Update) :PPO 算法基于优势函数进行增量更新,从而优化策略 \(\pi_{\theta}\),策略更新使用剪辑目标函数执行:

$$L^{CLIP}(\theta)=\hat{\mathbb{E} }_{t}\left[\min \left(r_{t}(\theta) \hat{A}_{t}, \operatorname{clip}\left(r_{t}(\theta), 1-\epsilon, 1+\epsilon\right) \hat{A}_{t}\right)\right]$$- 其中 \(r_{t}(\theta)\) 表示在当前策略 \(\pi_{\theta}\) 下采取动作 \(a_{t}\) 的概率与在旧策略 \(\pi_{\theta_{\text {old } } }\) 下的概率之比。该比率定义为:

$$r_{t}(\theta)=\frac{\pi_{\theta}\left(a_{t} | s_{t}\right)}{\pi_{\theta_{\text {old } } }\left(a_{t} | s_{t}\right)}$$- \(\hat{A}_{t}\) 是时间步 \(t\) 的估计优势,剪辑函数 \(\operatorname{clip}\left(r_{t}(\theta), 1-\epsilon, 1+\epsilon\right)\) 将策略更新限制在由超参数 \(\epsilon\) 控制的安全范围内

- 这种剪辑机制确保更新不会与先前的策略偏离太多,从而在训练期间保持稳定性

- 其中 \(r_{t}(\theta)\) 表示在当前策略 \(\pi_{\theta}\) 下采取动作 \(a_{t}\) 的概率与在旧策略 \(\pi_{\theta_{\text {old } } }\) 下的概率之比。该比率定义为:

- 值函数更新 :值函数 \(V_{\phi}\) 估计在策略 \(\pi_{\theta}\) 下,从给定状态 \(s_{t}\) 获得的预期累积奖励

- 为了确保值函数提供准确的估计,通过最小化预测值与实际奖励之间的均方误差来优化它:

$$\phi_{k+1}=\arg \min_{\phi} \mathbb{E}_{s_{t} \sim \pi_{\theta_{k} } }\left[\left(V_{\phi}\left(s_{t}\right)-R\left(s_{t}\right)\right)^{2}\right]$$- 其中 \(R(s_{t})\) 是从状态 \(s_{t}\) 获得的实际累积奖励,\(V_{\phi}(s_{t})\) 是在当前策略下的估计值

- 目标是调整参数 \(\phi\),以最小化预测奖励和实际奖励之间的差异,提高值函数的准确性

- 为了确保值函数提供准确的估计,通过最小化预测值与实际奖励之间的均方误差来优化它:

Principle of RLHF

- RLHF 是一种通过在学习过程中利用人类生成的反馈使模型与人类偏好保持一致的关键方法

- 这种方法包含一个明确捕捉人类输入的奖励函数,使模型能够更好地适应用户偏好和实际应用

- 定义 :在 RLHF 中,语言模型 \(\rho\) 生成词汇表 \(\sum\) 中标记序列的概率分布

- 模型 \(\rho\) 从输入空间 \(X=\sum^{\leq m}\) 生成标记序列 \(x_{0}, x_{1}, …, x_{n-1}\),其中每个标记都条件依赖于先前的标记

- 模型的输出由以下条件概率分布定义:

$$\rho\left(x_{0} \cdots x_{n-1}\right)=\prod_{0 \leq k<n} \rho\left(x_{k} | x_{0} \cdots x_{k-1}\right)$$ - 模型 \(P\) 在由输入空间 \(X\) 、 \(X\) 上的数据分布 \(D\) 和输出空间 \(Y=\sum^{\leq n}\) 定义的任务上进行训练

- 例如,在文本摘要中,如(2020)所示,GPT-2模型(2019)使用 RLHF 进行训练,其中任务涉及基于CNN/DailyMail(2015)和TL;DR(2017)等数据集预测文本摘要

- 目标函数 :策略 \(\pi\) 是一个与原始模型 \(\rho\) 结构相同的语言模型

- 最初,策略 \(\pi\) 被设置为等于 \(\rho\),目标是通过优化策略来最大化输入-输出对 \((x, y)\) 的预期奖励 \(R(x, y)\)

- 奖励函数 \(R(x, y): X \times Y \to \mathbb{R}\) 为每个输入-输出对分配一个标量值,通过解决以下最大化问题获得最优策略 \(\pi^{*}\) :

$$\pi^{*}=\max_{\pi} \mathbb{E}[R]= \max_{\pi} \mathbb{E}_{x \sim \mathcal{D}, y \sim \pi(\cdot | x)}[R(x, y)]$$ - 这个目标函数代表了一个标准的强化学习问题,其中模型通过在环境中的交互学习最大化预期奖励,并以人类反馈为指导

Principle of DPO

- 直接偏好优化(Direct Preference Optimization, DPO)在 RLHF 的基础上,直接根据人类偏好(通常以成对比较的形式表达)优化模型的输出

- 直接偏好优化消除了对传统奖励函数的需求,而是专注于通过最大化基于偏好的奖励来优化模型行为

- 目标函数(Objective Function) :论文从与先前方法(2019, 2023, 2020)相同的强化学习目标开始,采用通用奖励函数 \(r^{*}\) 。KL约束奖励最大化目标的最优解由下式给出:

$$\pi_{r}(y | x)=\frac{1}{Z(x)} \pi_{\text {ref } }(y | x) \exp \left(\frac{1}{\beta} r(x, y)\right)$$- 其中 \(Z(x)\) 是确保输出在所有可能动作上归一化的配分函数

- 即使利用真实奖励 \(r^{*}\) 的最大似然估计 \(r_{\phi}\),也可以近似配分函数 \(Z(x)\),从而简化优化过程

- 这种表述通过直接根据人类反馈调整策略,实现了更高效的偏好优

- 偏好模型(Preference Model) :使用 Bradley-Terry model(1952),该模型对两个输出 \(y_{1}\) 和 \(y_{2}\) 之间的偏好进行建模,最优策略 \(\pi^{*}\) 满足以下偏好模型:

$$p^{*}\left(y_{1} \succ y_{2} | x\right)=\frac{1}{1+\exp \left(\beta \log \frac{\pi^{*}\left(y_{2} | x\right)}{\pi_{\text {ref } }\left(y_{2} | x\right)}-\beta \log \frac{\pi^{*}\left(y_{1} | x\right)}{\pi_{\text {ref } }\left(y_{1} | x\right)}\right)}$$- 其中 \(p^{*}(y_{1} \succ y_{2} | x)\) 表示在给定输入 \(x\) 的情况下,人类偏好输出 \(y_{1}\) 胜过 \(y_{2}\) 的概率

- 这种方法有效地将人类偏好纳入模型的优化过程

Principle of GRPO

- GRPO 算法是强化学习中 PPO 算法的一种变体,最早在DeepSeek之前的工作《DeepSeekMath: Pushing the Limits of Mathematical Reasoning in Open Language Models》(2024)中提出

- 组相对策略优化省略了评论家模型,而是使用组分数估计基线,与 PPO 相比显著减少了训练资源消耗

- 定义 :组相对策略优化和 PPO 算法之间最显著的区别在于优势函数的计算方法

- 从 2.2.1节 的式(1)中可以看出,PPO 中的优势函数 \(A^{\pi}(s, a)\) 的值源于 Q值 和 V值 之间的差异

- 目标函数 :具体而言,对于每个问题 \(q\),组相对策略优化从旧策略 \(\pi_{\theta_{\text {old } } }\) 中采样一组输出 \(\left\{o_{1}, o_{2}, \ldots, o_{G}\right\}\),然后通过最大化以下目标来优化策略模型:

$$\begin{aligned} \mathcal{J}_{G R P O}(\theta) & =\mathbb{E}\left[q \sim P(Q),\left\{o_{i}\right\}_{i=1}^{G} \sim \pi_{\theta_{oid } }(O | q)\right] \\ & \frac{1}{G} \sum_{i=1}^{G} \frac{1}{\left|o_{i}\right|} \sum_{t=1}^{\left|o_{i}\right|}\left\{ m i n \left[\frac{\pi_{\theta}\left(o_{i, t} | q, o_{i,<t}\right)}{\pi_{\theta_{old } }\left(o_{i, t} | q, o_{i,<t}\right)} \hat{A}_{i, t}, clip\left(\frac{\pi_{\theta}\left(o_{i, t} | q, o_{i,<t}\right)}{\pi_{\theta_{old } }\left(o_{i, t} | q, o_{i,<t}\right)}, 1-\epsilon, 1+\epsilon\right) \hat{A}_{i, t}\right] -\beta D_{K L}\left[\pi_{\theta} | \pi_{ref }\right]\right\}, \end{aligned}$$- 其中 \(\epsilon\) 和 \(\beta\) 是超参数,\(\hat{A}_{i, t}\) 是仅基于每个组内输出的相对奖励计算的优势,这将在5.2小节中详细介绍

PoLMs for Fine-Tuning

- 微调是使预训练的 LLM 适应特定任务的基础,它通过有针对性地调整参数来优化模型的能力

- 这个过程利用有标签或特定任务的数据集来提升性能,从而缩小通用预训练和特定领域需求之间的差距

- 本章将探讨三种主要的微调范式:

- 监督微调(Supervised Fine-Tuning,在3.1节中介绍),它利用带 annotations(标注)的数据集来提高特定任务的准确性;

- 自适应微调(Adaptive Fine-Tuning,在3.2节中介绍),它通过 Instruction Tuning 和基于提示的方法来定制模型行为;

- 强化微调(Reinforcement Fine-Tuning,在3.3节中介绍),它结合强化学习,根据奖励信号迭代优化输出,通过动态交互促进模型的持续改进

SFT

- SFT (2022)通过利用特定任务的带标签数据集,使预训练的大语言模型适应特定任务

- 与依赖指令提示的 Instruction Tuning不同,监督微调直接使用带 annotations 的数据来调整模型参数 ,使模型既精确又能适应上下文,同时还保留了广泛的泛化能力

- 监督微调弥合了预训练阶段编码的广泛语言知识与目标应用的细致需求之间的差距(2021)

- 预训练的大语言模型通过接触大量语料库,获取了通用的语言模式,这减少了在微调时对大量特定领域数据的依赖

- 模型的选择至关重要:

- 较小的模型,如 T5(2019),在数据集有限、资源受限的环境中表现出色;

- 较大的模型,如 GPT-4(2023),则凭借其更强的能力在复杂、数据丰富的任务中表现优异

Dataset Preparation for SFT

- 构建高质量的监督微调数据集是一个多方面的过程,对微调的成功至关重要

- 监督微调数据集的构建(SFT Dataset Construction) :监督微调数据集通常被构建为 \(D=\{(I_{k}, X_{k})\}_{k = 1}^{N}\),其中 \(I_{k}\) 是一条指令,\(X_{k}\) 是其相应的实例

- 这种配对能让大语言模型识别特定任务的模式并生成相关输出

- 像 Self-Instruct(2022)这样的方法,通过合成新的指令-输出对,丰富了数据集的多样性,并使用如 ROUGE-L(2015)这样的指标过滤重复内容,以保持多样性

- 监督微调数据集的筛选(SFT Dataset Screening) :筛选确保最终数据集中只保留高质量的指令-实例对

- 使用筛选函数 \(r(·)\) 来评估每对 \((I_{k}, X_{k})\) 的质量,从而得到一个经过筛选的子集 \(D’\) :

$$\mathcal{D}’=\{(I_{k}, X_{k}) \in \mathcal{D} | r(I_{k}, X_{k}) \geq \tau\}$$- 其中 \(\tau\) 是用户定义的质量阈值

- 例如,指令跟随难度(Instruction Following Difficulty, IFD)指标(2023)用于量化给定指令引导模型生成预期响应的有效程度

- IFD 函数表示为:

$$r_{\theta}(Q, A)=\frac{\sum_{i = 1}^{N} \log P(w_{i}^{A} | Q, w_{1}^{A}, …, w_{i - 1}^{A} ; \theta)}{\sum_{i = 1}^{N} \log P(w_{i}^{A} | w_{1}^{A}, …, w_{i - 1}^{A} ; \theta)}$$- 其中 \(Q\) 表示指令,\(A\) 是预期响应,\(\theta\) 代表模型的可学习参数

- 这个指标通过比较在有指令和无指令情况下生成响应的可能性,提供了一种标准化的方法来衡量指令对响应生成的促进效果

- 不符合选定 IFD 阈值的指令-实例对将被排除,从而得到一个优化后的数据集 \(D’\)

- 注:特别需要注意的是,上述表达式中的分子分母均小于 0,所以,\(r_{\theta}(Q, A) > 1\) 时,说明 分子小于分母

- 注:这里 IFD 的表达式中同时省略了分子分母的负号,虽然结果一致,但会对理解 IFD 指标带来一定的困扰

- 补充:IFD 的原始计算方式(原始论文:From Quantity to Quality: Boosting LLM Performance with Self-Guided Data Selection for Instruction Tuning, 20240406):IFD 通过计算条件回答分数(Conditioned Answer Score,CAS)与直接答案分数(Direct Answer Score,DAS)的比值得到,公式为:

$$ \mathrm{IFD}_\theta(Q,A)=\frac{s_\theta(A|Q)}{s_\theta(A)}$$- \(s_\theta(A|Q)\) 表示模型在给定指令 \(Q\) 的情况下生成答案 \(A\) 的分数

$$ s_{\theta}(A | Q) = -\frac{1}{N} \sum_{i = 1}^{N} \log P\left(w_{i}^{A} | Q, w_{1}^{A}, w_{2}^{A}, \cdots, w_{i - 1}^{A} ; \theta\right)$$ - \(s_\theta(A)\) 表示模型直接生成答案 \(A\) 的分数

$$ s_{\theta}(A) = -\frac{1}{N} \sum_{i = 1}^{N} \log P\left(w_{i}^{A} | w_{1}^{A}, \cdots, w_{i - 1}^{A} ; \theta\right) $$

- \(s_\theta(A|Q)\) 表示模型在给定指令 \(Q\) 的情况下生成答案 \(A\) 的分数

- 补充:IFD 指标意义 :IFD 值可以反映指令对模型生成答案的影响程度

- IFD 值超过 1 的数据通常被视为异常数据

- 理解:由于分子分母都是正数,此时说明分子大于分母,即条件概率小于直接生成概率: \(P(A|Q,W) < P(A|W) \),这说明,加入 Q 对 A 的生成非但没有帮助,反而是负向影响

- IFD 高但不超过 1,意味着提示对模型生成答案有帮助,但帮助不显著,这类样本属于 “difficulty” 样本;

- 理解:此时条件概率大于直接生成概率 \(P(A|Q,W) > P(A|W) \),但是大的不多,即 Q 对 A 的生成影响不大,此时 模型难以将答案与给定的指令内容对齐 ,这种样本对模型来说挑战较大

- 低 IFD 值表明提示极大地简化了答案的生成,属于 “easy” 样本

- 理解:此时条件概率大于直接生成概率 \(P(A|Q,W) > P(A|W) \),且大很多,即 Q 对 A 的生成影响非常大,这种样本很容易学习(甚至不需要学习?)

- 较高的 IFD 分数表明模型难以将答案与给定的指令内容对齐 ,说明指令难度更高 ,对模型调优更有利

- IFD 值超过 1 的数据通常被视为异常数据

- 补充:IFD 的原始计算方式(原始论文:From Quantity to Quality: Boosting LLM Performance with Self-Guided Data Selection for Instruction Tuning, 20240406):IFD 通过计算条件回答分数(Conditioned Answer Score,CAS)与直接答案分数(Direct Answer Score,DAS)的比值得到,公式为:

- 使用筛选函数 \(r(·)\) 来评估每对 \((I_{k}, X_{k})\) 的质量,从而得到一个经过筛选的子集 \(D’\) :

- 监督微调数据集的评估(SFT Dataset Evaluation) :

- 评估监督微调数据集需要选择一个高质量的子集 \(D_{eval}\),作为衡量模型性能的基准

- 这个子集可以从经过筛选的数据集 \(D’\) 中抽样,或者从独立的部分数据中获取,以确保公正性

- 传统的监督微调评估方法,如 Few-Shot GPT(2020)和微调策略(2023),资源消耗大,而指令挖掘(Instruction Mining)(2023)提供了一种更高效的替代方法

- 指令挖掘使用线性质量规则和一组指标,如响应长度和平均奖励模型分数(2023),来衡量数据集质量,并评估这些指标与整体数据集质量之间的相关性

- 注:指令挖掘(Instruction Mining)通常是指从大量数据中自动或半自动地筛选、提取和构建高质量的指令遵循(instruction-following)数据的过程

- 问题:到底是 SFT Evaluation 还是 SFT Dataset Evaluation?

Process of SFT

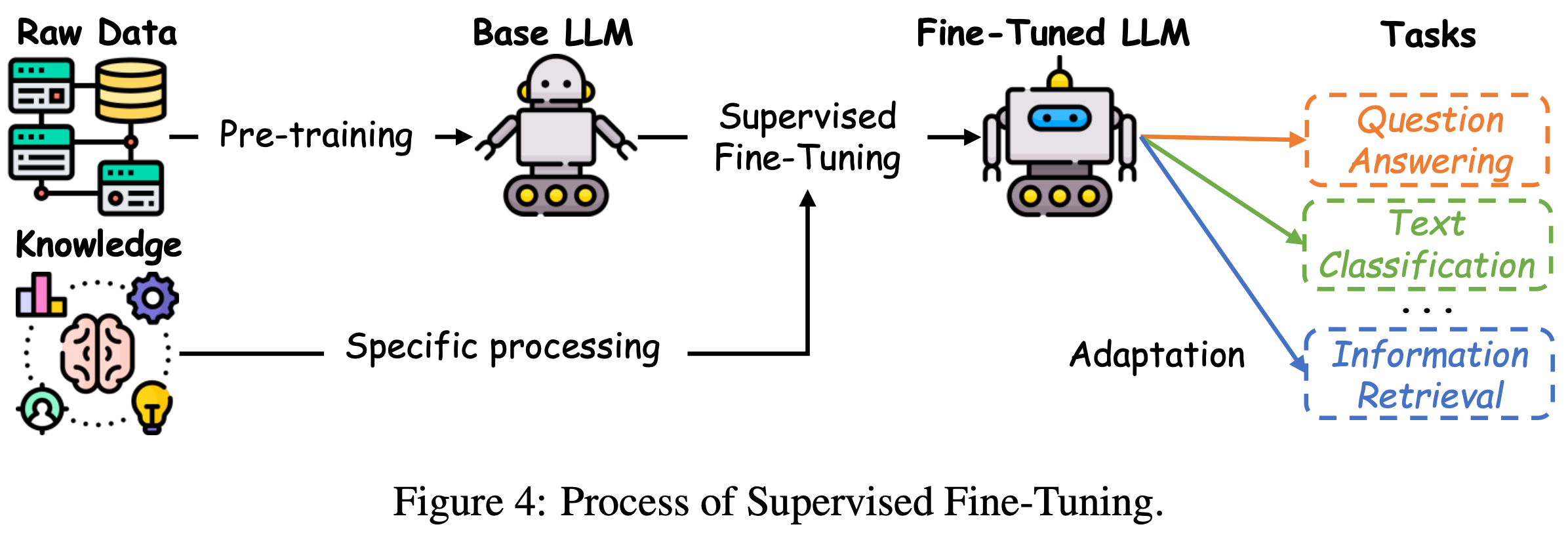

- 如图4所示,数据集准备好以后,微调过程从一个预训练的大语言模型开始

- 这个预训练模型通常是通过在大规模原始数据集上进行无监督或自监督预训练得到的)

- 预训练阶段的目标是获取适用于各种任务的通用特征表示(2021)

- 在微调阶段,模型的参数会使用特定任务的带 annotations 数据进行调整,使模型符合给定应用的要求(这个阶段常用的目标函数是交叉熵损失函数)

- 对于一个有 \(N\) 个样本和 \(C\) 个类别的分类任务,它可以表示为:

$$L_{\text{fine-tune}}(\theta)=-\frac{1}{N} \sum_{i = 1}^{N} \sum_{j = 1}^{C} y_{ij} \log P(y_{j} | x_{i} ; \theta)$$- 其中 \(y_{ij}\) 是样本 \(i\) 在类别 \(j\) 中的真实标签,\(P(y_{j} | x_{i} ; \theta)\) 表示模型预测样本 \(i\) 属于类别 \(j\) 的概率

- 最小化这个损失函数可以使模型更好地与真实标签对齐,从而提高在目标任务上的性能

- 一个突出的例子是 BERT 模型(2018),它在如 BooksCorpus 和 Wikipedia 等广泛的语言语料库上进行了广泛的预训练

- 在微调阶段,这些广泛的表示会使用特定任务的数据(例如用于情感分析的 IMDB 数据集(2011))进行优化,使 BERT 能够专注于诸如情感分类和问答等任务

Full-Parameter Fine-Tuning

- 全参数微调指的是调整预训练模型的所有参数的过程,这与像 LoRA(2021)或 Prefix-Tuning(2021)等仅修改部分参数的参数高效方法不同

- 全参数微调通常用于需要高精度的任务,如医疗和法律领域(2023),但它需要大量的计算资源

- 例如,微调一个有 65B 参数的模型可能需要超过 100GB 的 GPU 内存,这给资源受限的环境带来了挑战

- 理解:这里低估了吧,65B 模型全参数微调至少需要 1000GB 显存

- 为了缓解这些限制,像 LOMO(2023)这样的内存优化技术被引入,它减少了梯度计算和优化器状态的内存占用

- 模型的参数根据以下规则更新:

$$\theta_{t + 1}=\theta_{t}-\eta \nabla_{\theta} L(\theta_{t})$$- 其中 \(\theta_{t}\) 表示在迭代 \(t\) 时的模型参数,\(\eta\) 是学习率,\(\nabla_{\theta} L(\theta_{t})\) 表示损失函数的梯度

- 使用混合精度训练(Mixed Precision Training)(2017)和激活检查点(Activation Checkpointing)(2016)等内存优化技术,有助于减少内存需求,使大型模型能够在硬件资源有限的系统上进行微调

- 例如,微调一个有 65B 参数的模型可能需要超过 100GB 的 GPU 内存,这给资源受限的环境带来了挑战

- 从 GPT-3 到 InstructGPT(2022)就是一个全参数微调的显著例子,在这个过程中,模型的整个参数集使用为指令跟随任务设计的数据集进行了微调。这种方法能带来最佳性能,但由于需要更新所有参数,计算成本很高

Adaptive Fine-Tuning

- 自适应微调通过修改预训练模型的行为,更好地满足用户特定需求,并处理更广泛的任务

- 这种方法引入了额外的提示来指导模型生成输出,为定制模型的响应提供了一个灵活的框架

- 自适应微调中值得注意的方法包括 Instruction Tuning 和基于提示的微调(prompt-based tuning),这两种方法都通过引入特定任务的指导,显著增强了大语言模型的适应性

Instruction Tuning

- Instruction Tuning(2023)是一种通过在专门构建的指令数据集上对基础大语言模型进行微调,来优化模型的技术

- 这种方法大大提高了模型在各种任务和领域中的泛化能力,增强了其灵活性和准确性

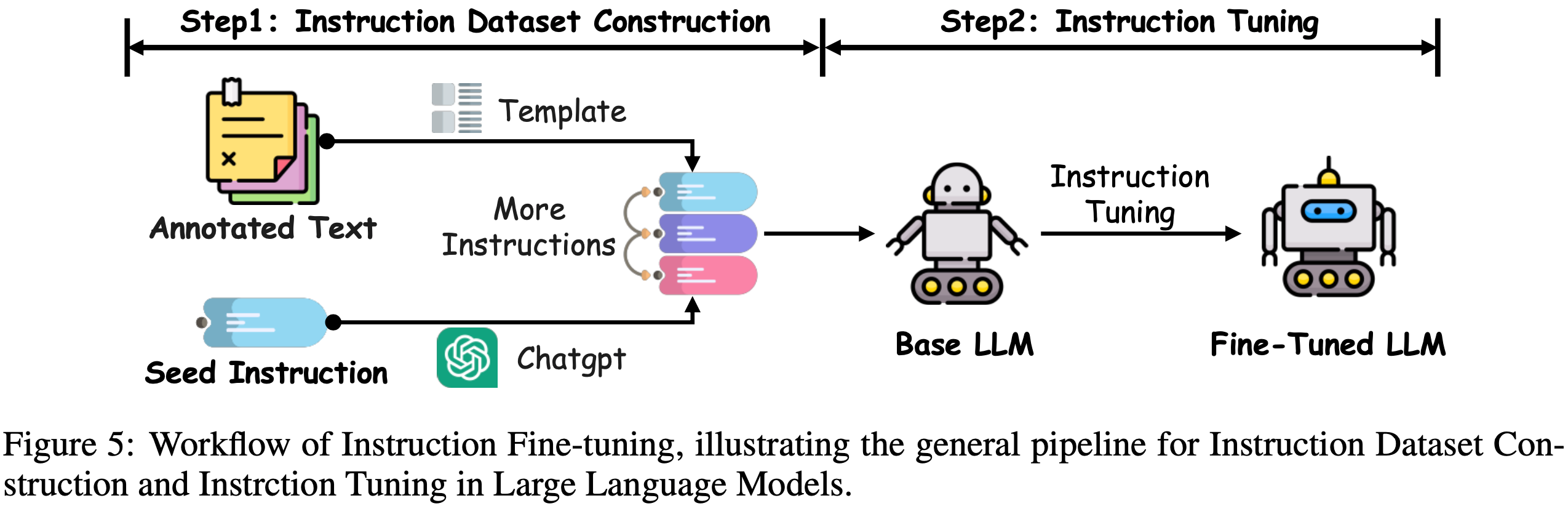

- 如图5所示,这个过程首先将现有的 NLP 数据集(例如用于文本分类、翻译和摘要的数据集)转换为自然语言指令,这些指令包括任务描述、输入示例、预期输出和示例演示

- 像 Self-Instruct(2022)这样的技术,通过自动生成额外的指令-输出对,进一步增强了这些数据集的多样性,扩大了模型接触的任务范围

- 微调过程使模型的参数与这些特定任务的指令保持一致,从而使大语言模型在熟悉和以前未见过的任务中都能表现出色

- 例如,InstructGPT(2022)和 GPT-4(2023)在众多应用中,指令跟随能力都有显著提升

- Instruction Tuning 的有效性在很大程度上取决于指令数据集的质量和广度

- 高质量的数据集应涵盖广泛的语言、领域和任务复杂性,以确保模型具有广泛的适用性(2023)

- 指令的清晰度和组织方式在使模型有效解释和执行任务方面起着关键作用

- 诸如整合示例演示,包括思维链提示(Chain-of-Thought prompting)(2022)等技术,可以显著提高在需要复杂推理的任务上的性能

- 此外,在微调阶段 确保任务的平衡分布至关重要 ,这可以避免因任务覆盖不均衡而导致的过拟合或模型性能下降

- 像按比例任务采样或加权损失函数这样的技术,有助于解决这些问题,确保每个任务在微调过程中都能做出公平的贡献

- 结论:通过精心构建和管理指令数据集,研究人员可以大大提高微调后的大语言模型的泛化能力,使其在广泛的任务和领域中表现出色(2023)

Prefix-Tuning

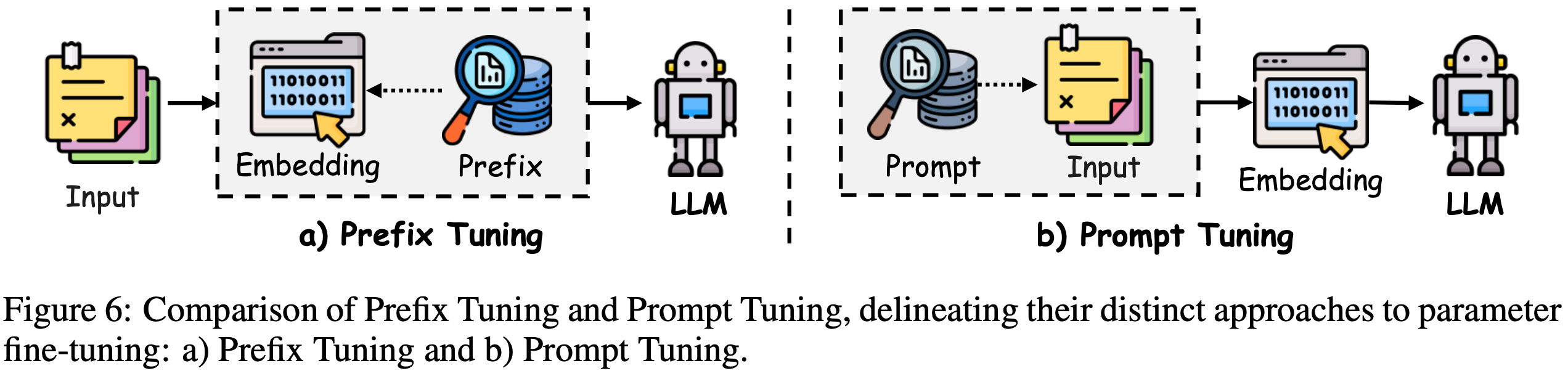

- Prefix-Tuning(2021)是一种参数高效的微调方法,它在语言模型的每个 Transformer 层添加一系列可训练的前缀标记(连续向量),同时保持核心模型参数不变

- 如图6(a)所示,这些前缀向量是特定于任务的,并且起着虚拟 token embedding 的作用

- 为了优化前缀向量,使用了一种重参数化技巧,即学习一个小型多层感知器(Multi-Layer Perceptron, MLP)函数,将一个较小的矩阵映射到前缀参数,而不是直接优化前缀向量

- 这种方法已被证明可以稳定训练过程

- 前缀向量被优化后,映射函数会被丢弃,只保留导出的前缀向量来提高特定任务的性能

- 通过在输入序列前添加学习到的连续提示,并利用分层提示,模型的行为被引导向特定任务的输出,而无需对整个模型进行微调

- 由于只调整前缀参数,这是一种一种更高效的参数调整方法

- 在此基础上,P-Tuning v2(2021)将分层提示向量整合到 Transformer 架构中 ,专门用于自然语言理解任务

- 这种方法还利用多任务学习来跨任务优化共享提示,从而在不同的参数规模上提高模型性能(2021)

- Prefix-Tuning 能够快速有效地使大语言模型适应特定任务,这使它成为需要灵活性和效率的应用中的一种有吸引力的策略

Prompt-Tuning

- Prompt-Tuning(2021, 2020)是一种旨在通过优化输入层的可训练向量 ,而不修改模型内部参数 ,来有效调整大语言模型的方法

- 如图6(b)所示,这项技术在离散提示方法(2020, 2021)的基础上,引入了软提示标记,这些标记可以采用无限制格式(2021)或前缀形式(2020)

- 这些学习到的提示嵌入在模型处理之前与输入文本嵌入相结合,从而在保持预训练权重不变的情况下引导模型的输出

- Prompt-Tuning 的一个值的提到的实现是 P-tuning(2021),它使用一种灵活的方法来组合上下文、提示和目标标记,适用于理解和生成任务

- 这种方法通过双向长短期记忆(Long Short-Term Memory, LSTM)架构增强了软提示表示的学习

- 相比之下,标准 Prompt-Tuning(2020)采用了更简单的设计,其中前缀提示被添加到输入之前,并且在训练过程中仅根据特定任务的监督更新提示嵌入

- 研究表明,Prompt-Tuning 在许多任务上可以达到与全参数微调相媲美的性能,同时所需的可训练参数要少得多

- 但它的成功与底层语言模型的能力密切相关,因为 Prompt-Tuning 只在输入层修改少量参数(2021)

- 在这些进展的基础上,像 P-Tuning v2(2021)这样的新方法已经证明,Prompt-Tuning 策略可以有效地扩展到各种模型大小,处理以前认为需要完全微调的复杂任务

- 这些发现确立了 Prompt-Tuning 作为传统微调的一种高效替代方法,在降低计算和内存成本的同时提供了可比的性能

Reinforcement Fine-Tuning

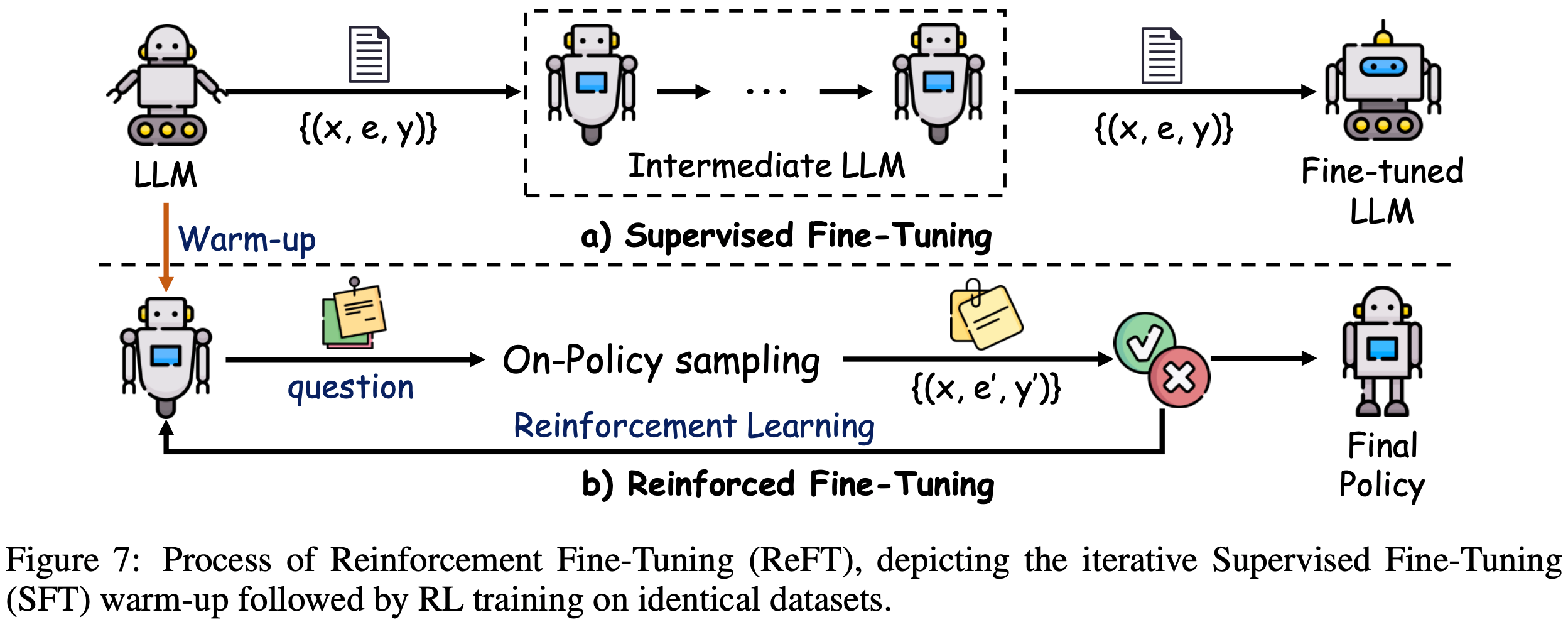

- 强化微调(Reinforcement Fine-Tuning, ReFT)(2024)是一种先进的技术,它将 RL 与监督微调相结合,以增强模型解决复杂动态问题的能力

- 强化微调与传统的监督微调不同

- 传统监督微调通常为每个问题使用单一的思维链 annotations

- 强化微调使模型能够探索多种有效的推理路径 ,从而提高其泛化能力和解决问题的技能

- 强化微调过程从标准的监督微调阶段开始,在监督微调阶段,模型最初有标签数据(labeled data)上进行训练,通过监督 annotations 学习基本的任务解决能力

- 在初始微调之后,模型使用强化学习算法(如 PPO(2017))进行进一步优化

- 在强化阶段,模型为每个问题生成多个思维链 annotations,探索不同的潜在推理路径。通过将模型的预测答案与真实答案进行比较来评估这些生成的路径,正确输出给予奖励,错误输出则给予惩罚。这个迭代过程促使模型调整其策略,最终改进其推理策略

- 如图7所示,强化微调过程分两个阶段执行

- 上半部分代表监督微调阶段,在这个阶段,模型在训练数据上迭代,在几个训练周期内学习每个问题的正确思维链 annotations

- 在图的下半部分,引入了强化微调阶段:

- 从经过监督微调训练的模型开始,模型根据其当前策略生成替代的思维链 annotations \((e’)\),并将其预测答案 \((y’)\) 与真实答案 \((y)\) 进行比较

- 正确答案给予正奖励,错误答案给予负奖励 ,从而推动模型提高性能

- 这些奖励信号随后用于通过强化学习更新模型的策略,增强其生成准确多样的思维链 annotations 的能力

- 最近的研究表明,强化微调明显优于传统的监督微调方法(2024)

- 此外,在推理时集成多数投票和重排序等策略,可以进一步提高性能,使模型在训练后能够优化其输出

- 值得注意的是,强化微调在不需要额外或增强训练数据的情况下实现了这些改进,仅从监督微调阶段使用的现有数据集中学习

- 这突出了模型卓越的泛化能力,因为它能够更高效地从可用数据中学习

PoLMs for Alignment

- LLM 的对齐是指引导模型输出符合人类期望和偏好,尤其在安全关键或面向用户的应用中

- 本章将讨论实现对齐的三种主要范式:

- RLHF(在4.1节中介绍):使用人类标记的数据作为奖励信号;

- RLAIF(在4.2节中介绍):利用人工智能生成的反馈来解决可扩展性问题;

- 直接偏好优化(在4.3节中介绍):直接从成对的人类偏好数据中学习,不需要显式的奖励模型

- 每种范式在追求稳健对齐方面都有其独特的优势、挑战和权衡

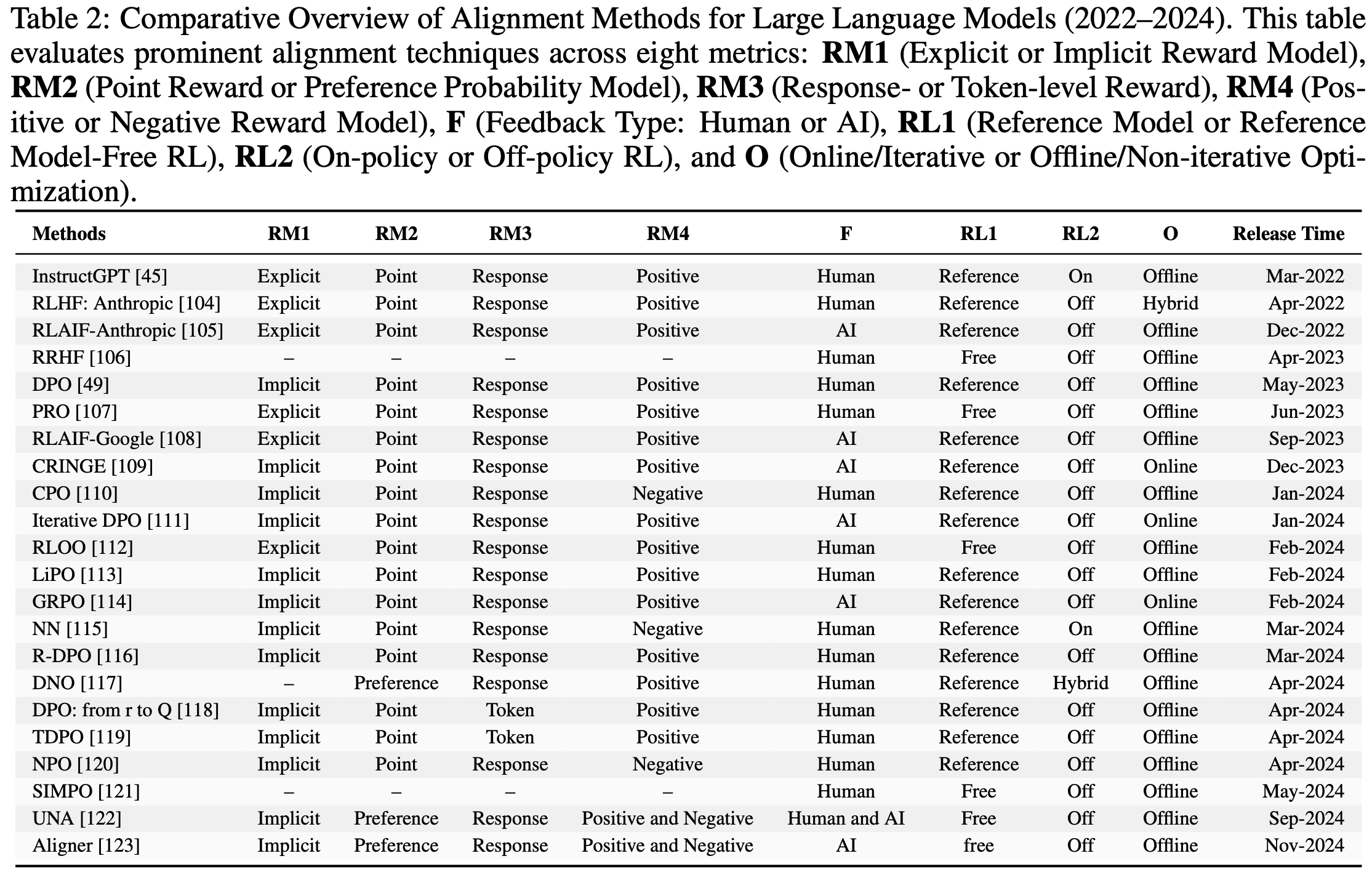

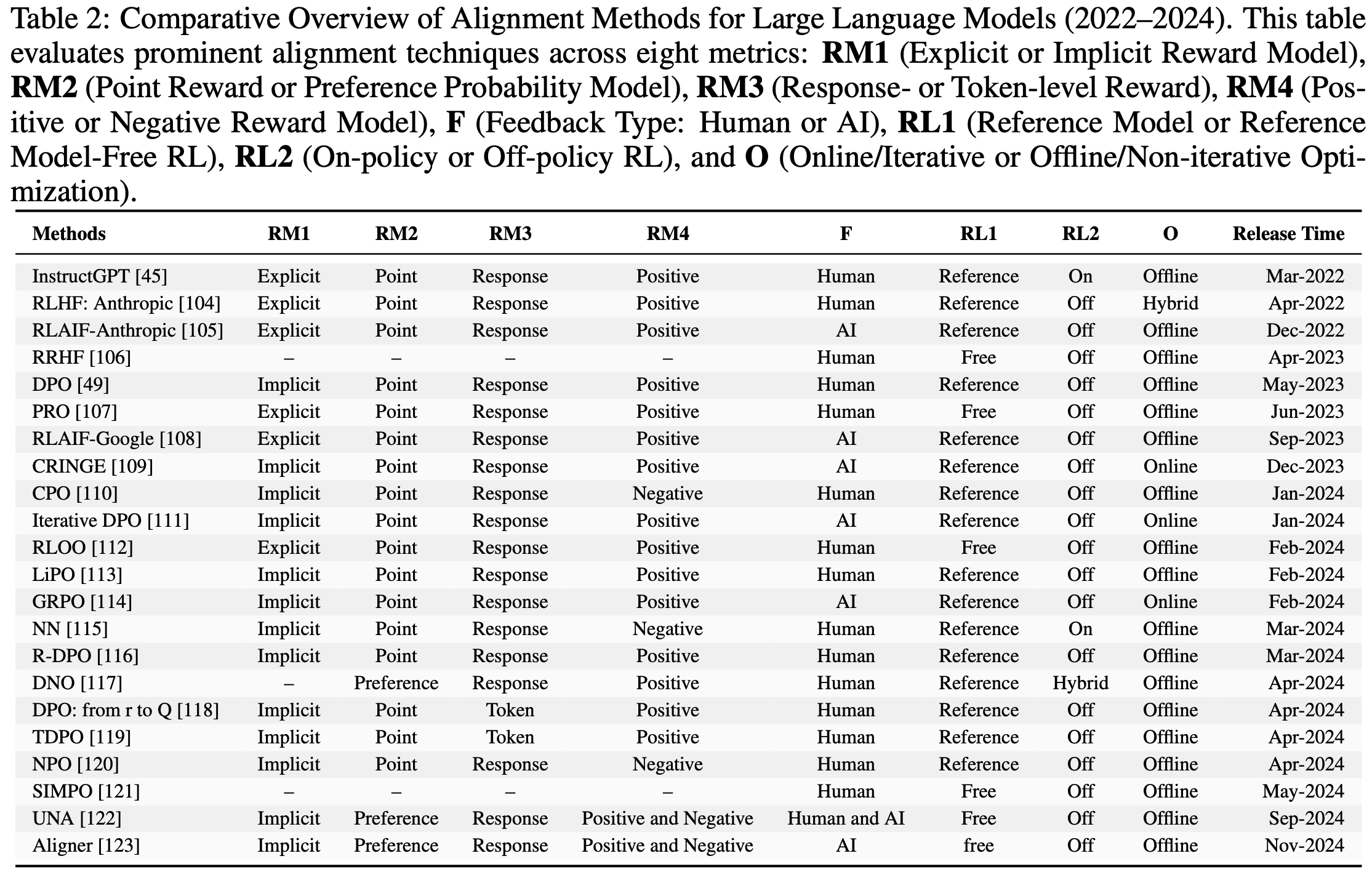

- 这些方法及相关方法的简要比较总结在表2中

RLHF(Reinforcement Learning with Human Feedback)

- SFT 是引导大语言模型遵循人类指令的基础技术

- 但在纯监督场景中,带 annotations 数据的多样性和质量可能参差不齐,而且监督模型捕捉更细微或适应性更强的人类偏好的能力往往有限

- 为了应对这些不足,人们提出了基于 RL 的微调方法。在强化学习方法中,RLHF(2022)是最早且最具影响力的基于强化学习的后训练对齐方法之一

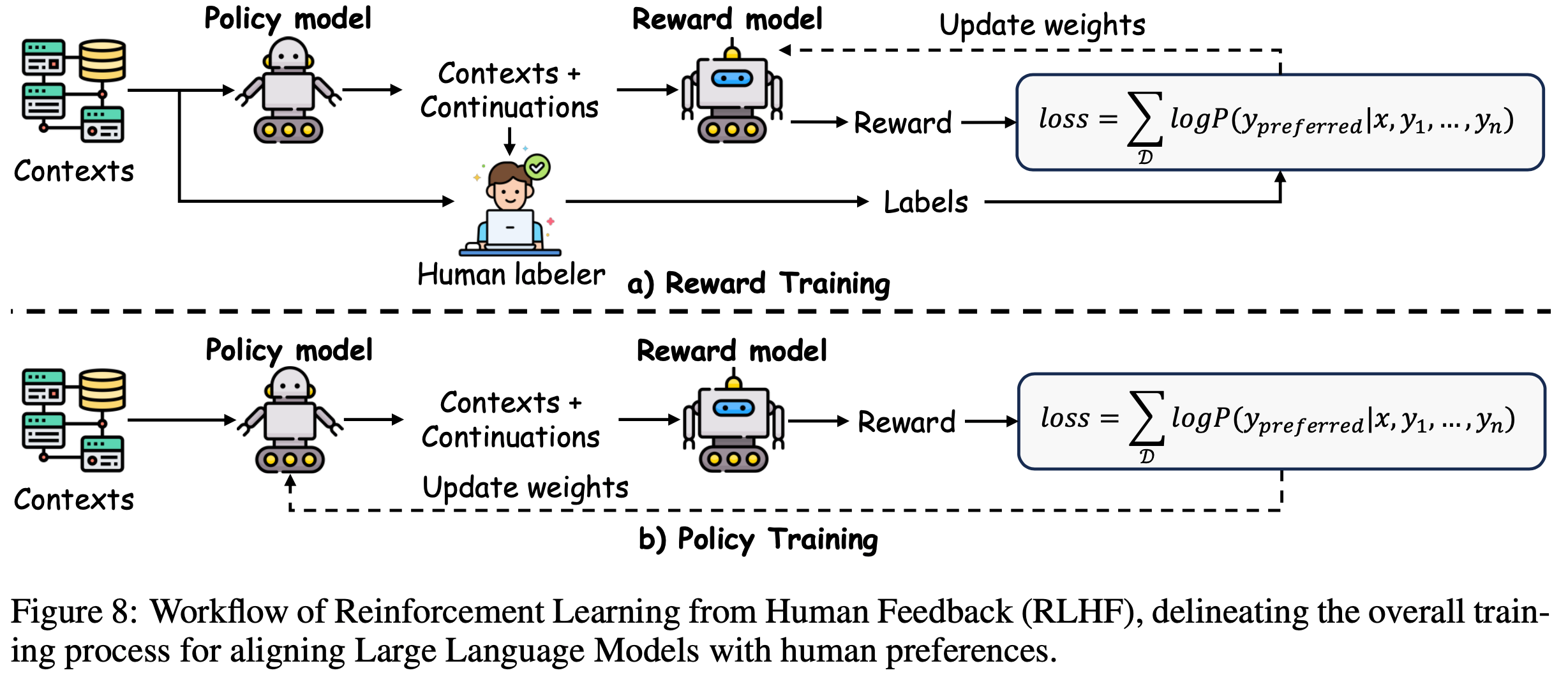

- 如图8所示:RLHF 首先以偏好标签或奖励信号的形式聚合人类反馈,然后使用这些信息来训练奖励模型

- 在这个奖励模型的指导下,策略会不断调整,以更好地匹配人类偏好

- 与监督微调相比,RLHF 融入了持续的、基于偏好的更新,从而带来更强的对齐效果

- 值得注意的是,像 GPT-4(2023)、Claude(2024)和 Gemini(2023)这样的现代大语言模型都受益于这些机制,在指令跟随、事实一致性和用户相关性方面都有改进

- 下面,论文将讨论 RLHF 的主要组成部分,包括反馈机制、奖励建模和策略学习策略

Feedback Mechanisms of RLHF

- 人类反馈是 RLHF 的核心,它向奖励模型告知用户偏好并指导策略更新

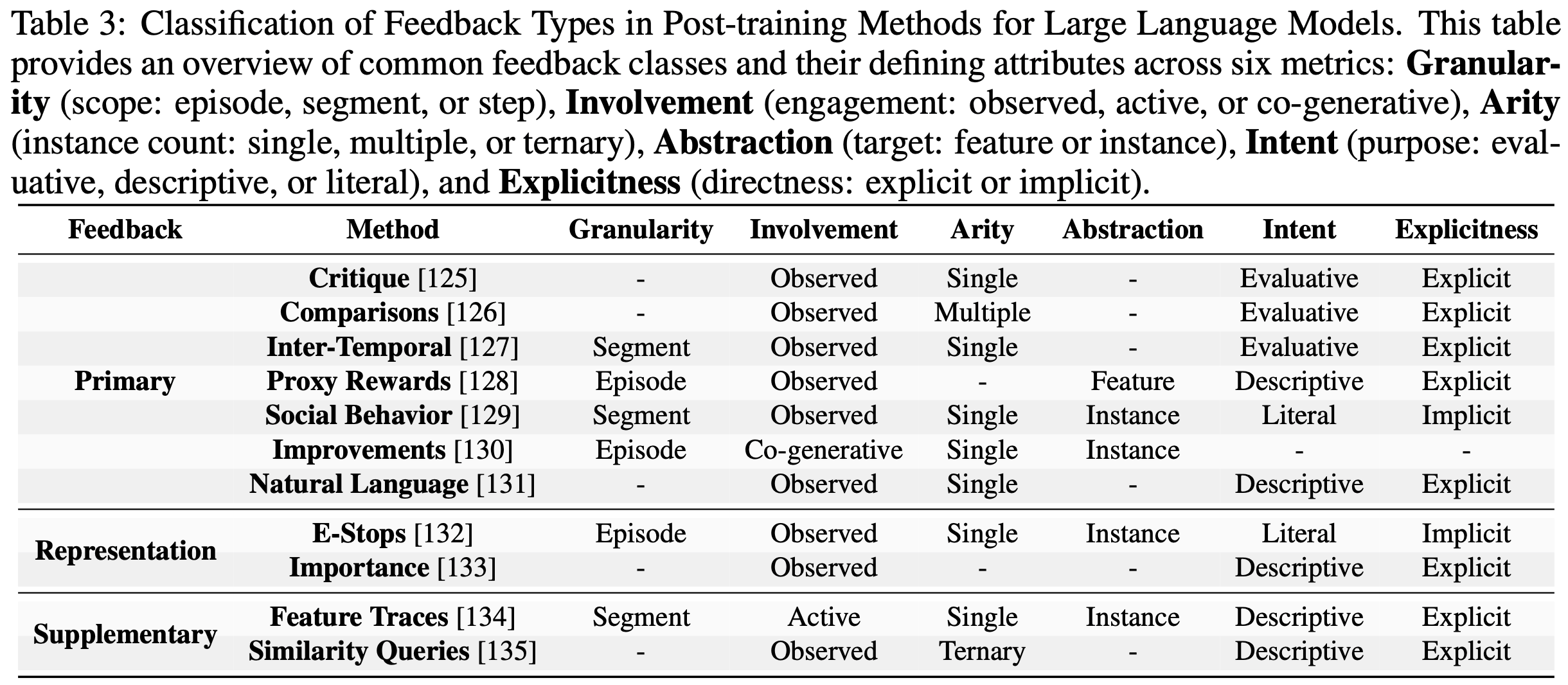

- 本小节采用(2023)的分类法对常见的人类反馈形式进行分类

- 表3从粒度、参与程度和明确性等维度展示了这些反馈类型

- 每种反馈方式都对模型优化的不同方面有所贡献,并在可解释性、可扩展性和抗噪声性方面表现出不同的水平

- 每种反馈方式都对模型优化的不同方面有所贡献,并在可解释性、可扩展性和抗噪声性方面表现出不同的水平

- 主要反馈(Primary Feedback) :这类反馈是 RLHF 中最直接影响奖励模型的反馈类型,例如:

- 评论(Critique)(2020)侧重于人类对智能体行为的明确评估,通常通过二元或多标签 annotations 来减少噪声

- 比较(Comparisons)(2011)允许评估者比较多个输出或轨迹;虽然更大的选择集可以提供更丰富的信号,但也可能导致因果混淆

- 跨时间反馈(Inter-Temporal Feedback)(2019)通过在不同时间步提供判断来优化轨迹评估

- 代理奖励(Proxy Rewards)(2021)整合了近似奖励函数,引导模型朝着用户定义的目标前进

- 社会行为(Social Behavior)(2021)利用隐含线索(如面部表情)使智能体目标与用户情绪保持一致

- 改进(Improvements)(2023)强调人类的实时干预,以逐步优化策略

- 自然语言反馈(Natural Language Feedback)(2023)利用文本信息传达偏好和改进建议

- 补充反馈(Supplementary Feedback) :除了主要反馈外,还有两类反馈进一步强化奖励建模过程

- 紧急停止(e-stops)(2023)允许人类通过中断智能体的轨迹来干预其行为,而无需提出替代方案

- 这种反馈的特点是隐含参与,并且专注于防止不良行为

- 重要性标签(Importance labels)(2021)表明特定观察结果对实现目标的重要性,提供不直接改变行为的明确反馈

- 这种反馈因上下文而异,作为补充输入,强化奖励模型的整体学习过程

- 紧急停止(e-stops)(2023)允许人类通过中断智能体的轨迹来干预其行为,而无需提出替代方案

- 特定表示反馈(Representation-Specific Feedback) :某些反馈类型主要用于增强表示学习,而不是直接塑造奖励函数

- 特征轨迹(Feature Traces)(2022)促使人类操作员展示特定特征的单调变化,从而实现特征集的动态扩展

- 相似性查询(Similarity Queries)(2023)通过比较轨迹三元组,通过轨迹空间中的成对距离来指导表示学习

- 通过利用这些特定表示的反馈形式,RLHF 可以更好地泛化到新任务和新环境

Reward Model of RLHF

- 真实的奖励函数 \(r(x, y)\) 通常是未知的,因此有必要基于人类提供的偏好构建一个可学习的奖励模型 \(r_{\theta}(x, y)\)

- 该模型预测候选输出 \(y\) 在给定输入 \(x\) 的情况下与人类期望的对齐程度

- 为了获得 \(r_{\theta}(x, y)\) 的训练数据,人类评估者会根据输出的相对适用性对输出对进行比较或标记,并且该模型通常使用这些比较的交叉熵损失进行训练

- 为了防止策略 \(\pi\) 与初始模型 \(\rho\) 偏离太远,在奖励函数中引入了一个由超参数 \(\beta\) 控制的惩罚项:

$$r_{\theta}(x, y)=r(x, y)-\beta \log \frac{\pi(y | x)}{\rho(y | x)}$$- 其中 \(\pi(y | x)\) 是微调后的策略 \(\pi\) 在给定输入 \(x\) 时产生输出 \(y\) 的概率,而 \(\rho(y | x)\) 是原始模型 \(\rho\) 对应的概率

- 这个项确保 \(\pi\) 在适应人类反馈的同时,仍然受到 \(\rho\) 所捕捉的先验知识的约束

- 评估奖励函数 \(r_{\theta}(x, y)\) 至关重要,因为它直接影响学习效果和策略性能

- 准确评估这个函数有助于确定适合的奖励结构,使模型输出与人类偏好保持一致

- 但在安全敏感领域,由于在线交互、偏差和对真实奖励的需求等相关风险,标准的滚动方法(2017, 2019)和离线策略评估(2019, 2019)可能不可行

- 为了应对这些挑战,通常采用两种主要方法:

- 距离函数(Distance Functions) :最近的研究集中在奖励评估距离函数上,这些函数考虑了潜在的转换,如潜在塑造。例如

- EPIC(2020)在各种转换下测量奖励函数的等价性

- DARD(2022)优化规范化以确保评估基于可行的转换

- 类 EPIC 距离(2022)通过允许规范化、标准化和度量函数的可变性来推广 EPIC 的方法

- STARC(2023)保留了 EPIC 的理论特性,同时提供了额外的灵活性

- 可视化和人工检查(Visual and Human Inspection) :其他方法依靠可解释性和精心设计的数据集来评估学习到的奖励函数的有效性

- PRFI(2022)使用预处理步骤来简化奖励函数,同时保持等价性,从而提高其透明度

8 同时,CONVEXDA 和 REWARDFUSION(2023)提出了旨在测试奖励模型对提示语义变化的响应一致性的数据集 - 这些技术共同有助于更可靠地评估奖励函数,加强大语言模型与人类偏好的对齐

- PRFI(2022)使用预处理步骤来简化奖励函数,同时保持等价性,从而提高其透明度

- 距离函数(Distance Functions) :最近的研究集中在奖励评估距离函数上,这些函数考虑了潜在的转换,如潜在塑造。例如

Policy Learning of RLHF

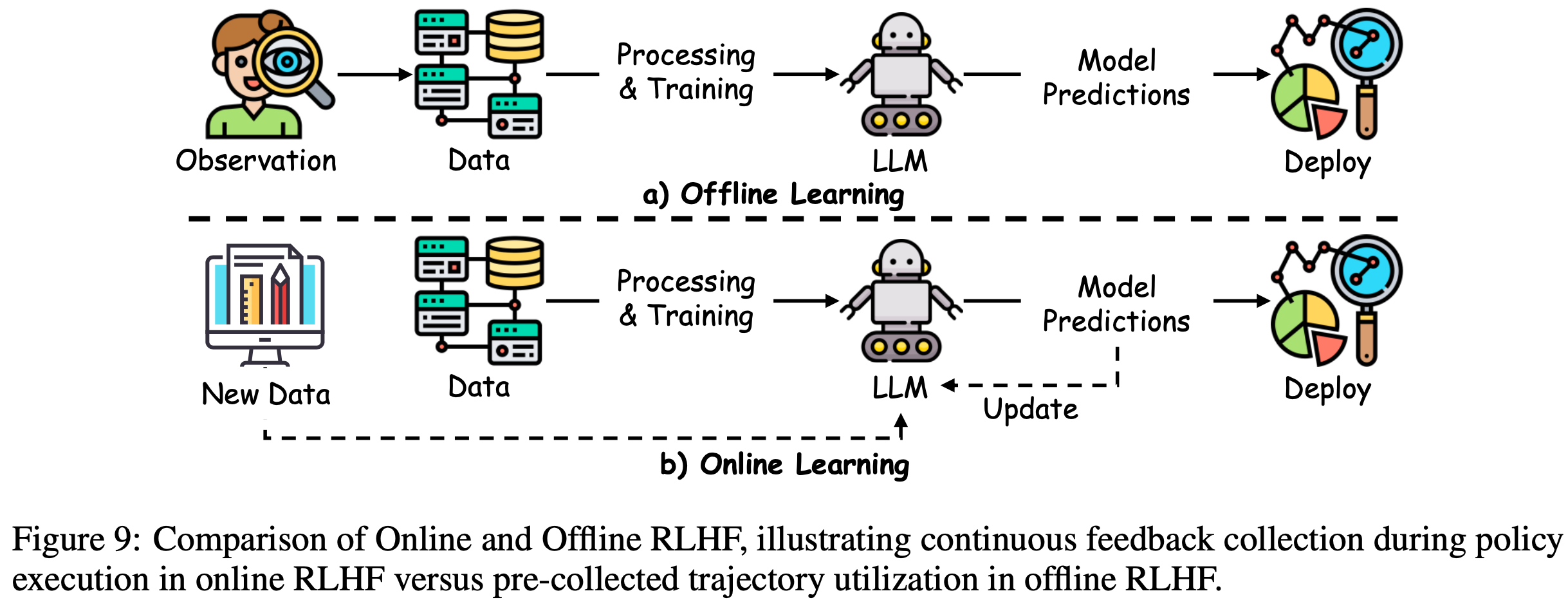

- 如图9所示,RLHF 的策略学习包括在在线和离线环境中通过人类反馈优化策略

- 在线学习(Online Learning) :在 Online RLHF 中,系统收集关于新生成的模型轨迹的实时人类偏好

- 像 DPS(2020)这样的算法使用贝叶斯更新来管理竞争过程,而 PPS 和 PEPS(2020)整合了动态规划和多臂老虎机的思想来优化策略行为

- 在 LPbRL(2022)中,特征嵌入捕捉不断变化的奖励结构,而 PbOP(2022)整合了最小二乘估计用于转换动态和偏好信号

- 最近,PARL(2023)通过将反馈获取视为策略优化的一个组成部分,以提高数据收集效率为目标

- 离线学习(Offline Learning) :在 Offline RLHF 中,以前收集的带有偏好标签的轨迹被用于学习或优化策略

- 例如,(2023)研究了带有成对比较数据的策略学习的悲观最大似然估计,并建立了性能界限

- 像 FREEHAND(2023)和 DCPPO(2023)这样的扩展推广到未知的偏好模型,探索离线数据覆盖范围和策略泛化之间的相互作用

- 此外,(2024)解决了成对比较的玻尔兹曼模型中的过拟合问题,而 DCPPO(2023)进一步研究了动态离散选择模型以提高反馈效率

- 在线学习和离线学习的融合(Blending Online and Offline Learning) :混合方法将离线预训练与在线偏好聚合相结合,充分利用预先收集的数据,同时仍然整合实时更新

- PFERL(2022)采用两阶段方法来最小化人类查询,而 PERL(2020)探索用于主动探索的乐观最小二乘策略

- 竞争强化学习(Dueling RL)(2023)及其扩展(如 PRPRL(2023)中的 REGIME)通过仔细划分数据获取和反馈收集来减少人类标记需求,从而优化样本效率、 annotations 成本和策略性能之间的权衡

RLAIF(Reinforcement Learning with AI Feedback)

- 基于 AI 反馈的强化学习(Reinforcement Learning with AI Feedback, RLAIF)扩展了 RLHF 范式,它采用大语言模型生成反馈信号

- 这种方法可以补充或替代人类反馈,在人类 annotations 稀缺、昂贵或不一致的任务中提供更具可扩展性、成本更低的偏好数据

RLAIF vs RLHF

- RLHF 在大规模应用中面临的一个主要挑战是其对人类生成的偏好标签的依赖,这需要大量资源来收集、整理和标记数据

- 标注数据的过程既耗时又昂贵,而且人类评估者可能会引入不一致性,从而使在所有模型输出上进行大规模、一致的标注变得复杂

- 这些限制极大地限制了 RLHF 的可扩展性和效率

- 为了应对这些挑战,(2022)提出了 RLAIF,它结合人类反馈和人工智能生成的反馈,通过强化学习来训练模型

- 通过利用大语言模型作为反馈源,RLAIF 减少了对人类标注者的依赖,为传统的 RLHF 提供了一种可行的替代方案

- 这种方法能够持续生成反馈,显著提高可扩展性,同时保留人类引导的模型优化的灵活性

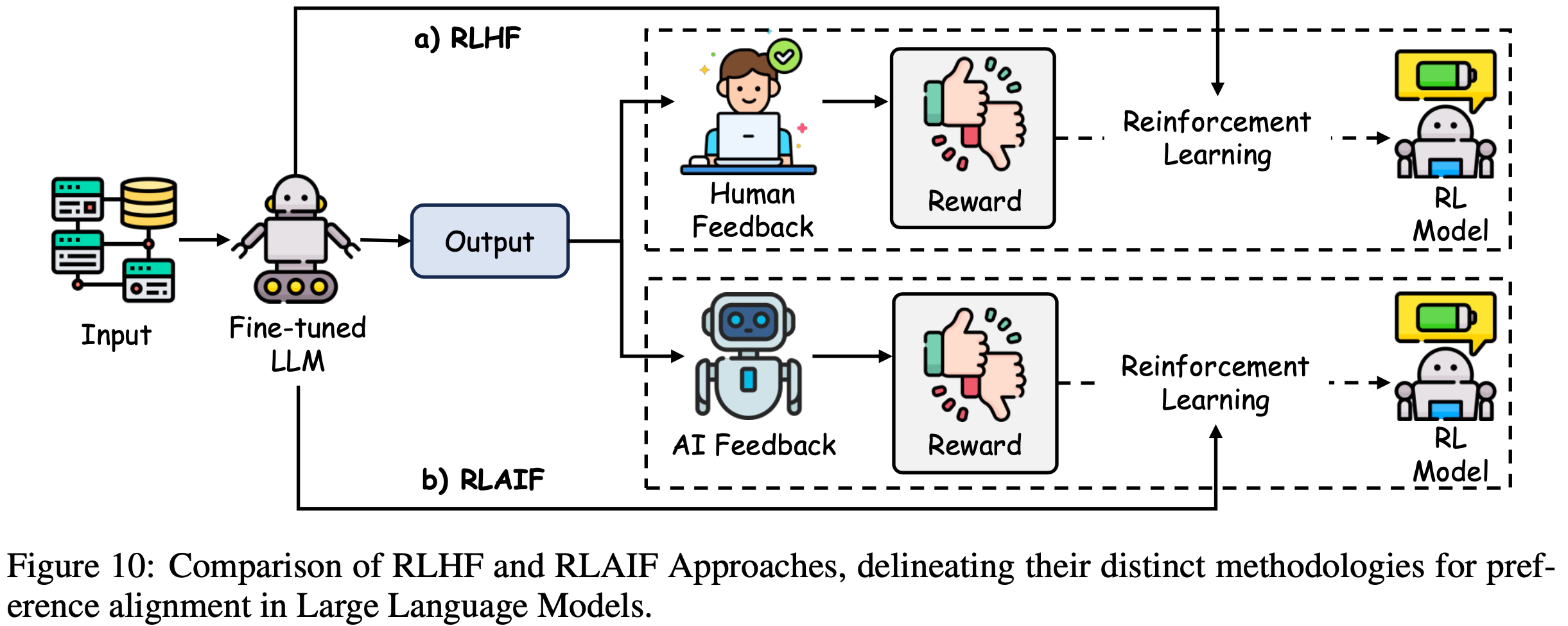

- 如图10所示,RLHF 和 RLAIF 的主要区别在于反馈源:

- RLHF 依赖于人类生成的偏好,而 RLAIF 使用人工智能生成的反馈来指导策略更新

- 实证研究(如(2023)的研究)表明:RLAIF 可以达到与 RLHF 相当甚至更优的性能 ,这是由人类评估者评估的

- RLAIF 不仅超过了传统的监督微调基线,而且使用与策略模型规模相同的大语言模型偏好标注器来实现这一点 ,突显了该方法的效率

RLAIF Training Pipeline

- RLAIF 的训练流程遵循几个关键阶段,在这些阶段中,人工智能生成的反馈被用于迭代优化模型的行为

- 正如(2023)所详细描述的,该流程使大语言模型的输出能够以跨各种任务的可扩展方式与人类期望保持一致

- 这些阶段如下:

- 人工智能反馈收集(AI Feedback Collection) :在这个阶段,人工智能系统根据预定义的标准生成反馈,这些标准可能包括特定任务的指标、响应的正确性或模型输出的适当性

- 与需要解释和手动标注的人类反馈不同,人工智能反馈可以在广泛的模型输出中一致地生成

- 这种特性使人工智能反馈能够持续提供,显著扩大了反馈循环的规模

- 奖励模型训练(Reward Model Training) :人工智能生成的反馈随后被用于训练或优化奖励模型

- 该模型将输入-输出对映射到相应的奖励,使模型的输出与反馈所指示的期望结果保持一致

- 虽然传统的 RLHF 依靠直接的人类反馈来评估输出,但 RLAIF 利用人工智能生成的标签,尽管这可能会引入一致性和偏差相关的问题,但在可扩展性和不依赖人力资源方面具有优势

- 策略更新(Policy Update) :最后阶段包括基于前一步训练的奖励模型更新模型的策略

- 采用强化学习算法来调整模型的参数,优化策略以在各种任务中最大化累积奖励

- 策略更新过程是迭代的,奖励模型指导模型的输出朝着与预期目标更高程度的对齐方向发展

- 人工智能反馈收集(AI Feedback Collection) :在这个阶段,人工智能系统根据预定义的标准生成反馈,这些标准可能包括特定任务的指标、响应的正确性或模型输出的适当性

- RLAIF 的主要优势在于:它能够在不需要持续人类干预的情况下扩展反馈循环

- 通过用人工智能生成的反馈替代人类反馈,RLAIF 促进了大语言模型在多个任务中的持续改进,缓解了人类标注工作带来的瓶颈

Direct Preference Optimization

- 如前所述,RLHF(2022)通常包括三个阶段:

- 监督微调(2021, 2022)

- 奖励建模

- 强化学习(通常通过 PPO 实现)(2017)

- 尽管 RLHF 是有效的,但它可能很复杂且容易不稳定,特别是在拟合奖励模型然后使用该模型微调大语言模型的阶段

- 困难在于创建一个准确反映人类偏好的奖励模型,以及在微调语言模型以优化这个估计奖励的同时,使其与原始模型保持接近

- 为了解决这些问题,直接偏好优化(Direct Preference Optimization, DPO)(2024)作为一种更稳定且计算效率更高的替代方案被引入

- 直接偏好优化通过将奖励函数直接与最优策略联系起来,简化了奖励优化过程

- 它将奖励最大化问题视为基于人类偏好数据的单阶段策略训练问题,从而避免了奖励模型拟合的复杂性以及对 Bradley-Terry model(1952)的依赖

Foundation of DPO

- RLHF 包括训练奖励模型(Reward Model, RM)和通过强化学习微调语言模型

- 直接偏好优化通过直接使用人类偏好数据训练语言模型,将奖励模型隐含地捕获在策略本身中,从而简化了这个过程

- KL 正则化奖励最大化目标(KL-Regularized Reward Maximization Objective) :直接偏好优化始于成熟的KL正则化奖励最大化框架,如下所示的目标:

$$\pi^{*}=\arg \max_{\pi} \mathbb{E}_{x \sim \mathcal{D}, y \sim \pi(\cdot | x)}\left[r(x, y)-\beta K L\left(\pi(\cdot | x) | \pi_{r e f}(\cdot | x)\right)\right] \tag{14}$$- 其中 \(r(x, y)\) 表示奖励函数,\(\beta>0\) 是控制与参考策略 \(\pi_\text{ref}\) 接近程度的系数,而 \(KL(\cdot | \cdot)\) 表示 KL 散度(Kullback-Leibler divergence)

- 这里,\(x \sim \mathcal{D}\) 表示从数据分布中抽取的输入,\(y \sim \pi(\cdot | x)\) 表示从策略中采样的输出

- 最优策略的推导(Deriving the Optimal Policy) :在适当的假设下,式(14)的解以玻尔兹曼分布(Boltzmann distribution)的形式导出(2019, 2023, 2020):

$$\pi^{*}(y | x)=\frac{1}{Z(x)} \pi_{r e f}(y | x) \exp \left(\frac{1}{\beta} r(x, y)\right) \tag{15}$$- 其中配分函数:

$$Z(x)=\sum_{y} \pi_{r e f}(y | x) \exp \left(\frac{1}{\beta} r(x, y)\right)$$- 作为归一化项,确保 \(\pi^{*}\) 仍然是一个有效的概率分布(即其概率之和为1)

- 其中配分函数:

- 奖励的重参数化(Reparameterizing the Reward) :对式(15)的两边取自然对数,我们可以将奖励 \(r(x, y)\) 与最优策略 \(\pi^{*}\) 联系起来。这产生:

$$r^{*}(x, y)=\beta\left[\log \pi^{*}(y | x)-\log \pi_{r e f}(y | x)\right]+\beta \log Z(x) \tag{16}$$- 其中 \(\beta \log Z(x)\) 是一个不影响奖励成对比较的常数

- 如果已知最优策略 \(\pi^{*}\),则真实奖励 \(r^{*}(x, y)\) 的值取决于这个常数

- Bradley–Terry 偏好(Preferences) :在 Bradley-Terry model(1952)下,人类对两个输出 \(y_{1}\) 和 \(y_{2}\) 的偏好由它们的奖励值之差决定

- 偏好 \(y_{1}\) 胜过 \(y_{2}\) 的概率由下式给出

$$p^{*}\left(y_{1} \succ y_{2} | x\right)=\frac{\exp \left(r^{*}\left(x, y_{1}\right)\right)}{\exp \left(r^{*}\left(x, y_{1}\right)\right)+\exp \left(r^{*}\left(x, y_{2}\right)\right)} \tag{17}$$ - 将式(17)代入式(18),论文得到最终的偏好模型:

$$p^{*}\left(y_{1} \succ y_{2} | x\right)=\frac{1}{1+\exp \left(\beta\left[\log \frac{\pi^{*}\left(y_{2} | x\right)}{\pi_{r e f}\left(y_{2} | x\right)}-\log \frac{\pi^{*}\left(y_{1} | x\right)}{\pi_{r e f}\left(y_{1} | x\right)}\right]\right)}$$ - 这个表达式将成对的人类偏好概率与最优策略 \(\pi^{*}\) 和参考策略 \(\pi_\text{ref}\) 的比率联系起来

- 偏好 \(y_{1}\) 胜过 \(y_{2}\) 的概率由下式给出

Training Details of DPO

- 直接偏好优化框架建立在两个核心模型之上:参考策略 \(\pi_\text{ref}\) 和目标策略 \(\pi_\text{tar}\)

- 参考策略通常是一个经过预训练和监督微调的语言模型,在整个训练过程中保持固定

- 相比之下,目标策略从 \(\pi_\text{ref}\) 初始化,并使用基于偏好的反馈进行迭代更新,从而更好地与人类判断保持一致

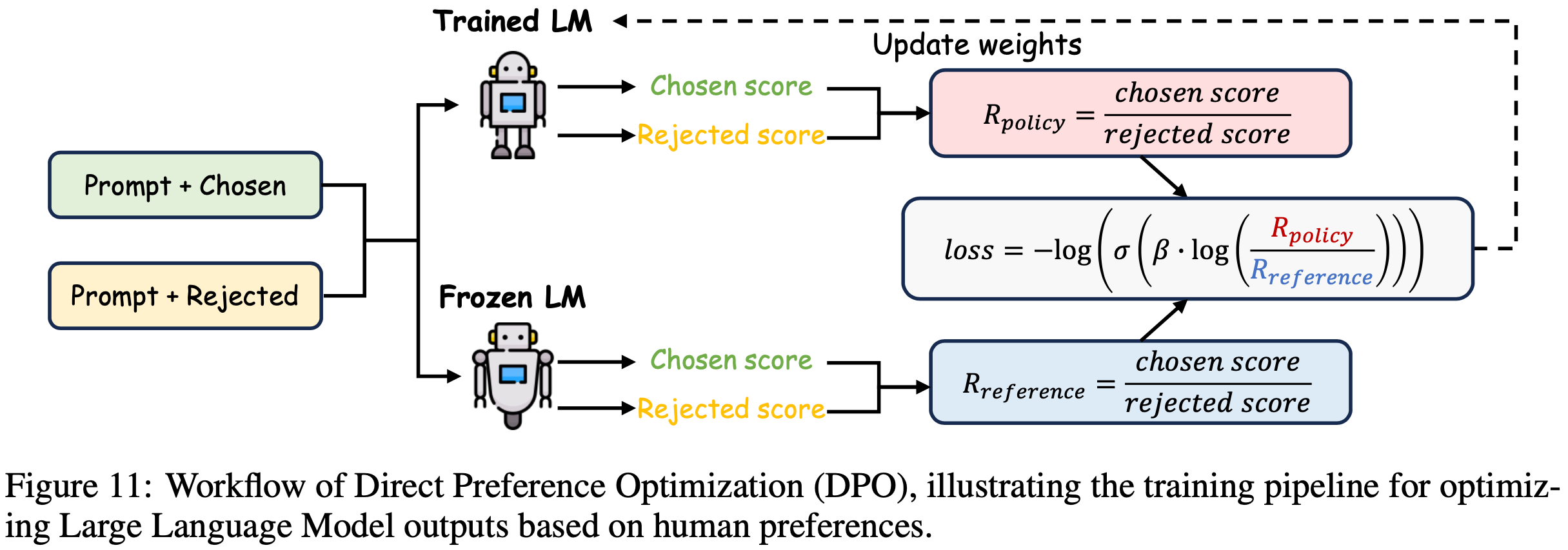

- 图11描述了这个整体流程

- 数据收集和准备 :直接偏好优化依赖于一个精心挑选的偏好数据集,该数据集是通过为每个提示 \(x\) 从 \(\pi_\text{ref}\) 中采样多个候选响应获得的

- 然后,人类标注者根据连贯性、相关性和清晰度等标准对这些响应进行比较或排序

- 由此产生的偏好标签作为优化 \(\pi_\text{tar}\) 的核心训练信号

- 训练过程 :通过一系列基于梯度的更新来优化目标策略,旨在最小化损失 \(L_{DPO}\) ,具体来说:

- 1)生成: \(\pi_\text{ref}\) 为每个提示 \(x\) 生成候选输出;

- 2)标注:人类标注者比较生成的输出,确定它们的相对偏好;

- 3)优化:利用这些成对的偏好,\(\pi_\text{tar}\) 被迭代更新,以更好地模仿人类偏好的输出

- 在整个过程中,\(\pi_\text{ref}\) 保持不变,为衡量改进提供了一个稳定的基线

- 实际考虑因素 :选择一个稳健的参考策略通常对有效初始化直接偏好优化至关重要

- 监督微调通常会为 \(\pi_\text{ref}\) 产生一个性能良好的基线,确保后续基于偏好的更新可以专注于优化,而不是基本技能的获取

- 理解:SFT 注入知识或技能,DPO 仅仅专注策略优化,而不是基本技能的学习

- 此外,偏好数据必须足够多样化,以捕捉用户期望的变化,从而促进模型的适应性并防止在定义狭窄的任务上过拟合

- 监督微调通常会为 \(\pi_\text{ref}\) 产生一个性能良好的基线,确保后续基于偏好的更新可以专注于优化,而不是基本技能的获取

Variants of DPO

- 已经出现了多种直接偏好优化的变体,以解决特定的对齐挑战并优化文本生成的不同方面

- 表2概述了这些方法,范围从 Token-level 生成优化到控制冗长性以及处理列表式或负面偏好

- 用于优化生成的直接偏好优化(DPO for Optimizing Generation) :Token-level DPO 和 iterative DPO 策略有助于更细粒度或持续地与人类偏好保持一致

- token-level DPO(2024)被重新表述为一个老虎机问题,采用由 \((S, A, f, r, \rho_{0})\) 定义的马尔可夫决策过程(Markov Decision Process, MDP)

- 这种方法减轻了诸如不受欢迎的标记的过度 KL 散度等挑战

- TDPO(2024)应用顺序前向 KL 散度而不是反向 KL 散度,同时改进了文本生成中的对齐和多样性保留

- Iterative DPO(2024)采用多轮方法,通过重复的偏好评估(通常由模型本身执行)来持续优化输出

- 成对厌恶优化(Pairwise Cringe Optimization, PCO)(2024)通过使用软边际来平衡探索和利用,将二元反馈扩展到成对设置

- Step-wise DPO(2024)对偏好数据集进行分区,并应用迭代更新,将每一轮的更新策略作为下一轮的基线

- token-level DPO(2024)被重新表述为一个老虎机问题,采用由 \((S, A, f, r, \rho_{0})\) 定义的马尔可夫决策过程(Markov Decision Process, MDP)

- 可控和灵活的直接偏好优化(Controllable and Flexible DPO) :一些直接偏好优化变体旨在管理冗长性并减少对固定参考策略的需求

- R-DPO(2024)通过目标函数中的正则化项惩罚输出长度,解决过度冗长或冗余的响应

- SimPO(2024)通过归一化响应长度并简化损失函数以处理期望和不期望的输出,消除了对参考策略的需求

- RLOO(2024)利用 REINFORCE 算法而不训练价值模型,大大减少了计算开销(问题:RLOO 算是 DPO 变体?)

- 它将整个响应视为单个动作,并从稀疏奖励中学习,与传统的基于 PPO 的方法相比,简化了实现

- Listwise DPO :列表式直接偏好优化方法不是将偏好数据限制为成对比较,而是对输出集进行优化

- LiPO(Listwise Preference Optimization, 列表式偏好优化)(2024)直接在候选响应的排序列表上应用学习排序技术,相对于重复的成对比较提高了效率

- RRHF(2023)将偏好对齐整合到监督微调中,消除了对单独参考模型的需求

- PRO(2024)将列表式偏好分解为更简单的二元任务,简化了监督微调期间的对齐

- Negative DPO :某些任务需要从不受欢迎或有害的输出中学习:

- NN(Negating Negatives, 否定负面)(2024)丢弃正面响应,并最大化与较不受欢迎的输出的差异

- NPO(Negative Preference Optimization, 负面偏好优化)(2024)对负面偏好应用梯度上升,有效减少有害输出并减轻灾难性崩溃

PoLMs for Reasoning

- 推理是使 LLM 能够处理涉及多步逻辑、复杂推理和复杂决策任务的核心支柱

- 本章探讨两种增强模型推理能力的核心技术:

- Self-Refine for Reasoning(5.1节),它指导模型自主检测并纠正自身推理步骤中的错误;

- Reinforcement Learning for Reasoning(5.2节),它采用基于奖励的优化来提高模型 CoT 的一致性和深度。这些方法共同使模型能够更稳健地处理长期决策、逻辑证明、数学推理和其他具有挑战性的任务

Self-Refine for Reasoning

- 在优化大语言模型以处理需要复杂逻辑推理和依赖上下文的决策任务时,推理仍然是一个核心挑战

- 在这种情况下,Self-Refine 作为一种强大的机制出现,它能在文本生成过程中或生成后迭代地找出并纠正错误,从而显著提高推理深度和整体可靠性

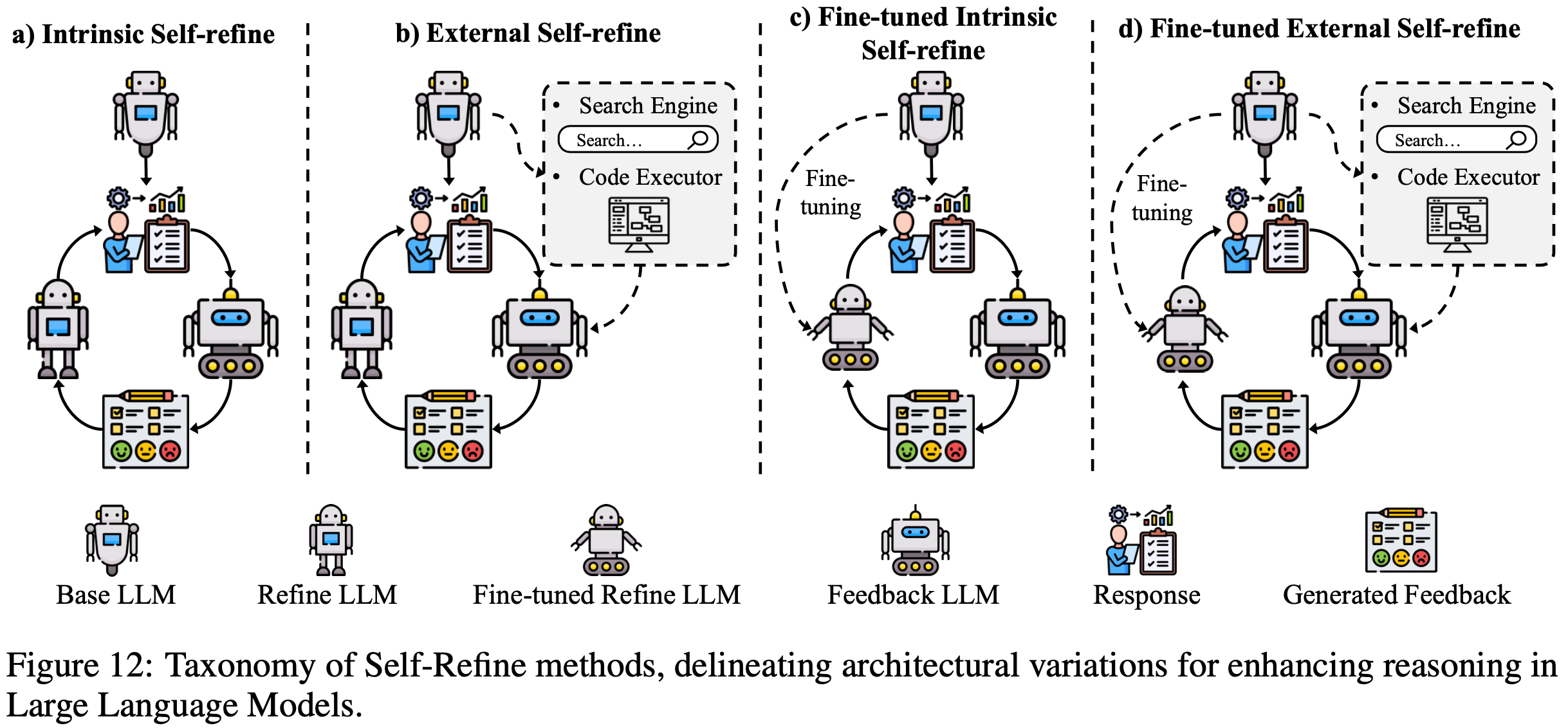

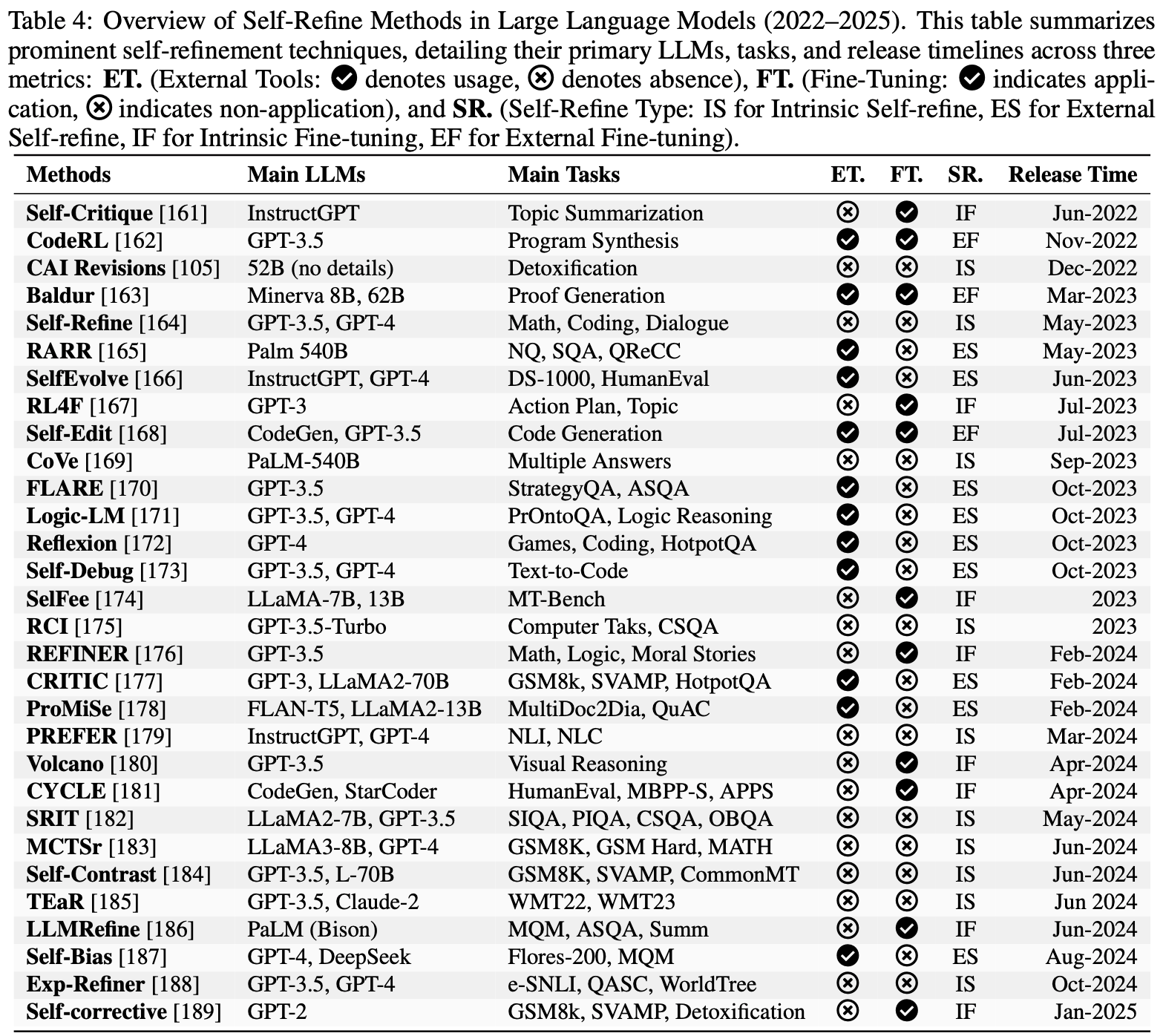

- 如图12所示, Self-Refine 方法可分为四类:

- 内在 Self-Refine (Intrinsic Self-refine),它依赖模型内部的推理循环;

- 外在 Self-Refine (External Self-refine),它整合外部反馈资源;

- 微调内在 Self-Refine (Fine-tuned Intrinsic Self-refine),它基于自我生成的修正迭代更新模型的推理过程;

- 微调外在 Self-Refine (Fine-tuned External Self-refine),它利用外部信号和微调以更具适应性、更长期的方式优化推理

- 表4进一步说明了每类方法如何增强大语言模型在各种任务中的推理能力

Intrinsic Self-Refine

- Intrinsic Self-Refine 方法专注于使模型自身能够在不借助外部工具的情况下检测并修正错误

- RCI 提示(RCI Prompting)(2024)仅在识别到矛盾或错误时才触发修正,避免对微小的不确定性反应过度

- CAI修订(CAI Revisions)(2022)纠正不良输出(如攻击性文本),同时教会模型自我调节其响应

- Self-Refine(2024)利用从低质量提示到高保真指令的转变,优化中间逻辑以提高一致性

- CoVe(2023)通过将多答案问题分解为子任务来处理这类问题,每个子任务都经过单独验证,以确保整个推理链的精确性和一致性

- 弱到强泛化(Weak-to-Strong Generalization, W2SG)方法利用先进算法,使强大的学生模型能够从能力较弱的教师模型产生的含噪声演示中有效学习(2023)

- 该框架在不同领域已有多项重要发展和应用

- 最近的研究通过各种创新增强了弱到强泛化。例如

- 集成学习技术已成功应用于提高弱到强泛化方法的稳健性和有效性(2024)

- (2024)采用弱到强外推来增强大语言模型的对齐

External Self-Refine

- External Self-Refine 方法涉及利用外部反馈源或计算工具来指导和纠正模型的推理

- CRITIC(2024)系统地检查分步输出,提高复杂推理任务的可靠性

- Reflexion(2024)和自我调试(Self-Debug)(2023)分别将生成的答案与参考解决方案或少样本示例进行比较,迭代优化逻辑

- 像 FLARE(2023)和 Logic-LM(2023)这样的技术整合来自外部文档或符号求解器的参考,从而最大限度地减少逻辑失误

- RARR(2022)和 SelfEvolve(2023)表明,验证中间状态(如编译器消息或相关知识源)是一种有效的方法,可及早修剪错误路径并引导模型找到正确解决方案

- (2024)提出了基于人类反馈的迭代偏好学习,包括用于在线场景的直接偏好优化(Direct Preference Optimization, DPO)算法的迭代版本,以及用于离线场景的多步拒绝采样策略

- PIT(2024)从人类偏好数据中间接学习改进目标

Fine-tuned Intrinsic Self-refine

- 通过专门针对内部修订(internal revision)对基础模型进行微调,Fine-tuned Intrinsic Self-refine 方法系统地加强大语言模型的自我纠正循环

- 自我批判(Self-Critique)(2022)旨在通过自我审查改进摘要

- SelFee(2023)使用迭代反馈循环确保更高水平的逻辑一致性

- Volcano(2024)通过在大语言模型架构中微调专用的校正模块来减少多模态幻觉

- RL4F(2023)利用基于强化学习的批判循环,在需要深入推理的基准测试中平均提高 10% 的性能

- REFINER(2024)同样专注于中间推理路径,而不改变模型原始的生成过程,这表明通过训练模型仔细重新检查其部分输出,可以实现持续的改进

- 易到难泛化(easy-to-hard generalization)作为弱到强泛化的一种有前景的变体出现,其中模型首先在易于验证的示例上训练,然后再处理更复杂的任务(2024)

- 这种方法的一个显著实现是在人类可验证的示例上训练强大的奖励模型,该模型随后指导在具有挑战性的任务上对更强大的模型进行监督(2024)

- 此外,弱到强泛化的有效性不仅限于大语言模型,在计算机视觉任务中也有成功应用(2024)

Fine-tuned External Self-refine

- Fine-tuned External Self-refine 方法下,在需要长期改进的场景中,模型的参数通过外部反馈机制进行更新。例如:

- 自我编辑(Self-Edit)(2023)基于执行结果重新生成代码输出,从而实现正确性的迭代改进

- Baldur(2023)通过添加或修改上下文来加强定理证明

- CodeRL(2022)采用基于测试的批判来验证程序合成任务中的功能准确性

- 总之,这些技术表明,将外部资源与有针对性的微调相结合,有助于在模型的整体推理性能方面实现可靠的、逐步的进步

Reinforcement Learning for Reasoning

- 在5.1节中,论文探讨了 Self-Refine 方法,这是一种通过局部调整和优化来提高大语言模型推理能力的广泛使用的方法

- 这种技术通常应用于单步任务或输出优化,如文本生成和问答,可快速提升推理效果;但对于需要多步逻辑的复杂、长期推理任务,它却难以胜任

- OpenAI 的 o1 系列(2024)的发布凸显了 RL 作为一种强大的替代方案,它通过基于奖励的反馈优化长内部思维链,训练大语言模型进行高级推理

- 这显著提高了在数学证明和战略规划等复杂任务中的性能

- o1 的成功推动了对大规模强化学习的研究,像 QwQ-32B-Preview(2023)在数学和编程方面表现出色,DeepSeek-R1(2025)则与 o1 的能力相当

- 本小节探讨强化学习在增强推理方面的作用,重点介绍领先的开源模型 DeepSeek-R1 和 DeepSeek-R1-Zero

Formulating Reasoning as an MDP

- 大语言模型中的推理可以巧妙地建模为一个顺序决策过程,其中模型为响应输入查询 \(x\) 迭代构建一系列中间步骤 \(a_{1}, a_{2}, …, a_{T}\),以优化得出正确最终答案的可能性

- 这种概念化将推理转变为适合强化学习的结构化框架,具体而言,是通过马尔可夫决策过程(Markov Decision Process, MDP)的视角,记为 \(M=(S, A, P, R, \gamma)\)

- 马尔可夫决策过程包含状态、动作、转移、奖励和时间折扣的动态相互作用,为训练大语言模型处理复杂推理任务提供了坚实的数学基础

- 通过将推理构建为一系列深思熟虑的选择,这种方法使模型能够系统地探索和优化其逻辑路径,这与游戏或机器人等领域的决策制定类似,但又适应了语言和概念推理的独特挑战

- 最终目标是推导出一个最优策略 \(\pi^{*}(a_{t} | s_{t})\),该策略最大化预期累积奖励,表示为

$$ J(\theta)=\mathbb{E}_{\pi_{\theta} }[\sum_{t = 1}^{T}\gamma^{t}R(s_{t}, a_{t})]$$ - 并利用诸如 PPO(2017)或 A2C(Advantage Actor-Critic,2016)等强化学习技术,基于环境反馈迭代增强推理能力

- 状态空间(State Space) :

- 状态空间 \(s\) 构成了这个马尔可夫决策过程的基础,每个状态 \(s_{t} \in S\) 表示时间步 \(t\) 的当前推理轨迹,它是语言和结构元素的丰富组合,对推理过程至关重要

- 具体而言,\(s_{t}\) 包括初始查询 \(x\) 、先前推理步骤序列 \(\{a_{1}, …, a_{t-1}\}\),以及编码逻辑依赖关系和中间结论(如部分解决方案或推断关系)的内部记忆表示

- 随着推理的展开,这个状态会动态演变,通过整合通过生成步骤明确表达的路径和从上下文理解中提取的潜在知识,反映思维的进展

- 例如,在数学证明中,\(s_{t}\) 可能包括问题陈述、先前推导的方程以及适用定理的记忆,使模型能够在各个步骤之间保持一致性

- 这种多方面的状态表示确保大语言模型能够自适应地跟踪其推理上下文,这是处理需要持续逻辑连续性的任务(如多步问题解决或文本生成中的叙事连贯性)的先决条件

- 动作空间(Action Space) :

- 动作空间 \(A\) 定义了每个步骤可能的决策范围,其中动作 \(a_{t} \in A\) 对应于下一个推理步骤的选择,为推进推理过程提供了多功能工具包

- 这些动作可能包括生成自然语言中的一个 Token 或短语来表达推理片段、应用预定义的逻辑或数学变换(如代数简化)、从知识库中选择相关定理或规则来扩展推理链,或者在得出结论性答案后终止过程

- 动作空间的性质因任务而异:

- 它可能是离散的(如在形式证明中从有限的逻辑规则集中选择)

- 也可能是连续的(如在开放式推理场景中生成自由形式的文本)

- 这反映了大语言模型的生成灵活性

- 这种双重性使模型能够处理结构化领域(如符号逻辑)和非结构化领域(如常识推理),根据任务需求调整其策略,同时保持朝向解决方案的连贯轨迹

- 转移函数(Transition Function) :

- 由函数 \(P(s_{t + 1} | s_{t}, a_{t})\) 封装的转移动态控制状态如何随每个动作演变,描述了马尔可夫决策过程框架内推理轨迹的进展

- 与传统强化学习环境中随机性来自外部变量(如环境噪声)不同,大语言模型中的推理转移主要是确定性的,由模型的自回归输出或结构化推理规则(如在证明中应用演绎步骤)驱动

- 然而,不确定性来自模型固有的局限性(如不完善的知识、模糊的中间状态或文本生成中的概率采样) ,这引入了强化学习必须解决的可变性

- 问题:如何理解这里的可变性?LLM 中动作即状态吧

- 对于自回归大语言模型,转移遵循可预测的序列生成过程,但错误累积或解释分歧的可能性使得需要稳健的设计来确保可靠性

- 这种确定性但不确定的动态强调了需要自适应策略,以在各种上下文中稳定推理,从精确的数学推导到微妙的叙事构建

- 奖励函数(Reward Function) :

- 奖励函数 \(R(s_{t}, a_{t})\) 作为马尔可夫决策过程的评估核心,为每个推理步骤的质量提供关键反馈,以指导模型的学习过程

- 与具有明确奖励(如游戏中的分数)的传统强化学习任务不同,推理奖励必须精心设计以平衡稀疏性和密集性,反映任务的复杂性和目标

- 稀疏奖励(如仅在得出正确最终答案时赋值)虽然简单,但在多步场景中可能会延迟学习;

- 密集奖励(评估步骤的正确性、逻辑有效性或与人类偏好的一致性)则提供细致的指导,如5.2.2节所述

- 这种灵活性使奖励函数能够适应各种推理需求,无论是奖励证明中有效推理规则的应用,还是叙事片段的连贯性,确保模型获得有意义的信号,以优化其在即时和扩展推理范围内的策略

- 折扣因子(Discount Factor) \(\gamma\) :

- \(\gamma \in[0,1]\) 是一个标量,它决定了即时奖励和未来奖励之间的权衡

- 较高的 \(\gamma\) 鼓励多步推理优化,促进深度推理链而非短期启发式

- 基于这种马尔可夫决策过程表述,目标是学习一个最优推理策略 \(\pi^{*}(a_{t} | s_{t})\),该策略最大化预期累积奖励:

$$J(\theta)=\mathbb{E}_{\pi_{\theta} }\left[\sum_{t = 1}^{T}\gamma^{t}R\left(s_{t}, a_{t}\right)\right]$$- 该框架使强化学习技术(如 PPO(2017)或 A2C(2016))能够应用于通过基于推理环境的反馈迭代调整策略 \(\pi_{\theta}\),从而优化大语言模型的推理能力

Reward Design for Reasoning

- 与具有明确奖励(如游戏分数)的传统强化学习任务不同,大语言模型中的推理需要结构化的奖励设计,以反映正确性、效率和信息量

- 常见方法包括:

- 二元正确性奖励,为正确的最终答案分配 \(r_{T}=1\),否则分配 \(r_{T}=0\),这种方法简单但由于反馈稀疏而引入高方差;

- 分步准确性奖励,基于推理规则有效性或中间步骤一致性等指标提供增量反馈,以指导多步推理;

- 自我一致性奖励,测量多个推理路径的稳定性,并为一致性高的情况分配更高奖励,以增强稳健性;

- 基于偏好的奖励,源自 RLHF 或 RLAIF,其中在人类或人工智能反馈上训练的模型 \(r_{\phi}(s_{t}, a_{t})\) 评估推理质量,为复杂任务提供细致的指导

Large-Scale RL on Base Model

- 大规模强化学习已成为一种变革性的后训练范式,用于增强大语言模型的推理能力,将重点从传统的监督微调转向动态的、自我进化的优化策略

- 这种方法利用广泛的计算框架和基于迭代奖励的反馈直接优化基础模型,绕过了对预标注数据集的需求,并使模型能够自主发展复杂的推理技能

- 通过整合大规模强化学习,大语言模型能够处理复杂的多步推理任务(如数学问题解决、逻辑演绎和战略规划),而传统的监督微调由于依赖静态的、人工整理的数据,在这些任务中往往表现不佳(2022)

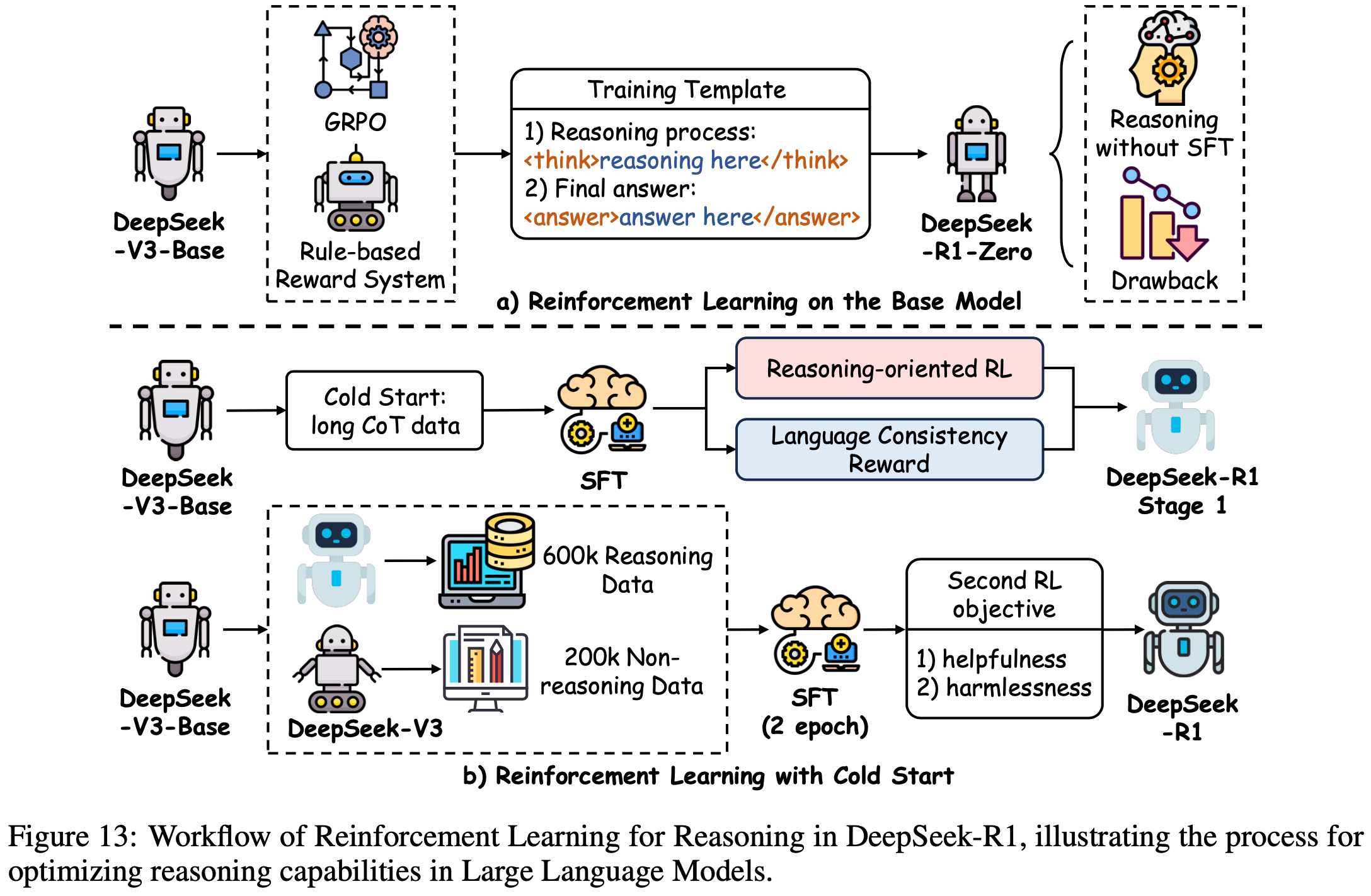

- DeepSeek-R1 模型就是这种范式的例证,它采用先进的强化学习技术实现了 SOTA 推理性能,同时优化了资源效率,如图13所示

- 本小节阐述支撑 DeepSeek-R1 成功的关键方法,包括新颖的优化算法、自适应探索和轨迹管理,这些共同重新定义了强化学习驱动的大语言模型推理的潜力

- GRPO :

- DeepSeek-R1-Zero 模型利用 PPO 的一种复杂变体,称为 GRPO ,以减轻大语言模型传统强化学习训练中固有的大量计算和资源需求

- 与依赖大量评论家网络的标准 PPO 不同,组相对策略优化采用基于组的基线估计来简化优化过程,在保持策略更新稳健性的同时显著减少训练开销

- 这种效率使大规模强化学习能够部署在资源受限的系统上,促进跨扩展轨迹的推理策略的迭代优化

- 通过在可管理的计算范围内优化策略,组相对策略优化使 DeepSeek-R1-Zero 成为增强推理能力的可扩展解决方案,如图13所示,使其成为当代强化学习驱动的推理研究的基石

- DeepSeek-R1-Zero :

- DeepSeek-R1-Zero 体现了大规模强化学习在提升大语言模型推理方面的变革潜力,它不依赖传统的监督微调作为初始步骤,而是采用纯强化学习驱动的自我进化范式

- 这种方法使模型能够通过基于奖励反馈迭代优化其内部思维链,自主发展复杂的推理技能,绕过了监督微调通常所需的预 标注数据集

- 其结果是在复杂的多步推理任务(如数学问题解决和逻辑推导)中性能显著提升,这表明强化学习有能力从基础模型中解锁高级推理能力

- 作为最强大的开源推理模型之一,DeepSeek-R1-Zero 的成功凸显了冷启动强化学习策略的可行性,它提供了一种资源高效的传统训练 Pipeline 替代方案,同时达到与最先进基准相当的性能

- 分步奖励建模(Stepwise Reward Modeling) :

- 为了在轨迹 \(\tau=(s_{1}, a_{1}, …, s_{T}, a_{T})\) 中指导推理,DeepSeek-R1 采用分步奖励模型 \(f_{\theta}\),该模型在每个时间步提供细致的反馈,定义为 \(r_{t}=f_{\theta}(s_{t}, a_{t} | D_\text{reasoning})\),其中 \(D_\text{reasoning}\) 包含带有步骤级正确性标签的人工标注思维链序列

- 问题:DeepSeek-R1 没有使用分布奖励吧?不是使用的 GRPO 吗?

- 这种密集的奖励结构与稀疏的序列末尾奖励形成对比,它提供关于各个推理步骤质量的即时、可操作的见解,使模型能够精确微调其策略

- 通过利用专家精心整理的数据,奖励模型确保反馈与人类推理标准保持一致,促进扩展推理链的一致性和准确性,这是处理需要长期逻辑合成的任务的关键特征

- 为了在轨迹 \(\tau=(s_{1}, a_{1}, …, s_{T}, a_{T})\) 中指导推理,DeepSeek-R1 采用分步奖励模型 \(f_{\theta}\),该模型在每个时间步提供细致的反馈,定义为 \(r_{t}=f_{\theta}(s_{t}, a_{t} | D_\text{reasoning})\),其中 \(D_\text{reasoning}\) 包含带有步骤级正确性标签的人工标注思维链序列

- 自适应探索(Adaptive Exploration) :

- DeepSeek-R1 通过整合到其目标中的自适应探索机制增强策略优化:

$$\begin{aligned}\mathcal{L}_\text{PPO+}=&\mathbb{E}_{\tau}\left[min \left(\frac{\pi_{\phi}(a | s)}{\pi_{old}(a | s)}A_{t}, clip\left(\frac{\pi_{\phi}(a | s)}{\pi_{old}(a | s)}, 1-\epsilon, 1+\epsilon\right)A_{t}\right)\right] \&+\lambda_{t} \mathcal{H}\left(\pi_{\phi}(\cdot | s)\right),\end{aligned}$$- 其中熵项 \(H\) 由自适应系数 \(\lambda_{t}=\alpha \cdot \exp (-\beta \cdot \operatorname{Var}(R(\tau_{1: t})))\) 调节,该系数根据轨迹上的奖励方差动态调整。这种方法平衡了探索和利用,鼓励模型在训练早期探索多样化的推理路径,同时在方差减小时收敛到最优策略,从而提高推理优化的稳健性和效率

- DeepSeek-R1 通过整合到其目标中的自适应探索机制增强策略优化:

- 轨迹剪枝(Trajectory Pruning) :

- 为了优化推理过程中的计算效率,DeepSeek-R1 实现了双注意力评论家 \(V_{\psi}(s_{t})=\text{LocalAttn}(s_{t})+\text{GlobalAttn}(s_{1: t})\),它通过结合局部步骤评估和全局轨迹上下文来评估每个状态的价值

- 当 \(V_{\psi}(s_{t})<\gamma \cdot \max_{k \leq t} V_{\psi}(s_{k})\) 时进行剪枝,终止低价值推理路径,将资源集中在有前景的轨迹上

- 这种机制减少了无效探索,加速了收敛,并确保模型优先考虑高质量推理序列,这有助于其在复杂推理任务中表现出色

RL for Reasoning with Cold Start

- DeepSeek-R1-Zero 通过采用冷启动方法进一步推进了强化学习的应用,它避开了监督微调,完全依赖于从未训练的基础模型进行大规模强化学习

- 这种自我进化策略通过迭代反馈优化推理,生成稳健的思维链序列,而不依赖预标注数据

- 通过直接在推理任务上训练,DeepSeek-R1-Zero 展示了强化学习的多功能性,其性能与从监督微调整开始的模型(如其对应模型DeepSeek-R1)相当甚至更优

- 这种方法不仅减少了对大量标记数据集的依赖,还展示了强化学习自主发展复杂推理能力的潜力,为未来大语言模型的发展提供了一种可扩展的范式

- 总之,强化学习为增强推理提供了一个有前景的框架,有效的奖励设计、策略优化(如组相对策略优化)和探索策略仍然至关重要

- 未来的研究可以探索结合模仿学习或自监督目标的混合方法,以进一步优化这些能力,巩固强化学习在推进大语言模型推理方面的作用

PoLMs for Efficiency

- 基于前面章节讨论的后训练优化技术,后训练的效率专门针对 LLM 在初始预训练后的运行性能

- 其主要目标是优化关键的部署指标(例如处理速度、内存使用和资源消耗),从而使大语言模型在实际应用中更具实用性

- 实现后训练效率的方法主要分为三类:

- 模型压缩(Model Compression,6.1节),通过剪枝和量化等技术来降低整体计算负担;

- 参数高效微调(Parameter-Efficient Fine-Tuning,6.2节),仅更新模型的部分参数或采用专门的模块,从而最小化重新训练的成本并加速对新任务的适应;

- 知识蒸馏(Knowledge Distillation,6.3节),将知识从较大的预训练模型转移到较小的模型,使较小的模型能够在减少资源需求的情况下实现可比的性能

Model Compression

- 模型压缩包含一系列旨在减小大语言模型的规模和计算需求的技术,其中包括后训练量化、参数剪枝和低秩近似

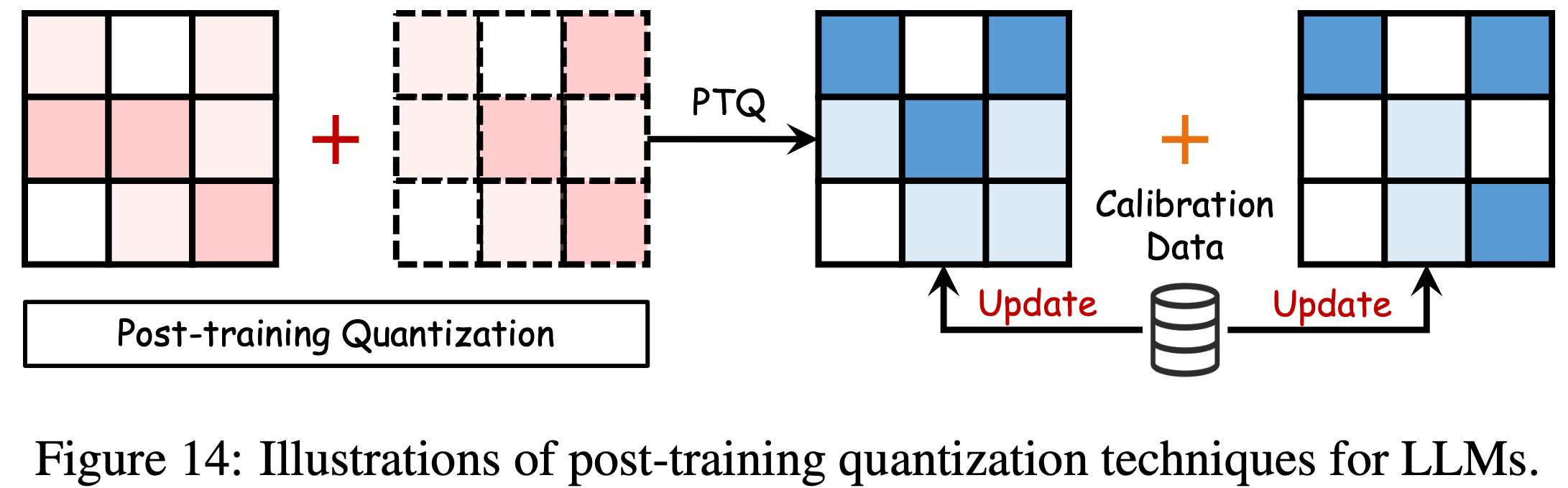

Post-training Quantization

- 大语言模型的一种关键压缩方法是量化,它将高精度数据类型 \(X^{H}\)(30位浮点数)转换为低精度格式 \(X^{L}\)(8位整数)(2021)。这种转换可表示为:

$$\mathcal{X}^{L} = \text{Round}\left(\frac{\text{absmax}\left(\mathcal{X}^{L}\right)}{\text{absmax}\left(\mathcal{X}^{H}\right)} \mathcal{X}^{H}\right)=\text{Round}\left(\mathcal{K} \cdot \mathcal{X}^{H}\right)$$- 其中 \(\mathcal{K}\) 代表量化常数,\(\text{absmax}\) 指元素的绝对最大值

- 函数 \(\text{Round}\) 将浮点数转换为整数

- 大语言模型的量化包括后训练量化(post-training quantization,PTQ)和量化感知训练(quantization-aware training,QAT)

- 后训练量化允许在预后训练调整模型的权重和激活值,使用一个小的校准数据集来优化计算效率和性能,如图14所示

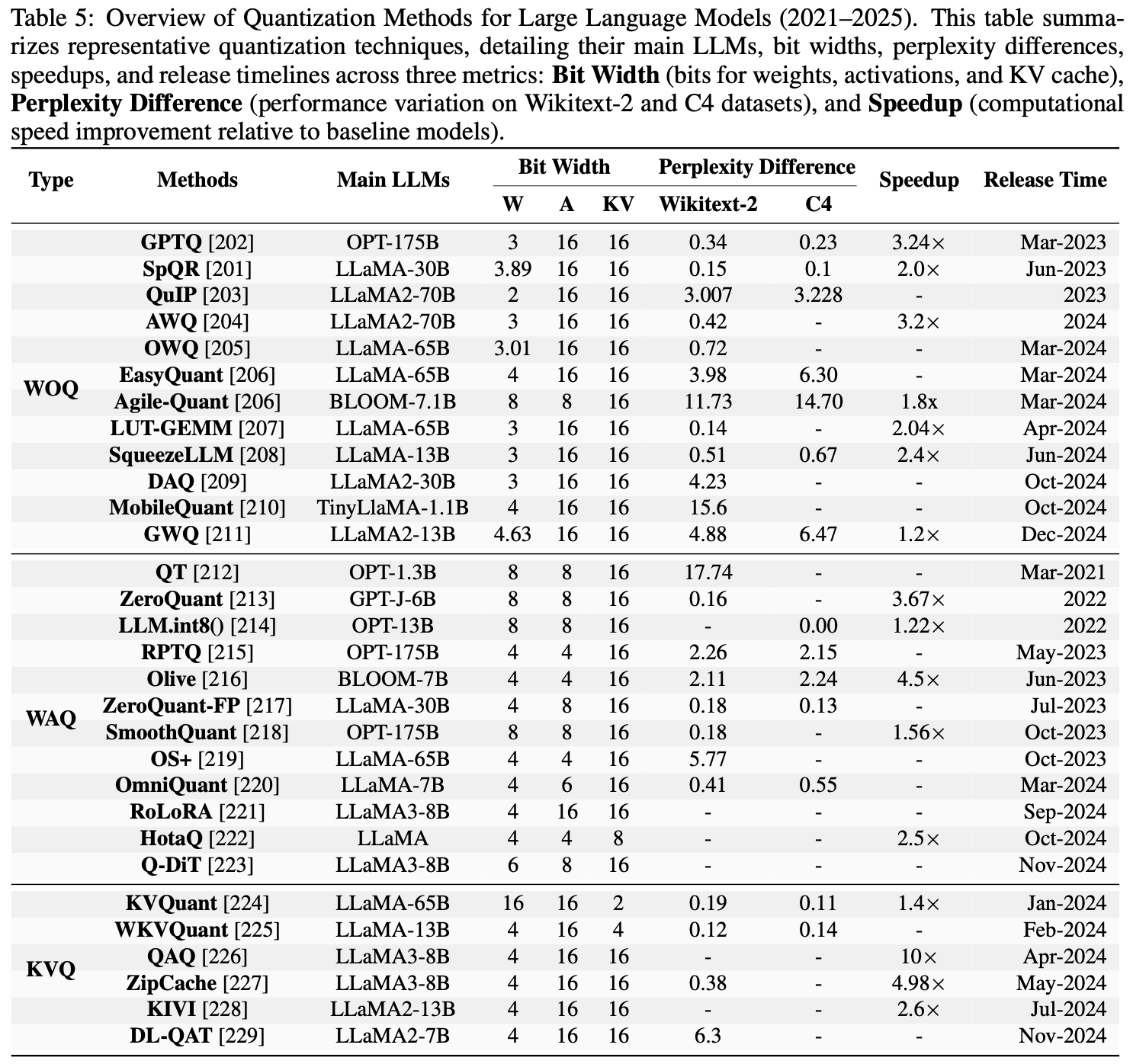

- 此外,表5展示了几种著名的大语言模型量化方法的性能指标

- 仅权重量化(Weight-Only Quantization, WOQ) :仅权重量化专注于压缩模型权重以提高效率

- GPTQ (2023) 使用最优脑量化(Optimal Brain Quantization, OBQ)进行逐层量化,将权重降低到 3 或 4 比特,以减少内存使用和处理时间

- QuIP (2024) 引入了用于2比特量化的非相干处理,提供了更紧凑的表示,进一步提高了效率

- AWQ (2024) 和 OWQ (2024) 通过对特别敏感的权重保持高精度来解决精度保留问题,从而最小化推理过程中可能的精度损失

- SpQR (2023) 将稀疏量化与解码相结合,实现了高效的 token-by-token 推理,同时保持模型的响应能力

- 权重-激活值联合量化(Weight-Activation Co-Quantization, WAQ) :权重-激活值联合量化将权重和激活值结合起来以提高效率

- LLM.int8() (2022) 使用精确存储来处理激活值异常值,并量化为 8 比特,同时保持性能

- SmoothQuant (2023) 实现了每通道缩放,将量化难度从激活值转移到权重,以实现无损结果

- OS+ (2023) 通过通道移位和缩放减轻了异常值的影响,从而提高了效率

- OmniQuant (2024) 将量化障碍从激活值转移到权重,并对极值的裁剪阈值进行微调

- RPTQ (2023) 对相似通道进行分组,以确保量化参数的一致性(进一步提高了效率)

- KV 缓存量化(KV-Cache Quantization, KVQ) :KV 缓存量化解决了大语言模型中的内存优化挑战,特别是随着输入 Token 数量的增加

- KVQuant (2024) 引入了针对大上下文长度的高效推理的定制方法,在性能损失最小的情况下保持性能

- KIVI (2024) 通过对键和值缓存应用不同的量化策略来优化内存节省,实现了 2 比特量化而无需微调

- WKVQuant (2024) 进一步通过二维量化策略和跨块正则化对其进行了改进,提供了与权重-激活值量化相当的内存效率,且性能几乎相同

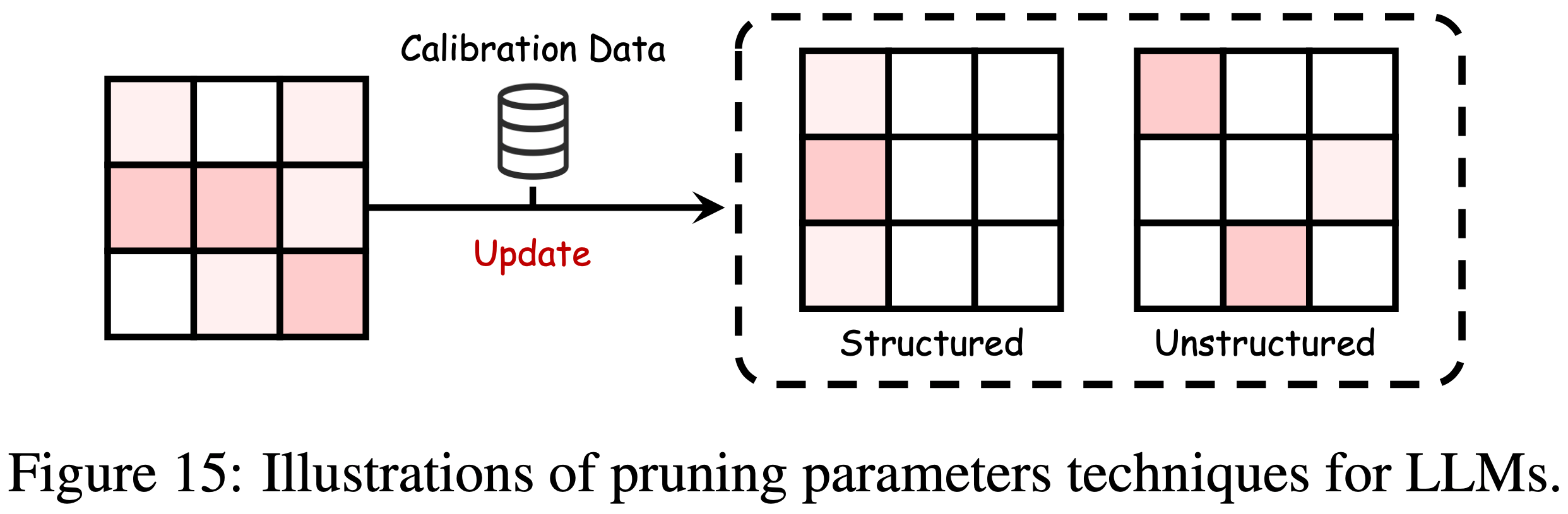

Parameter Pruning

- 参数剪枝 (2022) 是一种通过最小化模型大小和复杂性来提高大语言模型效率的关键技术,同时又不牺牲准确性

- 如图15所示,剪枝可分为非结构化剪枝和结构化剪枝

- 非结构化剪枝(Unstructured Pruning) :非结构化剪枝通过消除不重要的权重来提高大语言模型的稀疏性

- SparseGPT (2023) 方法通过单次剪枝实现了高达 60% 的稀疏性,同时保持最小的损失

- Wanda (2023) 方法基于权重大小和激活值进行剪枝,无需重新训练

- SAMSP (2024) 利用 Hessian 矩阵的敏感性进行稀疏性的动态调整,旨在最小化误差

- DSnoT (2024) 通过采用迭代剪枝周期来提高性能

- Flash-LLM (2023) 从全局内存中检索稀疏权重,并在片上缓冲区中将其密集重建,以促进高效计算

- 结构化剪枝(Structured Pruning) :结构化剪枝则侧重于剪枝大语言模型中的整个参数组 ,以提高硬件效率并简化结构

- LLM-runner (2023) 评估 LLaMA (2023) 的重要性,并使用 LoRA (2021) 在剪枝后恢复精度

- FLAP (2024) 使用结构化指标在不进行微调的情况下优化压缩

- SliceGPT (2024) 采用 PCA 进行剪枝,同时保持效率

- Sheared LLaMA (2023) 通过基于正则化的剪枝来优化模型形状

- LoRAPrune (2024) 通过基于 LoRA 重要性的迭代结构剪枝来提高效率

- Deja Vu (2023) 通过预测关键注意力头和 MLP 参数,利用上下文稀疏性来减少延迟,同时保持准确性

- 低秩近似(Low-Rank Approximation) :低秩近似通过用更小的矩阵 U 和 V 近似权重矩阵 W 来压缩大语言模型 ,从而实现 \(W \approx U V^{\top}\) 。这种方法不仅减少了参数数量 ,还提高了操作效率(enhances operational efficiency)

- TensorGPT (2023) 采用 TTD(Tensor-Train Decomposition)来开发更高效的嵌入格式

- LoSparse (2023) 将低秩近似与剪枝相结合,专门针对压缩相干神经元组件

- FWSVD (2022) 实现了加权 SVD 方法

- ASVD (2023) 提供了免训练的 SVD 替代方案

- FWSVD 和 ASVD 两者都以后训练效率为目标

- SVD-LLM (2024) 通过建立奇异值与压缩损失之间的直接关系进一步改进了压缩

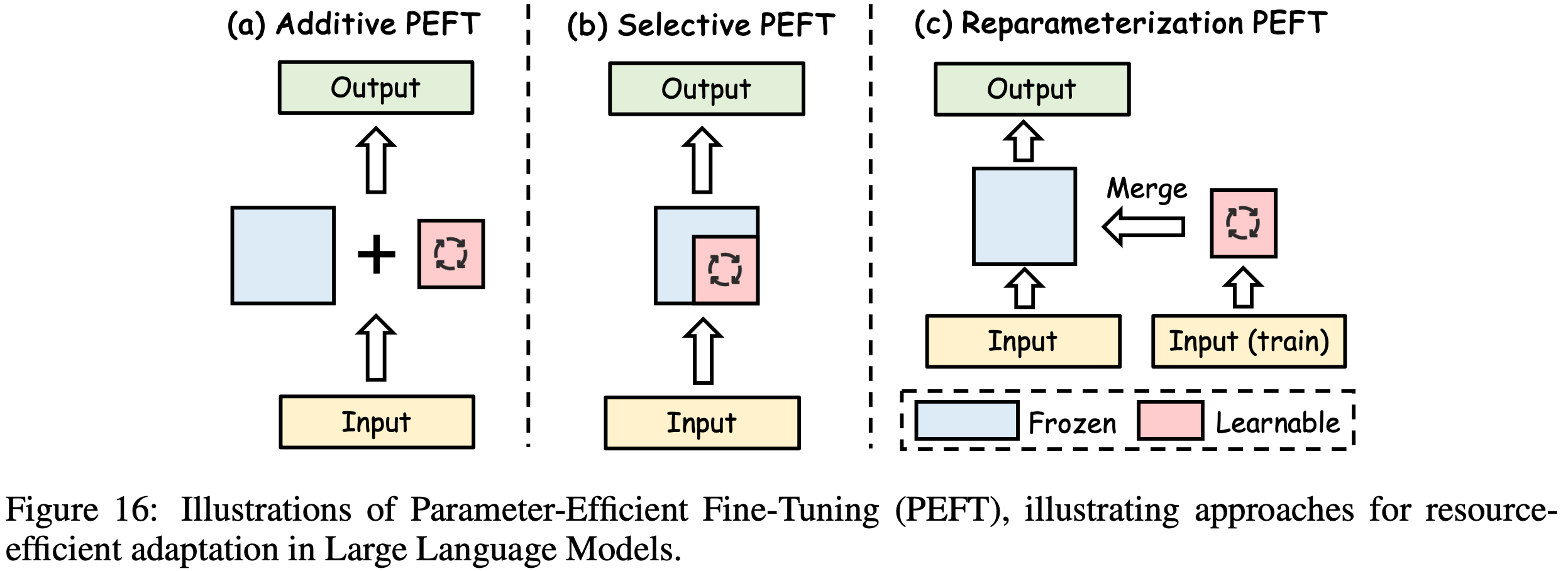

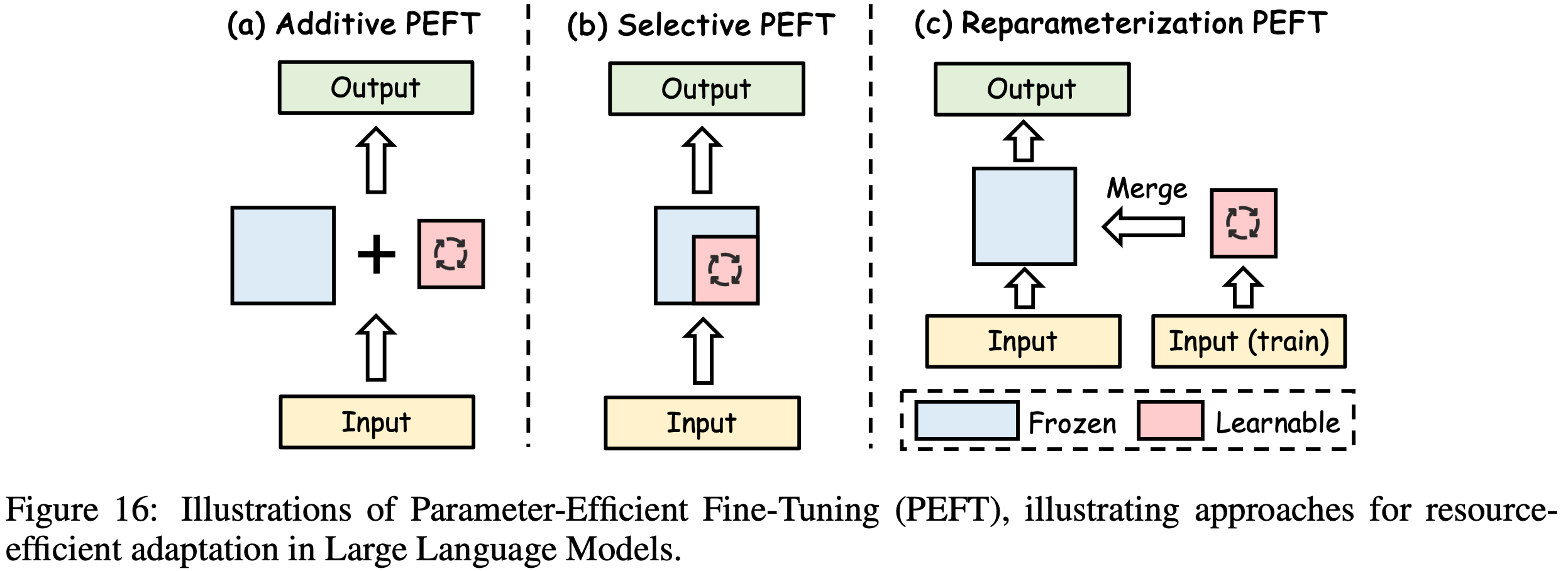

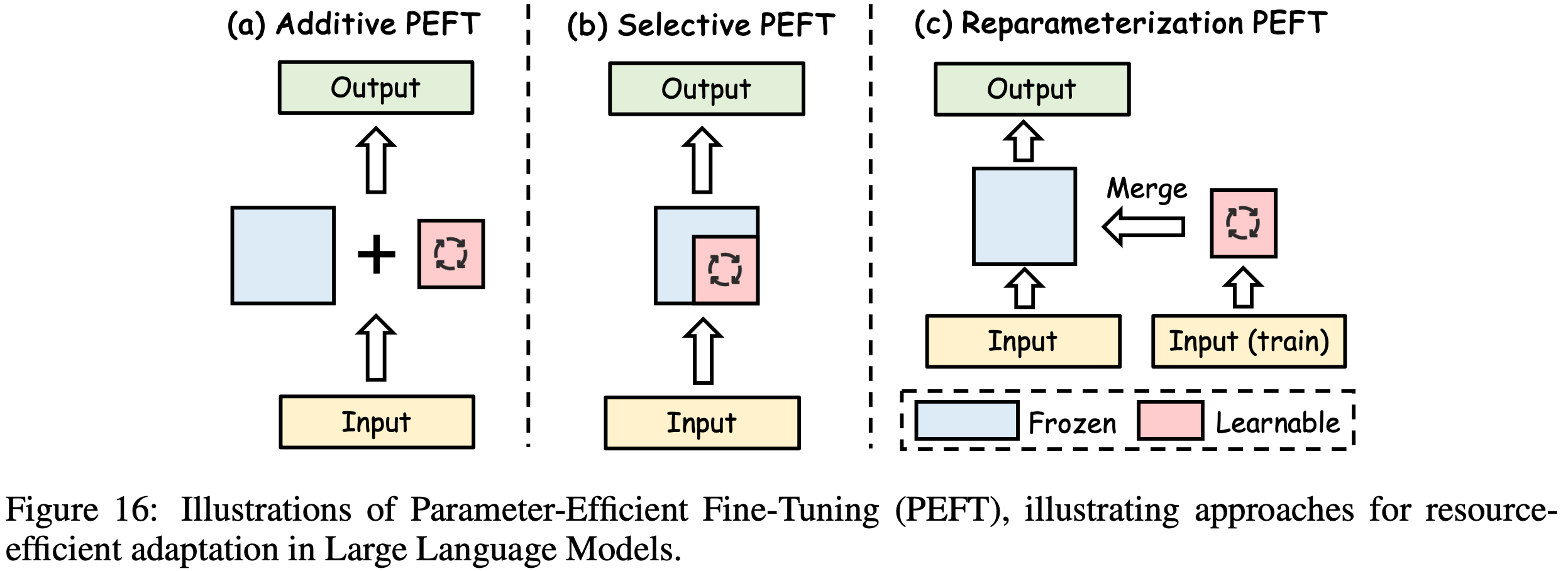

Parameter-Efficient Fine-Tuning

- 参数高效微调(PEFT)的过程包括冻结完整的大语言模型主干,同时只修改有限数量的新添加参数

- 如图16所示,PEFT 方法分为四类: Additive PEFT、Selective PEFT、Reparameterized PEFT 和 Hybrid PEFT

Additive PEFT

- Additive PEFT 将新的可训练模块整合到大语言模型中,而不改变原始参数,允许特定任务的微调,同时保留基础模型的知识,这对于微调是高效的

- 适配器(Adapters) :适配器在 transformer 块中集成紧凑层,定义为:

$$\text{Adapter}(x) = W_\text{up} \sigma\left(W_\text{down} x\right) + x$$- 其中,适配器层包括

- 下投影矩阵 \(W_\text{down} \in \mathbb{R}^{r \times d}\)

- 非线性激活函数 \(\sigma\)

- 上投影矩阵 \(W_\text{up} \in \mathbb{R}^{d \times r}\)

- 这里,\(d\) 是隐藏层维度,\(r\) 是瓶颈维度,在保持性能的同时降低复杂性

- 基于这种结构:

- Serial Adapter (2019) 在每个 transformer 块中引入了两个模块

- AdapterFusion (2020) 通过将适配器放置在 Add&Norm 之后来提高效率

- 并行适配器(Parallel Adapter, PA)(2021) 使适配器与子层并行运行

- CoDA (2023) 通过使适配器与子层并行运行来进行优化

- MerA (2023) 使用最优传输技术统一适配器的权重和激活值(这与 AdapterFusion 不同)

- 其中,适配器层包括

- 软提示(Soft Prompt) :软提示通过向输入序列添加可调整向量而不是优化离散 Token 来提高模型性能 (2023)。这种方法形式化为:

$$X^{(l)} = \left[s_{1}^{(l)}, …, s_{N_{S} }^{(l)}, x_{1}^{(l)}, …, x_{N_{X} }^{(l)}\right]$$- 其中:

- \(s_{i}^{(l)}\) 表示软提示 Token

- \(x_{i}^{(l)}\) 表示原始输入 Token

- \(N_{S}\) 和 \(N_{X}\) 分别是软提示和原始输入 Token 的数量

- Prefix Tuning (2021) 在 transformer 层之间引入可学习向量,通过重参数化来稳定,并通过 P-Tuning v2 (2021) 和 APT (2021) 进行改进

- Prompt Tuning (2021) 专注于初始嵌入层,以低计算成本优化大型模型

- Xprompt (2022) 和 IDPG (2022) 简化提示生成和插入

- SPoT (2021) 和 PTP (2023) 之类的方法解决了稳定性和收敛速度问题

- DePT (2023) 和 SMoP (2023) 通过优化的提示结构降低计算需求

- 其中:

- 其他 Additive 方法(Other Additive Methods) :

- 除了前面的技术外,诸如 \((IA)^3\) (2022) 和 SSF (2022) 之类的方法通过对模型参数进行最小但有效的调整来关注后训练效率

- 自注意力和 FFN 操作在数学上定义为:

$$SA(x) = \text{Softmax}\left(\frac{Q \cdot \left(l_{k} \odot K\right)^{T} }{\sqrt{d_{head} } }\right) \cdot \left(l_{v} \odot V\right) \\

FFN_\text{transformer}(x) = W_\text{up} \cdot \left(l_{ff} \odot \sigma\left(W_\text{down} x\right)\right)\tag{26;27}$$- \(\odot\) 表示哈达玛积

- 尺度向量 \(l_{k}\) 和 \(l_{v}\) 可以平滑地合并到 \(A_{Q}\) 和 \(A_{W}\) 的权重矩阵中

- IPA (2023) 使诸如 GPT-4 之类的大语言模型与用户特定需求保持一致

- IPA 不需要改变基础模型,因此在微调过程中保持效率

Selective PEFT

- Selective PEFT 通过仅微调参数的一个子集来提高效率 ,如图16(b)所示

- Selective PEFT 将二进制掩码 \(M = \{m_{1}, m_{2}, …, m_{n}\}\) 应用于参数 \(\theta = \{\theta_{1}, \theta_{2}, …, \theta_{n}\}\),其中每个 \(m_{i}\) 指示是否选择 \(\theta_{i}\) 进行微调

- 更新的参数集表示为:

$$\theta_{i}’ = \theta_{i} - \eta \cdot m_{i} \cdot \frac{\partial \mathcal{L} }{\partial \theta_{i} }$$- 其中,\(\eta\) 是学习率,\(\frac{\partial L}{\partial \theta_{i} }\) 是损失函数的梯度

- 只有选定的参数(其中 \(m_{i} = 1\) )会被更新,从而降低计算成本,同时保持有效性

- Diff pruning (2020),使用可微分的 \(L_{0}\)-范数来正则化可学习的二进制掩码

- FishMask (2021),基于 fisher 信息选择参数以提高相关性

- LT-SFT (2021) 将彩票假设(Lottery Ticket Hypothesis)应用于识别有影响力的参数

- 补充彩票假设(Lottery Ticket Hypothesis):其核心观点是,随机初始化的密集神经网络中存在一个稀疏子网络(“中奖彩票”),当单独训练该子网络时,性能可匹配甚至超越原网络

- SAM (2023) 采用二阶近似进行选择

- Child-tuning (2021) 在子网络中动态选择参数

- FAR (2022) 和 BitFit (2021) 专注于优化特定参数组

Reparameterized PEFT

- Reparameterized PEFT 主要采用低秩参数化来提高效率,如图16(c)所示

- LoRA(低秩适应)(2021) 引入两个可训练矩阵 \(W_\text{up} \in \mathbb{R}^{d \times r}\) 和 \(W_\text{down} \in \mathbb{R}^{r \times k}\),将输出修改为:

$$h_{out} = W_{0} h_{in} + \alpha \left(W_\text{up} W_\text{down} h_{in}\right)$$- 其中,\(\alpha\) 是缩放因子

- LoRA 允许有效地适应新任务,同时保留核心知识

- 在 LoRA 的基础上,还有许多工作有进一步的改进:

- Intrinsic SAID (2020) 最小化微调参数空间,进一步降低计算需求

- 动态变体(包括 DyLoRA (2022) 和 AdaLoRA (2023)),根据特定任务需求动态调整秩

- 其中,AdaLoRA 结合了基于 SVD 的剪枝以提高效率

- SoRA (2023) 通过去除正交性约束来简化过程

- Laplace-LoRA (2023) 应用贝叶斯校准进行微调

- Compacter (2021) 和 VeRA (2023) 进一步降低参数复杂性

- DoRA (2024) 优化方向分量的更新以提高效率和性能

- HiRA (2025) 采用哈达玛积进行高阶更新以提高效率和性能

- 为了处理多个任务和不断变化的领域:Terra (2024) 集成了时变矩阵,ToRA (2025) 利用 Tucker 分解进一步改进 LoRA 结构

- (除了结构设计外)PiSSA (2025) 和 LoRA-GA (2025) 使用 SVD 和梯度对齐优化 LoRA 的初始化

- LoRA+ (2024)、LoRA-Pro (2024) 和 CopRA (2024) 进一步完善梯度更新策略

- ComLoRA (2025) 采用竞争学习来选择性能最佳的 LoRA 组件

Hybrid PEFT

- Hybrid PEFT 方法通过整合或优化各种微调策略来提高后训练效率

- 一种著名的技术 UniPELT (2021) 在 transformer 块中融合了 LoRA、前缀调优和适配器

- 这种方法通过由前馈网络(FFN)管理的门控机制动态激活组件,这些前馈网络产生标量 \(G \in [0, 1]\),最终优化参数利用率

- 另一种创新方法 MAM Adapter (2021) 通过在自注意力层中战略性地放置前缀调优,并在馈送前层中使用缩放的并行适配器来改进此技术

- 基于 NAS 的方法(如 NOAH (2022) 和 AUTOPEFT (2024))通过识别为特定任务量身定制的最佳 PEFT 配置来提高后训练效率

- 神经架构搜索(Neural Architecture Search,NAS)是一种自动设计神经网络架构的技术,旨在通过算法自动找到最优或接近最优的神经网络架构,以优化特定任务的性能

- HeadMap (2025) 使用贪心方法识别在某些任务中起关键作用的一系列注意力头(即知识电路),并通过将这些注意力头的输出映射回大语言模型的残差流来有效地提高模型性能

- LLM-Adapters (2023) 提供了一个框架,用于在大语言模型中集成各种 PEFT 技术,确保最有效的模块放置,以在不同模型规模上保持效率

Knowledge Distillation

- 知识蒸馏(KD)是大语言模型后训练优化中的核心技术,能够将知识从大型预训练教师模型转移到紧凑的学生模型,以提高效率而不牺牲性能

- 知识蒸馏最初是在模型压缩的背景下引入的,由于其能够将复杂知识提炼到资源高效的架构中,使其能够部署在受限环境(如边缘设备和嵌入式系统)中,因此受到了广泛关注

- 通过利用教师模型的细微输出分布(比传统的硬标签更丰富),知识蒸馏使学生不仅能够复制类别预测,还能复制教师表示中包含的类间关系和细微模式

- 知识蒸馏过程通常涉及优化一个复合损失函数,该函数平衡监督学习目标和特定于蒸馏的目标,显著降低计算和内存需求,同时保留泛化能力

- 知识蒸馏的基本机制取决于最小化混合损失,该损失将传统分类损失与蒸馏项相结合。形式上,给定教师模型的软输出概率 \(p_{t}\) 和学生模型的预测 \(p_{s}\),以及真实标签 \(y\) 和学生输出 \(y_{s}\),知识蒸馏损失表示为:

$$\mathcal{L}_{K D} = \alpha \mathcal{L}_{C E}\left(y, y_{s}\right) + (1 - \alpha) \mathcal{L}_{K L}\left(p_{t}, p_{s}\right)$$- \(L_{CE}\) 表示捕获与真实标签对齐的交叉熵损失

- \(L_{KL}\) 表示测量教师和学生分布之间差异的 Kullback-Leibler 散度 (1951)

- \(\alpha \in [0, 1]\) 是调节这些目标之间权衡的超参数

- 软目标 \(p_t\) 通常通过温度参数 \(T\) 进行调整(即 \(p_{t} = \text{Softmax}(z_{t} / T)\)

- 其中 \(z_{t}\) 是教师 logits),编码更丰富的概率信息,使学生能够模仿教师的决策细微差别,而不仅仅是标签准确性

- 知识蒸馏广泛用于资源受限环境中的模型压缩和迁移学习,其中预训练教师指导特定任务的学生

- 知识蒸馏的有效性取决于教师能力、学生架构和蒸馏损失设计等因素

- 最近的进展将知识蒸馏扩展到输出蒸馏之外,使大语言模型在后训练优化中更高效和适应性更强

- 根据对教师模型内部参数和中间表示的访问级别,知识蒸馏方法大致可分为黑盒知识蒸馏和白盒知识蒸馏

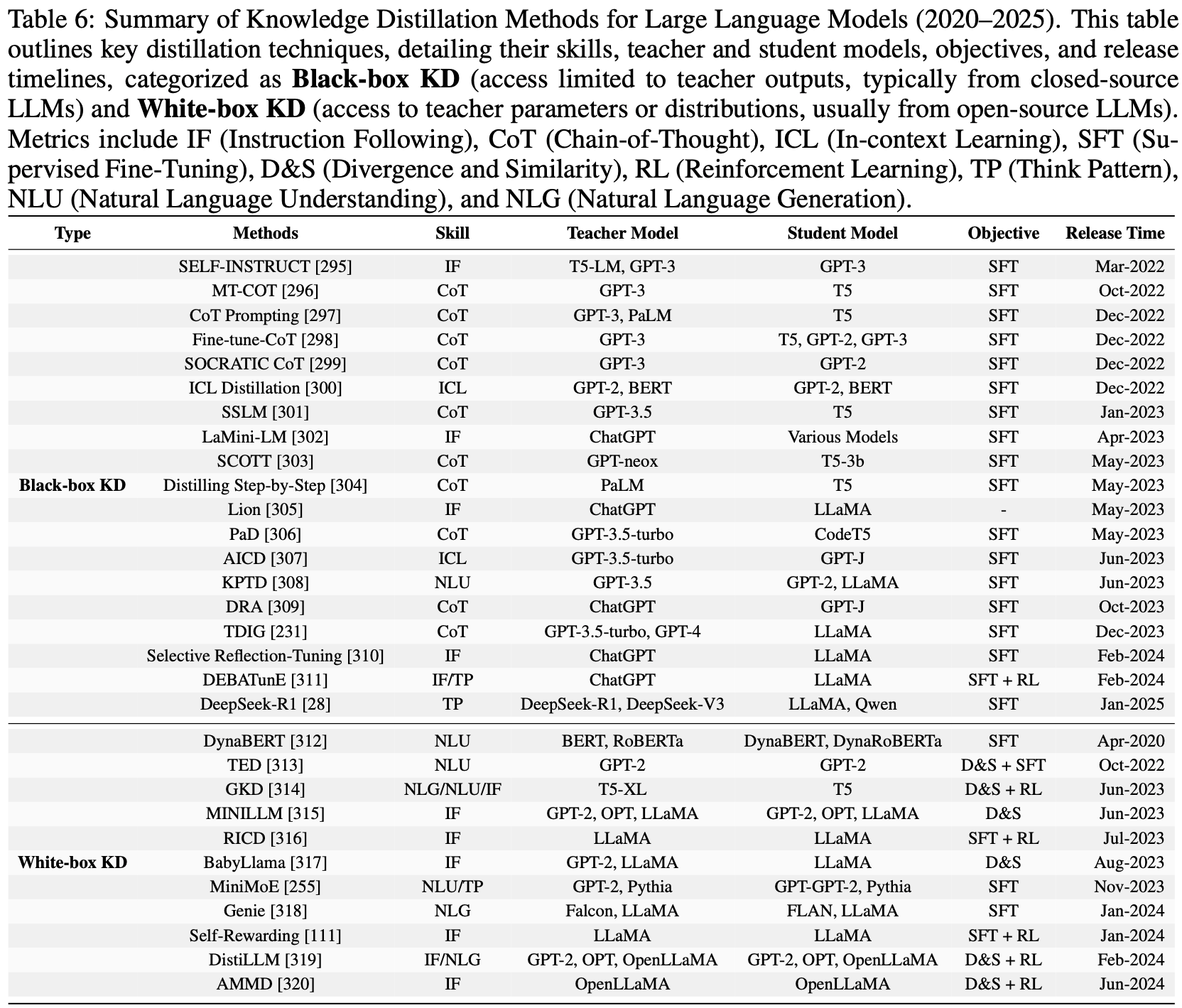

- 如表6所示,知识蒸馏方法大致可分为两类:黑盒知识蒸馏和白盒知识蒸馏

- 论文系统地总结了 LLM 中的各种知识蒸馏技术,以及它们相应的技能、教师模型和学生模型

Black-box KD

- 黑盒知识蒸馏是指学生模型仅从教师的输出 logits 中学习,而无法访问其内部表示或架构细节

- 黑盒知识蒸馏最初由 Hinton (2015) 提出,与经典的知识蒸馏范式一致,并且由于其灵活性而被广泛采用

- 黑盒知识蒸馏的一个关键优势是它将教师模型视为一个不透明的函数 ,即使教师是具有受限访问权限的专有模型或预训练模型,也能实现知识转移

- 在实践中:

- 教师模型通常用于生成高质量输出:例如 ChatGPT 和 GPT-4 (2023) 等

- 学生模型通常是较小的语言模型(smaller language models,SLM):包括 GPT-2 (2019)、T5 (2019)、Flan-T5 (2022) 和 CodeT5 (2021)

- 这些较小的语言模型针对效率进行了优化,同时保持强大的泛化能力,使其适合部署在资源受限的环境中

- 问题 :这里的定义是不是有问题,ChatGPT 也拿不到模型的 logits 吧,黑盒蒸馏 ChatGPT 是指蒸馏其最终文本输出而不是 logits?

- 回答 :黑盒知识蒸馏(Black-Box Knowledge Distillation)的真实定义是指在知识蒸馏过程中,学生模型无法直接访问教师模型的内部结构、参数、中间层输出或预 softmax 层的 logits ,只能通过教师模型的外部可观察输出(例如,最终的预测结果、生成的文本、或者通过 API 返回的概率分布)来学习

White-box KD

- 白盒知识蒸馏通过利用来自教师内部表示的额外 insight 扩展了传统的蒸馏范式

- 当教师模型的架构已知且可访问时,这种方法是有益的,允许更丰富的监督形式

- 白盒知识蒸馏与将教师视为不透明函数的黑盒知识蒸馏不同,白盒知识蒸馏允许学生模型不仅从教师的输出 logits 中学习,还可以从教师的中间激活、隐藏层,甚至注意力权重中学习 (2018)

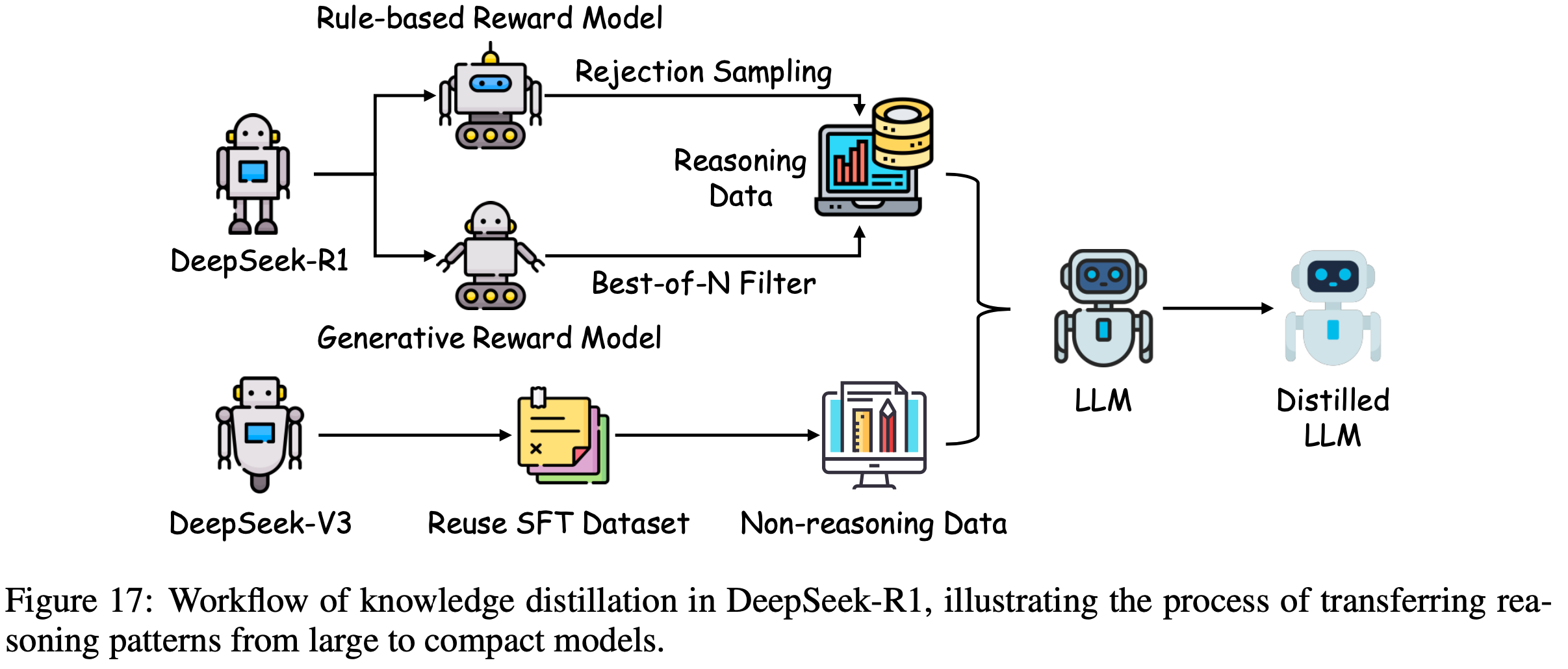

DeepSeek-R1: Direct Distillation of Reasoning Patterns

- 直接蒸馏(Direct Distillation) :DeepSeek-R1 通过将复杂的推理模式从大规模模型提炼到紧凑架构中,展示了知识蒸馏的变革潜力,显著增强了较小大语言模型的推理能力,而无需在这些模型上进行直接强化学习的计算负担

- DeepSeek-R1 利用由大型教师模型生成的大约 800K 个样本的精选数据集,其中包括来自 DeepSeek-V3 的 200K 个非推理实例和由 DeepSeek-R1-Stage1 检查点生成的 600K 个推理实例

- 这些样本构成了 SFT 的基础,并将其应用于开源基础模型(如 Qwen 和 LLaMA 小型变体),使学生模型能够继承通常只为更大模型保留的复杂推理能力

- 如图17所示,DeepSeek-R1 中的直接蒸馏过程以结构化 Pipeline 展开

- 最初,在广泛数据集上预训练的教师模型生成包含推理和非推理输出的多样化语料库,捕捉各种逻辑模式和事实知识

- 非推理数据(约 200K 个样本)提供一般知识的基线,而推理数据(约 600K 个样本)包含通过教师的高级能力提炼的多步推理链

- 然后,该数据集用于 SFT 阶段,其中学生模型被训练以使其输出分布与教师的输出分布保持一致,使用推理数据直接微调较小的模型以提炼紧凑的推理模型

- 与直接应用于小型模型的传统强化学习(可能由于容量有限而产生次优推理)不同,DeepSeek-R1 的直接蒸馏通过转移预优化的推理行为规避了此类限制,以减少的资源需求实现卓越的性能

- 与直接应用于小型模型的传统强化学习(可能由于容量有限而产生次优推理)不同,DeepSeek-R1 的直接蒸馏通过转移预优化的推理行为规避了此类限制,以减少的资源需求实现卓越的性能

- 最初,在广泛数据集上预训练的教师模型生成包含推理和非推理输出的多样化语料库,捕捉各种逻辑模式和事实知识

- DeepSeek-R1 的知识蒸馏方法的一个显著特征是其强调在模型规模上保持推理完整性

- 通过集成通过大规模强化学习提炼的 DeepSeek-R1-Stage1 的推理轨迹,学生模型不仅复制事实准确性,还模仿复杂的推理过程,例如数学问题解决或逻辑演绎所需的过程

- 这种有针对性的转移与传统知识蒸馏形成对比,并强调了 DeepSeek-R1 在面向推理的蒸馏方面的创新

- 注:传统知识蒸馏通常优先考虑分类任务

- 该方法最大限度地减少了在学生上进行大量强化学习迭代的需求,利用教师的预计算推理输出来简化训练,从而提高效率和可扩展性

- 这种方法将 DeepSeek-R1 定位为将高级推理提炼到紧凑大语言模型中的范例,为未来的后训练优化工作提供了蓝图

PoLMs for Integration and Adaptation

- 集成和适配技术对于提升 LLM 在各种现实应用中的通用性和有效性至关重要

- 这些方法能让大语言模型无缝处理异构数据类型,适应特定领域的需求,并利用多种架构的优势,从而应对复杂、多方面的挑战

- 本章将阐述三种主要策略:

- 多模态集成(第7.1节),使模型能够处理文本、图像和音频等多种数据模态;

- 领域适配(第7.2节),针对特定行业或应用场景优化模型;

- 模型融合(第7.3节),将不同模型的能力整合起来,优化整体性能

- 总体而言,这些方法提高了大语言模型的适应性、效率和稳健性,拓宽了它们在各种任务和场景中的应用范围

Multi-Modal Integration

- 基于前面章节中阐述的后训练优化策略,本节将探讨先进的方法,这些方法旨在增强大语言模型和大型多模态模型(Large Multi-modal Model, LMM),以便有效地处理多模态数据

- 虽然监督微调能提高大语言模型在特定任务中的熟练度,但它在充分利用多模态能力方面存在局限性,这就需要更复杂的后训练方法

- 这些技术通过将不同的数据类型集成到一个统一的框架中,使大型多模态模型能够处理复杂的跨模态任务,例如:

- 从视觉输入生成网页代码 (2022)

- 解读像表情包这样微妙的文化产物 (2022)

- 在不依赖光学字符识别(optical character recognition,ORC)的情况下进行数学推理 (2023))

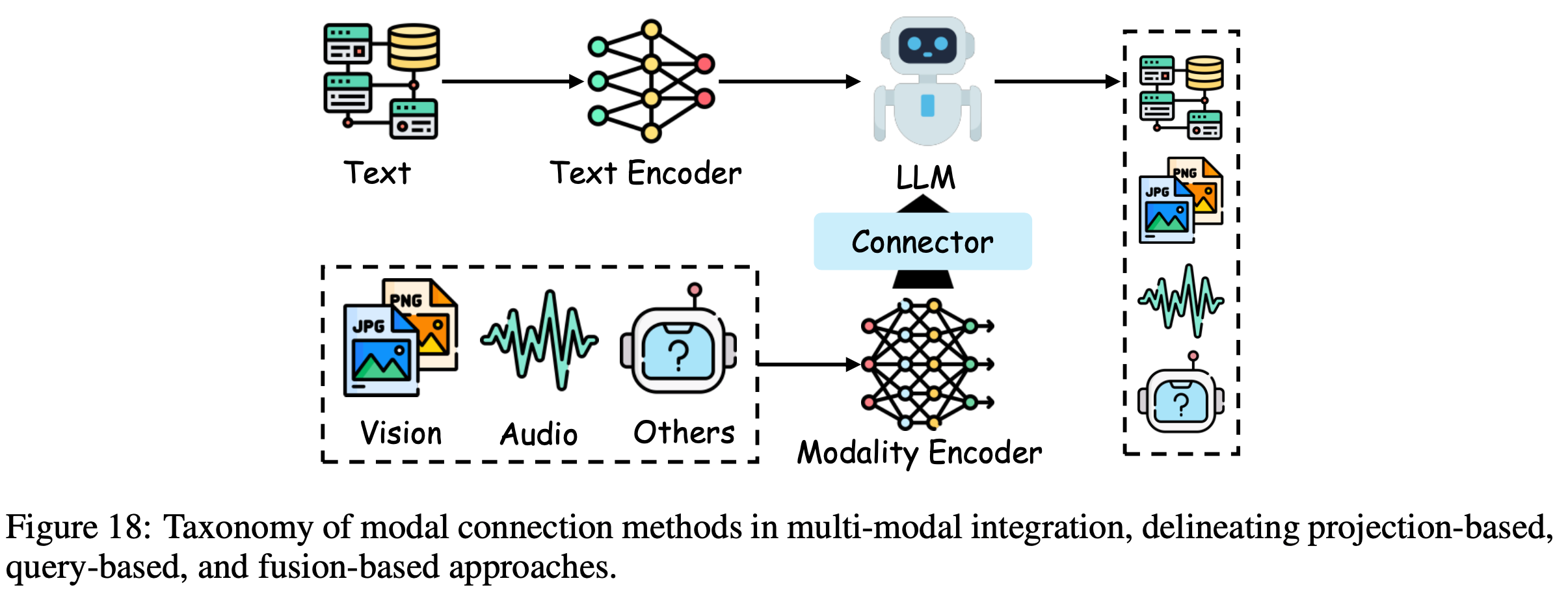

- 通常,大型多模态模型由模态编码器、预训练的大语言模型骨干和模态连接器组成,如图18所示

- 这种架构构成了后训练方法的基础,通过优化每个组件,促进强大的多模态集成和性能提升

- 这种架构构成了后训练方法的基础,通过优化每个组件,促进强大的多模态集成和性能提升

Modal Connection

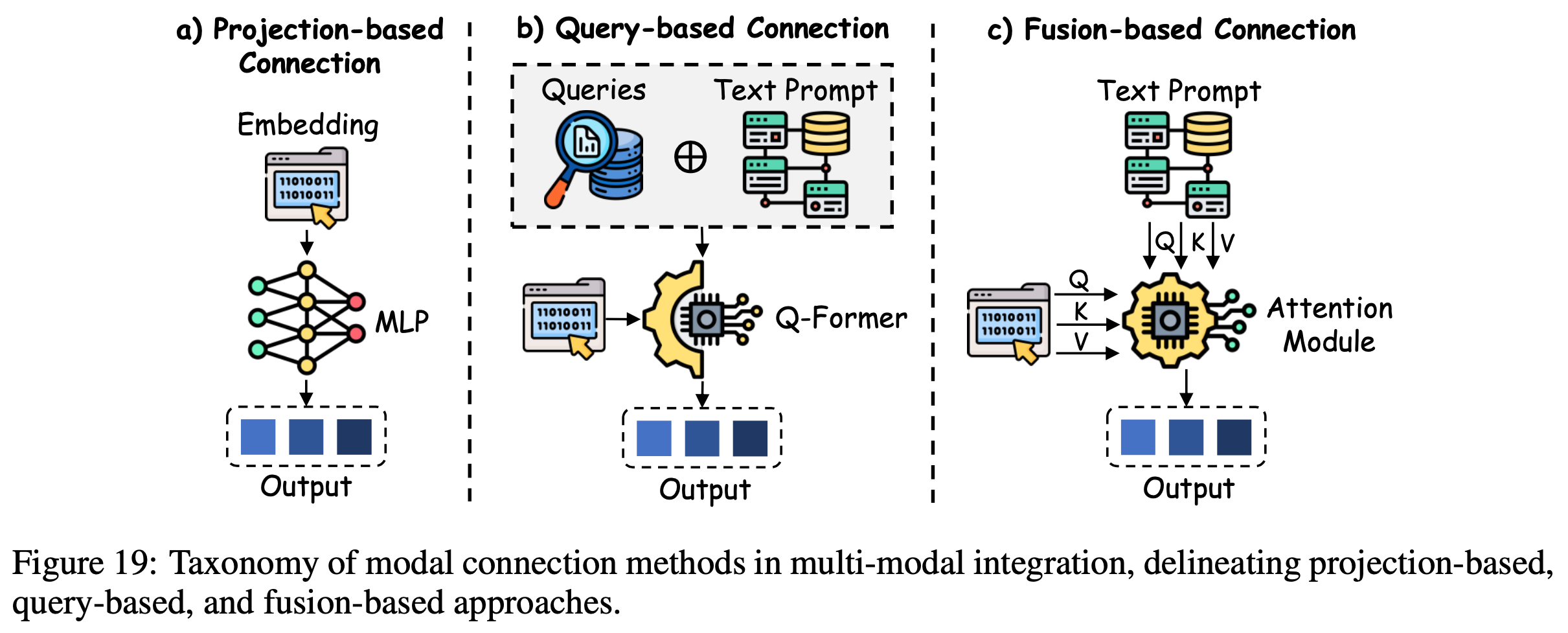

- 模态连接方法对于将多模态数据整合到一个连贯的表征框架中至关重要,主要分为三种策略(如图19所示):

- 基于投影的方法

- 基于查询的方法

- 基于融合的方法

- 基于投影的模态连接(Projection-based Modal Connection) :基于投影的方法将各种模态的输入转换到统一的文本嵌入空间 ,使其特征与大语言模型的语言维度对齐 ,以实现无缝集成

- LLaMA-Adapter (2023) 通过整合图像编码器将大语言模型扩展到多模态系统中,实现了基于图像的指令跟踪

- LLaMA-Adapter V2 (2023) 通过将视觉标签嵌入到早期的大语言模型层中,改进了这一过程,促进了对视觉知识的更好吸收

- FROMAGe (2023) 在冻结的大语言模型和视觉编码器框架内对输入和输出层进行微调,以实现跨模态交互

- LLaVA-1.5 (2023) 则使用双线性多层感知器(MLP)来增强多模态处理的稳健性

- Shikra (2023) 集成了空间坐标以增强自然语言对话

- VILA (2024) 优化了视觉语言预训练以实现卓越的零样本学习能力

- DetGPT (2023) 进一步推进了这一范式,将基于推理的目标检测与自然语言交互相结合,利用投影技术促进有效的多模态通信

- SOLO (2024) 采用单一的 Transformer 架构进行统一的端到端视觉语言建模,它可以接受原始图像 patches(以像素为单位)和文本作为输入,而无需使用单独的预训练视觉编码器

- MiniGPT-4 (2023) 通过单个投影层将冻结的视觉编码器与 Vicuna 对齐,通过两阶段训练过程实现了类似 GPT-4 的能力

- Idefics (2023) 凭借自回归设计和多阶段预训练在高效推理方面表现出色

- LaVIT (2024) 使用离散视觉标记器统一视觉和语言,实现无缝生成

- DeepSeek-VL2 (2024) 通过动态平铺和多头潜在注意力增强了高分辨率图像理解

- Qwen2.5-VL (2025) 通过重新设计的视觉 Transformer 在多模态任务中取得进展,在感知和视频理解方面表现出色

- 基于查询的模态连接(Query-based Modal Connection) :基于查询的方法通过使用可学习的 query Token 从不同模态中提取结构化信息 ,弥合了文本和非文本数据之间的差距 ,从而增强了多模态集成

- BLIP-2 (2023) 率先采用 query Transformer,有效地整合了文本和视觉输入

- Video-LLaMA (2023) 通过组合视觉编码器将该技术扩展到视频理解领域

- InstructBLIP (2023) 改进了查询机制,以确保精确遵循指令

- X-LLM (2023) 通过专门的接口对齐多模态输入

- mPLUG-Owl (2023) 和 Qwen-VL (2023) 优化了 Q-Former 架构以提高计算效率

- LION (2024) 进一步证明了基于查询的方法在推进视觉知识集成方面的有效性,强调了它们在提升大型多模态模型在各种任务中的性能方面的实用性

- Qwen-VL (2023) 是一系列基于 Qwen-7B 构建的大规模视觉语言模型,它结合了视觉接收器、位置感知适配器和三阶段训练 Pipeline,实现了多语言、细粒度的视觉语言理解

- Lyrics (2023) 是一个细粒度的视觉语言预训练和 Instruction Tuning 框架,通过视觉精炼器(图像标记、目标检测和语义分割)和多尺度查询 Transformer(MQ-Former)集成语义感知的视觉对象,增强了大型视觉语言模型(large vision-language models,LVLM)的能力

- 基于融合的模态连接(Fusion-based Modal Connection) :基于融合的技术通过将多模态特征直接嵌入到大语言模型架构中 ,加深了跨模态交互,在推理层面促进了更丰富的集成

- Flamingo (2022) 使用交叉注意力层在 Token 预测期间融合视觉特征,实现动态多模态处理

- OpenFlamingo (2023) 在其基础上进行扩展,允许冻结的大语言模型关注视觉编码器的输出,增强了灵活性

- Otter (2023) 引入指令调优,以改进多模态指令遵循能力

- CogVLM (2023) 在 Transformer 层内集成视觉专家模块,实现无缝的特征合成

- Obelics (2024) 利用交错的图像文本训练数据,突出了基于融合的方法在实现一致的多模态性能方面的稳健性

- InternVL (2023) 是一个大规模的视觉语言基础模型,它将视觉编码器扩展到 6B 参数,并使用语言中间件(QLLaMA)逐步将其与大语言模型对齐

- Llama 3 (2024) 是 Meta 开发的一个新的多语言、工具使用基础模型系列,扩展到 405B 参数,具有 128K Token 的上下文窗口,通过改进数据质量、更大规模的训练和结构化的后训练策略进行了优化

Modal Encoder

- 模态编码器将原始的多模态输入压缩成紧凑、语义丰富的表示形式,使其能够在各种任务和模态中高效处理

- 这些组件对于将异构数据转换为与大语言模型骨干兼容的格式至关重要,支持从视觉推理到音频理解等各种应用

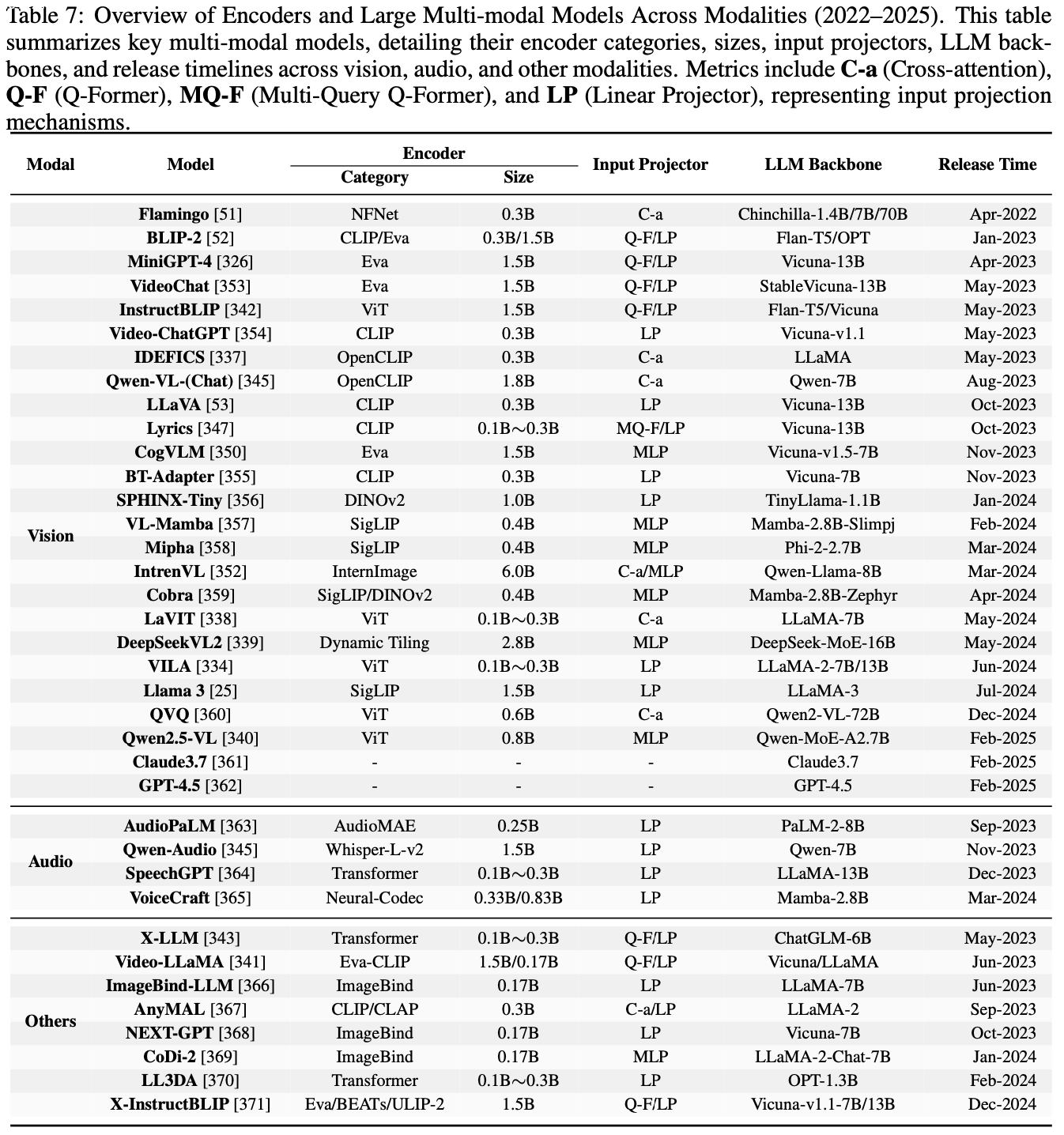

- 表7全面总结了视觉、音频和其他模态中常用的编码器,详细介绍了它们的特点以及对多模态集成的贡献

- 视觉编码器(Vision Encoder) :视觉编码器是多模态学习的基础,有助于大型多模态模型对视觉数据进行解释和生成

- CLIP (2021) 通过对比学习建立了联合图像文本表示,增强了跨模态对齐

- EVA (2023) 改进了视觉注意力机制以提高效率

- ImageBind (2023) 创建了一个跨多种模态的统一嵌入空间,提升了零样本识别能力

- SigLIP (2023) 引入了配对的sigmoid损失来优化图像文本预训练

- DINOv2 (2023) 采用无监督学习从各种来源提取强大的视觉特征

- LLaVA (2023) 采用自指令策略将图像转换为文本描述,使用先进的大语言模型生成新的数据集

- Video-ChatGPT (2023) 借助大规模指令数据集支持对话式视频理解

- BT-Adapter (2023) 通过高效的时间建模优化了视频理解

- VideoChat (2023) 专注于时空推理,利用专门的数据集

- CoDi-2 (2024) 和 Mipha (2024) 等模型在多模态处理中实现了效率提升

- VL-Mamba (2024) 和Cobra (2024) 引入了状态空间模型以优化推理

- SPHINX-Tiny (2024) 强调数据多样性和训练效率

- 音频编码器(Audio Encoder) :音频编码器增强了大型多模态模型处理和解释听觉输入的能力,拓宽了它们的多模态范围

- SpeechGPT (2023) 将大规模语音数据集与卷积和 Transformer 架构相结合 (2020),实现了强大的指令遵循能力

- AudioPaLM (2023) 使用通用语音模型(USM)编码器 (2023) 结合文本和语音处理,在零样本语言翻译等任务中表现出色

- WavCaps (2024) 采用 CNN14 (2020) 和 HTSAT (2022) 来缓解音频语言数据稀缺的问题,利用先进的大语言模型来优化数据集质量并提升学习效果,这突出了音频模态在多模态系统中的关键作用

- 其他编码器(Other Encoder) :除了视觉和音频,用于其他模态(如 3D 理解和多模态融合)的编码器对于全面的大型多模态模型也至关重要

- NEXT-GPT (2023) 促进了跨文本、图像、视频和音频的跨模态内容生成,通过最小的参数调整推进了类人人工智能能力

- ImageBind-LLM (2023) 对齐视觉和语言嵌入,以改进跨模态的指令遵循

- LL3DA (2024) 处理点云数据以进行 3D 推理和规划,引入了新颖的空间理解方法

- X-LLM (2023) 对图像和视频输入使用 Q-Former (2023),对语音使用 C-Former (2023),将音频特征压缩为 Token-level 嵌入,以提高多模态学习效率

Domain Adaptation

- 领域适配(Domain Adaptation, DA)是一种关键的后训练策略,用于优化大语言模型,使其在特定领域中表现出色,确保它们在目标应用中发挥实效

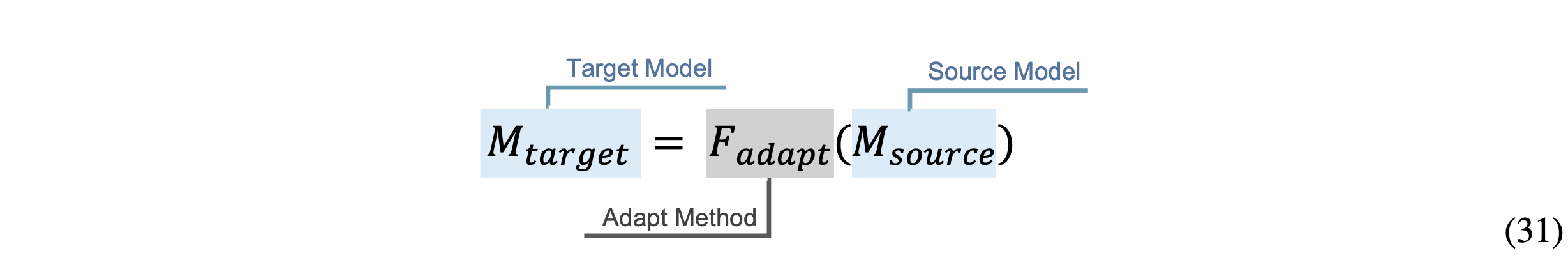

- 基于迁移学习的原理 (2018; 2024),领域适配通过适配函数 \(F_\text{adapt}\) 对初始模型 \(M_\text{source}\) 进行转换,生成特定领域的模型 \(M_\text{target}\),如下所示:

- 这个过程使 \(M_{target}\) 能够满足特定领域的独特需求和复杂性,从而优化其性能和相关性

- 通过提高大语言模型在编程 (2023; 2022) 和数学推理 (2023) 等领域的熟练度,领域适配不仅提升了特定领域的能力,还提高了计算效率,减轻了通用模型在处理特定领域术语和推理范式时常常遇到的局限性

- 此外,领域适配大大减少了从头开始训练特定领域模型通常所需的大量标记数据集和计算资源 (2024),使其成为后训练方法的基石

Knowledge Editing

- 知识编辑是一种复杂的后训练方法,旨在修改大语言模型以满足特定领域的要求 ,同时不损害其基本能力

- 这种技术有助于进行有针对性的参数调整,在整合新的或更新的领域知识时,保留模型原有的性能

- 通过快速适应不断变化的知识环境,知识编辑成为后训练流程中不可或缺的一部分

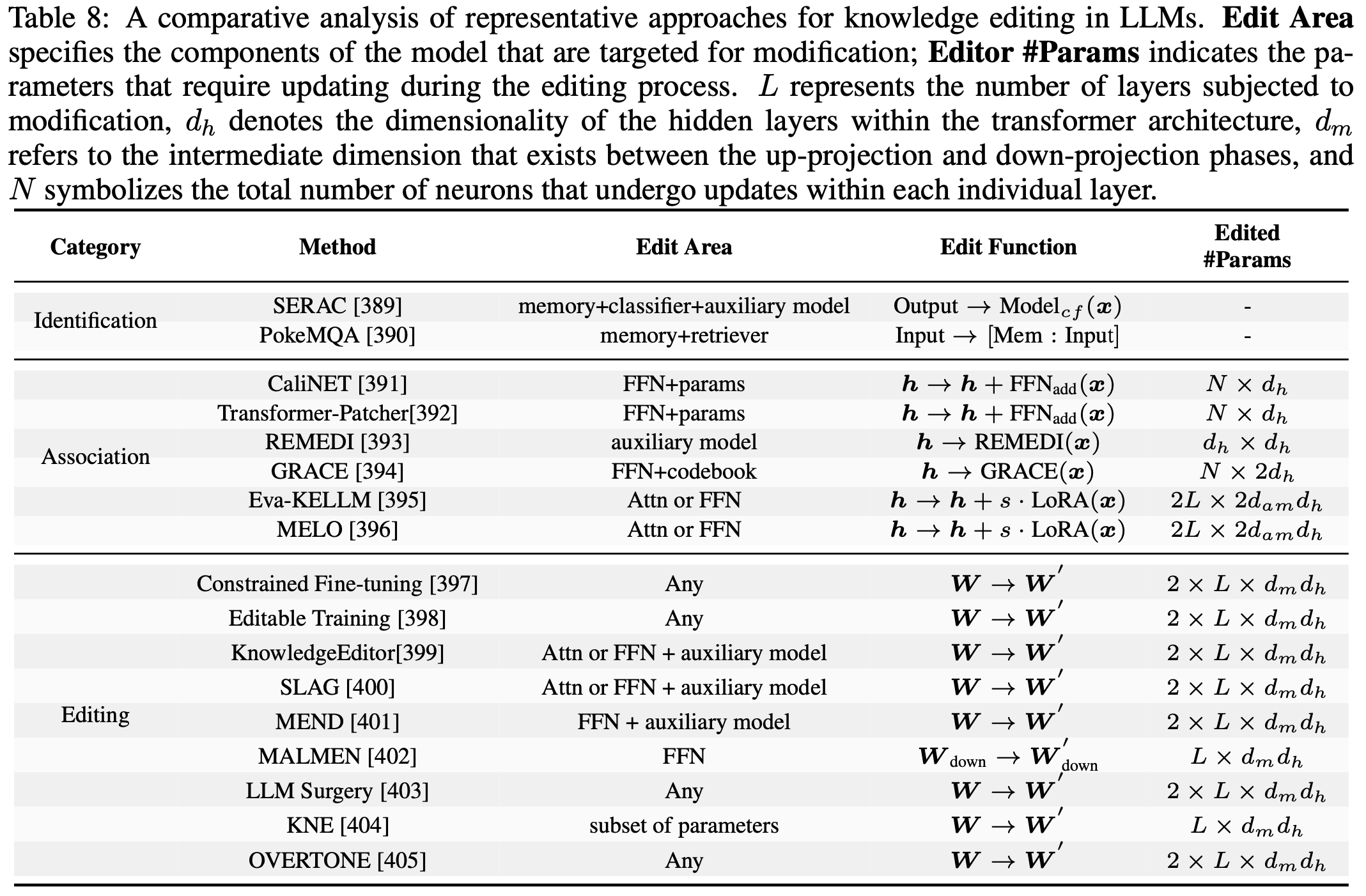

- 表8概述了主要的方法(例如,包括外部知识利用、集成和内在编辑)

- 知识编辑的形式化定义(Formal Definition of Knowledge Editing) :

- 考虑一个由 \(\theta\) 参数化的原始大语言模型,它在数据集 \(\mathcal{D}_\text{old}\) 上进行了预训练

- 设 \(\mathcal{D}_\text{new}\) 表示包含新的或更新信息 \(\Delta K\) 的数据集。知识编辑的目标是通过应用调整 \(\Delta \theta\) 来导出修订后的参数集 \(\theta’\),从而有效地吸收 \(\Delta K\),同时最小化对 \(\mathcal{D}_\text{old}\) 的性能下降。形式上,这被构建为一个约束优化问题,其中更新后的参数定义为:

$$\theta’=\theta+\Delta \theta, \text{ where } \mathcal{L}\left(\theta’ ; \mathcal{D}_{new }\right) \to min$$- \(c\) 代表一个损失函数(例如交叉熵),用于评估模型在 \(\mathcal{D}_\text{new}\) 上的质量

- 为了保护模型在原始数据集上的性能,施加了一个约束(确保新参数 \(\theta’\) 对旧数据 \(\mathcal{D}_\text{old}\) 的拟合能力不要降低太多):

$$\mathcal{L}\left(\theta’ ; \mathcal{D}_{old }\right) \leq \mathcal{L}\left(\theta ; \mathcal{D}_{old }\right)+\epsilon$$- 其中 \(\epsilon\) 是一个小的正常数,用于限制模型在 \(\mathcal{D}_\text{old}\) 上的性能损失

- 这个公式确保 \(\theta’\) 在整合 \(\Delta K\) 的同时,保留模型的先验知识库

- 在实际操作中,\(\Delta \theta\) 可能被限制在特定的架构组件(例如注意力层(Attn)或前馈网络(FFN)),以减少计算开销,并通过避免全面重新训练来保留核心功能

- 知识识别 :知识编辑的初始阶段侧重于检测新信息并将其整合到模型中

- PokeMQA (2023) 使用可编程范围检测器和知识提示来剖析查询,有效地检索相关事实

- SERAC (2022) 将反事实模型与分类器相结合,以确定新的知识来源的适用性,提供了一种微创方法,在无需进行广泛结构修改的情况下保留了基础模型的完整性

- 相关工作 (2024,[406]) 分析了大语言模型知识更新产生混乱涟漪效应的原因:

- 实际的编辑通常源于新出现的事件,这些事件包含新事实与过去事实之间的逻辑联系

- 基于这一观察,EvEdit (2024, [407]) 提出了一种基于事件的知识编辑方法,以确定知识锚点和知识更新边界

- 知识关联 :在识别之后,此阶段将新获取的信息与模型现有的知识框架相关联

- Transformer-Patcher (2023) 调整 Transformer 架构以整合更新的事实

- CaliNET (2022) 重新校准参数以与事实内容对齐

- 诸如 Eva-KELLM (2023)、MELO (2024) 和 REMEDI (2023) 等方法为精确更新优化特定行为

- GRACE (2024) 在知识插入后提高预测准确性,确保与先前表示的无缝集成

- 内在知识编辑 :最后阶段将关联的事实嵌入到模型的内部结构中,确保全面吸收

- 虽然传统的微调可能消耗大量资源,但先进的技术减轻了这一负担

- Constrained Fine-tuning (2020) 和元学习 (2021) 最大限度地减少知识损失和过拟合风险

- Editable Training (2020) 和 KnowledgeEditor (2021) 能够快速调整参数,同时将性能影响降至最低

- SLAG (2023)、MEND (2021) 和 MALMEN (2024) 解决编辑冲突并支持大规模更新,在整合新的领域见解的同时保持基本能力

- LLM Surgery (2024) 通过应用反向梯度去除过时数据、使用梯度下降整合新事实以及使用 KL 散度项保留现有知识,统一了遗忘和编辑,实现了显著的计算效率

- KNE (2024) 引入了知识神经元集成方法,精确定位并仅更新与新插入事实密切相关的神经元,在保留无关知识的同时实现更准确的编辑

- OVERTONE (2025) 通过引入 Token-level 平滑技术来解决知识编辑中的异构 Token 过拟合问题,该技术自适应地优化训练目标,从而保留预训练知识并提高模型对新插入事实的推理能力

- 这些有针对性的技术确保模型在整合新获取的信息时保留其基本能力

Retrieval-Augmented Generation

- 检索增强生成(Retrieval-Augmented Generation, RAG)将传统的信息检索与现代大语言模型相结合,以提高生成输出的相关性和事实准确性 (2020; 2023; 2024)

- 通过从外部来源动态检索相关信息并将其嵌入到生成过程中,检索增强生成解决了大语言模型在特定领域知识方面的不足,并减少了生成幻觉内容的倾向

- 这种方法在需要精确、最新信息的领域特别有效,例如问答系统 (2020)、科学研究 (2023) 和医疗保健 (2024),能够处理复杂查询和知识密集型任务

- 此外,检索增强生成减少了对话系统中误导性响应的普遍性,提高了基于知识的自然语言生成的保真度 (2024; 2023)

- 本节重点关注基于训练的检索增强生成方法 (2024),认识到无训练检索增强生成方法 (2020; 2023; 2024) 可能由于缺乏特定任务优化而损害知识利用效率

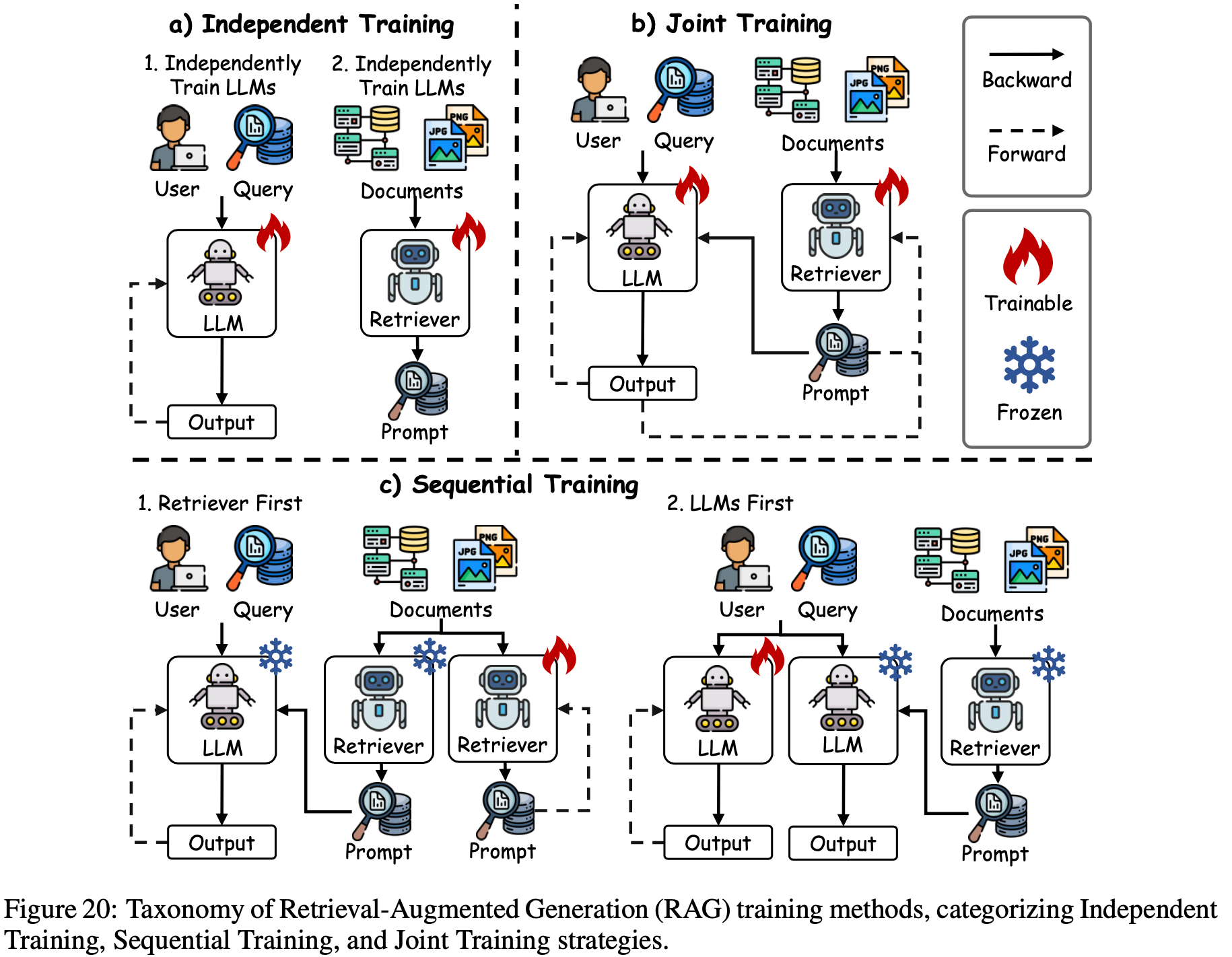

- 三种主要的训练策略:

- 独立训练

- 顺序训练

- 联合训练

- 提高了模型的适应性和集成能力,如图20所示

- 独立训练(Independent Training) :该策略将检索器和生成器作为不同的模块进行训练,能够灵活地采用针对任务需求定制的稀疏或密集检索器

- DPR (2020) 利用双BERT网络分别对查询和段落进行编码,应用对比学习优化检索,而无需与生成器交互

- 相关工作 (2024) 提出了 Reward-RAG,它利用奖励模型根据基于GPT的反馈仅微调检索器,而不改变生成器

- 顺序训练(Sequential Training) :顺序训练通过一次优化一个模块来提高效率,促进检索器和生成器之间的协同作用

- 它包括检索器优先方法 (2023; 2023; 2023; 2023; 2023),如 RETRO (2022),该方法先预训练基于 BERT 的检索器,然后训练编码器-解码器以无缝整合检索到的内容,从而提高性能

- LLM 优先方法 (2023; 2023; 2023),如 RA-DIT (2023),先微调语言模型以有效利用检索到的知识,然后优化检索器以实现更好的对齐和连贯性 (2023; 2023)

- 联合训练(Joint Training) :联合训练在端到端框架中同步优化检索器和生成器

- RAG (2020) 最小化负对数似然以共同训练两个组件

- REALM (2020) 通过最大内积搜索(Maximum Inner Product Search, MIPS)(2015) 提高检索精度

- 这些方法适应特定任务的需求,最大限度地利用外部知识的优势,并最大限度地减少生成错误

Model Merging

- 模型融合已成为提高大语言模型在训练和推理阶段性能和效率的重要后训练策略 (2024; 2024)

- 模型融合将专门的模型整合到一个统一的架构中,避免了大规模重新训练的需求,并解决了大型模型尺寸和计算需求带来的挑战

- 模型融合将单任务模型整合为一个能够执行多任务的整体(这与在合并的数据集上训练不同),为多任务学习提供了一种资源高效的范式

- 通过简化训练流程并促进开发在各种应用中具有强大泛化能力的通用模型,该技术优化了大语言模型在不同场景中的部署

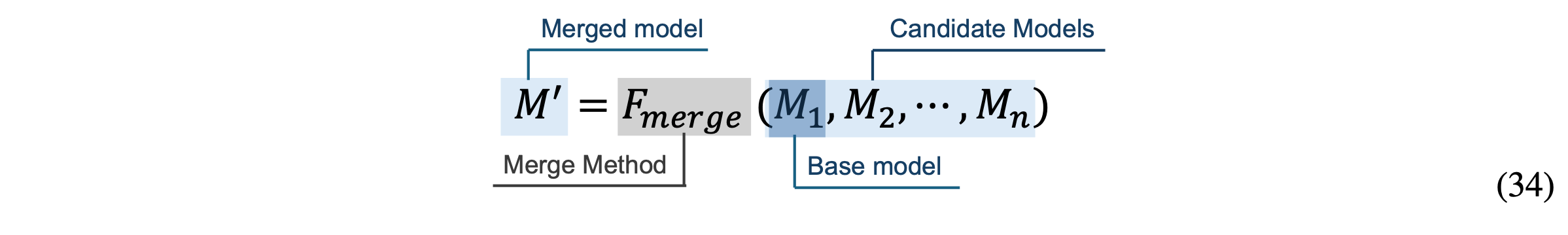

- 给定一组候选模型 \(M = \{M_{1}, M_{2}, …, M_{n}\}\),目标是设计一个融合函数 \(F_\text{merge}\),生成一个统一的模型 \(M’\),可能以基础模型 \(M_{1}\) 为锚点,如下所示:

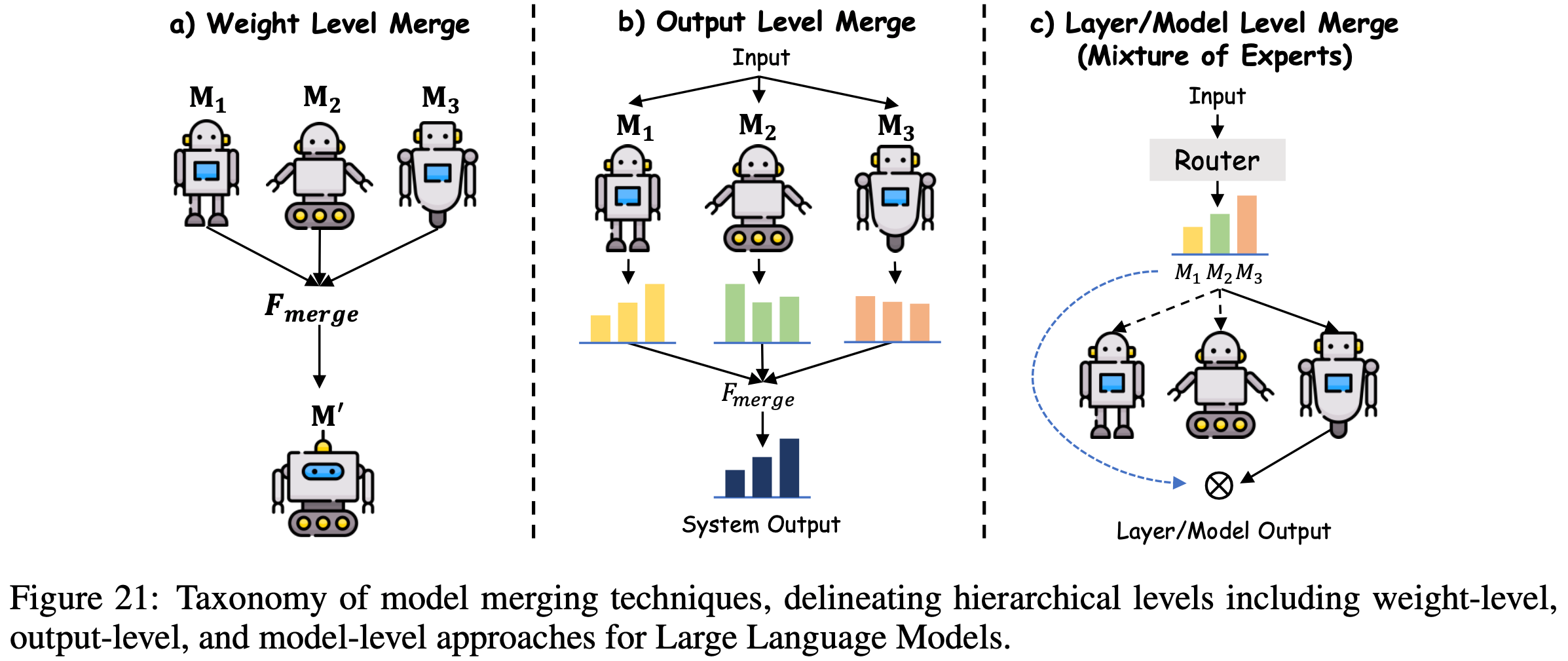

Model Merging at Hierarchical Levels

- 模型融合技术系统地分为三个层级(如图21所示):

- 权重级(weight-level merging)

- 输出级(output-level merging)

- 模型级融合(model-level merging)

- 权重级模型融合(Weight-Level Model Merging) :权重级融合直接操作参数空间 ,使其特别适用于具有相似架构或在相关任务上训练的模型

- 形式上,给定参数集 \(\theta_{1}, \theta_{2}, …, \theta_{n} \in \mathbb{R}^{d}\),线性融合方案将这些参数集聚合为一个统一的集合 \(\theta’\),表示为:

$$\theta’=\alpha_{1} \theta_{1}+\alpha_{2} \theta_{2}+…+\alpha_{n} \theta_{n}, \\

\text{ subject to }\quad \alpha_{k} \geq 0, \sum_{k=1}^{n} \alpha_{k}=1$$ - Model Soup (2022; 2020) 是一个权重级模型融合例子

- Model Soup 通过线性组合在不同任务上微调的模型的权重,生成一个单一、高效的模型

- Task Arithmetic(TA)(2022) 通过参数的算术运算扩展了这种灵活性,提高了性能适应性

- TIES-merging (2024) 确保参数一致性(为了减轻对齐问题)

- DARE (2024) 通过概率性地调整参数增量来最小化干扰,优化融合过程的连贯性和效率

- 形式上,给定参数集 \(\theta_{1}, \theta_{2}, …, \theta_{n} \in \mathbb{R}^{d}\),线性融合方案将这些参数集聚合为一个统一的集合 \(\theta’\),表示为:

- 输出级模型融合(Output-Level Model Merging) :当模型在架构或初始化方面存在差异 ,使得权重级方法不可行时,输出级融合变得有利

- 输出级模型融合方法聚合输出分布而不是内部参数,表示为:

$$ y’=\alpha y_{1}+(1-\alpha) y_{2}, \alpha \in[0,1] $$- 其中 \(y_{1}\) 和 \(y_{2}\) 分别表示模型 \(M_{1}\) 和 \(M_{2}\) 的概率分布

- 与集成策略类似,这种方法将模型预测合成为一个统一的输出

- LLMBlender (2023) 通过生成独立输出并通过排序和生成过程将其融合来实现这一点

- FuseLLM (2024) 将组合的输出概率蒸馏到单个网络中,以实现分布保真度

- FuseChat (2024) 通过将知识从多个大语言模型转移到一个整合的目标中,架起了权重级和输出级融合之间的桥梁,增强了跨模型协同作用

- 输出级模型融合方法聚合输出分布而不是内部参数,表示为:

- 模型级模型融合(Model-Level Model Merging) :模型级融合通过路由机制整合子模型或层 ,通常在 MoE 框架内 ,表示为:

$$ M’=\text{Merge}\left(M_{1}, M_{2}\right) $$- 其中 Merge 表示硬路由或软路由函数

- Switch Transformer (2022) 采用离散门控来选择性地激活专家层,减少计算负载,尽管由于刚性路由可能会有潜在的性能权衡

- SoftMoE (2023) 和 SMEAR (2023) 利用连续门控促进专家之间更平滑的过渡,增强组件集成和模型凝聚力

Pre-Merging Methods

- Pre-Merging Methods 通过优化独立模型的权重空间、架构一致性和参数对齐,为模型融合建立兼容性基础,从而最大限度地减少后续融合阶段的冲突和干扰

- 这些技术提高了融合过程的有效性,确保得到的统一模型保留其组成部分的优势,同时减轻潜在的性能下降

- 线性化微调(Linearization Fine-tuning) :

- 这种方法在预训练模型的切空间内优化模型,避开原始的非线性参数空间,以实现权重解耦,减少融合过程中的干扰

- 诸如适配器(例如 TAFT (2023))或注意力层 (2024) 的部分线性化技术将权重更新对齐到不相交的输入区域,在融合模型中保留独立功能 (2023)

- 通过将更新约束在一个线性化框架内,这种方法促进了不同模型之间的无缝集成

- 架构转换(Architecture Transformation) :

- 该策略将具有不同架构的异构模型转换为适合直接参数融合的同构形式

- 方法包括知识蒸馏,如 FuseChat (2024) 所示,以及身份层插入,如 CLAFusion (2021)

- GAN Cocktail (2021) 初始化目标模型以吸收来自不同架构的输出,实现跨越结构差异的统一融合过程

- 权重对齐(Weight Alignment) :这种方法通过排列将模型对齐到共享的权重域,利用线性模式连接(Linear Mode Connectivity, LMC)特性来提高兼容性

- 技术包括最优传输(OTFusion (2019))、启发式匹配(Git re-basin (2022))和基于学习的对齐(DeepAlign (2021))

- REPAIR (2022) 减轻了缺乏归一化层的模型中的对齐失败,确保在融合前参数能够稳健收敛

During-Merging Methods

- During-Merging Methods 专注于动态优化参数融合策略,以解决任务冲突、减轻干扰,并提高所得融合模型的性能和泛化能力

- 这些方法实时处理整合不同模型的挑战,增强统一架构的适应性和稳健性

- 基本融合(Basic Merging) :

- 这种方法利用简单的参数平均或任务向量算术,将任务向量 \(\tau_{t}\) 定义为第 \(t\) 个任务的微调参数 \(\Theta^{(t)}\) 与初始预训练参数 \(\Theta^{(0)}\) 之间的偏差:

$$\tau_{t}=\Theta^{(t)}-\Theta^{(0)}$$ - 并通过公式 \(\Theta^{(\text{merge} )}=\Theta^{(0)}+\lambda \sum_{t=1}^{T} \tau_{t}\) 促进多任务学习 (2022)

- 这种方法计算效率高且概念简洁,但经常遇到由于未减轻的参数相互作用导致的任务干扰,限制了其在需要复杂任务协调的场景中的实用性

- 这种方法利用简单的参数平均或任务向量算术,将任务向量 \(\tau_{t}\) 定义为第 \(t\) 个任务的微调参数 \(\Theta^{(t)}\) 与初始预训练参数 \(\Theta^{(0)}\) 之间的偏差:

- 加权融合(Weighted Merging) :

- 该策略根据各个模型的重要性动态分配融合系数,定制贡献以优化融合结果

- MetaGPT (2024) 通过归一化每个任务向量的平方 L2 范数来计算最优权重:

$$\lambda_{t}^{*}=\frac{\left| \tau_{t}\right| ^{2} }{\sum_{k=1}^{T}\left| \tau_{k}\right| ^{2} }$$- 从而为参数变化更大的任务分配更大的影响,如更高的 \(\left|\tau_{t}\right|^{2}\) 所示

- SLERP (2024) 采用球面插值确保参数的平滑过渡,保留模型连续性

- 分层 AdaMerging (2024) 通过在每层粒度上优化系数来改进此过程,提高融合架构内的任务特定精度

- 子空间融合(Subspace Merging) :

- 这种方法将模型参数投影到稀疏子空间中 ,以最大限度地减少干扰,同时保持计算效率,解决参数贡献的重叠问题

- TIESMerging (2024) 保留按幅度排列的前 20% 参数,解决符号冲突以保持连贯性

- DARE (2024) 缩放稀疏权重以减少冗余

- Concrete (2023) 利用双层优化来构建自适应掩码,确保模型组件的精细集成,减少跨任务干扰

- 基于路由的融合(Routing-based Merging) :

- 该技术根据输入特定属性动态融合模型,实现上下文响应式集成过程

- SMEAR (2023) 计算依赖于样本的专家权重以优先考虑相关特征

- Weight-Ensembling MoE (2024) 采用输入驱动的线性层路由进行选择性激活

- Twin-Merging (2024) 融合任务共享和任务私有知识,培养灵活的融合框架,适应不同的输入需求并增强多任务稳健性

- 融合后校准(Post-calibration) :

- 这种技术通过将统一模型的隐藏表示与独立组件的隐藏表示对齐来纠正融合后的表示偏差,减轻性能下降

- Representation Surgery (2024) 就是一个例子,它通过改善表示一致性来增强融合模型的稳健性和准确性

Datasets

- 后训练技术经过精心设计,旨在提高 LLM 对特定领域或任务的适应性,而数据集是这一优化过程的基石

- 对以往研究的深入考察 (2024; 2024) 强调,数据的质量、多样性和相关性对模型效能有着深远影响,往往决定了后训练工作的成败

- 为了阐明数据集在这一背景下的关键作用,论文对后训练阶段所使用的数据集进行全面回顾和深入分析,并根据其收集方法将其分为三大类

- 人工标注数据

- 蒸馏数据

- 合成数据

- 这些类别反映了数据整理的不同策略,模型要么采用单一方法,要么采用融合多种类型的混合方法,以在可扩展性、成本和性能之间取得平衡

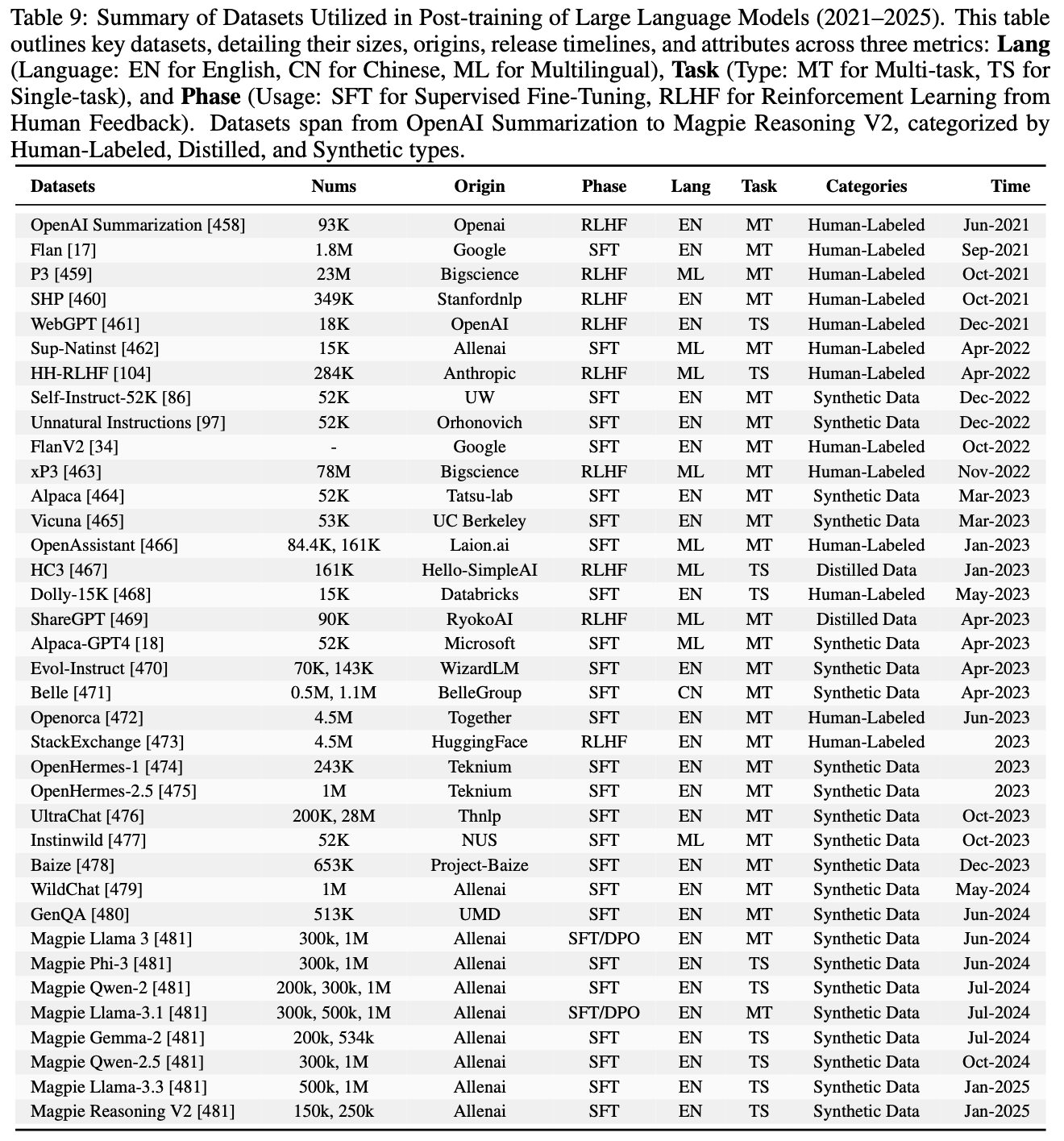

- 表9详细概述了这些数据集类型,包括它们的来源、规模、语言、任务和后训练阶段(如 SFT 和 RLHF ),论文将在后续章节中探讨它们在提升大语言模型能力方面的贡献和面临的挑战

Human-Labeled Datasets

人工标注数据集以其极高的准确性和语境保真度著称,这些特性源于标注者对任务复杂性的细致理解,以及他们做出精确、符合语境调整的能力

这些数据集是优化 Instruction Tuning 的基石,通过提供高质量、专业整理的训练信号,显著提升大语言模型在各类任务中的性能

在这一类别中,Flan (2021)、P3(Public Pool of Prompts)(2021)、Sup-Natinst(Super-Natural Instructions)(2022) 和 Dolly-15K (2023) 等著名示例成为大语言模型后训练中广泛采用的资源,每一种都通过人类专业知识为模型能力的优化做出了独特贡献

用于监督微调的人工标注数据 :在监督微调阶段,人工标注数据集发挥着不可或缺的作用,Flan、Sup-Natinst 和 Dolly-15K 的贡献就体现了这一点,它们提供精心设计的提示-响应对和特定任务指令,以提高大语言模型在各种自然语言处理基准测试中的效能

- Flan :

- Flan 数据集 (2021) 是一项基础性资源,最初包含 62 个广为人知的自然语言处理基准测试,如 HellaSwag (2019)、MRPC (2005) 和 ANLI (2019),通过 1800K 个示例促进强大的多任务学习

- 最近,FlanV2 (2023) 作为一个高级迭代版本出现,它整合了 Flan (2021)、P3 (2021)、Sup-Natinst (2022) 以及大量其他数据集,形成一个连贯、全面的语料库,从而增强了其在各种语言和任务领域的监督微调效用

- Sup-Natinst :

- 超级自然指令(Super-Natural Instructions,Sup-Natinst)(2022) 提供了涵盖 55 种语言的 76 种任务类型,是多语言大语言模型后训练的多功能资源

- 每个任务都与一个指令精心配对,该指令包括清晰的任务定义(概述从输入文本到期望输出的映射)和一组示例,这些示例既展示正确响应也展示错误响应,为引导模型实现精确的任务执行和增强跨语言适应性提供了坚实框架

- Dolly-15k :

- 由 Databricks 员工开发的 Dolly-15K (2023) 是一个精心整理的语料库,包含 15,000 个高质量的人工生成提示-响应对,专门设计用于大语言模型的 Instruction Tuning

- 它涵盖广泛的主题和场景,包括头脑风暴、内容生成、信息提取、开放式问答和摘要,反映了丰富多样的任务类型,使模型能够灵活适应各种指令语境,并提高语境相关性

- Flan :

上述语料库充分体现了人工标注数据集在监督微调中的效力,即广泛覆盖各种任务和场景

除上述语料库外:

- OpenAssistant (2023) 提供了一个庞大的多语言对话语料库,该语料库源自全球众包工作,可免费用于推进研究工作

- OpenOrca (2023) 通过数百万个 GPT-3.5 和 GPT-4 完成内容扩展了 FlanV2 (2023),成为一个动态扩展的微调与任务对齐资源

- 尽管这些数据集对模型泛化能力有显著贡献,但确保标注质量和多样性的一致性仍然是一项挑战,因此需要严格的质量控制以最大限度地发挥它们的作用

用于 RLHF 的人工标注数据 :对于 RLHF,P3、其多语言扩展版本 xP3 (2022) 和 SHP (2021) 等人标注数据集提供了必要的人工标注评估,这些评估完善了大语言模型与用户偏好的对齐,为奖励建模提供了细致的反馈机制

- P3 :

- P3 数据集 (2021) 是一个精心整理的 Instruction Tuning 资源

- 它从 Hugging Face Hub 聚合了 23000K 个多任务提示

- 每个提示都配有手工编写的指令,涵盖各种自然语言处理任务,从而为 RLHF 提供丰富基础,以提高大语言模型在各种应用中的适应性和精确性

- xP3 :

- xP3(Crosslingual Public Pool of Prompts)(2022) 将 P3 扩展到多语言框架,包含 46 种语言和 16 种自然语言处理任务的提示和监督数据,旨在支持 BLOOMZ 和 mT0 等模型的多任务提示微调

- 其内容整合了英文 P3 数据集、四个新的英文任务(如翻译、程序合成)以及 30 个多语言自然语言处理数据集,为跨语言 RLHF 优化提供全面资源

- SHP :

- SHP (2021) 包含 349,000 个人类偏好标注,这些标注针对 18 个学科领域的问题和指令的响应,评估响应的有用性,用于训练 RLHF 奖励模型和评估自然语言生成(NLG)质量

- 与 HH-RLHF 等混合数据集不同,它的独特之处在于完全依赖人类创作的数据

- P3 :

这些数据集通过提供多样化的人工标注评估,完善了 RLHF,使模型更好地与用户偏好对齐

OpenAI Summarization (2021) 和 Webgpt (2021) 提供基于比较的结构化反馈和李克特量表评分,有助于使模型输出更符合人类期望

HH-RLHF (2022) 通过包含对有用性和无害性的评估进一步强化了这一框架,为旨在确保安全和符合伦理的响应的模型奠定了坚实基础

StackExchange (2023) 贡献了特定领域的用户生成内容,丰富了训练数据,尤其有利于需要技术领域专业知识的模型

但这些数据集面临着可扩展性、人工标注可能存在的偏差以及超出特定领域的适用性有限等挑战

因此,尽管它们很有价值,但可能需要补充更广泛的数据集,以实现模型在各种现实世界任务中的全面对齐

Distilled Dataset

- 蒸馏数据源于将庞大的原始数据集精炼为紧凑、优化的子集的复杂过程,这些子集保留了大语言模型训练所需的关键信息,在保持性能的同时提高了训练效率并降低了计算需求

- 这种方法产生的数据集在效能上常常媲美甚至超越未精炼的数据集,加速模型收敛并减少资源消耗,尤其在 RLHF 阶段

- ShareGPT (2023) 和 HC3(Human-ChatGPT Comparison Corpus)(2023) 是关键示例,它们通过提炼现实世界交互和比较见解,成为大语言模型微调的广泛采用的资源,提供可操作的训练信号

- ShareGPT

- ShareGPT (2023) 是一个动态数据收集平台,通过其 API 聚合了大约 90,000 个对话,这些对话来自用户与 ChatGPT 或 GPT-4 的真实交互

- 它包含真实的人类指令和查询以及相应的人工智能响应,将自然对话模式提炼为集中资源,使 RLHF 能够完善大语言模型的对话流畅性和语境响应能力,具有高度的相关性和质量

- HC3 :

- HC3 数据集 (2023) 专门设计用于对比 ChatGPT 生成的响应与人类编写的答案,包含 161,000 个问答对,涉及开放式话题、金融、医学、法律和心理学等领域

- 这个经过提炼的语料库便于对响应特征和质量进行比较分析,使研究人员能够在 RLHF 期间提高大语言模型输出的真实性和特定领域准确性,同时突出人类与人工智能生成内容之间的差异

Synthetic Datasets

- 合成数据是大语言模型后训练的监督微调阶段的变革性资产,它通过人工智能模型生成,为人工标注数据集提供了具有成本效益、可扩展且保护隐私的替代方案

- 通过自动创建指令-响应对和对话,合成数据能够构建庞大的训练语料库,提高模型的适应性

- Self-Instruct-52K (2022)、Vicuna (2023) 和 Baize (2023) 是广泛用于增强大语言模型指令遵循和对话生成能力的主要示例

- 基于 Self-Instruct 方法的数据集(Datasets Based on the Self-Instruct Method) :

- 采用 Self-Instruct Method 的合成数据集从一小组手工编写的种子示例开始,利用大语言模型生成大量指令遵循数据,提高模型对各种指令的响应能力,Self-Instruct-52K、Alpaca 和 Magpie 系列就是这种方法的体现,它们通过可扩展自动化推进 Instruction Tuning

- Self-Instruct-52K :

- Self-Instruct-52K (2022) 为指令遵循模型建立了基准,它使用各种提示模板从手工编写的种子中生成 52,000 个示例,引导大语言模型更精确、一致地解释和执行特定任务指令

- Alpaca :

- Alpaca (2023) 和 Alpaca-GPT4 (2023) 分别使用 GPT-3 和 GPT-4 将初始的 175 个种子对扩展为 52,000 个高质量指令-响应对,提高了指令遵循能力;

- InstInWild (2023) 为多语言语境调整了这种方法,生成英文和中文数据集,增强跨语言适应性

- Magpie 数据集(Magpie Datasets) :Magpie 数据集 (2024) 利用对齐的大语言模型从预定义模板生成指令-响应对,产生了专门的系列,如:

- 强调思维链推理的 Magpie Reasoning V2

- 针对流行模型的 Magpie Llama-3 和 Qwen-2 系列

- 适用于 Gemma 架构的 Magpie Gemma-2

- 包含偏好优化信号的 Magpie-Air-DPO 等变体

- 通过这些数据集共同增强了对话和推理任务的监督微调与 Instruction Tuning

- 除此之外,下面的数据集显著扩大了指令生成的规模

- Unnatural Instructions (2022):240K examples

- Evol-Instruct (2023):通过迭代复杂度增强得到 70K-143K refined entries

- Belle (2023):来自 ChatGPT 的 500K-1100K 中文对话)

- 然而,质量保证、复杂度校准和偏差缓解方面的挑战仍然存在,需要持续改进以确保在复杂应用中的可靠性

- 基于 Self-Chat 方法的数据集(Datasets Based on Self-Chat Methods) :

- Self-Chat 数据集采用模型在内部或与同伴模拟多轮对话的技术,提高对话生成能力并弥补现有语料库的不足,Baize、UltraChat 和 OpenHermes 通过自动化交互策略体现了这种方法

- Baize :

- Baize (2023) 利用 ChatGPT 的 Self-Chat 技术生成 653,000 个多轮对话,整合来自 Quora、Stack Overflow 和 Alpaca 的种子数据以提高指令遵循质量,从而完善大语言模型的对话连贯性和任务遵循能力,用于监督微调

- UltraChat :

- UltraChat (2023) 利用多个 ChatGPT API 生成超过 12M 个高质量对话记录,涵盖各种主题,克服了多轮数据集普遍存在的质量低下和标注不准确等问题,为对话增强提供了强大的监督微调资源

- Openhermes :

- 由 Teknium 开发的 OpenHermes 包括 OpenHermes-1 (2023)(243K entries)及其扩展版本 OpenHermes-2.5 (2023)(1M entries),提供高质量的监督微调数据集,具有更大的体量和多样性,涵盖广泛的主题和任务类型,以提高对话和指令遵循能力

- 这些 Self-Chat 数据集使模型能够通过自交互生成多轮对话,如 Baize 利用具有各种种子的 ChatGPT 以及 UltraChat 利用广泛的 API 驱动对话,显著提高了对话质量并填补了训练数据可用性的关键空白

- 基于真实用户交互的数据集(Datasets Based on Real User Interactions) :

- 源自真实用户交互的数据集利用与大语言模型的真实对话交换,捕捉多样化和真实的输入,以提高模型处理现实世界场景的能力,Vicuna、WildChat 和 GenQA 是这种方法的主要示例

- Vicuna :

- Vicuna (2023) 在从 ShareGPT 的公共 API 共享的大约 70,000 个用户对话上进行微调,通过将 HTML 转换为 markdown、过滤低质量样本以及分割冗长对话以适应模型语境长度来处理这些对话,确保高质量的监督微调数据用于真实交互建模

- WildChat :

- WildChat (2024) 包含 1M 个真实世界的 User-ChatGPT 交互,涵盖多种语言和提示类型,具有模糊请求和语码转换等独特交流方式,既作为监督微调资源,又作为分析用户行为的工具

- GenQA :

- GenQA (2024) 提供超过 10M 个经过清理和过滤的指令样本的庞大监督微调数据集,这些样本完全由大语言模型生成,无需人工输入或复杂流程,通过快速生成合成数据来弥补覆盖空白,补充现有语料库

- 与人工标注数据集相比,合成数据在成本、可扩展性和隐私方面具有优势,但在深度和真实性方面可能存在不足,存在偏差传播和过度简化的风险

- 依赖人工智能生成内容可能会延续模型固有的错误,这凸显了整合合成数据和人工生成数据以提高大语言模型在各种语境中的稳健性和适用性的必要性

Applications

- 尽管预训练赋予了 LLM 强大的基础能力,但在专业领域部署时,它们常常面临一些持续存在的局限性,比如上下文长度受限、容易产生幻觉、推理能力欠佳以及存在固有偏见等

- 这些缺陷在现实应用中尤为关键,因为精准性、可靠性和伦理一致性至关重要。这引发了一些核心问题:

- (1)如何系统性地提升大语言模型的性能以满足特定领域的需求?

- (2)有哪些策略能有效缓解实际应用中存在的固有障碍?

- 后训练作为一项关键解决方案,通过优化大语言模型对特定领域术语和推理模式的识别能力,同时保留其广泛的综合能力,从而增强了它们的适应性

- 本章将阐述后训练大语言模型在专业、技术和交互领域的变革性应用,详细说明定制化的后训练方法如何应对这些挑战,并提升模型在不同场景中的实用性

Professional Domains

- 法律助手(Legal Assistant) :法律领域是利用后训练赋予大语言模型专业知识的典型场景,能让它们应对法学领域的复杂知识体系,并解决法学中固有的多方面挑战

- 大量研究 (2023; 2023; 2023) 探讨了大语言模型在法律领域的应用,涵盖法律问答 (2023; 2023)、判决预测 (2021; 2022)、文档摘要 (2023; 2024) 以及更广泛的任务,如检索增强和司法推理 (2024; 2024; 2024)

- 经过后训练的法律助手,如 LawGPT (2024) 和 Lawyer-LLaMA (2023),已展现出卓越的能力,不仅能在各种法律事务中提供可靠指导,还能在专业资格考试中取得成功,这充分证明了它们具备先进的解释和分析能力

- LexiLaw (2023) 和 SAUL (2024) 等模型支持多语言,包括英语和中文,进一步扩大了其应用范围

- 这些进步的核心在于对精心整理的法律语料库进行后训练 ,例如 ChatLaw (2023),它将大量法律文本整合到对话数据集中 ,使模型能够优化自身的推理能力和术语识别能力

- 医疗健康(Healthcare and Medical) :后训练显著提升了大语言模型在医疗健康领域各类应用中的性能,这些模型利用特定领域的数据,精准满足临床和学术需求

- 在临床环境中,大语言模型助力完成药物发现 (2022)、药物协同预测 (2024)、催化剂设计 (2023)、诊断支持、医疗记录生成和患者交互等任务;

- 在学术领域,通过定制化的后训练,大语言模型在医疗报告合成 (2023) 和问答 (2024) 等方面表现出色。例如

- ChatMed (2023) 基于 500K 条医疗咨询记录进行优化,展现出更高的诊断和咨询准确性;

- PULSE (2023) 则使用涵盖中文医疗和通用领域的 4000K 条指令进行微调,展现出卓越的多任务处理能力

- 这些模型通过后训练获得的适应性,将复杂的医学知识融入其中,其性能优于通用模型,这凸显了定制化数据集在实现实际应用价值方面的不可或缺性

- 这些进步不仅提高了特定任务的成果,还为将大语言模型整合到医疗工作流程铺平了道路,在这些流程中,精准性和语境相关性至关重要,充分体现了后训练对实际医疗应用的变革性影响

- 金融经济(Finance and Economics) :在金融和经济领域,大语言模型在情感分析 (2024)、信息提取 (2023) 和问答 (2023) 等任务中展现出巨大潜力,而后训练通过特定领域的优化进一步提升了它们的效能

- FinGPT (2023) 和 DISC-FinLLM (2023) 等专业模型在经过金融语料库的后训练后,在那些需要深入理解市场动态和专业术语的任务中表现比基础模型更出色

- XuanYuan (2023) 利用大量金融数据集和先进的后训练技术,提高了经济建模和预测的准确性,其性能超过了未经过微调的基准模型

- 这些发展表明,后训练在使大语言模型适应金融应用的复杂需求方面发挥着关键作用,因为在金融领域,精准解读定量数据和定性见解至关重要,这确保了模型能够提供可靠、符合行业标准和预期的特定领域输出

- 移动 Agent(Mobile Agents) :大型多模态模型(LMM)的发展推动了一个新兴的研究领域,即基于大型多模态模型的图形用户界面(graphical user interface,GUI)Agent 研究 (2024)

- 该领域旨在开发能够在各种图形用户界面环境中执行任务的人工智能助手,包括网页界面(Web Interfaces) (2023; 2024; 2024; 2024; 2024)、个人计算平(personal computing platforms) (2023; 2024; 2024; 2024; 2024) 和移动设备(Mobile Devices) (2024; 2024; 2024; 2024; 2024)

- 在移动领域, (2024) 通过工具整合和额外的探索阶段 (2024; 2024) 提升了单个 Agent 的感知和推理能力

- 一些研究采用多 Agent 系统进行决策和反思 (2024; 2024),展现出巨大潜力,从而提高了任务效能

- 值得注意的是,MobileAgent-E (2025) 在 Agent 之间引入了层次结构,促进了强大的长期规划,并提高了低级别动作的精度

- 这些进展凸显了多模态后训练策略在培养适应性强、高效的移动环境 Agent 方面的变革性作用

Technical and Logical Reasoning

- Mathematical Reasoning :大语言模型在数学推理方面展现出巨大潜力,涵盖代数运算、微积分和统计分析等领域,而后训练在缩小计算能力与人类水平能力之间的差距方面起着关键作用

- GPT-4 (2023) 在标准化数学评估中取得高分,这得益于其多样化的预训练语料库,而后训练进一步优化了这一能力

- DeepSeekMath (2024) 利用专门的数学数据集和 SFT、 GRPO (2024) 等技术,提高了推理精度,能够运用结构化的思维链(CoT)解决复杂问题

- OpenAI 的 o1 (2024) 通过 RL 在这一领域取得进展,不断优化推理策略,在多步骤推导和证明中实现更优异的性能

- 通过后训练进行的持续优化不仅提高了准确性,还使大语言模型的输出更符合严谨的数学逻辑,使它们成为教育和研究领域的宝贵工具,因为在这些领域中,高级推理至关重要

- Code Generation :后训练彻底改变了代码生成领域,赋予大语言模型在自动编码、调试和文档编制方面的卓越能力,从而改变了软件开发流程

- Codex (2021) 在庞大且多样化的代码库上进行训练,是 GitHub Copilot 的基础,能够提供实时编码辅助,且准确性极高

- Code Llama (2023) 这样的专业模型通过在特定编程数据集上进行后训练,进一步优化了这一能力,能为不同语言和框架的开发者提供帮助

- OpenAI 的 o1 (2024) 将其数学推理能力扩展到代码生成领域,生成高质量、符合语境的代码片段,其质量可与人类输出相媲美

- 当前的研究重点包括增强个性化、加深语境理解以及嵌入伦理保障措施,以降低代码滥用等风险,确保大语言模型在技术领域最大限度地提高生产力,同时遵循负责任的开发原则

Understanding and Interaction

- 推荐系统(Recommendation System) :大语言模型已成为推荐系统领域的变革性力量,它们通过分析用户交互、产品描述和评论,以前所未有的精细度提供个性化建议 (2023; 2023; 2024)

- 后训练增强了它们整合情感分析的能力,使其能够细致理解内容和情感内涵,GPT-4 (2023) 等模型以及 LLaRA (2024) 和 AgentRec (2024) 等专门系统就体现了这一点

- 亚马逊和淘宝等电子商务巨头利用这些能力处理评论情感、搜索查询和购买历史,优化客户偏好模型,并高度精准地预测用户兴趣 (2023)

- 除了对物品进行排名外,经过后训练的大语言模型还能参与对话式推荐、规划和内容生成,通过提供动态、符合语境的交互来提升用户体验,这些交互能适应不断变化的偏好,这充分证明了后训练在将数据分析与实际应用价值相结合方面的作用

- 语音对话(Speech Conversation) :经过后训练的大语言模型重新定义了语音处理,将识别、合成和翻译的自然度和准确性提升到前所未有的水平 (2024)