注:本文包含 AI 辅助创作

- 参考链接:

- 原始论文:Qwen3 Technical Report, Qwen, 20250514

- Qwen3技术报告解读-包包算法笔记

- Qwen3技术报告解读-刘聪NLP

- Github 链接:github.com/QwenLM/Qwen3

- github.com/QwenLM/Qwen3/tree/main/examples/llama-factory 文件夹下有 Qwen3 在 Llama-factory 框架下微调的方法

Paper Summary

- 整体说明:

- Qwen3 包含一系列 LLM,包括 Dense 和 MoE 模型,参数规模从 0.6B 到 235B 不等(这个模型 Size 的丰富度,可以称为地表最强开源模型了)

- Qwen3 的一项关键创新是将思考模式(thinking mode,用于复杂的多步推理)和非思考模式(non-thinking mode,用于快速的上下文驱动响应)集成到一个统一框架中

- Qwen3 引入了思考预算(thinking budget)机制,允许用户在推理过程中自适应地分配计算资源,从而根据任务复杂度平衡延迟和性能

- 该模型基于包含 36 万亿 token 的大规模数据集进行预训练,能够理解和生成 119 种语言和方言的文本

- Qwen3 在预训练和训练后模型的标准基准测试中均表现出色,涵盖代码生成、数学、推理和 Agent 相关任务

- 利用旗舰模型的知识(蒸馏小模型),显著减少了构建小规模模型所需的计算资源,同时确保其具备高度竞争力

- Qwen3 在多样化基准测试中取得了 SOTA 结果,包括代码生成、数学推理、智能体任务等,与更大的 MoE 模型和专有模型相比具有竞争力

- 与上一代 Qwen2.5 相比,Qwen3 将多语言支持从 29 种扩展到 119 种语言和方言

Introduction and Discussion

- 人类的目标:人工通用智能(Artificial General Intelligence, AGI)或人工超级智能(Artificial Super Intelligence, ASI)

- 这项工作介绍了基础模型家族 Qwen 的最新系列 Qwen3

- Qwen3 是一组开源 LLM ,在广泛的任务和领域中实现了 SOTA 性能

- 发布了 Dense 和 MoE 模型,参数数量从 0.6B 到 235B 不等,以满足不同下游应用的需求

- 旗舰模型 Qwen3-235B-A22B 是一个 MoE 模型,总参数为 235B,每个 token 激活的参数为 22B

- 这种设计确保了高性能和高效的推理

- Qwen3 引入了多项关键技术进步以增强其功能和可用性

- 首先,它将两种不同的操作模式(思考模式和非思考模式)集成到单一模型中

- 这使得用户无需在不同模型之间切换(例如从 Qwen2.5 切换到 QwQ (2024))即可切换模式

- 这种灵活性确保开发者和用户可以高效地根据特定任务调整模型行为

- 此外,Qwen3 引入了思考预算,使用户能够精细控制模型在执行任务时应用的推理努力水平

- 这一能力对于优化计算资源和性能至关重要,能够根据实际应用中的复杂度调整模型的思考行为

- 此外,Qwen3 在涵盖 119 种语言和方言的 36 万亿 token 上进行了预训练,有效增强了其多语言能力

- 这种广泛的语言支持扩大了其在全球用例和国际应用中的部署潜力

- 这些进步共同使 Qwen3 成为 SOTA 开源大语言模型家族,能够有效解决跨领域和跨语言的复杂任务

- 首先,它将两种不同的操作模式(思考模式和非思考模式)集成到单一模型中

- Qwen3 的预训练过程使用了约 36 万亿 token 的大规模数据集,经过精心筛选以确保语言和领域的多样性

- 为了高效扩展训练数据,作者采用了多模态方法:Qwen2.5-VL (2025) 被微调以从大量 PDF 文档中提取文本

- 作者还使用领域特定模型生成合成数据:Qwen2.5-Math (2024) 用于数学内容,Qwen2.5-Coder (2024) 用于代码相关数据

- 预训练过程采用三阶段策略:

- 1)通用阶段(S1) :所有 Qwen3 模型在 4,096 token 的序列长度上训练超过 30 万亿 token

- 在此阶段,模型在语言能力和通用世界知识上完成了全面预训练,训练数据涵盖 119 种语言和方言

- 2)推理阶段(S2) :为了进一步提升推理能力,作者优化了本阶段的预训练语料库,增加了 STEM、编码、推理和合成数据的比例

- 模型在 4,096 token 的序列长度上进一步训练约 5 万亿高质量 token

- 在此阶段,作者加速了学习率衰减

- 3)长上下文阶段(S3) :在最后的预训练阶段,作者收集高质量的长上下文语料以扩展 Qwen3 模型的上下文长度

- 所有模型在 32,768 token 的序列长度上训练了数千亿 token

- 长上下文语料库包含 75% 长度在 16,384 到 32,768 token 之间的文本,以及 25% 长度在 4,096 到 16,384 token 之间的文本

- 1)通用阶段(S1) :所有 Qwen3 模型在 4,096 token 的序列长度上训练超过 30 万亿 token

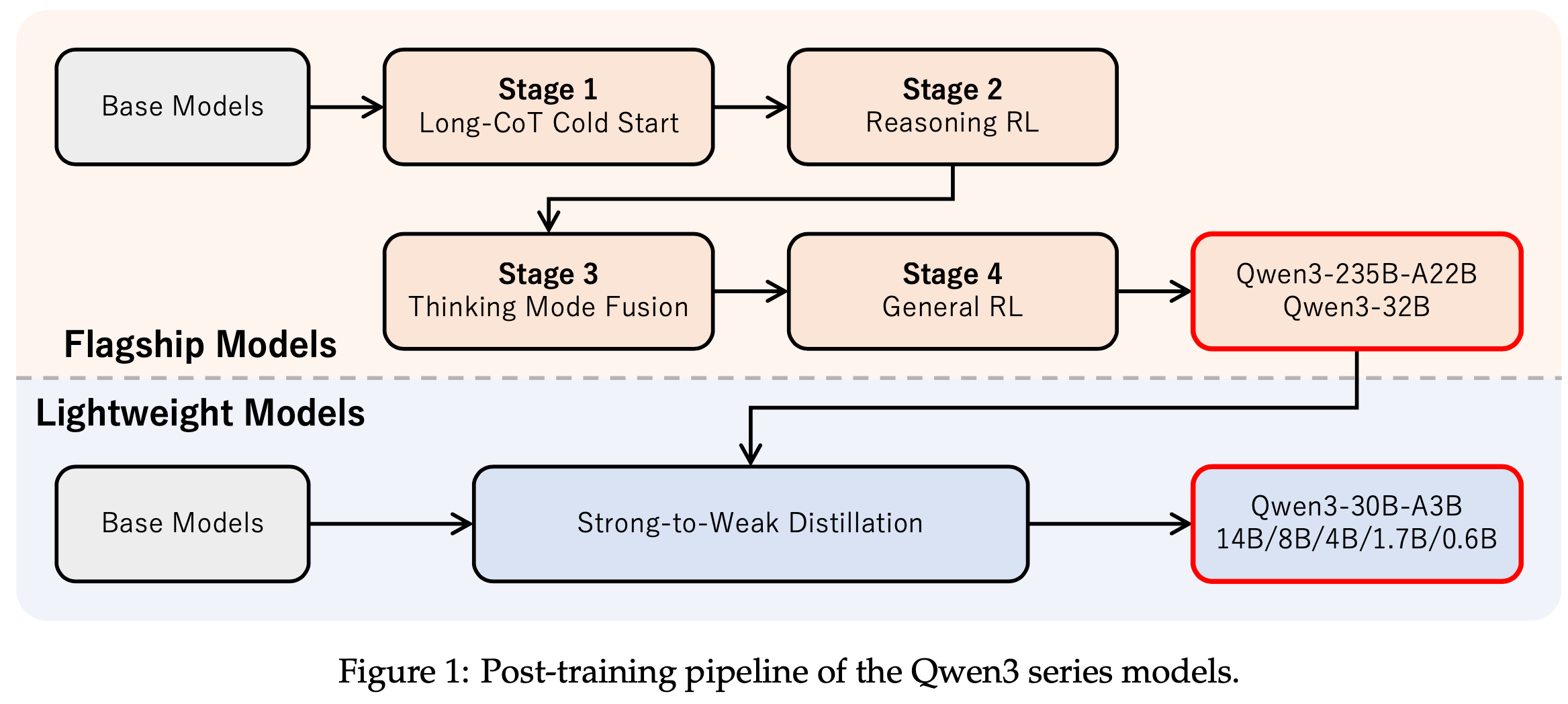

- 为了更好地将基础模型与人类偏好和下游应用对齐,作者采用了多阶段后训练方法,同时赋能思考(推理)和非思考模式

- 在前两个阶段,通过长 CoT 冷启动微调和专注于数学与编码任务的强化学习 ,开发了强大的推理能力

- 在最后两个阶段,将带有和不带有推理路径的数据合并为一个统一数据集进行进一步微调 ,使模型能够有效处理两种类型的输入,随后应用通用领域的强化学习以提升在广泛下游任务中的性能

- 对于小模型,使用强到弱蒸馏(strong-to-weak distillation),利用从大模型的 Off-policy 和 On-policy 知识迁移来增强其能力

- 从高级教师模型的蒸馏在性能和训练效率上显著优于强化学习

Architecture

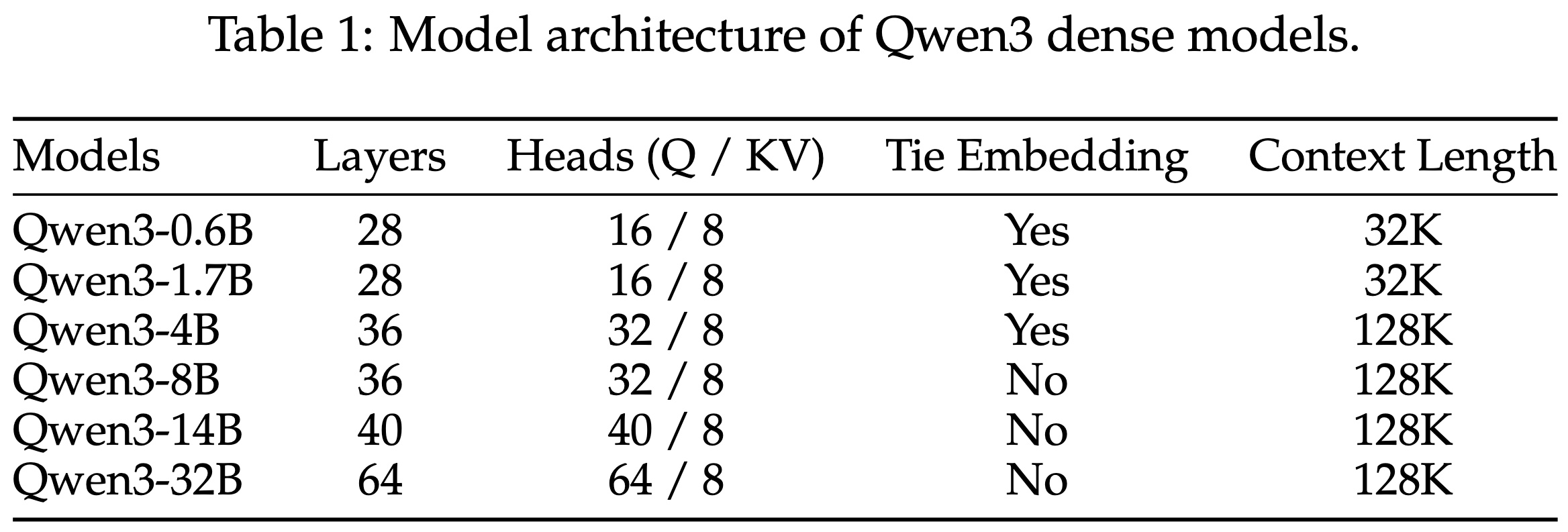

- Qwen3 系列包括 6 个 Dense 模型(Qwen3-0.6B、Qwen3-1.7B、Qwen3-4B、Qwen3-8B、Qwen3-14B 和 Qwen3-32B)和 2 个 MoE 模型(Qwen3-30B-A3B 和 Qwen3-235B-A22B)

- 旗舰模型 Qwen3-235B-A22B 总参数为 235B,激活参数为 22B

- Qwen3 Dense 模型的架构与 Qwen2.5 (2024) 类似,包括使用如下组件:

- 分组查询注意力(Grouped Query Attention, GQA)(2023)

- SwiGLU (2017)

- 旋转位置嵌入(Rotary Positional Embeddings, RoPE)(2024)

- RMSNorm (2023) 的预归一化(pre-normalization)

- Qwen3 移除了 Qwen2 (2024) 中使用的 QKV 偏置(QKV-bias),并在注意力机制中引入了 QK 归一化(QK-Norm)(2023) 以确保 Qwen3 的训练稳定性

- 模型架构的关键信息如表 1 所示

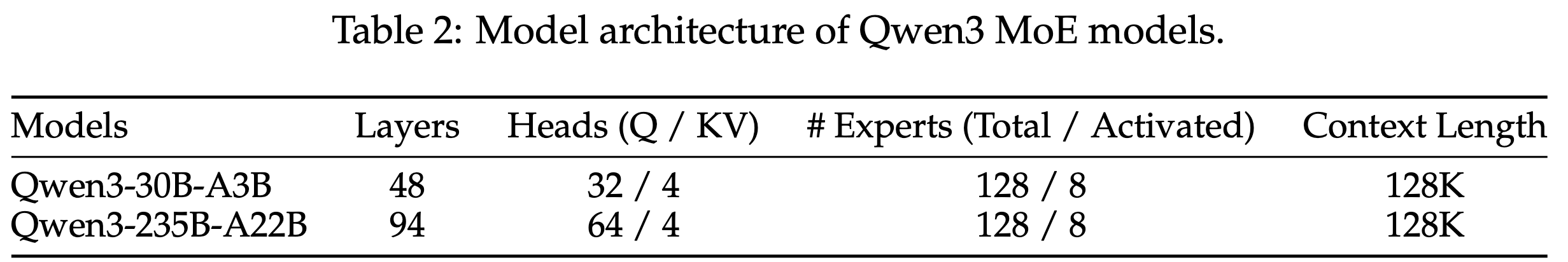

- Qwen3 MoE 模型与 Qwen3 Dense 模型共享相同的基础架构,模型架构的关键信息如表 2 所示

- 遵循 Qwen2.5-MoE (2024) 并实现了细粒度专家分割(fine-grained expert segmentation)(2024)

- Qwen3 MoE 模型共有 128 个专家,每个 token 激活 8 个专家

- 与 Qwen2.5-MoE 不同,Qwen3-MoE 设计排除了共享专家

- Qwen3 采用全局批量负载均衡损失(global-batch load balancing loss)(2025) 以鼓励专家专业化

- 这些架构和训练创新在下游任务中显著提升了模型性能

- Qwen3 模型使用 Qwen 的分词器 (2023),它实现了 BBPE(Byte-level Byte-Pair Encoding)(2020; 2020; 2016),词表为 151,669

Pre-training

Pre-training Data

- 与 Qwen2.5(2024)相比,Qwen3 显著扩大了预训练数据的规模和多样性

- 作者收集了 36 万亿 token 的数据,覆盖 119 种语言和方言

- 这些数据包含多个领域的高质量内容,例如代码、STEM(科学、技术、工程和数学)、推理任务、书籍、多语言文本以及合成数据

- 作者收集了 36 万亿 token 的数据,覆盖 119 种语言和方言

- 作者对预训练数据做了如下扩展:

- First,使用 Qwen2.5-VL 模型(2025)对大量 PDF 类文档进行文本识别,随后通过 Qwen2.5 模型(2024)对识别文本进行优化,从而获得额外的高质量文本 token,总量达到数万亿

- Second,利用 Qwen2.5(2024)、Qwen2.5-Math(2024)和 Qwen2.5-Coder(2024)模型合成了数万亿不同格式的文本 token,涵盖教材、问答、指令和代码片段等,覆盖数十个领域

- Third,通过引入更多语言数据进一步扩展了预训练语料库。与 Qwen2.5 相比,支持的语言数量从 29 种大幅增加到 119 种,显著提升了模型的跨语言能力

- 作者开发了一套多语言数据标注系统,用于提升训练数据的质量和多样性

- 该系统已应用于大规模预训练数据集,对超过 30 万亿 token 进行了多维度标注,包括教育价值、领域和安全性等

- 这些细粒度的标注支持更高效的数据过滤和组合

- 与以往研究(2023;2023;2024)在数据源或领域级别优化数据混合比例不同,Qwen3 通过在小规模代理模型上进行细粒度数据标签的消融实验,实现了实例级别的数据混合优化

Pre-training Stages

- Qwen3 模型的预训练分为三个阶段:

- 1)General Stage(S1) :在第一阶段,所有 Qwen3 模型在超过 30 万亿 token 上以 4,096 token 的序列长度进行训练

- 此阶段模型已完全掌握语言能力和通用世界知识,训练数据覆盖 119 种语言和方言

- 2)Reasoning Stage(S2) :为了进一步提升推理能力,作者优化了本阶段的预训练语料库,增加了 STEM、代码、推理和合成数据的比例

- 模型以 4,096 token 的序列长度进一步预训练约 5 万亿高质量 token,并在此阶段加速学习率衰减

- 3)Long Context Stage(S3) :在最后的预训练阶段,作者收集高质量的长上下文语料库,将 Qwen3 模型的上下文长度扩展到 32,768 token

- 长上下文语料库中,75% 的文本长度介于 16,384 到 32,768 token 之间,25% 介于 4,096 到 16,384 token 之间

- 遵循 Qwen2.5(2024)的方法,作者使用 ABF 技术(2023)将 RoPE 的基础频率从 10,000 增加到 1,000,000,同时引入 YARN(2023)和双块注意力(Dual Chunk Attention, DCA)(2024),在推理时实现序列长度容量的四倍提升

- 1)General Stage(S1) :在第一阶段,所有 Qwen3 模型在超过 30 万亿 token 上以 4,096 token 的序列长度进行训练

- 与 Qwen2.5(2024)类似,Qwen3 基于上述三个阶段开发了超参数(如学习率 Scheduler 和 Batch Size)的扩展规律

- 通过大量实验,作者系统研究了模型架构、训练数据、训练阶段与最优训练超参数之间的关系,最终为每个 Dense 或 MoE 模型预测了最优学习率和 Batch Size 策略

Pre-training Evaluation

- Qwen3 系列的基础语言模型评估重点关注其在通用知识、推理、数学、科学知识、代码和多语言能力方面的表现。评估数据集包括 15 个基准测试:

- 通用任务(General Tasks) :MMLU(2021a)(5-shot)、MMLU-Pro(2024)(5-shot,CoT)、MMLU-redux(2024)(5-shot)、BBH(2023)(3-shot,CoT)、SuperGPQA(2025)(5-shot,CoT)

- 数学与 STEM 任务(Math & STEM Tasks) :GPQA(2023)(5-shot,CoT)、GSM8K(2021)(4-shot,CoT)、MATH(2021b)(4-shot,CoT)

- 代码任务(Coding Tasks) :EvalPlus(2023a)(0-shot)(HumanEval(2021)、MBPP(2021)、Humaneval+、MBPP+ 的平均值)、MultiPL-E(2023)(0-shot)(Python、C++、Java、PHP、TypeScript、C#、Bash、JavaScript)、MBPP-3shot(2021)、CRUX-O of CRUXEval(2024)(1-shot)

- 多语言任务(Multilingual Tasks) :MGSM(2023)(8-shot,CoT)、MMMLU(OpenAI,2024)(5-shot)、INCLUDE(2024)(5-shot)

- 在基础模型的基线对比中,将 Qwen3 系列基础模型与 Qwen2.5 基础模型(2024)以及其他领先的开源基础模型进行了比较,包括 DeepSeek-V3 Base(2024a)、Gemma-3(2025)、Llama-3(2024)和 Llama-4(Meta-AI,2025)系列基础模型

- 所有模型均使用相同的评估流程和广泛采用的评估设置,以确保公平比较

Summary of Evaluation Results

- 基于整体评估结果,论文中总结了 Qwen3 基础模型的关键结论:

- (1) 与之前开源的 SOTA Dense 和 MoE 基础模型(如 DeepSeek-V3 Base、Llama-4-Maverick Base 和 Qwen2.5-72B-Base)相比,Qwen3-235B-A22B-Base 在大多数任务中表现更优,且参数量显著更少

- (2) 对于 Qwen3 MoE 基础模型,实验结果表明:

- (a) 使用相同的预训练数据,Qwen3 MoE 基础模型仅需 1/5 的激活参数即可达到与 Dense 模型相当的性能;

- (b) 由于架构改进、训练 token 规模扩大和更先进的训练策略,Qwen3 MoE 基础模型的性能优于 Qwen2.5 MoE 基础模型,且激活参数和总参数量更少;

- (c) 即使仅使用 Qwen2.5 Dense 基础模型 1/10 的激活参数,Qwen3 MoE 基础模型也能达到相当的性能,显著降低了推理和训练成本

- (3) Qwen3 Dense 基础模型的整体性能与更高参数规模的 Qwen2.5 基础模型相当

- 例如,Qwen3-1.7B/4B/8B/14B/32B-Base 分别与 Qwen2.5-3B/7B/14B/32B/72B-Base 性能相当,尤其在 STEM、代码和推理基准测试中,Qwen3 Dense 基础模型的性能甚至超越了更高参数规模的 Qwen2.5 基础模型

- 注:【此处省略一些评估细节】

Post-training

- 图 1 展示了 Qwen3 系列模型的后训练流程,该流程围绕两个核心目标设计:

- (1) 思维控制(Thinking Control) :通过整合“非思维模式(non-thinking mode)”和“思维模式(thinking mode)”,使用户能够灵活选择模型是否进行推理,并通过指定思维过程的 token 预算来控制思考深度

- (2) 强到弱蒸馏(Strong-to-Weak Distillation) :旨在简化和优化轻量级模型的后训练过程

- 通过利用大规模模型的知识,显著降低构建小规模模型所需的计算成本和开发工作量

- 通过利用大规模模型的知识,显著降低构建小规模模型所需的计算成本和开发工作量

Long-CoT Cold Start

- 首先构建了一个涵盖数学、代码、逻辑推理和 STEM 问题的综合数据集,每个问题均配有已验证的参考答案或基于代码的测试用例

- 该数据集用于长链思维(long Chain-of-Thought, long-CoT)训练的冷启动阶段

- 数据集构建包含两阶段过滤流程:查询过滤(query filtering)和响应过滤(query filtering)

- 查询过滤阶段:使用 Qwen2.5-72B-Instruct 识别并移除难以验证的查询(例如包含多个子问题或要求生成通用文本的查询),同时排除 Qwen2.5-72B-Instruct 无需 CoT 推理即可正确回答的查询,以确保仅包含需要深度推理的复杂问题

- 使用 Qwen2.5-72B-Instruct 标注每个查询的领域,以保持数据集的领域平衡

- 响应过滤阶段:保留验证集后,使用 QwQ-32B 为每个剩余查询生成 \(N\) 个候选响应

- 若 QwQ-32B 无法生成正确解决方案,则由人工标注者评估响应准确性

- 对于通过 Pass@\(N\) 的查询,进一步应用严格过滤标准,移除以下类型的响应:

- (1) 最终答案错误;

- (2) 包含大量重复内容;

- (3) 明显猜测而无充分推理;

- (4) 思维内容与总结不一致;

- (5) 语言混合不当或风格突变;

- (6) 疑似与验证集内容过度相似

- 随后,使用精炼后的数据集子集进行推理模式的初始冷启动训练

- 此阶段的目标是为模型奠定基础推理模式 ,而非过度强调即时推理性能,从而确保模型潜力不受限制,为后续RL阶段提供更大改进空间

- 为实现这一目标,建议在此准备阶段尽量减少训练样本数量和训练步数

Reasoning RL

- 推理强化学习阶段使用的 query-verifier 对需满足以下四个标准:

- (1) 未在冷启动阶段使用;

- (2) 冷启动模型可学习;

- (3) 尽可能具有挑战性;

- (4) 覆盖广泛的子领域

- 最终收集了 3995 对 query-verifier ,并采用 GRPO(2024)更新模型参数

- 实验表明,使用大的 Batch Size 和(每个查询)高 rollout 次数,结合 Off-policy 训练以提高样本效率,对训练过程有益

- 此外,通过控制模型的熵(entropy)使其稳步增加或保持稳定 ,可以有效平衡探索与利用(exploration and exploitation),这对维持训练稳定性至关重要

- 注:这里作者说模型的熵是稳步增加的,但大部分论文中给出的训练都是看到熵在下降的,作者应该是否做了一些特定的设计来提升模型在这方面的能力?

- 结果表明,在单次 RL 训练过程中,无需手动干预超参数,即可实现训练奖励和验证性能的持续提升

- 例如,Qwen3-235B-A22B 模型的 AIME’24 分数在 170 个 RL 训练步中从 70.1 提升至 85.1

Thinking Mode Fusion

- 思维模式融合阶段的目标是将“非思维(non-thinking)”能力整合到已具备“思维(thinking)”能力的模型中

- 这种方法使开发者能够管理和控制推理行为,同时降低部署独立模型以处理思维和非思维任务的成本和复杂性

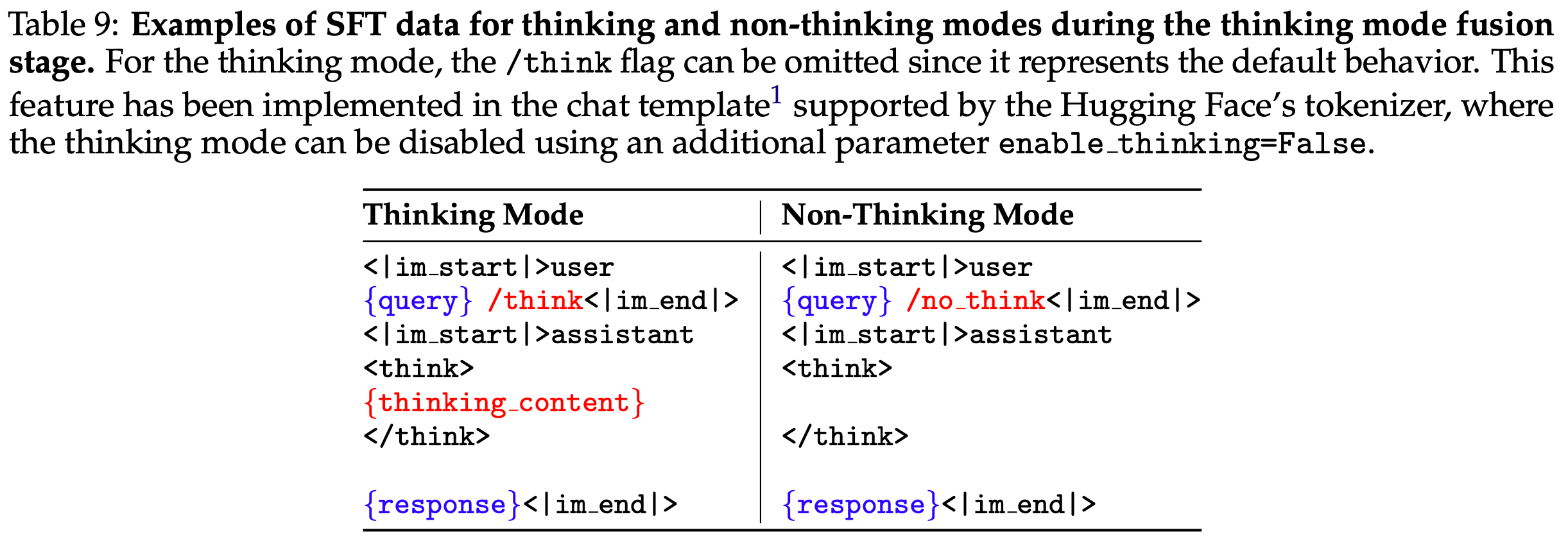

- 为实现这一目标,作者对推理强化学习模型进行持续 SFT ,并设计聊天模板以融合两种模式

- 作者发现能够熟练处理两种模式的模型在不同思维预算下均表现稳定

Construction of SFT data

- SFT 数据集结合了“thinking”和“non-thinking”数据

- 为确保 Stage 2 模型的性能不受额外 SFT 影响 :

- “thinking”数据通过使用 Stage 2 模型对 Stage 1 查询进行拒绝采样(rejection sampling)生成;

- “non-thinking”数据则精心策划,涵盖编码、数学、指令遵循、多语言任务、创意写作、问答和角色扮演等多样化任务

- 理解:因为 Stage 2 模型已经是训练好的了,为了增加思维链融合功能,额外的 SFT 是可能会导致模型出现问题的,这里使用 Stage 2 和 Stage 1 模型相关的数据来训练,从而保证 Stage 2 和 Stage 1 模型的原始能力?

- 此外,作者采用自动生成的检查表评估“non-thinking”数据的响应质量,并特别增加低资源(low-resource)任务上的性能,作者特地增加了翻译任务的比例

Chat Template Design

- 为更好整合两种模式并支持用户动态切换思维过程,作者设计了 Qwen3 的聊天模板(如表 9 所示)

- 对于思维模式和非思维模式的样本,作者分别在用户查询或系统消息中引入

/think和/no_think标志,使模型能够根据用户输入选择相应的思维模式 - 对于非思维模式样本 ,作者在助手响应中保留空的思维块(thinking block)

- 这一设计确保模型内部格式一致性,并允许开发者通过在聊天模板中拼接空的思维块来阻止模型进行思维行为

- 默认情况下,模型以思维模式运行,因此作者添加了一些用户查询中不包含

/think标志的思维模式训练样本 - 对于更复杂的多轮对话,作者在用户查询中随机插入多个

/think和/no_think标志,模型响应则遵循最后遇到的标志

- 对于思维模式和非思维模式的样本,作者分别在用户查询或系统消息中引入

Thinking Budget

- 思维模式融合的额外优势在于,一旦模型学会以非思维和思维模式响应,它自然能够处理中间情况(即基于不完整思维生成响应)

- 这一能力为实施模型思维过程的预算控制奠定了基础

- 具体而言,当模型的思维长度达到用户定义的阈值时,手动停止思维过程,并插入停止思维指令:

“Considering the limited time by the user, I have to give the solution based on the thinking directly now.\n</think>.\n\n” - 插入该指令后,模型基于已积累的推理生成最终响应

- 值得注意的是,此能力并非通过显式训练获得,而是思维模式融合的自然结果

- 具体而言,当模型的思维长度达到用户定义的阈值时,手动停止思维过程,并插入停止思维指令:

General RL

- 通用强化学习阶段旨在广泛增强模型在多样化场景中的能力和稳定性

- 为此,作者建立了一个覆盖 20 多项任务 的复杂奖励系统 ,每项任务均配备定制化评分标准,重点关注以下核心能力:

- Instruction Following :确保模型准确解释并遵循用户指令,包括内容、格式、长度和结构化输出等要求,生成符合用户期望的响应

- 格式遵循(Format Following) :除显式指令外,模型需遵循特定格式约定

- 例如,通过

/think和/no_think标志切换思维模式,并在最终输出中使用指定 token(如<think>和</think>)分隔思维和响应部分

- 例如,通过

- 偏好对齐(Preference Alignment) :针对开放式查询,偏好对齐侧重于提升模型的帮助性、参与度和风格,最终提供更自然和令人满意的用户体验

- 智能体能力(Agent Ability) :训练模型通过指定接口正确调用工具

- 在 RL rollout 过程中,模型可执行完整的多轮交互周期 ,并接收真实环境执行反馈 ,从而提升其在长视野决策任务中的性能和稳定性

- 专项场景能力(Abilities for Specialized Scenarios) :在更专业的场景中,作者设计特定任务

- 例如,在检索增强生成(Retrieval-Augmented Generation, RAG)任务中,引入奖励信号引导模型生成准确且上下文合适的响应 ,从而最小化幻觉风险

- 为上述任务提供反馈时,作者采用三种不同类型的奖励:

- (1)基于规则的奖励(Rule-based Reward) :广泛用于推理强化学习阶段,也适用于指令遵循(2024)和格式遵循等通用任务

- 设计良好的基于规则的奖励可高精度评估模型输出的正确性,避免奖励破解(reward hacking)问题

- (2)带参考答案的模型奖励(Model-based Reward with Reference Answer) :为每个查询提供参考答案,并提示 Qwen2.5-72B-Instruct 基于参考答案对模型响应评分

- 该方法无需严格格式化即可灵活处理多样化任务,避免纯规则奖励可能导致的假阴性

- (3)无参考答案的模型奖励(Model-based Reward without Reference Answer) :利用人类偏好数据训练奖励模型 ,为模型响应分配标量分数

- 该方法不依赖参考答案,可处理更广泛查询,同时有效提升模型的参与度和帮助性

- (1)基于规则的奖励(Rule-based Reward) :广泛用于推理强化学习阶段,也适用于指令遵循(2024)和格式遵循等通用任务

Strong-to-Weak Distillation

- 强到弱蒸馏流程专为优化轻量级模型设计,涵盖 5 个 Dense 模型(Qwen3-0.6B、1.7B、4B、8B 和 14B)和 1 个 MoE 模型(Qwen3-30B-A3B)

- 该方法在提升模型性能的同时,有效赋予其强大的模式切换能力

- 蒸馏过程分为两个主要阶段:

- (1) Off-policy 蒸馏(Off-policy Distillation) :在此初始阶段,作者结合教师模型在

/think和/no_think模式下的输出进行响应蒸馏 ,帮助轻量级学生模型发展基础推理能力和思维模式切换能力,为后续 On-policy 训练阶段奠定基础 - (2) On-policy 蒸馏(On-policy Distillation) :在此阶段,学生模型生成 On-policy 序列进行微调

- 使用学生模型采样提示后,学生模型以

/think或/no_think模式生成响应,并通过对齐其 logits 与教师模型(Qwen3-32B 或 Qwen3-235B-A22B)以最小化 KL 散度(Kullback-Leibler divergence)进行微调

- 使用学生模型采样提示后,学生模型以

- (1) Off-policy 蒸馏(Off-policy Distillation) :在此初始阶段,作者结合教师模型在

Post-training Evaluation

- For 全面评估指令调优模型的质量,采用自动化基准测试思维和非思维模式下的模型性能。这些基准分为以下几类:

- 通用任务(General Tasks) :使用 MMLU-Redux(2024)、GPQA-Diamond(2023)、C-Eval(2023)和 LiveBench(2024-11-25)(2024)等基准

- 对于 GPQA-Diamond,每个查询采样 10 次并报告平均准确率

- 对齐任务(Alignment Tasks) :评估模型与人类偏好的对齐程度

- 针对指令遵循性能,报告 IFEval(2023)的严格提示准确率;

- 针对通用主题的人类偏好对齐,使用 Arena-Hard(2024)和 AlignBench v1.1(2023);

- 针对写作任务,依赖 Creative Writing V3(2024)和 WritingBench(2025)评估模型的熟练度和创造力

- 数学与文本推理(Math & Text Reasoning) :评估数学和逻辑推理能力,采用高阶数学基准 MATH-500(2023)、AIME’24 和 AIME’25(2025),以及文本推理任务 ZebraLogic(2025)和 AutoLogi(2025)

- 对于 AIME 问题,每年试题包含 Part I 和 Part II,共 30 题,每题采样 64 次并以平均准确率作为最终分数

- 智能体与编码(Agent & Coding) :测试模型在编码和智能体任务中的熟练度,使用 BFCL v3(2024)、LiveCodeBench(v5, 2024.10-2025.02)(2024)和 Codeforces Ratings from CodeElo(2025)

- 对于 BFCL,所有 Qwen3 模型均采用 FC 格式评估,并使用 yarn 将模型部署至 64k 上下文长度以进行多轮评估

- 部分基线来自 BFCL 排行榜,取 FC 和 Prompt 格式中的较高分;未在排行榜中报告的模型则评估 Prompt 格式

- 对于 LiveCodeBench,非思维模式使用官方推荐提示,思维模式则调整提示模板以允许模型更自由地思考(移除限制

You will not return anything except for the program) - 为评估模型与竞技编程专家的性能差距,使用 CodeForces 计算 Elo 评分,每个问题最多生成八次独立推理尝试

- 对于 BFCL,所有 Qwen3 模型均采用 FC 格式评估,并使用 yarn 将模型部署至 64k 上下文长度以进行多轮评估

- 多语言任务(Multilingual Tasks) :评估四种任务:指令遵循、知识、数学和逻辑推理

- 指令遵循使用 Multi-IF(2024)(覆盖 8 种关键语言);

- 知识评估包含两类:区域知识通过 INCLUDE(2024)(覆盖 44 种语言)评估,通用知识通过 MMMLU(2024)(覆盖 14 种语言,排除未优化的约鲁巴语);

- 数学任务采用 MT-AIME2024(2025)(涵盖 55 种语言)和 PolyMath(2025)(涵盖 18 种语言);

- 逻辑推理使用 MlogiQA(覆盖 10 种语言,源自 2024)

- 通用任务(General Tasks) :使用 MMLU-Redux(2024)、GPQA-Diamond(2023)、C-Eval(2023)和 LiveBench(2024-11-25)(2024)等基准

- 所有 Qwen3 模型采样超参数设置如下:

- 在思维模式下的采样超参数设置为 temperature\(=0.6\)、top-p\(=0.95\)、top-k\(=20\);

- 对于 Creative Writing v3 和 WritingBench,应用 presence penalty\(=1.5\) 以鼓励生成更多样化内容

- 补充:presence penalty 会对已经生成过的词汇的概率值进行削弱

- 值越大,削弱越厉害,生成的文本更加多样化;

- 值越小,更容易生成重复的词,但文本会更加连贯

- 非思维模式的采样超参数为 temperature\(=0.7\)、top-p \(=0.8\)、top-k \(=20\)、presence penalty\(=1.5\)

- 两种模式的最大输出长度均设为 32,768 token,AIME’24 和 AIME’25 除外(扩展至 38,912 token 以提供充足思维空间)

Summary of Evaluation Results

- 在思维模式下的采样超参数设置为 temperature\(=0.6\)、top-p\(=0.95\)、top-k\(=20\);

- 从评估结果中,我们总结出最终确定的Qwen3模型的几个关键结论如下:

- (1)我们的旗舰模型 Qwen3-235B-A22B 在思考模式和非思考模式下均展现出开源模型中的顶尖整体性能,超越了 DeepSeek-R1 和 DeepSeek-V3 等强基线模型

- Qwen3-235B-A22B 与闭源领先模型(如 OpenAI-o1、Gemini2.5-Pro 和 GPT-4o)相比也具有高度竞争力,彰显了其深厚的推理能力和全面的通用能力

- (2)我们的旗舰 Dense 模型 Qwen3-32B 在大多数基准测试中优于我们此前最强的推理模型 QwQ-32B,且性能与闭源的OpenAI-o3-mini 相当,表明其推理能力令人瞩目

- Qwen3-32B 在非思考模式下的表现也极为出色,超越了我们此前的旗舰非推理 Dense 模型 Qwen2.5-72B-Instruct。

- (3)我们的轻量级模型(包括 Qwen3-30B-A3B、Qwen3-14B 及其他较小的 Dense 模型)与参数规模相近或更大的开源模型相比,性能始终更优,证明了我们“Strong-to-Weak Distillation”方法的成功。

- (1)我们的旗舰模型 Qwen3-235B-A22B 在思考模式和非思考模式下均展现出开源模型中的顶尖整体性能,超越了 DeepSeek-R1 和 DeepSeek-V3 等强基线模型

- 注:【此处省略一些评估细节】

Discussion

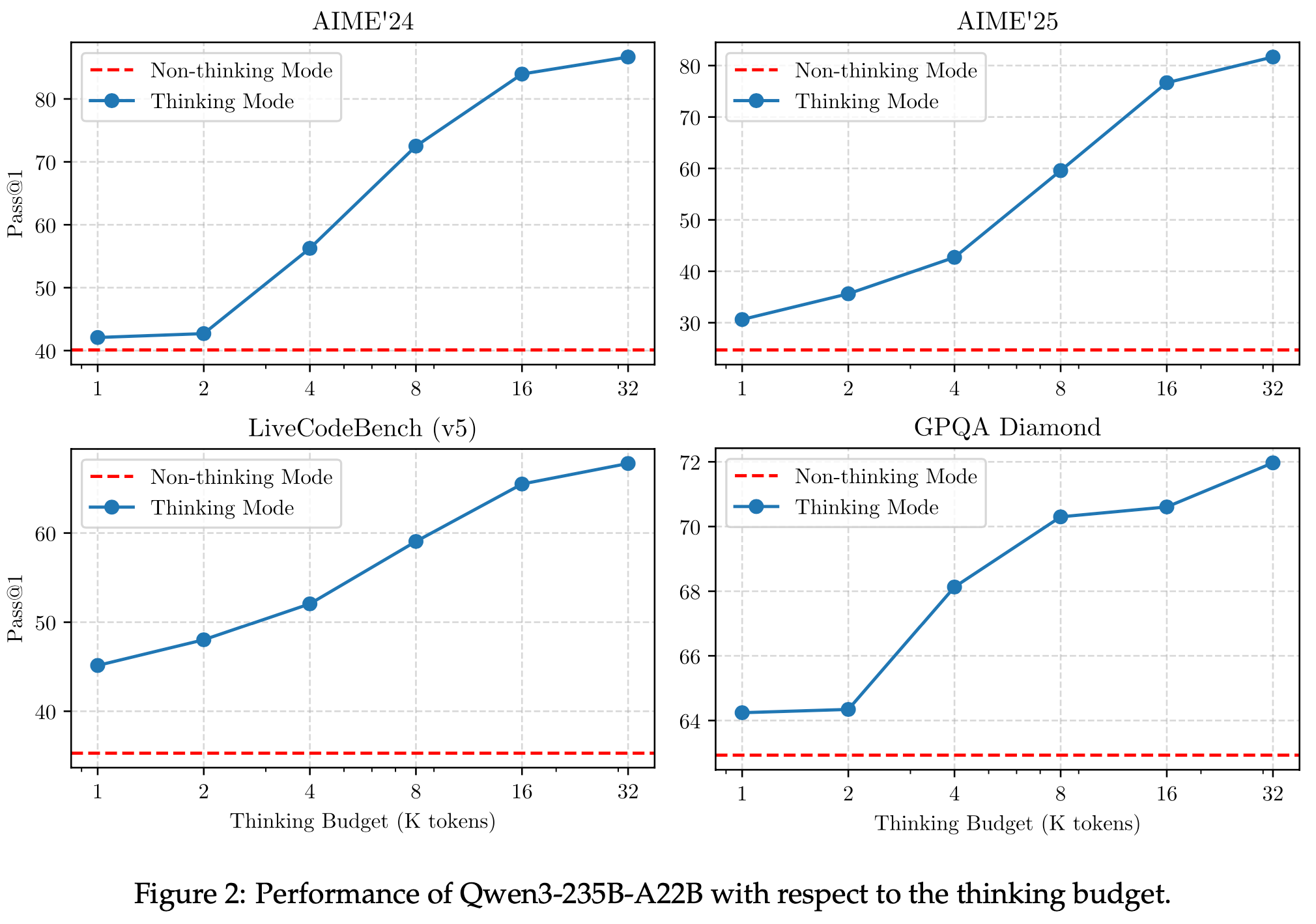

The Effectiveness of Thinking Budget

- 为验证 Qwen3 可通过增加思维预算提升智能水平,在数学、编码和 STEM 领域的四个基准上调整分配的思维预算

- 如图 2 所示,Qwen3 展现出与分配思维预算相关的可扩展且平滑的性能提升

- Thinking Budget 越大,效果越好

- 若进一步将输出长度扩展至 32K 以上,模型性能有望在未来继续提升,作者将此探索留作未来工作

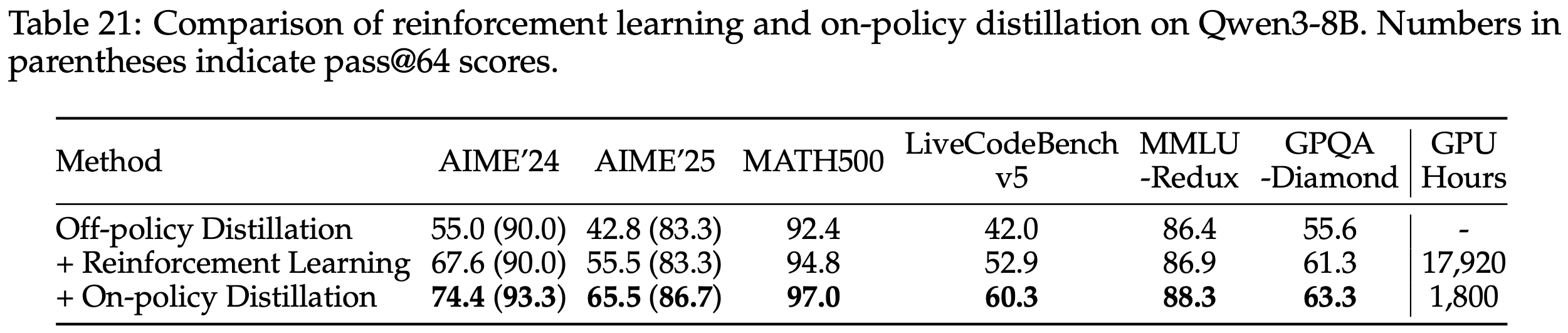

The Effectiveness and Efficiency of On-Policy Distillation

- 通过比较蒸馏与直接强化学习在相同 Off-policy 蒸馏 8B 检查点后的性能和计算成本(以 GPU 小时计),评估 On-policy 蒸馏的有效性和效率

- 注:为简化,以下仅关注数学和代码相关查询

- 表 21 的结果表明,蒸馏在仅需约 1/10 GPU 小时的情况下,性能显著优于强化学习

- 从教师 logits 蒸馏使学生模型能够扩展其探索空间并增强推理潜力,表现为蒸馏后 AIME’24 和 AIME’25 基准的 pass@64 分数较初始检查点有所提升;

- 强化学习未带来 pass@64 分数的任何改进。

- 这些观察凸显了利用更强教师模型指导学生模型学习的优势

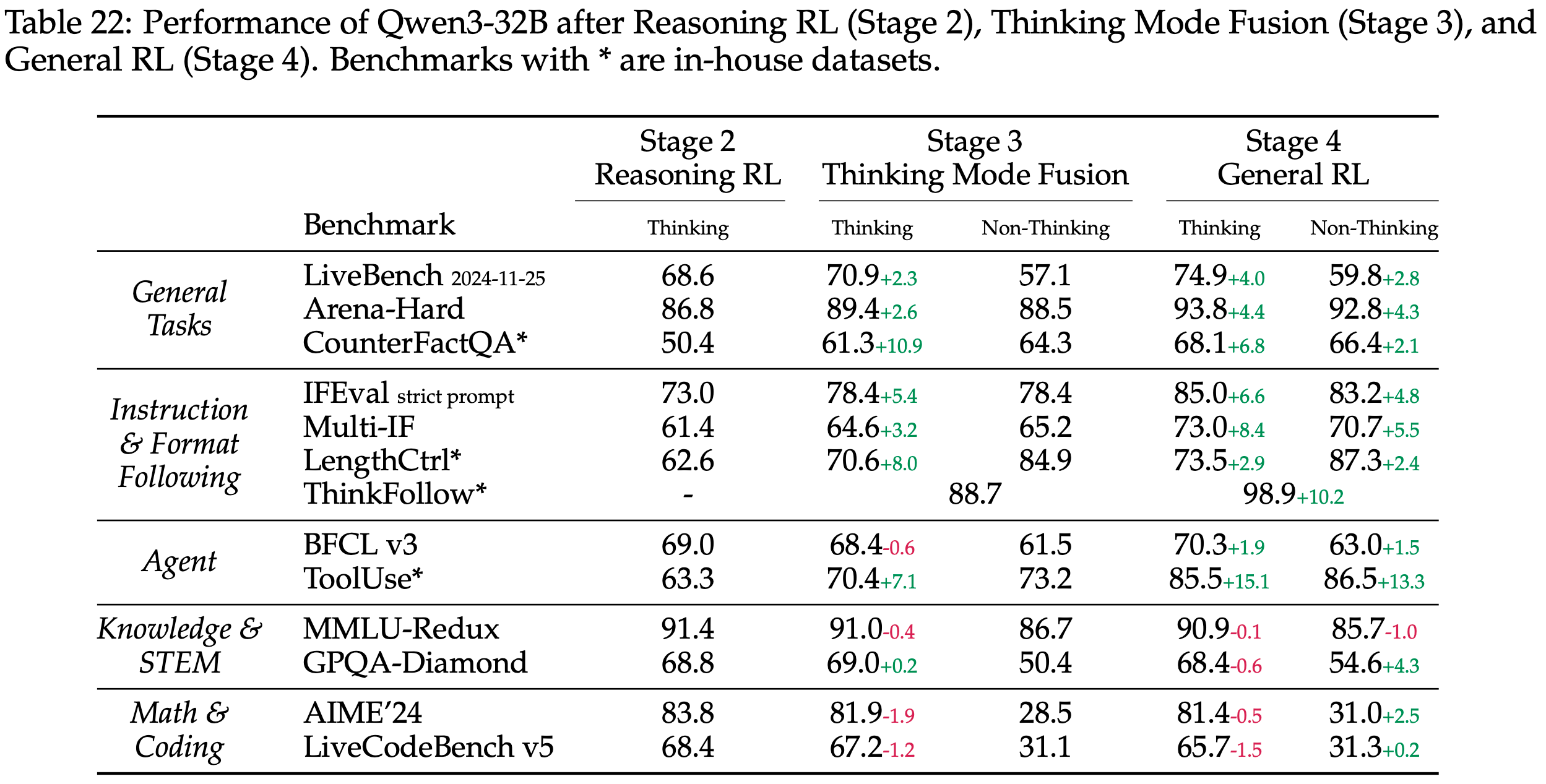

The Effects of Thinking Mode Fusion and General RL

- For 评估后训练中思维模式融合和通用强化学习的有效性,对 Qwen-32B 模型的各个阶段进行评估

- 除前述数据集外,引入多个内部基准以监控其他能力:

- CounterFactQA :包含反事实问题,模型需识别问题非事实并避免生成幻觉答案

- LengthCtrl :包含带长度要求的创意写作任务,最终分数基于生成内容长度与目标长度的差异

- ThinkFollow :包含随机插入

/think和/no_think标志的多轮对话,测试模型能否根据用户查询正确切换思维模式 - ToolUse :评估模型在单轮、多轮和多步工具调用过程中的稳定性,分数包括工具调用过程中的意图识别准确率、格式准确率和参数准确率

- 结果如表 22 所示,可得出以下结论:

- (1) Stage 3 将非思维模式整合至已通过前两阶段训练具备思维能力的模型中

- ThinkFollow 基准分数 88.7 表明模型已具备初步模式切换能力,但仍偶有错误

- Stage 3 还提升了模型在思维模式下的通用和指令遵循能力,CounterFactQA 提升 10.9 分,LengthCtrl 提升 8.0 分

- (2) Stage 4 进一步强化模型在思维和非思维模式下的通用、指令遵循和智能体能力

- ThinkFollow 分数提升至 98.9,确保准确模式切换

- (3) 对于知识、STEM、数学和编码任务 ,思维模式融合和通用强化学习未带来显著提升

- 相反,对于 AIME’24 和 LiveCodeBench 等挑战性任务,思维模式性能在这两个训练阶段后实际下降

- 作者推测这种退化是由于模型在更广泛通用任务上训练,可能影响其处理复杂问题的专项能力

- 在 Qwen3 开发中,作者选择接受这种性能权衡以增强模型的整体通用性

- (1) Stage 3 将非思维模式整合至已通过前两阶段训练具备思维能力的模型中

Future Work

- 在不久的将来,作者的研究将聚焦于以下几个关键方向:

- (1) 预训练扩展(Scale up pretraining) :作者将继续扩展预训练规模,使用质量更高、内容更多样的数据

- (2) 架构优化(Improving model architecture) :改进模型架构和训练方法,以实现高效压缩、超长上下文支持等目标

- (3) RL :增加计算资源投入,重点关注基于环境反馈的智能体强化学习系统,以构建能够处理需要推理时间扩展的复杂任务的智能体

Appendix

A.1 Additional Evaluation Results

A.1.1 Long-Context Ability

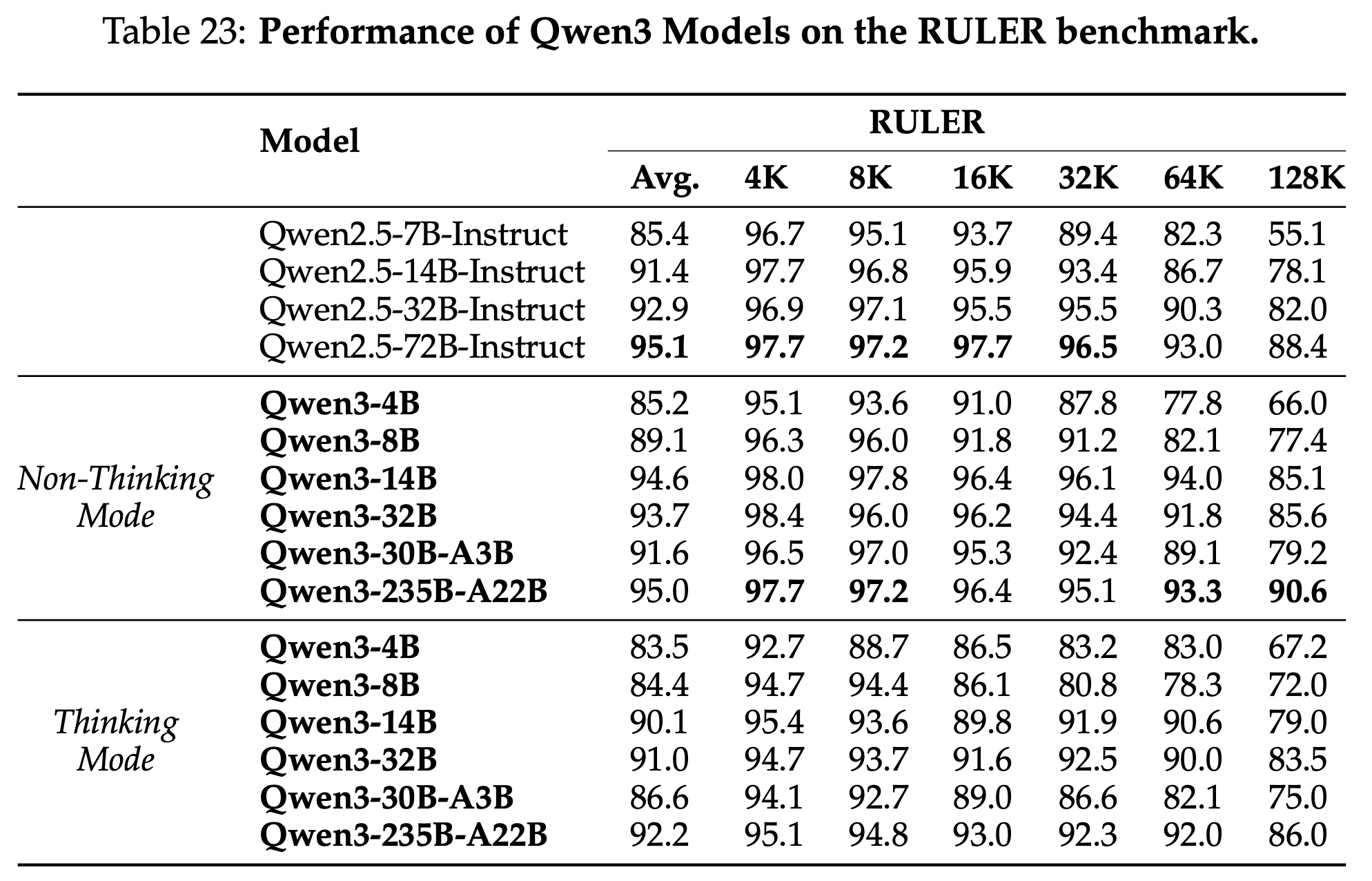

- For 评估长上下文处理能力,在 RULER 基准测试 (2024) 中报告了结果(表 23)

- 为实现长度外推(length extrapolation),使用 YARN (2023) 并设置缩放因子 \( \text{scaling_factor} = 4 \)

- 在思考模式下,作者将思考预算(thinking budget)设为 8192 token,以减少对超长输入的冗余推理

- 结果显示:

- (1) 在非思考模式下,Qwen3 在长上下文处理任务中优于同规模的 Qwen2.5 模型

- (2) 在思考模式下,模型性能略有下降

- 作者推测思考内容对这些检索任务(无需依赖推理)帮助有限 ,甚至可能干扰检索过程

- 未来版本将重点提升思考模式下的长上下文能力

A.1.2 Multilingual Ability

- 表 24-35 展示了 Qwen3 系列模型在西班牙语、法语、葡萄牙语、意大利语、阿拉伯语、日语、韩语、印尼语、俄语、越南语、德语和泰语等多种语言中的详细基准得分

- 这些结果表明,Qwen3 系列模型在所有评估基准中均表现优异,展现了强大的多语言能力

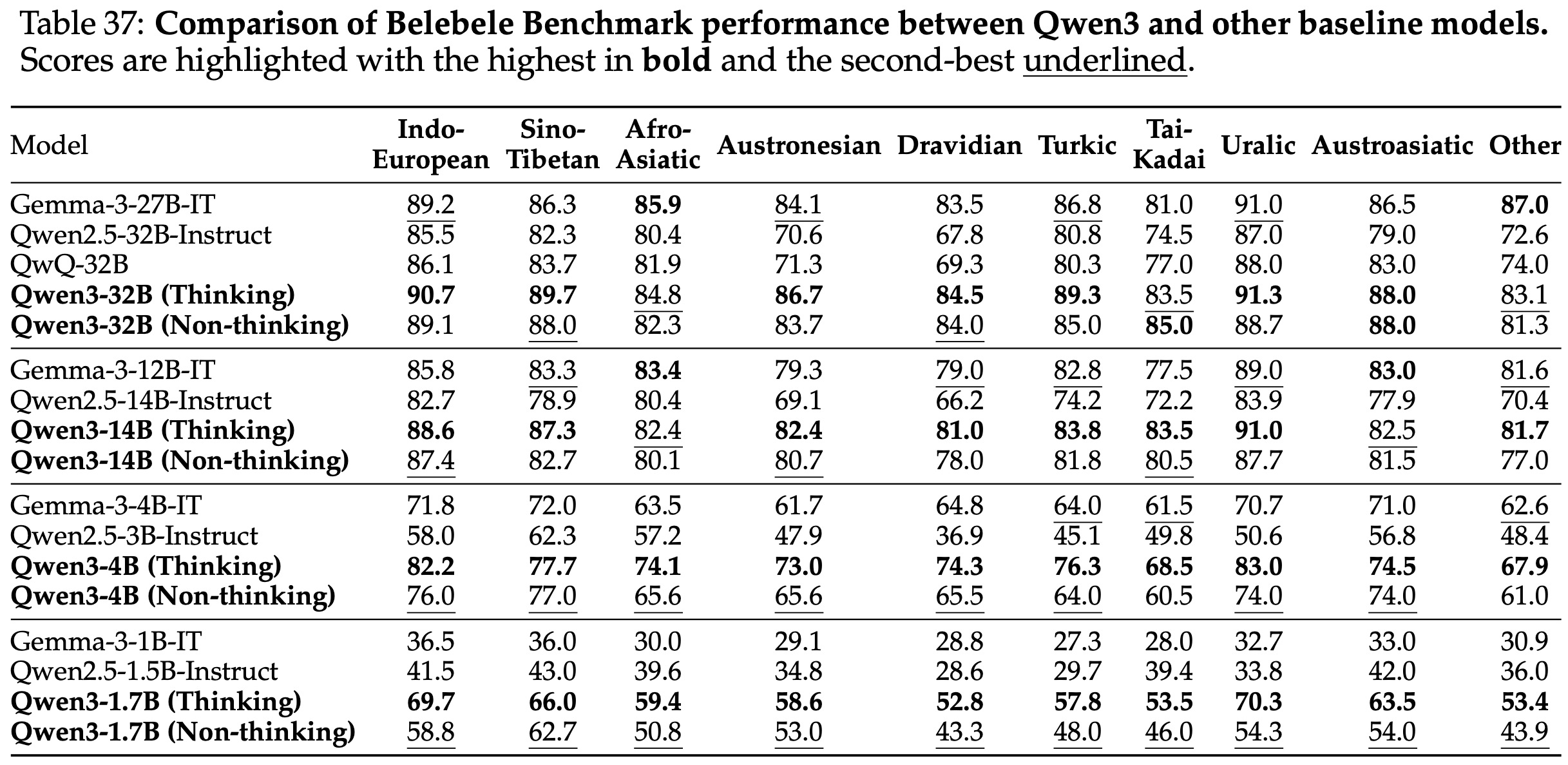

- 为更广泛评估 Qwen3 的多语言表现,作者使用 Belebele (2023) 基准测试,覆盖 80 种优化语言(表 36 按语系列出)

- 表 37 展示了 Qwen3 与其他基线模型在 Belebele 基准上的性能对比

- 结果显示,Qwen3 在同等规模下与 Gemma 模型表现相当,同时显著优于 Qwen2.5

附录:Qwen3-MoE 源码

- 参考博客:图解 Qwen3 MoE 模型源码

- 包含一些流程图和源码,比较清晰